Algebra liniowa z geometrią analityczną

Opis

Zapoznanie z podstawowymi pojęciami algebry liniowej dla przestrzeni skończenie wymiarowych. Wprowadzenie do geometrii analitycznej \(R^n\)

Sylabus

Autorzy

- Barbara Opozda — Uniwersytet Jagielloński, Wydział Matematyki i Informatyki, Instytut Matematyki

- Małgorzata Downarowicz — Uniwersytet Jagielloński, Wydział Matematyki i Informatyki, Instytut Matematyki

- Dominik Kwietniak — Uniwersytet Jagielloński, Wydział Matematyki i Informatyki, Instytut Matematyki

Wymagania wstępne

- Podstawy logiki i teorii mnogości

- Wiadomości ze szkoły

Zawartość

- Ciała i przestrzenie wektorowe:

- grupa, ciało (przemienne), charakterystyka ciała

- przykłady ciał, ciało liczb zespolonych

- definicja przestrzeni wektorowej

- podprzestrzenie, operacje na podprzestrzeniach

- kombinacja liniowa, podzbiór generujący, układ liniowo niezależny, baza, przestrzeń skończenie wymiarowa, wymiar przestrzeni

- Odwzorowania liniowe:

- definicja odwzorowania liniowego

- jądro i obraz odwzorowania liniowego, rząd odwzorowania liniowego

- monomorfizm, epimorfizm, izomorfizm

- przestrzeń dualna, baza dualna, odwzorowanie dualne

- Macierze:

- podstawowe pojęcia

- działania na macierzach

- macierz odwzorowania liniowego

- mnożenie macierzy a składanie odwzorowań liniowych

- macierz dualna a odwzorowanie dualne

- rząd macierzy

- macierz przejścia, macierz odwzorowania liniowego po zmianie bazy

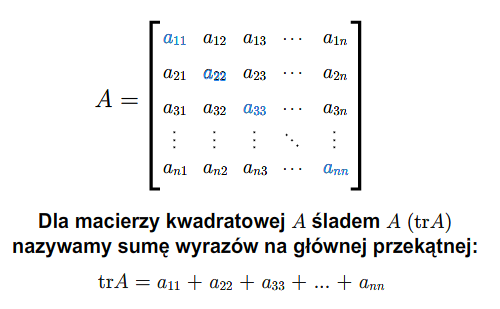

- ślad macierzy i endomorfizmu

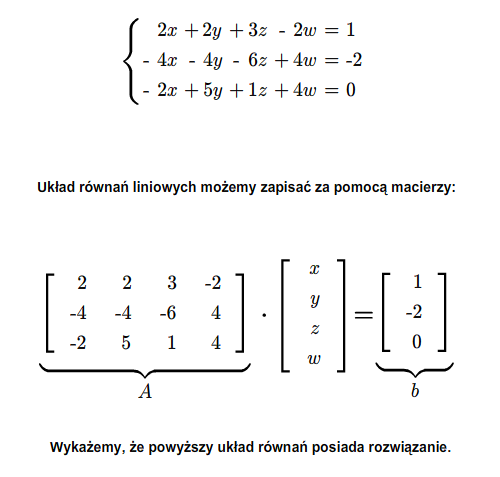

- Układy równań liniowych:

- twierdzenie Kroneckera-Capellego

- zbiór rozwiązań układu równań liniowych

- badanie układu równań

- Wyznacznik:

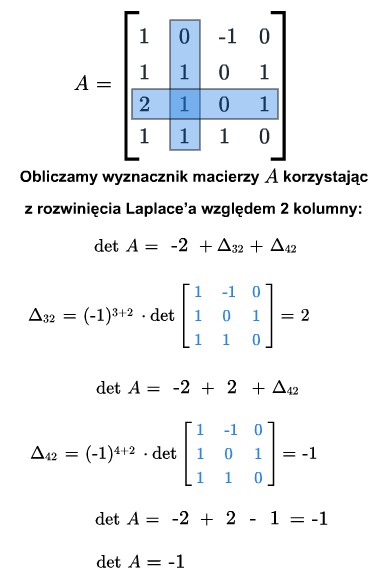

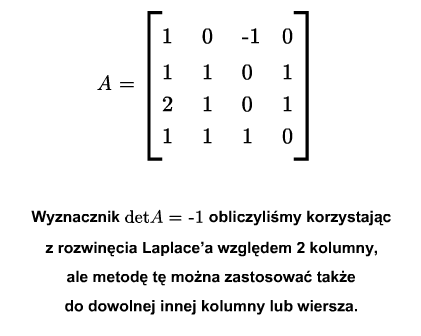

- wyznacznik macierzy i endomorfizmu, metody obliczania wyznacznika, własności wyznacznika

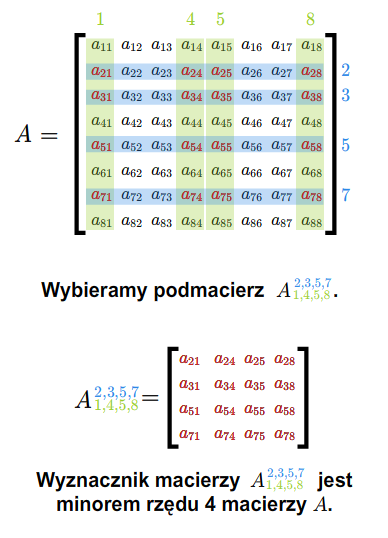

- minory i rząd macierzy

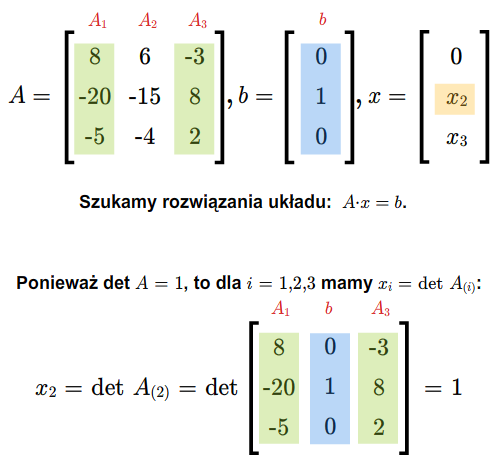

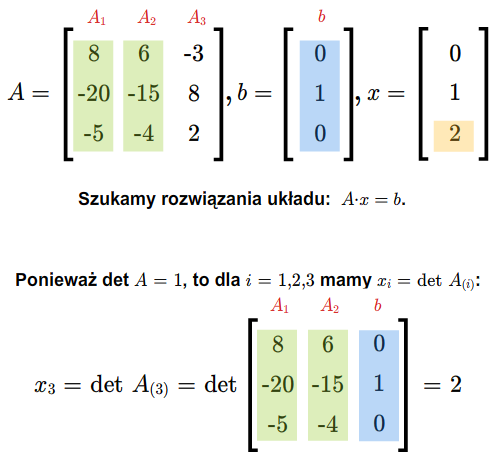

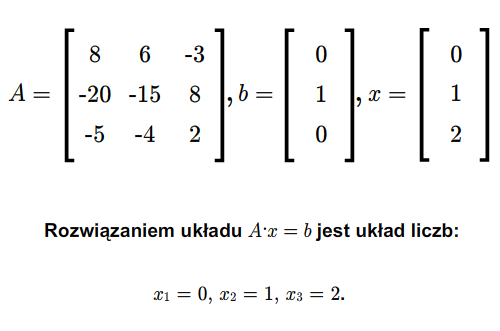

- wzory Cramera

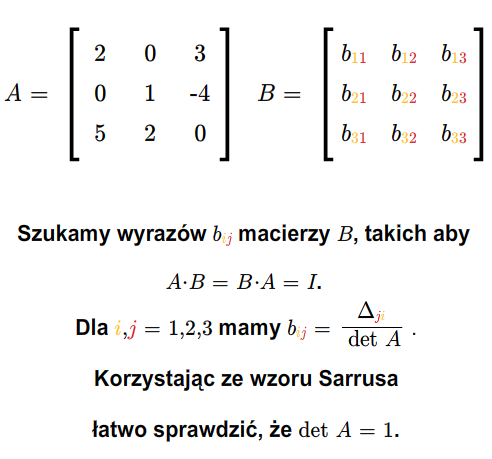

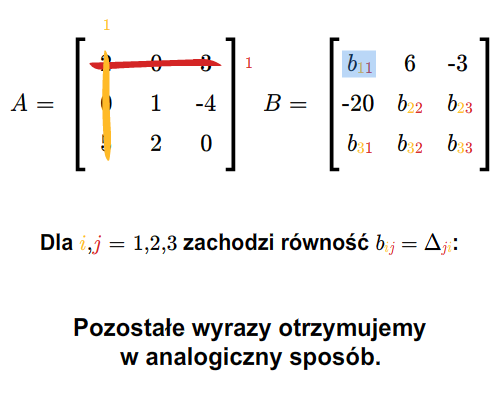

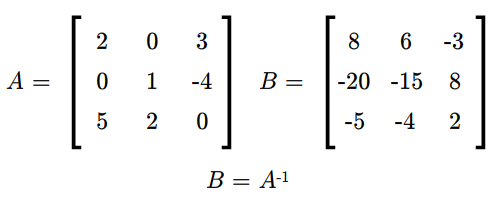

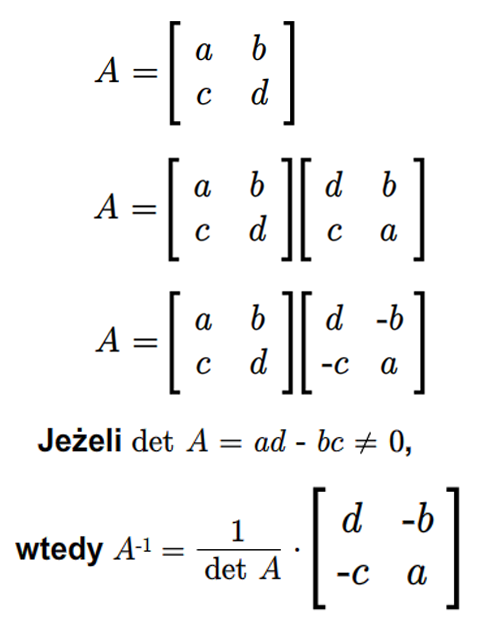

- wzory na wyrazy macierzy odwrotnej

- Endomorfizmy:

- wartość własna i wektor własny

- wielomian charakterystyczny

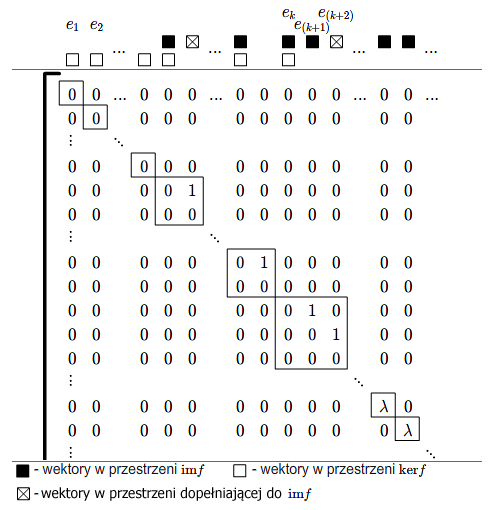

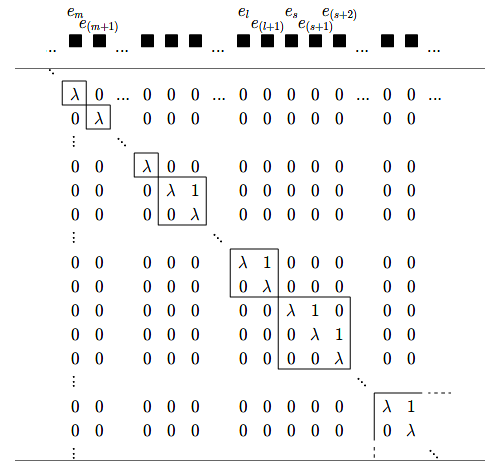

- bazy i macierze Jordana

- Formy kwadratowe:

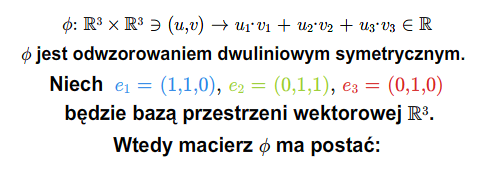

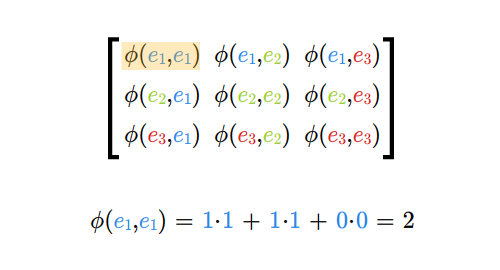

- macierz i rząd odwzorowania dwuliniowego

- twierdzenie Lagrange'a i Sylvestera, sygnatura formy kwadratowej

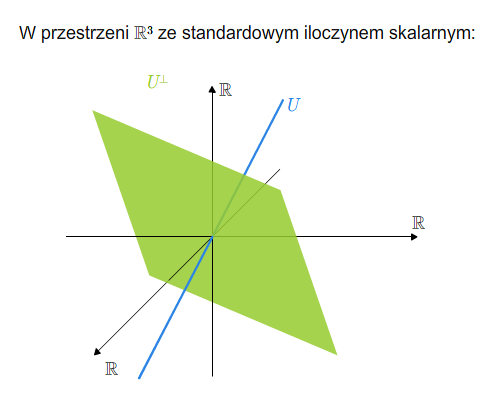

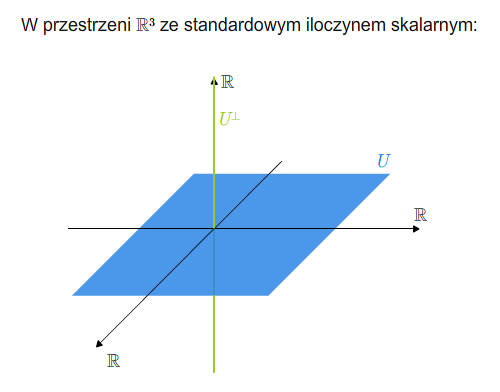

- Euklidesowe przestrzenie wektorowe:

- iloczyn skalarny

- norma wyznaczona przez iloczyn skalarny

- nierówność Schwarza

- baza ortonormalna, ortonormalizacja Grama-Schmidta

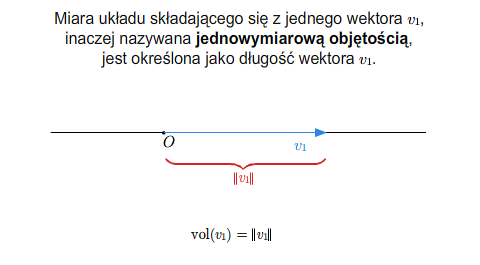

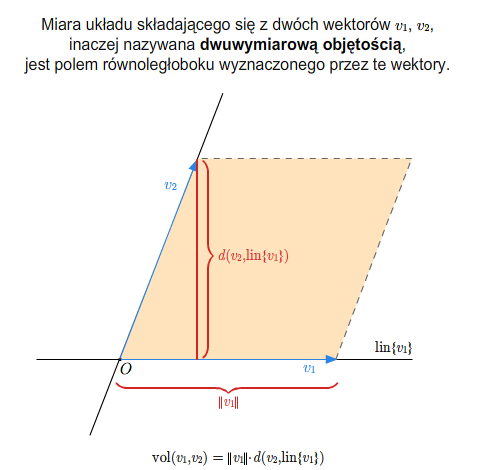

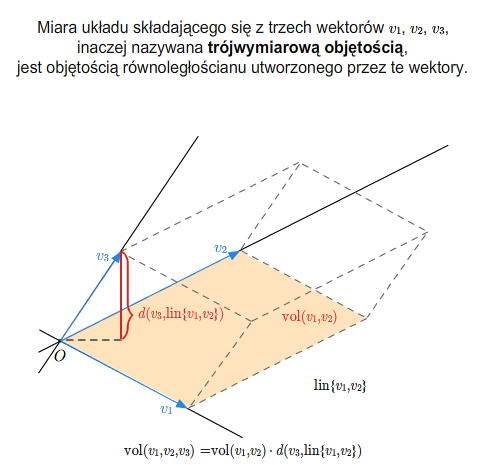

- macierz i wyznacznik Grama, miara układu wektorów

- izometrie liniowe, macierz ortogonalna

- Geometria analityczna:

- przestrzeń afiniczna, euklidesowa przestrzeń afiniczna, euklidesowa przestrzeń afiniczna \(R^n\)

- układ bazowy, ukośnokątny (prostokątny) układ współrzędnych

- podprzestrzeń afiniczna, operacje na podprzestrzeniach afinicznych

- równoległość podprzestrzeni afinicznych

- podprzestrzeń rozwiązań układu równań liniowych

- opisy analityczne podprzestrzeni afinicznych

- odległość punktów i niektórych figur

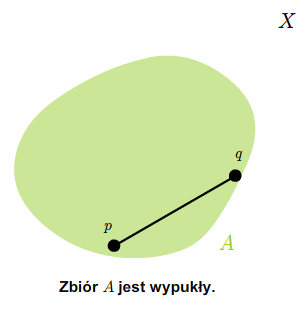

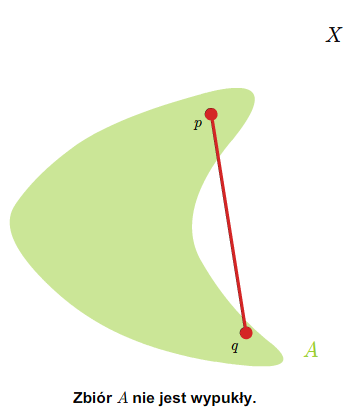

- zbiory wypukłe

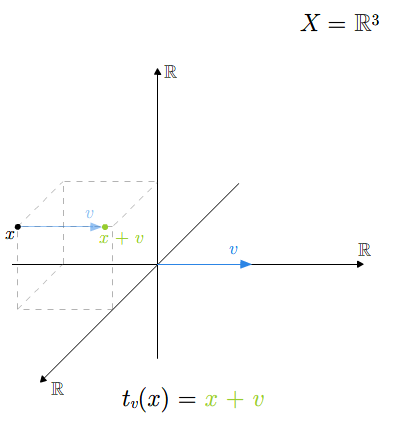

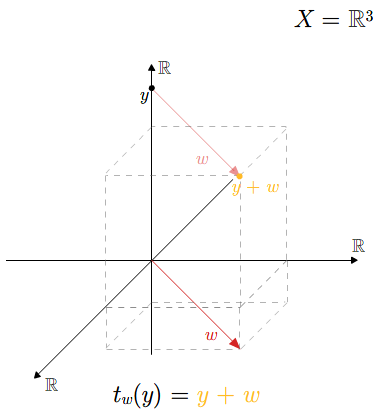

- odwzorowania afiniczne, izometrie, postać macierzowa

Literatura

- A. Białynicki-Birula, Algebra liniowa z geometrią, Państwowe Wydawnictwo Naukowe, Biblioteka Matematyczna t.48, Warszawa 1979.

- J. Gancarzewicz, Algebra liniowa z elementami geometrii, Wydawnicwo Naukowe UJ, Kraków, 2001.

- J. Komorowski, Od liczb zespolonych do tensorów, spinorów, algebr Liego i kwadryk, Państwowe Wydawnictwo Naukowe, Warszawa 1978.

- K. Nomizu, Fundamentals of Linear Algebra, McGraw-Hill, Inc., New York 1966.

- K. Sieklucki, Geometria i topologia, część I - Geometria, Państwowe Wydawnictwo Naukowe, Biblioteka Matematyczna t.53, Warszawa 1979, Warszawa 2006.

Grupy i ciała

Grupy

Przez strukturę algebraiczną rozumie się zbiór składający się ze skończonej liczby zbiorów i ze skończonej liczby odwzorowań iloczynów kartezjańskich tych zbiorów w te zbiory. Odwzorowania te nazywa się działaniami.

Zaczniemy od rozważenia najprostszych struktur.

Niech \(G\) będzie zbiorem niepustym. Działaniem wewnętrznym w zbiorze \(G\) nazywamy odwzorowanie \(d:G\times G\longrightarrow G\). Działanie \(d\) jest łączne, jeśli dla każdych \(a,b,c\in G\) zachodzi równość

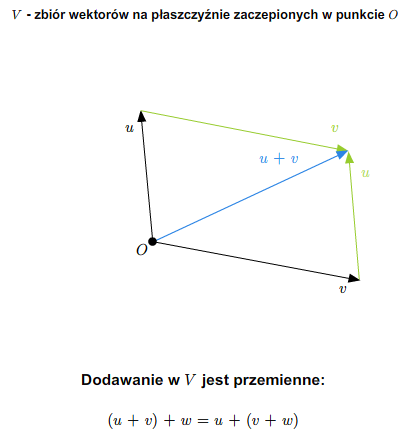

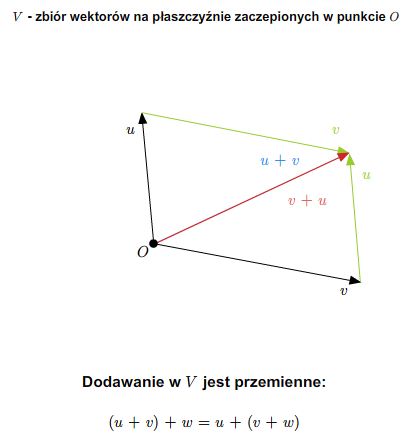

Mówimy, że działanie \(d\) jest przemienne, jeśli dla każdych

elementów \(a,b\in G\) zachodzi równość

Element \(e\in G\) nazywa się elementem neutralnym ze względu

na działanie \(d\), jeśli dla każdego elementu \(a\in G\) mamy

Łatwo widać, że jeśli istnieje element neutralny, to element taki

jest jedyny w \(G\). Istotnie, niech \(e\) i \(e'\) będą elementami neutralnymi ze względu na \(d\). Zachodzą następujące równości

Działania oznacza się najczęściej znakiem plus, tzn. \(+\), lub

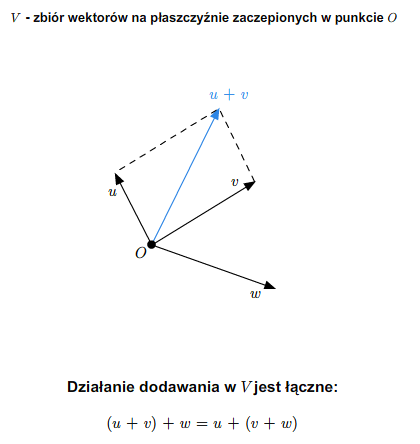

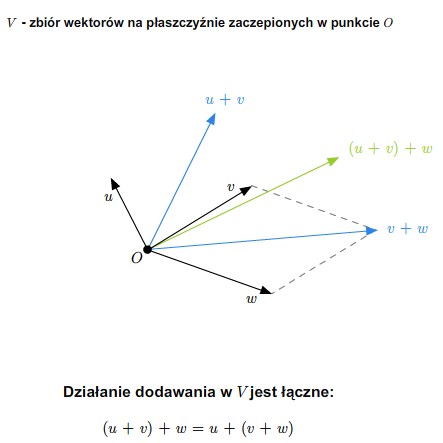

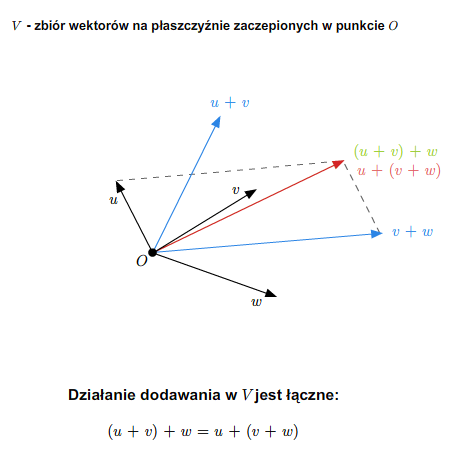

znakiem kropki, która zwykle jest w zapisie pomijana. Oczywiście są też inne sposoby oznaczania działań, np. kółkiem, gwiazdką, etc. Działanie oznaczane znakiem \(+\) nazywa się dodawaniem, działanie oznaczane kropką nazywa się mnożeniem. Jeśli działanie oznaczone jest plusem, to łączność oznacza, że dla każdych \(a,b,c\in G\) mamy \(a+(b+c)= (a+b) +c\). A zatem zapis \(a+b+c\) ma sens. Podobnie dla działania zapisywanego multyplikatywnie, czyli kropką, łączność oznacza, że \(a(bc)=(ab)c\) dla każdych \(a,b,c\in G\), a zapis \(abc\) ma sens. Oczywiście, łączność dodawania oznacza, że zapis \(a_1+...+a_n\) ma sens dla dowolnego \(n\in \mathbb N\), zaś w przypadku mnożenia, zapis \(a_1\cdot ...\cdot a_n\) ma sens dla dowolnego \(n\in \mathbb N\).

Jeśli działanie zapisywane jest w sposób addytywny, tzn. za pomocą znaku \(+\), to element neutralny (o ile istnieje) nazywany jest zerem i oznaczany przez \(0\). W przypadku zapisu multyplikatywnego, element neutralny nazywany jest często jedynką i oznaczany cyfrą \(1\).

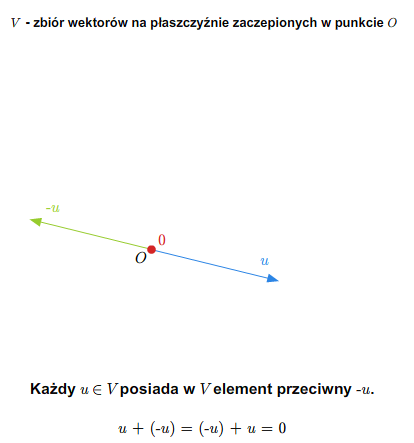

Załóżmy, że działanie \(d\) w zbiorze \(G\) ma element neutralny \(e\). Załóżmy najpierw, że działanie to jest zapisywane addytywnie. Mówimy, że element \(a\in G\) ma element przeciwny, jeśli istnieje element \(a'\in G\) taki, że \(a+a'=a'+a=e\). Jeśli działanie zapisywane jest multyplikatywnie, to mówimy, że element \(a\in G\) ma element odwrotny w \(G\), jeśli istnieje element \(a'\in G\), taki że \(aa'=a'a=e\).

Zauważmy, że jeśli działanie jest łączne, ma element neutralny i element \(a\in G\) ma element odwrotny (przeciwny), to element taki jest jedyny. Mianowicie, jeśli \(a'\) i \(a''\) są elementami odwrotnymi do \(a\), to (stosując zapis multyplikatywny) mamy następujące równości

Jeżeli działanie zapisywane jest w sposób addytywny i element \(a\)

ma dokładnie jeden element przeciwny, to element ten oznaczamy przez \(-a\). Ponadto, jeśli \(b\in G\), to przyjmujemy oznaczenie

Jeśli działanie zapisywane jest w sposób multyplikatywny i element \(a\) ma dokładnie jeden element odwrotny, to oznaczamy go przez

\(a^{-1}\). Przyjmujemy także oznaczenie

Definicja 1.1 [Grupa]

Mówimy, że zbiór niepusty \(G\) z działaniem wewnętrznym jest grupą, jeśli działanie to jest łączne, ma element neutralny i każdy element \(G\) ma element odwrotny (przeciwny).

Grupę nazywamy przemienną, lub abelową, jeśli jej działanie jest przemienne.

Załóżmy, że \(G'\) jest niepustym podzbiorem grupy \(G\). Mówimy, że \(G'\) jest podgrupą grupy \(G\), jeśli działanie grupy \(G\) zawężone do \(G'\times G'\) ma wartości w \(G'\) oraz dla każdego elementu \(a\in G'\) jego element odwrotny \(a^{-1}\) również należy do \(G'\).

Łatwo można sprawdzić, że podgrupa z zawężonym działaniem jest grupą.

Ciała

Rozważymy teraz zbiory wyposażone w dwa działania - dodawanie i mnożenie. Przyjmiemy następującą definicję.

Definicja 2.1 [Ciało]

Ciałem (dokładniej mówiąc - ciałem przemiennym) nazywamy zbiór \(\mathbb K\) wyposażony w dwa działania wewnętrzne - dodawanie i mnożenie, które spełniają następujące warunki:

C1) \(\mathbb K\) z dodawaniem jest grupą przemienną,

C2) mnożenie w \(\mathbb K\) jest przemienne i zbiór \(\mathbb K\setminus \{0\}\) z mnożeniem jest grupą,

C3) \(a(b+c)=ab+ac\) dla każdych elementów \(a,\, b,\, c\in \mathbb K\) (prawo rozdzielności mnożenia względem dodawania).

Udowodnimy najbardziej podstawowe własności ciał.

Twierdzenie 2.2 [Własności Ciała]

W ciele zachodzą następujące warunki:

- \(1\ne 0\),

- \(0\cdot a= a\cdot 0=0,\)

- \((-1)\cdot a =-a,\)

- jeżeli \(ab=0\), to \(a=0\) lub \(b=0\),

- jeżeli \(a\ne 0\) i \(b\ne 0\), to \((ab)^{-1}=b^{-1}a^{-1}\)

dla każdych \(a,\, b \in \mathbb K\).

Dowód

Wiemy, że zbiór \(\mathbb K \setminus \{0\}\) jest grupą ze względu na mnożenie, a więc \(1\in \mathbb K\setminus \{0\}\). Stąd mamy pierwszą własność.

Dla udowodnienia drugiej własności zauważmy, że

Dodając do obydwu stron \(-(0\cdot a)\) dostajemy żądaną równość. Korzystając z przemienności mnożenia w całym \(\mathbb K\) dostajemy równość \(a\cdot 0=0\) dla każdego \(a\in \mathbb K\). Stąd i założonej łączności mnożenia w \(\mathbb K\setminus\{0\}\) wynika już łączność mnożenia w całym zbiorze \(\mathbb K\).

Korzystając z drugiej własności dostajemy teraz

Ponieważ dodawanie w \(\mathbb K\) jest przemienne, dostajemy równość \((-1)a +a=0\). Oznacza to, że \((-1)a\) jest elementem przeciwnym do \(a\), co dowodzi trzeciej własności.

Dla dowodu czwartej własności przypuśćmy, że \(a\ne 0\). Wtedy, wykorzystując już udowodnioną własność (2) dostajemy

Własność ta wynika też z aksjomatu C2), bo w aksjomacie tym implicite założono, że \(\mathbb K\setminus \{0\}\) jest zamknięty ze względu na mnożenie.

Własność ostatnia wynika z następujących równości

Konsekwencją trzeciej własności i wcześniejszej umowy (1.1)

jest równość następująca:

dla każdych \(a,\, b,\, c\in \mathbb K\).

Wprowadzimy teraz pojęcie charakterystyki ciała.

Definicja 2.3 [Charakterystyka ciała]

Niech \(\mathbb K\) będzie ciałem. Jeżeli istnieje liczba naturalna \(n\) taka, że

gdzie jedynka w powyższej sumie występuje \(n\) razy, to najmniejszą taką liczbę \(n\) nazywamy charakterystyką ciała. Jeśli taka liczba naturalna nie istnieje, mówimy, że charakterystyka ciała równa jest \(0\).

Ponieważ \(1\ne 0\), więc charakterystyka ciała, jeśli nie jest równa \(0\), musi być większa lub równa \(2\). Ciałem o charakterystyce 2 jest tzw. ciało zero-jedynkowe, które można wprowadzić tak. W zbiorze \(\{0,\, 1\}\) wprowadzamy działania

Łatwo widać, że spełnione są wszystkie warunki definiujące ciało i ciało to ma charakterystykę równą 2.

Ciałami są zbiór liczb wymiernych i zbiór liczb rzeczywistych ze zwykłymi działaniami. Są to oczywiście ciała o charakterystyce \(0\). Ciała te oznaczamy symbolami \(\mathbb Q\) i \(\mathbb R\) odpowiednio.

Ciało liczb zespolonych

Niech \(\mathbb C\) będzie zbiorem \(\mathbb R\times \mathbb R\) wyposażonym w dwa następujące działania:

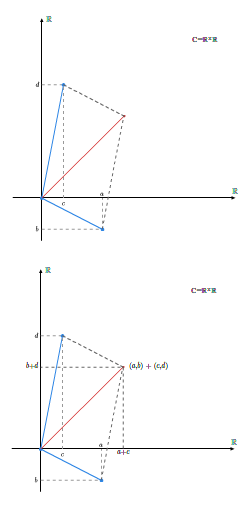

Dodawanie liczb zespolonych

Dodawanie liczb zespolonych

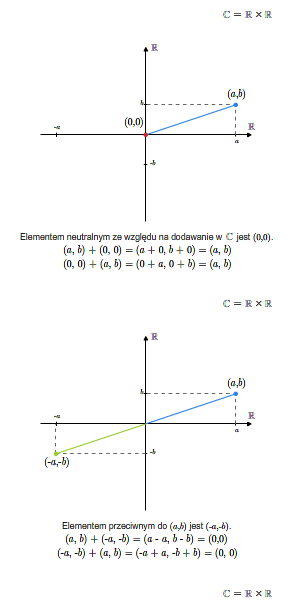

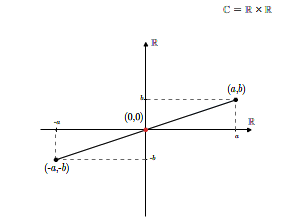

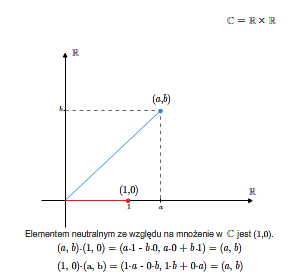

Sprawdzenie, że tak zdefiniowana struktura jest ciałem jest kwestią bezpośredniego rachunku. Elementem neutralnym ze względu na dodawanie (zerem w \(\mathbb C\)) jest element \((0,0)\), zaś elementem neutralnym ze względu na mnożenie jest element \((1,0)\). Elementem przeciwnym do elementu \((a,b)\) jest element \((-a,-b)\).

Elementem odwrotnym do niezerowego elementu \((a,b)\) jest element

Ciało liczb zespolonych ma charakterystykę 0.

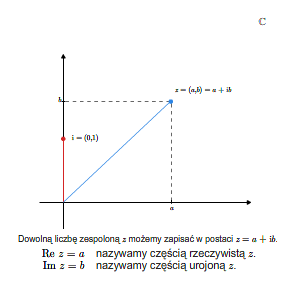

Element \((0,1)\) oznaczamy przez \(\mathbf i\). Liczbę rzeczywistą \(a\) utożsamiamy z liczbą zespoloną \((a,0)\). Dokładniej mówiąc, odwzorowanie

jest injekcją, czyli zbiór liczb rzeczywistych można uważać za podzbiór

zbioru liczb zespolonych. Co więcej, według powyższych formuł definiujących dodawanie i mnożenie w ciele liczb zespolonych, zwykłe dodawanie i mnożenie liczb rzeczywistych jest zawężeniem dodawania i mnożenia (odpowiednio) z ciała liczb zespolonych. Mówimy, że ciało \(\mathbb R\) jest podciałem ciała \(\mathbb C\).

Liczba zespolona \(\mathbf i =(0,1)\) ma tę własność, że \(\mathbf i ^2=-1\). W związku z tym, liczbę tę zapisywano jako \(\sqrt {-1}\). Oznaczenie to używane było już w XVI wieku, jako formalny symbol, do obliczania pierwiastków wielomianów. Współczesna teoria i symbolika liczb zespolonych pochodzi z XIX wieku.

Liczbę \(\mathbf i\) nazywamy jednostką urojoną i zgodnie z przyjętymi wyżej definicjami i ustaleniami, każdą liczbę zespoloną \((a,b)\) możemy zapisać jako \(a+b\mathbf i\). Liczbę rzeczywistą \(a\) nazywamy częścią rzeczywistą (z łac. realis) liczby zespolonej \(z=a+b\mathbf i\) i oznaczamy ją \(\Re\, z\), zaś liczbę rzeczywistą \(b\) nazywamy częścią urojoną ( z łac. imaginalis) liczby zespolonej \(z\) i oznaczamy ją przez \(\Im\, z\).

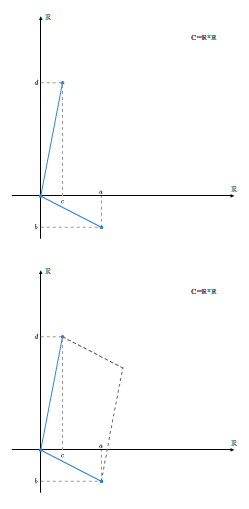

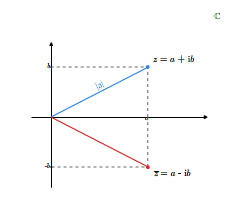

Liczby zespolone, jako elementy zbioru \(\mathbb R ^2\), możemy identyfikować z punktami na płaszczyźnie wyposażonej w prostokątny układ współrzędnych. Dokładniej mówiąc, liczbę zespoloną \(z=(a,b)\) przedstawiamy na płaszczyźnie jako punkt o współrzędnych \((a,b)\) lub jako wektor o początku w początku układu współrzędnych (w punkcie o współrzędnych \((0,0)\)) i końcu w punkcie o współrzędnych \((a,b)\). Przyjmując tę geometryczną interpretację liczby zespolonej, zbiór wszystkich liczb zespolonych nazywamy płaszczyzną liczb zespolonych. Dodawaniu liczb zespolonych odpowiada dodawanie wektorów zaczepionych w początku układu współrzędnych.

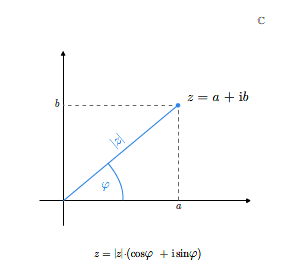

Dla liczby zespolonej wprowadzamy pojęcie modułu i argumentu. Modułem liczby zespolonej \(z=a+b\mathbf i\) nazywamy liczbę rzeczywistą \(|z|\) określoną wzorem

Biorąc pod uwagę geometryczną interpretację liczb zespolonych, widzimy, że moduł liczby \(z= a+b\mathbf i\) jest odległością punktu \((a,b)\) od początku układu współrzędnych lub długością wektora reprezentującego tę liczbę zespoloną. Moduł liczby zespolonej jest równy zeru wtedy i tylko wtedy, gdy liczba ta jest równa zeru.

Argumentem różnej od zera liczby zespolonej \(z=a+b\mathbf i\) nazywamy każdą liczbę rzeczywistą \(\varphi\) spełniającą układ równań

Umawiamy się, że dla liczby zespolonej \(z=0\) argumentem jest każda liczba rzeczywista. Argumentem głównym liczby zespolonej \(z\ne 0\) nazywamy ten argument, który leży w przedziale \([0,2\pi)\). Argument główny liczby zespolonej (niezerowej) oznaczmy przez \(\arg z\).

Argument główny jest kątem nachylenia wektora \(z\) do dodatniej półosi odciętych. Liczbę zespoloną \(z=a+b\mathbf i\) różną od \(0\) możemy teraz zapisać jako

Każdą liczbę zespoloną możemy zapisać jako

dla pewnego argumentu \(\varphi\). Zapis ten nazywamy trygonometryczną postacią liczby zespolonej.

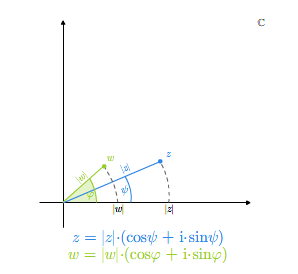

Można przeliczyć, stosując znane ze szkoły wzory trgonometryczne, że jeśli \(z_1=|z_1|( \cos\varphi _1 +\mathbf i \sin\varphi _1)\) i \(z_2 = |z_2|(\cos\varphi _2 +\mathbf i \sin\varphi _2)\), to

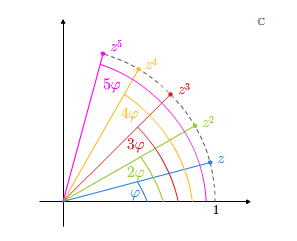

Jeśli przyjmiemy, że \(z^n = z\cdot ...\cdot z\), gdzie \(z\) powtarza się \(n\) razy, to posługując się ostatnim wzorem na mnożenie liczb zespolonych w postaci trygonometrycznej, dostajemy natychmiast tzw. wzory de Moivre'a na \(n\)-tą potęgę liczby zespolonej

Potęgowanie liczb zespolonych

Dla liczby zespolonej \(z=a+b\mathbf i\) definiujemy tak zwaną liczbę sprzężoną \(\overline z\) do liczby \(z\). Mianowicie, definiujemy

Jeśli \(z=|z|(\cos\varphi +\mathbf i \sin \varphi )\), to

Wobec tego liczba sprzężona \(\overline z\) jest obrazem przez odbicie symetryczne względem osi odciętych liczby \(z\), gdzie \(z\)

traktujemy jako punkt płaszczyzny lub wektor.

Na koniec tego wykładu przytoczymy, bez dowodu, bardzo ważną cechę ciała liczb zespolonych, której to cechy nie ma ciało liczb rzeczywistych. Najpierw wprowadźmy następującą definicję

Definicja 3.1 [Algebraiczna domkniętość]

Mówimy, że ciało \(\mathbb K\) jest algebraicznie domknięte, jeśli każdy wielomian jednej zmiennej o współczynnikach z ciała \(\mathbb K\) ma w ciele \(\mathbb K\) miejsce zerowe.

Jak wiadomo, ciało liczb rzeczywistych nie ma takiej własności, bo np. wielomian \(x^2 +1\) nie ma miejsc zerowych w \(\mathbb R\).

W przypadku liczb zespolonych zachodzi następujące twierdzenie, nazywane zasadniczym twierdzeniem algebry

Twierdzenie 3.2

Ciało liczb zespolonych jest algebraicznie domknięte.

Z twierdzenia tego wynika, że każdy wielomian o współczynnikach z ciała \(\mathbb C\) jest rozkładalny na czynniki stopnia 1 o współczynnikach z ciała \(\mathbb K\).

Przestrzenie wektorowe

Definicja przestrzeni wektorowej

Na początku tego wykładu wprowadzimy pojęcie przestrzeni wektorowej - najważniejszej struktury, którą zajmuje się algebra liniowa.

Definicja 1.1 [Przestrzeń wektorowa]

Niech \(V\) będzie zbiorem niepustym wyposażonym w działanie wewnętrzne - dodawanie. Dane jest także ciało \(\mathbb K\) oraz działanie zewnętrzne, tak zwane mnożenie zewnętrzne z lewej strony, będące odwzorowaniem zbioru \(\mathbb K \times V\) w zbiór \(V\). Wartość tego odwzorowania na parze \((\lambda ,v)\in \mathbb K\times V\) oznaczamy przez \(\lambda\cdot v\). Występującą tu kropkę najczęściej pomijamy.

Mówimy, że struktura składająca się ze zbioru \(V\), ciała \(\mathbb K\) oraz dwóch powyższych działań jest przestrzenią wektorową, jeśli spełnionych jest pięć poniższych warunków, zwanych aksjomatami przestrzeni wektorowej:

V1) Zbiór \(V\) z dodawaniem jest grupą przemienną,

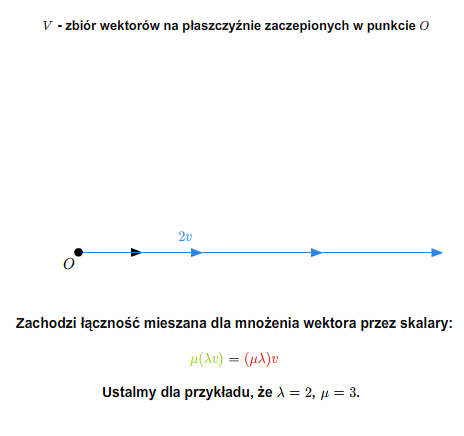

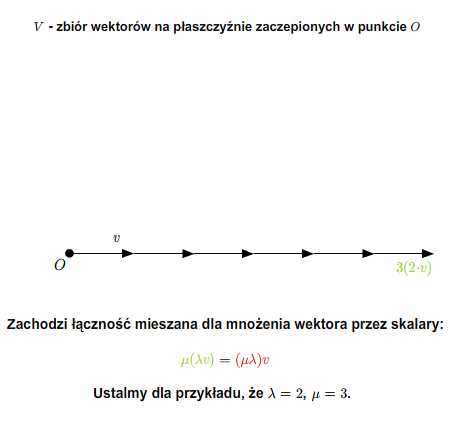

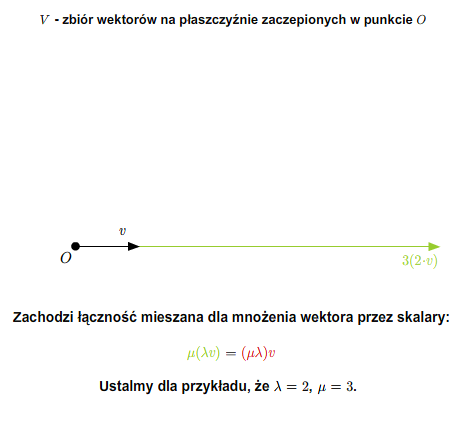

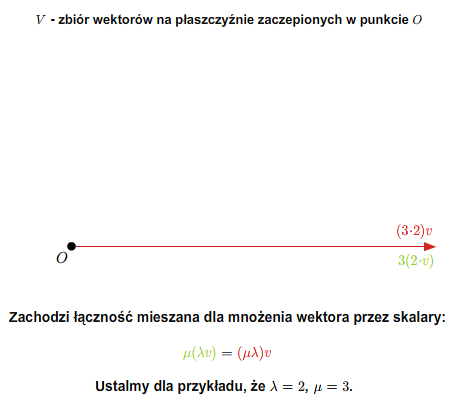

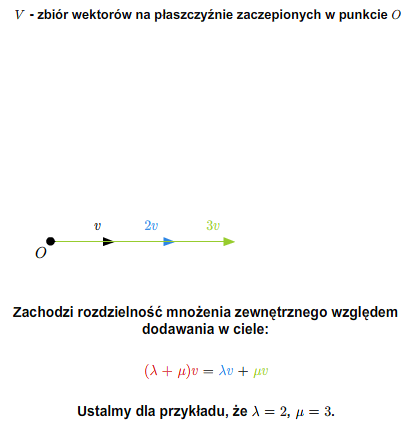

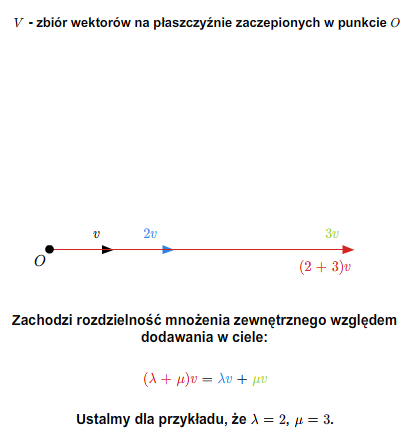

V2) Dla każdych \(\lambda\, \mu \in \mathbb K\) i dla każdego \(v\in V\) zachodzi równość \(\lambda(\mu v)=(\lambda\mu )v\).

V3) Dla każdych \(\lambda\, \mu \in \mathbb K\) i dla każdego \(v\in V\) zachodzi równość \((\lambda +\mu )v=\lambda v +\mu v\).

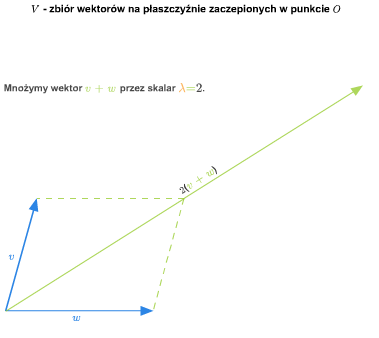

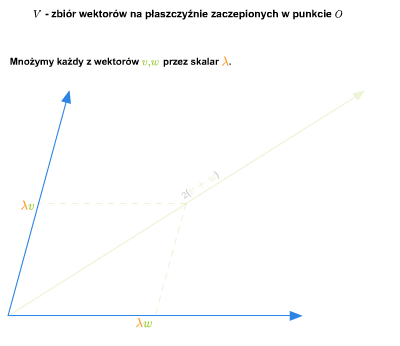

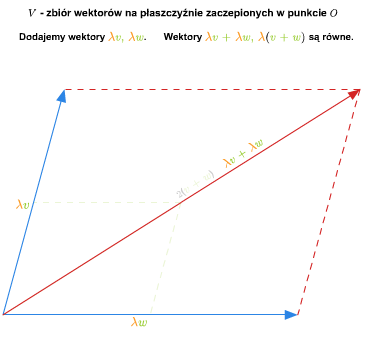

V4) Dla każdego \(\lambda \in \mathbb K\) i każdych \(v,w\in V\) zachodzi równość \(\lambda (v+w)= \alpha v +\alpha w\).

V5) Dla każdego \(v\in V\) zachodzi równość \(1\cdot v= v\).

W pierwszym aksjomacie najczęściej żąda się, tak jak to zrobiliśmy, aby grupa była przemienna, choć przemienność tej grupy jest konsekwencją pozostałych warunków. Proponujemy, aby czytelnik sam sprawdził ten fakt. Aksjomaty V2)- V5) są w definicji niezbędne. Proponujemy, aby czytelnik sprawdził to, znajdując przykład struktury, dla której spełnione są wszystkie warunki oprócz V2), następnie przykład struktury, dla której spełnione są wszystkie warunki oprócz warunku V3), etc. Własność V3) nazywa się łącznością mieszaną, własność V4) - rozdzielnością mnożenia zewnętrznego względem dodawania w ciele i wreszczcie własność V4) - rozdzielnością mnożenia zewnętrznego względem dodawania wewnętrznego.

Jeśli spełnione są wszystkie powyższe aksjomaty, to mówimy także, że \(V\) jest przestrzenią wektorową nad ciałem \(\mathbb K\). Elementy przestrzeni \(V\) nazywamy wektorami, zaś elementy ciała \(\mathbb K\) nazywamy skalarami.

Zauważmy najpierw pewne elementarne własności przestrzeni wektorowych.

Twierdzenie 1.2

Niech \(V\) będzie przestrzenią wektorową nad ciałem \(\mathbb K\). Wtedy dla każdego \(v\in V\) i każdego \(\lambda \in \mathbb K\) zachodzą równości:

Uwaga 1.3

W pierwszej z powyższych równości \(0\) z lewej strony jest zerem w ciele, zaś \(0\) z prawej strony jest zerem w przestrzeni wektorowej. W drugiej równości oba \(0\) są zerami w przestrzeni wektorowej.

Dowód

Dowód trzech pierwszych z powyższych własności jest analogiczny do odpowiednich części dowodu Twierdzenia 2.2. z Wykładu 1. Dla dowodu czwartej własności załóżmy, że \(\lambda \ne 0\) i \(\lambda v=0\). Pomnóżmy obie strony przez \(\lambda ^{-1}\). Otrzymujemy stąd równość \(v=0\).

Podamy teraz kilka przykładów przestrzeni wektorowych.

Przykład 1.4

Dowolny zbiór jednoelementowy jest przestrzenią wektorową nad dowolnym ciałem. Jedyny element takiego zbioru jest zerem w tej przestrzeni. Taką przestrzeń nazywamy przestrzenią zerową.

Przykład 1.5

Każde ciało jest przestrzenią wektorową nad samym sobą.

Ogólniej, jeśli \(\mathbb K\) jest ciałem, to iloczyn kartezjański \(\mathbb K ^n\), \(n\in \mathbb N\), ma naturalną strukturę przestrzeni wektorowej nad ciałem \(\mathbb K\). Dodawanie w \(\mathbb K ^n\) definiujemy następująco

zaś mnożenie zewnętrzne dane jest formułą

Bezpośrednim i łatwym rachunkiem można sprawdzić, że tak zdefiniowana struktura na \(\mathbb K ^n\) jest przestrzenią wektorową nad ciałem \(\mathbb K\).

W kolejnym przykładzie zdefiniujemy strukturę przestrzeni wektorowej na iloczynie kartezjańskim dowolnych przestrzeni wektorowych.

Przykład 1.6

Niech \(V\), \(W\) będą przestrzeniami wektorowymi nad ciałem \(\mathbb K\). Wtedy iloczyn kartezjański \(V\times W\) ma naturalną strukturę przestrzeni wektorowej nad ciałem \(\mathbb K\). Istotnie, jeśli zdefiniujemy dodawanie formułą

dla \(v_1, v_2\in V\) i \(w_1, w_2\in W\), a mnożenie zewnętrzne formułą

dla \(\lambda \in\mathbb K\) i \(v\in V\), \(w\in W\), to otrzymujemy strukturę przestrzeni wektorowej (nad ciałem \(\mathbb K\)) na \(V\times W\).

Przykład 1.7

Załóżmy, że dana jest przestrzeń wektorowa \(V\) nad ciałem \(\mathbb K\) i \(X\) jest dowolnym zbiorem niepustym. Weźmy zbiór wszystkich odwzorowań \(f:X\longrightarrow V\). Oznaczmy ten zbiór przez \(V^X\). W zbiorze \(V ^X\) wprowadzamy dodawanie

dla każdych \(f,g\in V^X\) i dla każdego \(x\in X\). Mnożenie

zewnętrzne definiujemy formułą

dla \(\lambda \in\mathbb K\), \(f\in V\) i \(x\in X\).

Tak określone działania definiują , co łatwo sprawdzić, strukturę przestrzeni wektorowej na \(V^X\) nad \(\mathbb K\).

Jako szczególny przypadek możemy wziąć zbiór wszystkich ciągów nieskończonych o wartościach w dowolnej przestrzeni wektorowej \(V\). Zbiorem \(X\) jest tutaj zbiór liczb naturalnych \(\mathbb N\).

Jeśli za \(X\) weźmiemy zbiór \(\{1,...,n\}\), a \(V\) jest dowolną przestrzenią wektorową, to otrzymamy przestrzeń ciągów o długości \(n\) i wyrazach w \(V\).

Jeśli za \(X\) przyjmiemy pewien przedział w zbiorze liczb rzeczywistych, to zbiór wszystkich funkcji określonych na tym przedziale i o wartościach w zbiorze liczb rzeczywistych jest przestrzenią wektorową.

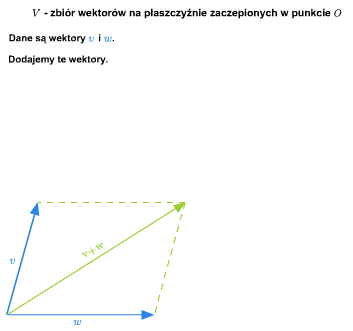

Przykład 1.8

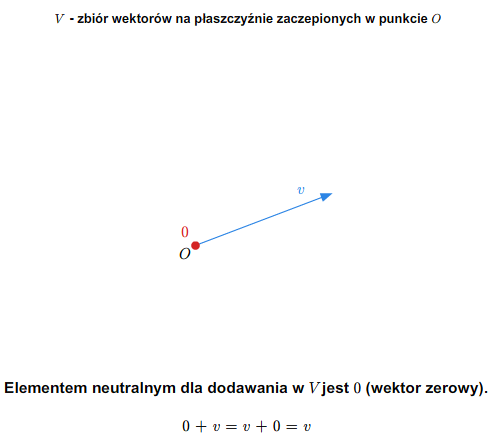

W szkole wprowadza się pojęcie wektora swobodnego na płaszczyźnie. Zbiór wszystkich takich wektorów ze znanymi ze szkoły dodawaniem (przez zastosowanie reguły równoległoboku) i mnożeniem wektorów przez liczby rzeczywiste stanowi przykład przestrzeni wektorowej nad ciałem \(\mathbb R\). Podobnie ma się rzecz ze zbiorem wektorów swobodnych w trójwymiarowej przestrzeni fizycznej.

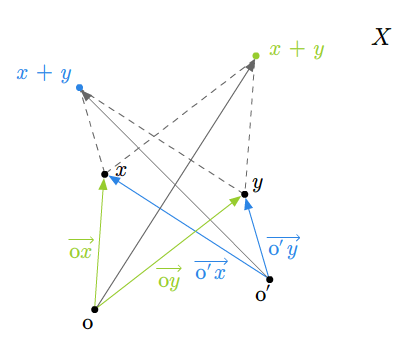

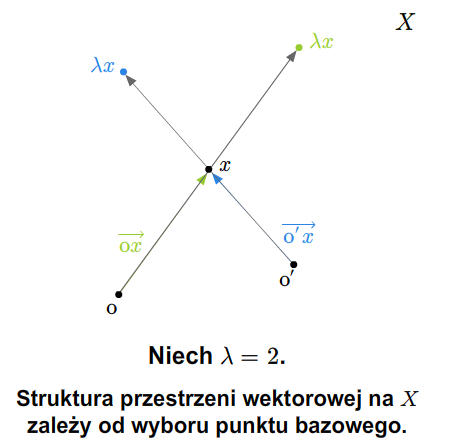

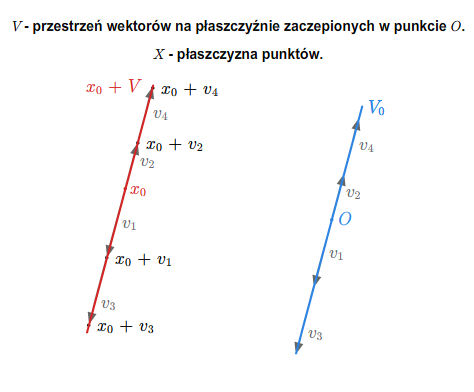

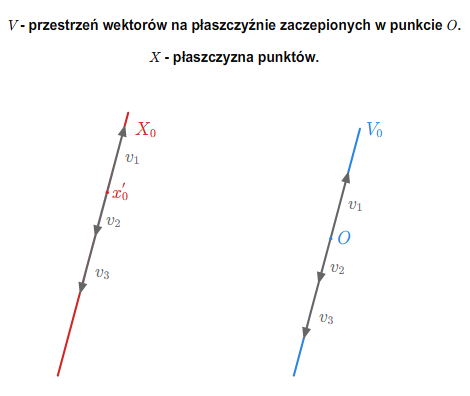

Można też rozumować tak (pomijając pojęcie wektora swobodnego). Rozważmy płaszczyznę (lub trójwymiarową przestrzeń) z ustalonym punktem (np. początkiem pewnego układu współrzędnych). Bierzemy zbiór wszystkich wektorów zaczepionych w tym punkcie. Wprowadzamy dodawanie wektorów i mnożenie przez liczbę rzeczywistą tak, jak się to robi w szkole. Tak otrzymana struktura jest przestrzenią wektorową nad \(\mathbb R\).

Jeśli płaszczyzna (lub trójwymiarowa przestrzeń fizyczna) jest wyposażona w układ współrzędnych, to tak otrzymaną przestrzeń wektorów można utożsamiać z \(\mathbb R ^2\) (w przypadku płaszczyzny) lub z \(\mathbb R ^3\) (w przypadku trójwymiarowej przestrzeni fizycznej).

Przestrzeń wektorową \(V\) nad ciałem liczb zespolonych nazywamy przestrzenią wektorową zespoloną. Przestrzeń wektorową nad ciałem liczb rzeczywistych nazywamy przestrzenią wektorową rzeczywistą. Każda przestrzeń wektorowa zespolona jest automatycznie przestrzenią wektorową rzeczywistą (z mnożeniem zewnętrznym będącym zawężeniem do \(\mathbb R\times V\) mnożenia zewnętrznego przez liczby zespolone).

Podprzestrzenie wektorowe

Definicja 2.1

Niech \(V\) będzie przestrzenią wektorową nad ciałem \(\mathbb K\). Załóżmy, że \(W\) jest niepustym podzbiorem zbioru \(V\). Podzbiór \(W\) nazywamy podprzestrzenią wektorową przestrzeni \(V\), jeśli dla każdych \(v,w\in W\) i \(\lambda\in\mathbb K\) mamy

Innymi słowy, podprzestrzeń wektorowa \(W\) przestrzeni \(V\) jest niepustym podzbiorem przestrzeni \(V\) zamkniętym ze względu na działania w \(V\). Jest jasne, że jeśli \(W\) jest podprzestrzenią \(V\), to dla każdych \(\lambda _1,...,\lambda _k \in \mathbb K\) i dla każdych wektorów \(v_1,..., v_k \in W\) wektor równy \(\lambda _1v_1+...+\lambda _kv_k\) należy do podprzestrzeni \(W\).

Jeżeli \(W\) jest podprzestrzenią wektorową przestrzeni \(V\) i \(v\in W\), to \(-v=(-1) v\) również należy do \(W\). A zatem \(0=v+(-1)v \in W\), czyli do każdej podprzestrzeni wektorowej \(W\) musi należeć zero przestrzeni \(V\).

Ponieważ własności działań przestrzeni wektorowej \(V\) zawarte w aksjomatach dziedziczą się łatwo na podzbiór zamknięty ze względu na te działania, więc podprzestrzeń wektorowa jest przestrzenią wektorową (nad tym samym ciałem co przestrzeń \(V\)).

Podamy kilka najważniejszych przykładów podprzestrzeni wektorowych. Oczywiście cała przestrzeń \(V\), a także podzbiór \(\{0\}\subset V\) są podprzestrzeniami wektorowymi \(V\). Są to tak zwane podprzestrzenie trywialne.

Kolejny przykład będzie odgrywać ważną rolę w naszym wykładzie

Przykład 2.2

Jeśli \(a_1,...a_n\) są ustalonymi elementami ciała \(\mathbb K\), to zbiór opisany równaniem liniowym \(a_1x_1+...+a_nx_n=0\), tzn. zbiór

\(\begin{cases} & a_{11}x_1+...+a_{1n}x_n=0,\\ & .\\ & .\\ & .\\ & a_{m1}x_1+...+a_{mn}x_n=0, \end{cases}\) (2.2)

gdzie \(a_{ij}\) dla \(i=1,...,m\), \(j=1,...,n\), są dowolnymi ustalonymi skalarami. Jest to układ \(m\) równań z \(n\) niewiadomymi \(x_1,...x_n\). Zbiór wszystkich rozwiązań tego układu, czyli zbiór wszystkich ciągów \((x_1,....,x_n)\in \mathbb K ^n\) spełniających (2.2), jest podprzestrzenią wektorową przestrzeni \(\mathbb K ^n\).}

Wróćmy teraz do Przykładu 1.7.

Przykład 2.3

Inny przykład wywodzący się z Przykładu 1.7 jest taki. Weźmy przestrzeń \(V=\mathbb R ^{\mathbb N}\) wszystkich nieskończonych ciągów o wyrazach rzeczywistych. Weźmy podzbiór składający się ze wszystkich ciągów zbieżnych do liczb rzeczywistych. Podzbiór ten jest podprzestrzenią \(V\).

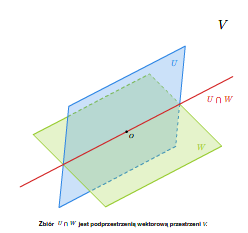

Jeżeli \(W\) i \(U\) są podprzestrzeniami wektorowymi przestrzeni \(V\), to ich iloczyn mnogościowy jest też podprzestrzenią wektorową przestrzeni \(V\). Istotnie, \(0\) należy do \(U\) i \(V\), a zatem \(U\cap W\) jest niepusty. Dalej, jeśli \(v, w\in U\cap W\), to obydwa te wektory należą do \(U\), a więc ich suma należy do \(U\), a także należą do \(W\), a więc ich suma należy do \(W\). Czyli \(v+w\in U\cap W\). Podobnie, jeśli \(\lambda \in\mathbb K\) i \(v\in U\cap W\), to \(\lambda v\) należy zarówno do \(U\) jak i do \(W\). Wobec tego \(\lambda v\in U\cap W\).

Równie łatwo można stwierdzić, że jeśli mamy dowolną niepustą rodzinę podprzestrzeni \({W_t}_{\{t\in T\}}\) przestrzeni \(V\), to ich iloczyn mnogościowy \(\bigcap _{t\in T} W_t\) jest podprzestrzenią wektorową.

Dodawanie mnogościowe podprzestrzeni wektorowych nie jest dobrą operacją, tzn. suma mnogościowa podprzestrzeni wektorowych na ogól nie jest podprzestrzenią wektorową. Zachodzi następujące twierdzenie, którego dowód proponujemy czytelnikowi

Twierdzenie 2.4

Suma mnogościowa dwóch podprzestrzeni wektorowych \(U\), \(W\) przestrzeni \(V\) jest podprzestrzenią wektorową przestrzeni \(V\) wtedy i tylko wtedy, gdy \(U\subset W\) lub \(W\subset U\).

Zamiast sumy mnogościowej podprzestrzeni rozważa się sumę algebraiczną podprzestrzeni.

Mianowicie, niech \(U\), \(W\) będą podprzestrzeniami wektorowymi przestrzeni \(V\). Definiujemy zbiór

Łatwo sprawdzić, że zbiór ten spełnia warunki podprzestrzeni wektorowej. Sumę tę można uogólnić na skończoną liczbę składników. Jeśli \(W_1,...,W_k\) są podprzestrzeniami wektorowymi przestrzeni \(V\), to

Zbiór ten jest podprzestrzenią wektorową przestrzeni \(V\).

Bardzo ważnym pojęciem dotyczącym sumy algebraicznej podprzestrzeni jest pojęcie sumy prostej podprzestrzeni.

Definicja 2.5 [Suma prosta]

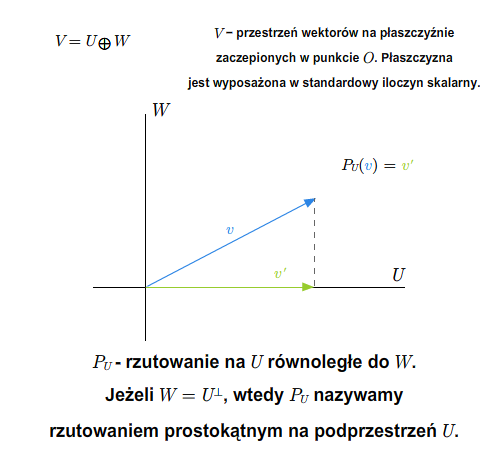

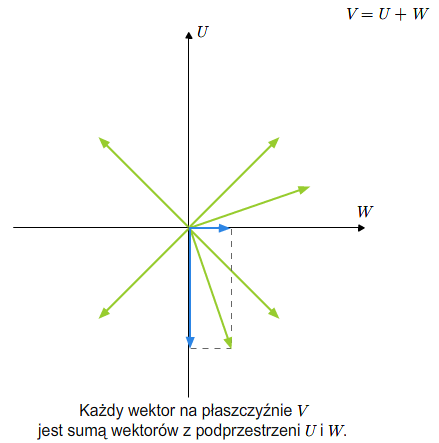

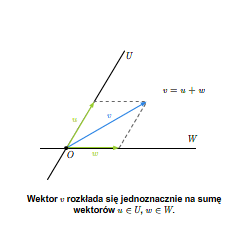

Mówimy, że \(V\) jest sumą prostą swoich podprzestrzeni \(U\) i \(W\), jeśli \(V=U +W\) oraz \(U\cap W=\{0\}\). Piszemy \(V=U\oplus W\).

Jednym z podstawowych powodów, dla których sumy proste są ważne, jest następujące twierdzenie

Twierdzenie 2.6

Jeżeli \(V=U\oplus W\), to każdy wektor \(v\in V\) można jednoznacznie przedstawić jako sumę wektorów przestrzeni \(U\) i \(W\).

Suma prosta podprzestrzeni wektorowych

Dowód

Do pokazania jest jednoznaczność. Niech \(v=u+w\), gdzie \(u\in U\) i \(w\in W\) oraz \(v=u'+w'\), gdzie \(u'\in U\) i \(w'\in W\). Wtedy \(u'-u=w-w'\). Po lewej stronie równości mamy wektor z przestrzeni \(U\), po prawej - z przestrzeni \(W\). A zatem oba należą do \(U \cap W\), czyli muszą być równe zeru.

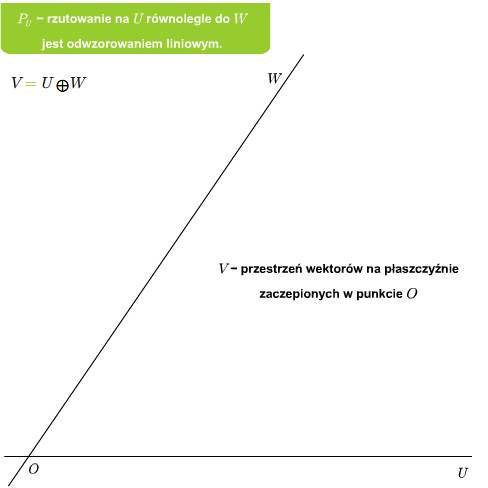

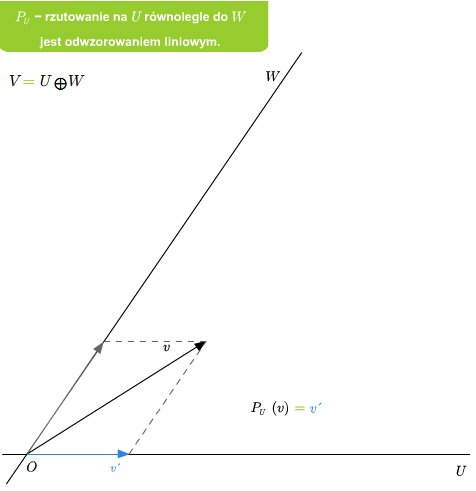

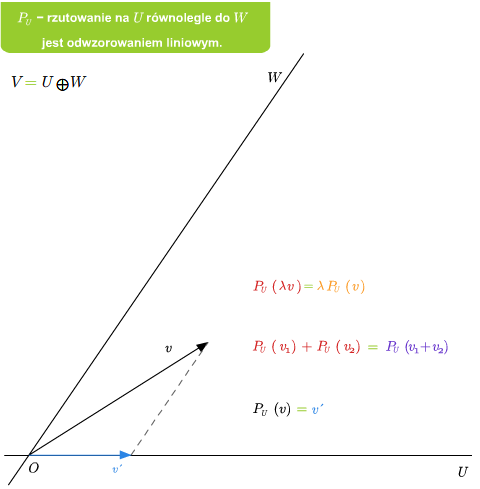

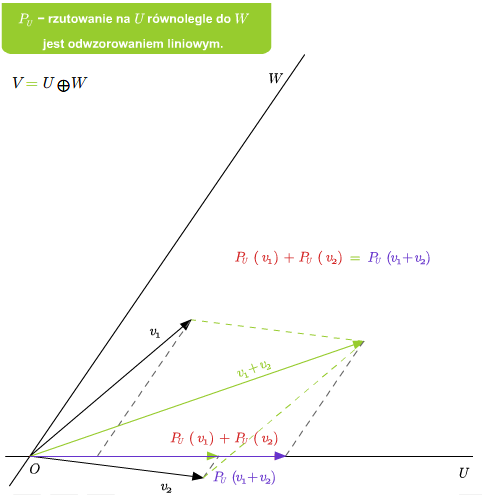

Mając sumę prostą \(V=U\oplus W\) możemy zdefiniować rzutowania. Mianowicie, niech \(v\in V\). Wtedy \(v\) rozkłada się jednoznacznie na sumę \(v=u+w\), gdzie \(u\in U\) i \(v\in V\). Odwzorowanie \(P_U: V\longrightarrow V\), które wektorowi \(v\) przyporządkowuje \(u\) z powyższego rozkładu, nazywamy rzutowaniem na podprzestrzeń \(U\) w kierunku podprzestrzeni \(W\) (lub rzutowaniem na \(U\) równoległym do \(W\)). Podobnie definiuje się rzutowanie \(P_W\) na \(W\) w kierunku \(U\).

Jeżeli \(V=U\oplus W\), to \(W\) nazywamy dopełnieniem algebraicznym do \(U\). Oczywiście \(U\) jest wtedy dopełnieniem algebraicznym do \(W\).

Układy liniowo niezależne, generatory, bazy

Kombinacje liniowe, układy i zbiory liniowo niezależne, układy i zbiory generujące.

Niech \(V\) będzie przestrzenią wektorową nad ciałem \(\mathbb K\).

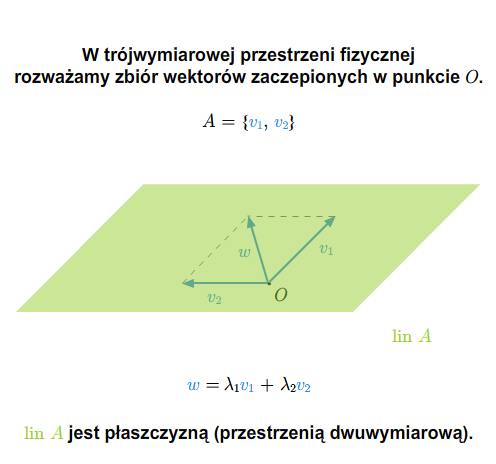

Kombinacją liniową wektorów \(v_1,..., v_n\in V\) nazywamy wyrażenie

gdzie \(\lambda _1,...,\lambda _n\) są skalarami z ciała \(\mathbb K\). Wartością kombinacji liniowej (1.1) nazywamy wektor równy \(\lambda _1v_1+...+\lambda _nv_n\). Skalary \(\lambda _1,...,\lambda _n\) nazywamy współczynnikami kombinacji liniowej (1.1). Kombinację liniową nazywamy trywialną, jeśli wszystkie jej współczynniki są zerami. Kombinację liniową nazywamy zerową, jeśli jej wartość jest wektorem zerowym. Każda kombinacja liniowa trywialna jest zerowa. Oczywiście nie każda kombinacja zerowa jest trywialna. Na przykład, kombinacja liniowa \(1\cdot v+(-1)\cdot v\) jest zerowa i nietrywialna.

W praktyce mówimy, że wektor \(v\) jest kombinacją liniową pewnych wektorów mając na myśli to, że jest wartością tej kombinacji.

Wprowadzimy teraz fundamentalne dla naszego wykładu pojęcie liniowej niezależności.

Definicja 1.1 [Liniowa niezależność]

Mówimy, że ciąg wektorów \(v_1,..., v_n\) przestrzeni wektorowej \(V\) jest liniowo niezależny, jeśli spełniona jest następująca implikacja:

Jeżeli \(\lambda _1v_1+...\lambda _nv_n =0\) dla pewnych skalarów \(\lambda _1,...,\lambda _n\), to wszystkie te skalary muszą być zerami.

Innymi słowy, ciąg \(v_1,...,v_n\) jest liniowo niezależny, jeżeli każda jego kombinacja liniowa, która jest zerowa, jest trywialna. Kolejność wektorów w ciągu \(v_1,..., v_n\) jest w tej definicji nieistotna. Zamiast mówić o ciągach liniowo niezależnych, mówimy o układach liniowo niezależnych. Słowo układ zawiera najczęściej w sobie informację, że kolejność jego elementów jest nieistotna. Mówimy też o zbiorach liniowo niezależnych. Jasne jest, co to znaczy, że skończony zbiór jest liniowo niezależny. Różnica między zbiorem skończonym a układem jest taka, że w układzie mogą się pojawić wektory jednakowe.

Zbiór pusty uznajemy za liniowo niezależny.

Mówimy, że dowolny zbiór (niekoniecznie skończony) jest liniowo niezależny, jeśli każdy jego podzbiór skończony jest liniowo niezależny. Definicja taka nie prowadzi do żadnej sprzeczności z definicją liniowej niezależności w przypadku zbiorów skończonych, ponieważ zachodzi następujący lemat

Lemat 1.2 [Podukład]

Niech \(v_1,...v_n\) będzie układem liniowo niezależnym. Wtedy każdy jego podukład jest też liniowo niezależny.

Dowód

Można założyć, że dany podukład składa się z wektorów \(v_1,..., v_k\), gdzie \(k<n\). Niech \(\lambda _1v_1+...+\lambda _kv_k=0\). Wtedy

Korzystając teraz z liniowej niezależności wektorów \(v_1,...,v_n\) dostajemy, że wszystkie współczynniki \(\lambda _1,...,\lambda _k\) są zerami.

Mówimy, że wektory \(v_1,...,v_n\) są liniowo zależne, jeśli nie są liniowo niezależne. A zatem, wektory \(v_1,...,v_n\) są liniowo zależne, jeśli istnieją skalary \(\lambda_1,...,\lambda _n\in \mathbb K\), nie wszystkie równe zeru takie, że \(\lambda _1v_1+...+\lambda _nv_n =0\). Wtedy pewien wektor wśród \(v_1,..., v_n\) mianowicie każdy, przy którym współczynnik w kombinacji \(\lambda _1v_1+...+\lambda _nv_n=0\) jest niezerowy) da się przedstawić jako kombinacja liniowa pozostałych wektorów. Przypuśćmy, że \(\lambda _1\ne 0\). Wtedy

Podkreślmy, że liniowa zależność wektorów \(v_1,...,v_n\) nie oznacza, że każdy wektor wśród \(v_1,...v_n\) jest kombinacją liniową pozostałych wektorów.

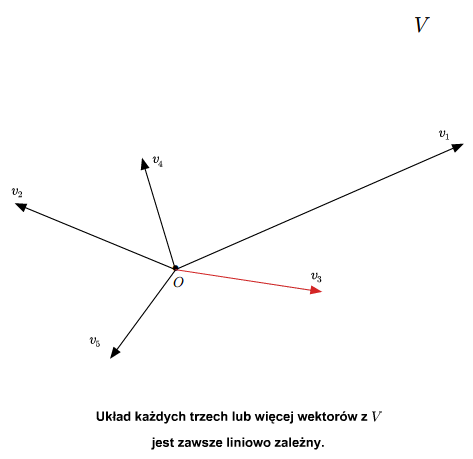

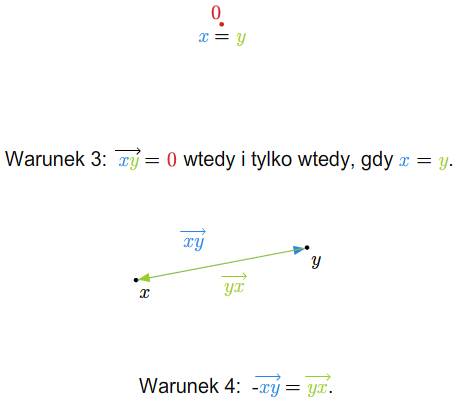

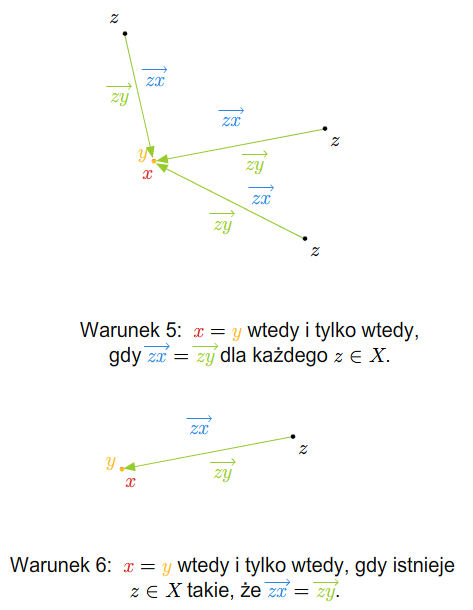

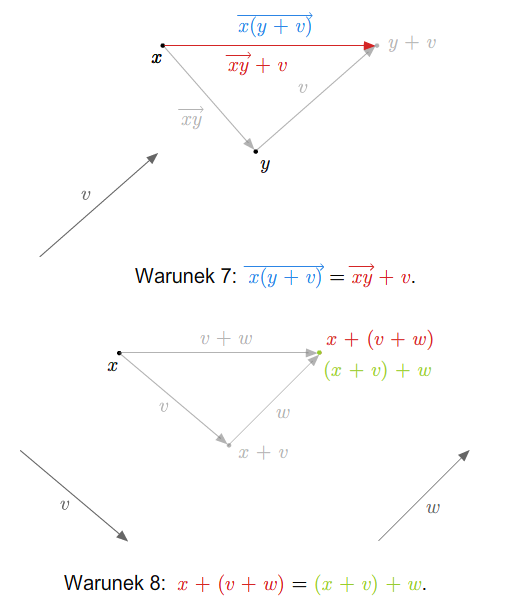

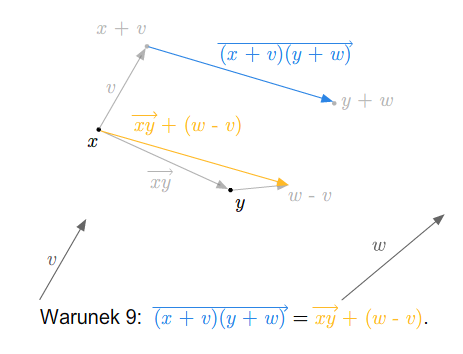

Al-3-2

Al-3-2

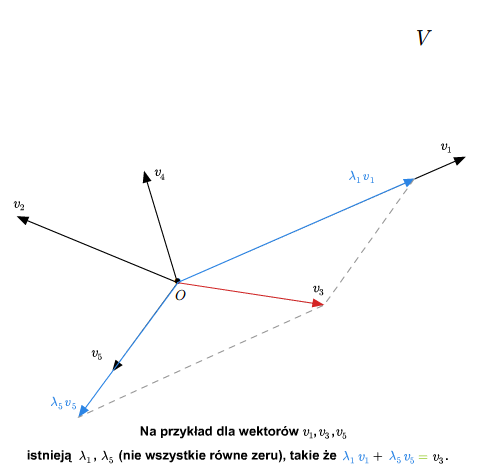

AL-3-3

AL-3-3

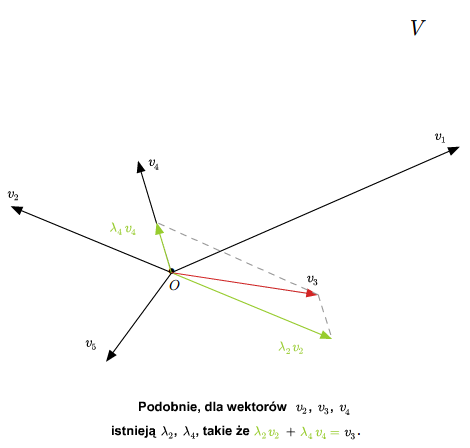

AL-3-4

AL-3-4

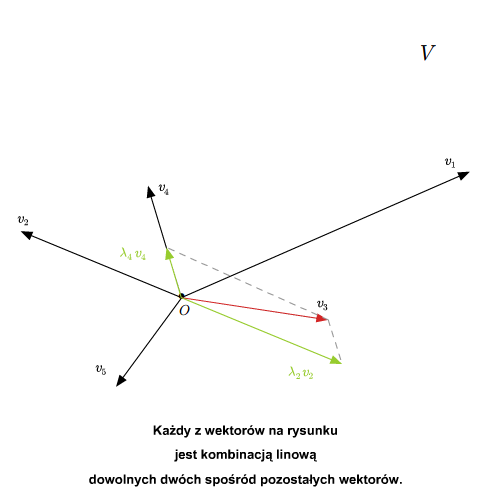

AL-3-5

AL-3-5

Każdy układ zawierający \(0\) lub dwa jednakowe wektory jest liniowo zależny. Ponadto, układ dwóch wektorów \(u,v\in V\) jest liniowo zależny wtedy i tylko wtedy, gdy wektory te są proporcjonalne, tzn. \(v=\lambda u\) lub \(u=\gamma v\) dla pewnych \(\lambda, \gamma \in \mathbb K\). Sprawdzenie tych faktów pozostawiamy jako ćwiczenie.

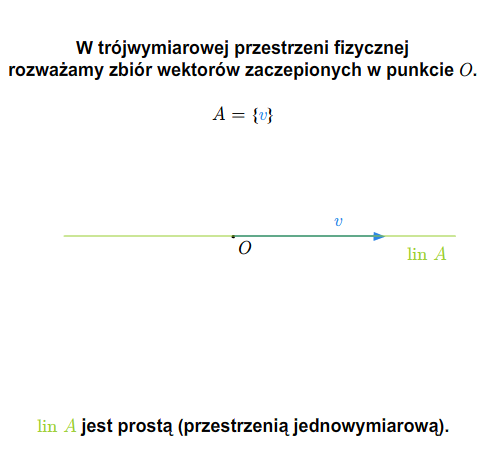

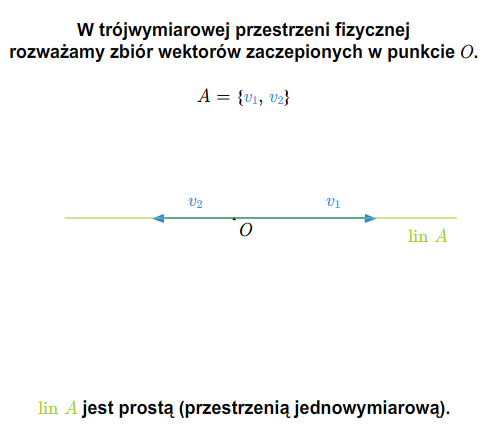

Niech teraz \(A\) będzie dowolnym podzbiorem przestrzeni \(V\). Bierzemy rodzinę wszystkich podprzestrzeni wektorowych zawierających podzbiór \(A\). Rodzina ta jest niepusta, bo cała przestrzeń \(V\) należy do tej rodziny. A zatem przecięcie wszystkich zbiorów tej rodziny jest podprzestrzenią wektorową zawierającą \(A\) (najmniejszą w sensie inkluzji). Oznaczmy tę podprzestrzeń symbolem \( lin A\). Jeżeli \(A\) jest zbiorem pustym, wtedy \( lin A=\{0\}\). Jeżeli \(W= lin A\), to mówimy, że \(A\) generuje (rozpina) podprzestrzeń \(W\). Oczywiście można też mówić o układzie \(A\) i podprzestrzeni generowanej przez ten układ. Jest oczywiste, że jeśli \(A\subset B\), to \( lin A\subset lin B\). Jeśli \(W\) jest podprzestrzenią wektorową, to \( lin\, W =W\), a zatem dla dowolnego podzbioru \(A\) mamy równość \( lin ( lin A)= lin A\).

Twierdzenie 1.3 [Span]

Niech \(A\) będzie niepustym podzbiorem przestrzeni wektorowej \(V\). Wtedy

Dowód

Łatwo można sprawdzić, że zbiór znajdujący się po prawej stronie równości(1.2) jest podprzestrzenią wektorową zawierającą \(A\). A zatem \( A\) zawiera się w tym zbiorze. Odwrotnie, jest oczywiste, że każdy element tego zbioru (wartość kombinacji liniowej pewnych wektorów zbioru \(A\)) jest elementem podprzestrzeni wektorowej \( lin A\).

W dalszym ciągu będziemy wykorzystywali następujące lematy.

Lemat 1.4

Niech \(v_1,..., v_n\) będą wektorami liniowo niezależnymi i \(w\notin lin \{v_1,...,v_n\}\). Wtedy wektory \(v_1,...,v_n, w\) są liniowo niezależne.

Dowód

Niech

Gdyby \(\lambda\ne 0\), to wektor \(w\) byłby kombinacją liniową wektorów \(v_1,...,v_n\), a zatem należałby do \( lin \{v_1,...,v_n \}\), co byłoby sprzeczne z założeniem. A więc \(\lambda =0\) i w konsekwencji mamy zerową kombinację liniową wektorów liniowo niezależnych \(v _1,...,v_n\). A zatem wszystkie \(\lambda _1\), ..., \(\lambda _n\) są zerami.

Lemat 1.5

Niech wektor \(w\) będzie kombinacją liniową wektorów \(v_1,...v_n\), t.j. \(w=\lambda _1v_1 +...+\lambda _n v_n\), dla pewnych skalarów \(\lambda _1,...,\lambda _n\). Jeżeli \(\lambda _1\ne 0\), to

Dowód

Ponieważ \(w\) jest kombinacją liniową wektorów \(v_1,...v_n\), więc \( lin \{w,v_2,...,v_n\}\subset lin \{ v_1,...,v_n\}\).

Z drugiej strony, ponieważ \(\lambda _1\ne 0\), więc

Zatem każda kombinacja liniowa wektorów \(v_1,...v_n\) jest też kombinacją liniową wektorów \(w,v_2,...,v_n\).

Twierdzenie 1.6

Niech \(w_1,...,w_m\), \(v_1,...v_n\) będą wektorami przestrzeni \(V\). Jeżeli \(w_1,...,w_m\) są liniowo niezależne oraz \(w_1,..., w_m \in lin \{v_1,...,v_n\}\), to \(m\le n\).

Dowód

Dla dowodu niewprost przypuśćmy, że \(m>n\). Wektor \(w_1\) jest kombinacja liniową wektorów \(v_1,...,v_n\). Po ewentualnym spermutowaniu wektorów \(v_1,...,v_n\), możemy przyjąć, że w tej kombinacji współczynnik przy \(v_1\) jest różny od \(0\). Z powyższego lematu mamy, że

Ponieważ \(w_2\) należy do tej przestrzeni, więc jest kombinacją liniową wektorów \(w_1,v_2,...,v_n\). W kombinacji tej przynajmniej jeden ze współczynników przy wektorach \(v_2,...,v_n\) musi być różny od zera. W przeciwnym bowiem przypadku, \(w_1,w_2\) byłyby liniowo zależne. Po ewentualnym spermutowaniu wektorów \(v_2,...,v_n\) możemy założyć, że współczynnik przy \(v_2\) jest różny od zera. A zatem, korzystając z Lematu 1.5,

dostajemy, że

Postępujemy podobnie dalej, tzn. zastępujemy kolejne wektory \(v_3,...\) wektorami \(w_3,...\). Ponieważ założyliśmy, że \(m>n\), więc dochodzimy do sytuacji, gdy \( lin \{w_1,...w_n\}= lin\{v_1,...v_n\}\). Oznacza to sprzeczność, gdyż wektor \(w_{n+1}\) musiałby być kombinacją liniową wektorów \(w_1,...,w_n\).

Baza i wymiar przestrzeni

Wprowadzimy teraz kolejne fundamentalne dla naszego wykładu pojęcie.

Definicja 2.1 [Baza]

Mówimy, że podzbiór (lub układ, lub ciąg) \(A\) przestrzeni wektorowej \(V\) jest bazą tej przestrzeni, jeśli jest liniowo niezależny i generuje \(V\).

Bazą przestrzeni zerowej jest zbiór pusty.

Twierdzenie 2.2 [Baza]

Załóżmy, że wektory \(v_1,...,v_n\) generują przestrzeń wektorową \(V\). Z wektorów \(v_1,..., v_n\) można wybrać bazę przestrzeni \(V\).

Dowód

Weźmy wszystkie podukłady układu \(v_1,...,v_n\) i wśród tych, które są liniowo niezależne, wybierzmy maksymalny, czyli o maksymalnej długości. (Taki podukład nie musi być jedyny.) Możemy założyć, że \(v_1,...,v_m\) jest takim podukładem. Twierdzimy, że jest to baza \(V\). Gdyby bowiem nie była to baza, to któryś z pozostałych wektorów \(v_{m+1},..., v_n\), powiedzmy \(v_{m+1}\), nie byłby kombinacją liniową wektorów \(v_1,...,v_m\). A zatem wektory \(v_1,...,v_{m+1}\) byłyby liniowo niezależne, na podstawie Lematu 1.4. Oznacza to, że podukład \(v_1,...,v_m\) nie byłby maksymalnym podukładem liniowo niezależnym.

Definicja 2.3 [Skończona wymiarowość]

Mówimy, że przestrzeń wektorowa jest skończenie wymiarowa, jeśli ma skończony układ generujący.}

Z powyższych twierdzeń wynika następujący wniosek

Twierdzenie 2.4

Przestrzeń skończenie wymiarowa \(V\) ma bazę.

Wykażemy ponadto

Twierdzenie 2.5

W przestrzeni skończenie wymiarowej wszystkie bazy są równoliczne, czyli mają tyle samo elementów.

Dowód

Niech \(B_1=\{e_1,..., e_n\}\) będzie skończoną bazą przestrzeni \(V\), a zatem, skończonym zbiorem generującym \(V\). Załóżmy, że \(B_2\) jest inną bazą tej przestrzeni. Wtedy każdy skończony podzbiór \(B_2\) jest liniowo niezależny. Z Twierdzenia 1.6 wynika, że każdy taki podzbiór ma co najwyżej \(n\) elementów. Oznacza to, że zbiór \(B_2\) jest skończony i ma co najwyżej \(n\) elementów. Zamieńmy teraz rolami bazy \(B_1\) i \(B_2\). Potraktujmy \(B_2\) jako zbiór generujący \(V\), zaś \(B_1\) jako zbiór liniowo niezależny. I znowu z Twierdzenia 1.6 wynika, że zbiór \(B_1\) ma co najwyżej tyle elementów co zbiór \(B_2\).

Na podstawie powyższego twierdzenia możemy podać następującą definicję wymiaru przestrzeni skończenie wymiarowej.

Definicja 2.6 [Wymiar]

Wymiarem przestrzeni skończenie wymiarowej nazywamy liczbę wektorów pewnej (lub, co na jedno wychodzi, każdej) bazy tej przestrzeni. Wymiar przestrzeni \(V\) oznaczamy symbolem \(\dim V\).

Kolejne twierdzenie jest natychmiastową konsekwencją powyższych rozważań.

Wniosek 2.7

Przestrzeń wektorowa jest skończenie wymiarowa wtedy i tylko wtedy, gdy ma bazę skończoną. Jeżeli \(e_1,...,e_n\) jest bazą przestrzeni \(V\), to każdy wektor \(v\) przestrzeni \(V\) da się w sposób jednoznaczny przedstawić jako kombinacja liniowa wektorów \(e_1,...,e_n\).

Dowód

Sprawdźmy jednoznaczność w ostatniej tezie. Jeśli \(e_1,...,e_n\) jest ustaloną bazą i \(v=\lambda _1e_1+...\lambda_ne_n\) oraz \(v=\lambda' _1e_1+...\lambda'_ne_n\), to \((\lambda_1 -\lambda' _1)e_1+...+(\lambda_n-\lambda'_n)e_n=0\). Z liniowej niezależności wektorów bazy dostajemy, że \(\lambda _i=\lambda'_i\) dla każdego \(i=1,...n\).

Jeżeli mamy bazę \(e_1,...,e_n\) przestrzeni wektorowej \(V\) i wektor \(v=\lambda _1e_1+...+\lambda _ne_n\), to skalary \(\lambda _1,...,\lambda _n\) nazywamy współrzędnymi wektora \(v\) w bazie \(e_1,..., e_n\).

Najważniejszym i najłatwiejszym przykładem bazy jest tak zwana baza kanoniczna przestrzeni \(\mathbb K ^n\). Mianowicie, baza ta jest ciągiem

Bardzo często kolejność wektorów bazy jest istotna. Aby to podkreślić,

mówimy, że baza jest uporządkowana. Baza kanoniczna jest uporządkowana w naturalny sposób.

Twierdzenie 2.8

Niech \(v_1,...,v_m\) będzie układem liniowo niezależnym w skończenie wymiarowej przestrzeni wektorowej \(V\). Układ ten można uzupełnić do bazy, a zatem istnieje baza przestrzeni \(V\) zawierająca dany układ liniowo niezależny.

Dowód

Niech \(W_1 = lin \{ v_1,..., v_m\}\). Jeżeli \(W_1\ne V\), to istnieje wektor \(v_{n+1}\) w \(V\), który nie należy do \(W_1\). Wtedy, na podstawie Lematu 1.4, zbiór \(v_1,...,v_n, v_{m+1}\) jest liniowo niezależny. Jeśli zbiór ten nie jest bazą \(V\), postępujemy tak jak poprzednio. To znaczy, bierzemy wektor \(v_{m+2}\notin lin \{v_1,...,v_n,v_{n+1}\}\) i dołączamy go do poprzednich wektorów. Postępując tak skończoną ilość razy otrzymujemy bazę przestrzeni \(V\).

Z twierdzenia tego wynika natychmiast

Wniosek 2.9

Każda podprzestrzeń \(W\) przestrzeni skończenie wymiarowej \(V\) jest skończenie wymiarowa i jej wymiar jest nie większy od wymiaru przestrzeni \(V\). Bazę \(e_1,...,e_n\) przestrzeni \(V\) można wybrać w ten sposób, że pierwsze jej wektory \(e_1,..., e_m\) stanowią bazę podprzestrzeni \(W\).

Dowód

Zauważmy jeszcze, że jeśli \(V\) jest przestrzenią skończenie wymiarową a \(U\) jest jej podprzestrzenią taką, że \(\dim U=\dim V\), to \(V=U\). Istotnie, wybierzmy pewną, powiedzmy \(n\)-elementową, bazę przestrzeni \(U\). Rozrzerzmy ją do bazy przestrzeni wektorowej \(V\). Ale ta rozrzerzona baza też musi mieć \(n\) elementów, a zatem wybrana baza przestrzeni \(U\) jest też bazą przestrzeni \(V\). To oczywiście implikuje, że \(U=V\).

Jeżeli mamy zbiór (lub układ wektorów) \(A\) przestrzeni wektorowej \(V\) i podprzestrzeń \( lin A\) jest skończenie wymiarowa, to rzędem \(A\) nazywamy liczbę \(\dim lin A\). Rząd \(A\) oznaczać będziemy symbolem \( rk A\).

Twierdzenie 2.10

Niech \(U\), \(W\) będą podprzestrzeniami przestrzeni skończenie wymiarowej przestrzeni wektorowej \(V\). Zachodzi wtedy wzór

Dowód

Wiemy już, że przestrzenie \(U\), \(W\), \(U\cap W\) są skończenie wymiarowe.

Niech \(e_1,...,e_m\) będzie bazą \(U\cap W\). Na podstawie Twierdzenia 2.8 wiemy, że układ ten można rozszerzyć do bazy przestrzeni \(U\) oraz do bazy przestrzeni \(W\).

Oznaczmy te bazy przez \(e_1,...,e_m, e_{m+1} ...e_{n_1}\) oraz \(e_1,..., e_m,e'_{m+1},..., e'_{n_2}\) odpowiednio. Twierdzimy, że zbiór

\(e_1,...,e_m, e_{m+1},..., e_{n_1},e'_{m+1},..., e'_{n_2}\) (2.3)

jest bazą przestrzeni \(U+W\).

Sprawdźmy najpierw generowanie. Niech \(v\in U + W\). Wtedy \(v=u+w\), gdzie \(u\in U\) i \(w\in W\). Istnieją skalary \(\alpha _1,..., \alpha _{n_1}\) oraz \(\beta _1,..., \beta _{n_2}\) takie, że

Wobec tego

Sprawdzimy teraz liniową niezależność układu (2.3). Niech

\(0=\lambda _1 e_1+...+ \lambda _m e_m + \lambda _{m+1}e_{m+1}+ ...+\lambda _{n_1} e_{n_1} + \lambda ' _{m+1}e'_{m+1}+...+\lambda ' _{n_2} e'_{n_2}.\) (2.4)

Oznaczmy przez \(w\) wektor \(\lambda ' _{m+1}e'_{m+1}+...+\lambda '_{n_2} e'_{n_2}\), zaś przez \(u\) wektor \(\lambda _1 e_1+...+\lambda _m e_m + \lambda _{m+1}e_{m+1}+ ...+\lambda _{n_1}e_{n_1}\). Wtedy \(u=-w\). Wektor \(u\) należy do \(U\), a wektor \(w\) do \(W\). A zatem obydwa te wektory należą do podprzestrzeni \(U\cap W\). Oznacza to, że \(w =\gamma _1e_1+... +\gamma _m e_m\) i w konsekwencji mamy

Z liniowej niezależności układu \(e_1,...,e_m,e'_{m+1},..., e'_{n_2}\) dostajemy, że skalary \(\lambda '_{m+1},..., \lambda '_{n_2}\) są równe zeru. Wracając teraz do równości (2.4) i korzystając z liniowej niezależności układu \(e_1,..., e_{n_1}\) otrzymujemy, że \(\lambda _1,...,\lambda _{n _1}\) są również równe zeru.

Dowód został zakończony.

Wróćmy teraz do pojęcia sumy prostej zdefiniowanego w poprzednim wykładzie.

Na podstawie Twierdzenia 2.10 mamy

Wniosek 2.11

Jeśli \(V\) jest skończenie wymiarowa i \(V=U\oplus W\), to \(\dim V=\dim U +\dim W\).

Mamy ponadto

Twierdzenie 2.12

Niech \(V\) będzie skończenie wymiarową przestrzenią wektorową a \(U\) jej podprzestrzenią. Istnieje wtedy dopełnienie algebraiczne do \(U\).

Dowód

Niech \(e_1,...e_m\) będzie bazą \(U\). Rozszerzmy ten układ do do bazy przestrzeni \(V\). Oznaczmy tę rozszerzoną bazę przez \(e_1,...,e_m, e_{m+1},..., e_n.\) Oznaczmy przez \(W\) przestrzeń rozpiętą na wektorach \(e_{m+1},..., e_n\). Wtedy \(V=U\oplus W\).

Zauważmy, że dopełnienie algebraiczne nie jest wyznaczone jednoznacznie.

Zakończymy ten wykład uwagami o przestrzeniach nieskończenie wymiarowych.

Przestrzeń \(V\) nazywa się przestrzenią nieskończenie wymiarową, jeśli nie jest skończenie wymiarowa. Mamy następujący lemat

Lemat 2.13

Jeśli przestrzeń \(V\) zawiera nieskończony zbiór wektorów liniowo niezależnych, to \(V\) jest nieskończenie wymiarowa.

Dowód

Gdyby przestrzeń \(V\) była skończenie wymiarowa, to na podstawie Twierdzenia 1.6, każdy zbiór liniowo niezależny tej przestrzeni byłby skończony.

Dowodzi się, co wykracza poza ramy tego wykładu, że w każdej przestrzeni wektorowej (również nieskończenie wymiarowej) istnieje baza i wszystkie bazy danej przestrzeni są równoliczne (czyli bijektywne).

Odwzorowania liniowe

Definicja odwzorowania liniowego

Definicja 1.1 [Odwzorowanie liniowe]

Niech \(V\), \(W\) będą przestrzeniami wektorowymi nad ciałem \(\mathbb K\) i niech \(f: V\longrightarrow W\) będzie odwzorowaniem. Mówimy, że \(f\) jest liniowe, jeśli spełnione są następujące warunki

L 1) dla każdych wektorów \(u,v\in Vf(u+v)=f(u)+f(v)\),

L 2) dla każdych \(\lambda \in \mathbb K\) i \(v\in Vf(\lambda v)=\lambda f(v)\).

Własność pierwszą nazywamy addytywnością odwzorowania \(f\), drugą - jednorodnością \(f\).

Zespół warunków L 1) i L 2) można zastąpić jednym z następujących warunków L 3) lub L4).

L 3) Dla każdych \(\lambda ,\mu \in \mathbb K\) i dla każdych \(u,v\in V\) zachodzi równość \(f(\lambda u+\mu v)=\lambda f(u) +\mu f(v)\).

L 4) Dla każdych skalarów \(\lambda _1,...,\lambda _k\in \mathbb K\), wektorów \(v_1,...,v_k\in V\) i każdego \(k\in \mathbb N\), zachodzi równość

Dowód równoważności warunków L 3) i L 4) polega na zastosowaniu indukcji.

Zauważmy od razu, że \(f(0)=f(0\cdot v)= 0\cdot f(v)\), gdzie \(v\) jest dowolnym wektorem przestrzeni \(V\). A zatem, dla odwzorowania liniowego zawsze mamy \(f(0)=0\).

Przykład 1.2

Odwzorowanie stale równe zeru jest liniowe. Odwzorowanie identycznościowe dowolnej przestrzeni wektorowej na siebie jest liniowe. Odwzorowanie to oznaczać będziemy przez \(I\).

Przykład 1.3

Weźmy przestrzeń \(V\) wszystkich funkcji ciągłych na przedziale \((a,b)\subset \mathbb R\) o wartościach w \(\mathbb R\). Odwzorowanie

jest odwzorowaniem liniowym.

Podobny przykład otrzymuje się dla całki oznaczonej.

Rozważmy jeszcze przestrzeń \(U\) funkcji różniczkowalnych na przedziale \((a,b)\subset \mathbb R\) i odwzorowanie przyporządkowujące funkcji z \(U\) jej pochodną. Odwzorowanie to jest liniowe.

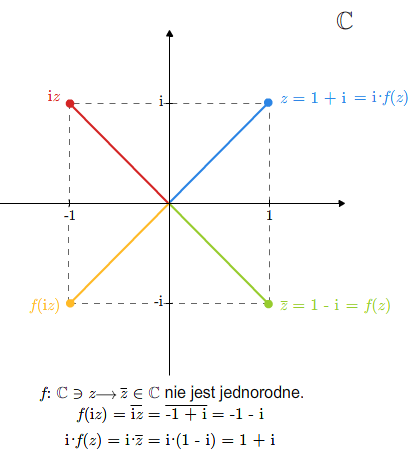

Przykład 1.4

Rozważmy odwzorowanie \(f:\mathbb C\ni z \longrightarrow \overline z\in \mathbb C\). Jeśli potraktujemy odwzorowanie \(f\) jako odwzorowanie przestrzeni wektorowych nad ciałem \(\mathbb C\), to odwzorowanie to nie jest liniowe, bo nie jest jednorodne.

Jeśli jednak potraktujemy \(\mathbb C\) jako przestrzeń wektorową nad ciałem \(\mathbb R\), to odwzorowanie \(f\) jest liniowe. Mówimy, że \(f\) jest \(\mathbb R\)-liniowe, ale nie jest \(\mathbb C\)-liniowe.

Własności odwzorowań liniowych. Obraz i jądro.

Omówimy teraz podstawowe własności odwzorowań liniowych.

Twierdzenie 2.1

Złożenie odwzorowań liniowych jest odwzorowaniem liniowym. Jeśli odwzorowanie liniowe jest bijekcją, to odwzorowanie odwrotne jest też liniowe.

Dowód

Tezy pierwszej dowodzi się bezpośrednim rachunkiem, co zostawiamy czytelnikowi. Dla sprawdzenia drugiej tezy ustalmy, że \(f:V\longrightarrow W\) jest liniową bijekcją. Niech \(w,w'\in W\). Wtedy istnieją jedne jedyne wektory \(v,v'\in V\) takie, że \(w=f(v)\) i \(w'=f(v')\). Zatem \(v=f^{-1}(w)\) i \(v' =f^{-1}(w')\). Niech \(\lambda, \mu\) będą dowolnymi skalarami. Zachodzą równości

Istotne cechy odwzorowań liniowych, często wykorzystywane w dalszej części wykładu, opisują następujące lematy

Lemat 2.2

Niech \(A\) będzie zbiorem generującym przestrzeń \(V\) i odwzorowania \(f, h: V\longrightarrow W\) będą liniowe. Jeśli \(f_{|A }=h_{|A}\), to \(f=h\).

Dowód

Niech \(v\in V\) będzie dowolnym wektorem. Istnieją wektory \(v_1,...,v_n\) ze zbioru \(A\) oraz skalary \(\lambda _1,...,\lambda _n\) takie, że \(v=\lambda _1v_1+...+\lambda _nv_n\). Ponieważ obydwa odwzorowania \(f\) i \(h\) są liniowe, więc \(f(v)=\lambda _1f(v_1)+...+\lambda _nf(v_n)= \lambda _1h(v_1)+...+\lambda _nh(v_n)=h(v)\).

Lemat 2.3

Niech \(B\) będzie bazą przestrzeni \(V\) i \(\tilde f: B\longrightarrow W\) będzie dowolnym odwzorowaniem.

Istnieje dokładnie jedno odwzorowanie liniowe \(f: V\longrightarrow W\) takie, że \(\tilde f =f_{| B}\)

Dowód

Dla dowolnego \(v\) istnieją wektory \(e_1,..., e_n\) należące do bazy i skalary \(\lambda _1,..., \lambda _n\) takie, że \(v=\lambda _1e_1+...+\lambda _ne_n\). Wybór wektorów z bazy i skalarów jest jednoznaczny. A zatem \(f\) zadane formułą

\(f(v)= \lambda _1\tilde f(e_1)+...+\lambda _n\tilde f(e_n)\) (2.1)

jest dobrze określone. Łatwo sprawdzić, że jest liniowe. Jest też oczywiste, że \(f\) musi być zadane formułą (2.1). Stąd jedyność \(f\) (lub z poprzedniego lematu).

Ostatni lemat mówi, że odwzorowanie liniowe może być zadane na bazie. Lemat dotyczy także przestrzeni nieskończenie wymiarowych.

Twierdzenie 2.4

Niech \(f: V\longrightarrow W\) będzie odwzorowaniem liniowym. Jeżeli \(U\) jest podprzestrzenią \(V\), to obraz podprzestrzeni \(U\) przez odwzorowanie f, czyli \(f(U)\), jest podprzestrzenią \(W\). Jeżeli \(U\) jest podprzestrzenią \(W\), to przeciwobraz podprzestrzeni \(U\) przez odwzorowanie \(f\), czyli \(f^{-1}(U)\), jest podprzestrzenią \(V\).

Dowód

Jeżeli \(w, z\in f(U)\), to \(w=f(v)\) i \(z=f(u)\) dla pewnych \(u, v\in U\). Zatem \(v+u\in U\) i \(w+z=f(v)+f(u)=f(v+u)\in f(U)\). Ponieważ \(\lambda u\in U\), więc \(\lambda z= \lambda f(u)=f(\lambda u)\in f(U)\) dla dowolnego skalara \(\lambda\).

Niech \(u,v\in f^{-1}(W)\). Wtedy \(f(u),f(v)\in W\) i, w konsekwencji, \(f(u)+f(v)\in W\). Zatem \(f(u+v)=f(u)+f(v)\in W\). Podobnie \(f(\lambda u)=\lambda f(u)\in W\) dla dowolnego \(\lambda\).

Dla odwzorowania liniowego definiuje się dwie ważne podprzestrzenie - obraz i jądro odwzorowania liniowego.

Definicja 2.5 [Jądro odwzorowania]

Niech \(f:V\longrightarrow W\) będzie odwzorowaniem liniowym. Jądrem odwzorowania \(f\) nazywamy podprzestrzeń \(f^{-1}(\{0\})\). Jądro oznaczamy symbolem \(\ker f\). Obrazem \(f\) nazywamy podprzestrzeń \(f(V)\) przestrzeni \(W\). Przestrzeń tę oznaczamy \( im f\). Wymiar przestrzeni \( im f\) nazywamy rzędem odwzorowania \(f\) i oznaczamy \( rk f\).

Przykład 2.6

Jeśli dana jest suma prosta \(V=U\oplus W\), to rzutowanie \(P_U\) na U równolegle do \(W\) jest liniowe. Ponadto \(\ker P_U=W\) oraz \( im P_U=U\).

Kolejny lemat wykorzystamy w dalszej części wykładu.

Lemat 2.7

Jeśli zbiór \(A\) generuje przestrzeń \(V\) i \(f:V\longrightarrow W\) jest odwzorowaniem liniowym, to \(f(A)\) generuje przestrzeń \( im f\).

Dowód

Oczywiście \(f(A)\subset im f\), a więc \( lin f(A)\subset im f\). Niech \(w\in im f\) i niech \(v\in V\) będzie takim wektorem, że \(f(v)=w\). Istnieją skalary \(\lambda _1,...,\lambda _n\in \) oraz wektory \(v_1,...,v_n\in A\) takie, że \(v=\lambda _1v_1+...+\lambda _nv_n\). Zatem \(w= f(v)= \lambda _1 f(v_1)+...+\lambda _n f(v_n)\in lin f(A)\).

Monomorfizmy. epimorfizmy, izomorfizmy

Definicja 3.1 [Monomorfizm]

Niech \(f\) będzie odwzorowaniem liniowym Odwzorowanie \(f\) nazywa się monomorfizmem, jeśli jest różnowartościowe. Odwzorowanie \(f\) nazywa się epimorfizmem, jeśli jest surjekcją. Odwzorowanie, które jest jednocześnie monomorfizmem i epimorfizmem (czyli liniowa bijekcja) nazywa się izomorfizmem.

Podamy teraz łatwe, ale bardzo ważne, twierdzenie charakteryzujące monomorfizmy.

Twierdzenie 3.2

Niech \(f:V\longrightarrow W\) będzie odwzorowaniem liniowym. Odwzorowanie to jest monomorfizmem wtedy i tylko wtedy, gdy \(\ker f=\{0\}\).

Dowód

Oczywiście \(0\in\ker f\). Niech \(f\) będzie monomorfizmem. Jeśli \(v\ne 0\), to \(f(v)\ne f(0)=0\). Oznacza to, że jedynym elementem zbioru \(\ker f\) jest wektor zerowy. Odwrotnie, jeśli \(\ker f\) składa się tylko z elementu zerowego i \(f(v)=f(u)\), to \(f(v-u)=f(v)-f(u)=0\), a więc \(u-v\in\ker f\). Ponieważ \(\ker f=\{0\}\), więc \(u=v\). Zatem \(f\) jest różnowartościowe.

Kolejne twierdzenie zawiera pewną charakteryzację monomorfizmów, epimorfizmów i izomorfizmów.

Twierdzenie 3.3

Niech \(f: V\longrightarrow W\) będzie odwzorowaniem liniowym.

- Jeżeli \(f\) jest monomorfizmem, to \(f\) przekształca każdy zbiór liniowo niezależny na zbiór liniowo niezależny.

- Jeżeli \(f\) przekształca injektywnie pewną bazę przestrzeni \(V\) na zbiór liniowo niezależny, to \(f\) jest monomorfizmem.

- Jeżeli \(f\) jest epimorfizmem, to \(f\) przekształca każdy zbiór generujący \(V\) na zbiór generujący przestrzeń \(W\).

- Jeżeli \(f\) przekształca pewien zbiór generujący \(V\) na zbiór generujący \(W\), to \(f\) jest epimorfizmem.

- Jeżeli \(f\) jest izomorfizmem, to przekształca każdą bazę przestrzeni \(V\) na bazę przestrzeni \(W\).

- Jeżeli \(f\) przekształca injektywnie pewną bazę przestrzeni \(V\) na bazę przestrzeni \(W\), to \(f\) jest izomorfizmem.

Dowód

Rozważmy implikację 1.

Niech \(B\) będzie zbiorem liniowo niezależnym w \(V\). Niech \(w_1,...,w_n\) będą różnymi między sobą wektorami z \(f(B)\) takimi, że \(\lambda _1 w_1+...+\lambda _nw_n =0\). Istnieją \(v_1,...,v_n\in B\) (różne między sobą, bo \(f\) jest injekcją) takie, że \(w_1=f(v_1),...,w_n=f(v_n)\). Mamy równości: \(f(\lambda _1 v_1+...+\lambda _nv_n) =\lambda _1 f(v_1)+...+\lambda _nf(v_n)=0\). Ponieważ \(f\) jest monomorfizmem, więc \(\lambda _1 v_1+...+\lambda _nv_n =0\). Wobec tego, ponieważ \(v_1,...,v_n\) są liniowo niezależne, wszystkie \(\lambda _i\), dla \(i=1,...,n\), są równe zeru.

Dla dowodu drugiej implikacji, załóżmy, że \(B\) jest bazą przestrzeni \(V\), przekształconą injektywnie na zbiór liniowo niezależny. Niech \(f(v)=0\). Istnieją skalary \(\lambda _1,...,\lambda _n\in \mathbb K\) oraz wektory \(v_1,...,v_n\in B\) takie, że \(v=\lambda _1v_1+...+\lambda _nv_n\). Mamy więc równość: \(0=\lambda _1f(v_1)+...+\lambda _n(v_n)\). Ponieważ \(f\) jest injekcją na bazie, więc wektory \(f(v_1),...,f(v_n)\) są różne między sobą. A zatem \(f(v_1),...,f(v_n)\) jest skończonym podzbiorem \(f(B)\). Jest liniowo niezależny, a więc wszystkie skalary \(\lambda _1\),...,\(\lambda _n\) są równe \(0\) i, w konsekwencji, \(v=0\).

Dowód pozostałych implikacji zostawiamy czytelnikowi.

Założenie w implikacji 2. w przypadku przestrzeni skończenie wymiarowych można sformułować tak:

Dla pewnej bazy \(e_1,...,e_n\) przestrzeni \(V\) układ \(f(e_1),...,f(e_n)\) jest liniowo niezależny.

Podobnie formułuje się założenie w implikacji 6.

Z powyższego twierdzenia, a także z dobrze już znanych faktów, że w skończenie wymiarowej przestrzeni każdy układ liniowo niezależny można uzupełnić do bazy i z każdego układu generatorów można wybrać bazę, dostajemy natychmiast

Wniosek 3.4

Niech \(V,W\) będą przestrzeniami skończenie wymiarowymi tego samego wymiaru. Niech \(f:V\longrightarrow W\) będzie odwzorowaniem liniowym. Następujące warunki są równoważne

- f jest monomorfizmem.

- f jest epimorfizmem.

- f jest izomorfizmem.

Z twierdzenia (3.3) wynika także

Wniosek 3.5

Jeżeli \(f:V\longrightarrow W\) jest izomorfizmem liniowym i przestrzeń \(V\) jest skończenie wymiarowa, to \(W\) jest też skończenie wymiarowa oraz \(\dim V=\dim W\).

Rząd odwzorowania liniowego

Kolejne twierdzenie opisuje ważny związek między wymiarami jądra i obrazu danego odwzorowania liniowego.

Twierdzenie 4.1

Niech \(f:V\longrightarrow W\) będzie odwzorowaniem liniowym. Jeżeli \(V\) jest skończenie wymiarowa, to

Dowód

Jeżeli \(\ker f=V\) lub \(\ker f=\{0\}\), twierdzenie jest trywialne. Załóżmy, że \(\ker f\ne V\) i \(\ker f\ne\{0\}\). Niech \(e_1,..., e_k\) będzie bazą \(\ker f\). Rozszerzmy tę bazę do bazy całej przestrzeni \(V\). Niech \(e_1,...,e_k,e_{k+1},..., e_{n}\) będzie bazą rozszerzoną. Twierdzimy, że wektory \(f(e_{k+1}),..., f(e_{n})\) stanowią bazę przestrzeni \( im f\).

Sprawdźmy najpierw, że wektory te generują przestrzeń \( im f\). Jeśli \(w\in im f\), to istnieje \(v\in V\) taki, że \(f(v)=w\). Wektor \(v\) da się przedstawić jako kombinacja liniowa wektorów bazy \(e_1,..., e_n\), tzn. \(v=\lambda _1e_1 +...+\lambda _ne_n\). Zatem

Aby sprawdzić liniową niezależność tych wektorów, załóżmy, że

dla pewnych skalarów \(\lambda _{k+1},...\lambda _n\). Wtedy \(f(\lambda _{k+1}e_{k+1}+...+ \lambda _{n}e_{n})=0\), czyli \(\lambda _{k+1}e_{k+1}+...+ \lambda _{n}e_{n} \in \ker f\). Wobec tego istnieją skalary \(\lambda _1,...,\lambda _k\) takie, że

Ponieważ układ wektorów \(e_1,...,e_k, e_{k+1},..., e_n\) jest liniowo niezależny, wszystkie skalary w powyższej równości, w szczególności skalary \(\lambda _{k+1},..., \lambda _n\), są równe \(0\).

Z Twierdzenia 2.7 otrzymujemy natychmiast

Wniosek 4.2

Niech \(V\) i \(W\) będą skończenie wymiarowe. Dla odwzorowania liniowego \(f:V\longrightarrow W\) jego rząd spełnia nierówność

Przestrzeń dualna

Przypomnijmy sobie Przykład 7. z Wykładu 2. Wiemy z niego, że ogół odwzorowań prowadzących z niepustego zbioru \(V\) do przestrzeni wektorowej \(W\) jest przestrzenią wektorową z działaniami wprowadzonymi w Przykładzie 7. Przypomnijmy, że

dla \(f,h\in W^V\), \(v\in V\) i \(\lambda \in\mathbb K\). Niech \(V,W\) będą, jak w całym tym wykładzie, przestrzeniami wektorowymi nad jednym ciałem \(\mathbb K\) i \(f, h:V\longrightarrow W\) - odwzorowaniami liniowymi. Łatwo widać, że suma tych odwzorowań, a także iloczyn odwzorowania liniowego przez skalar są odwzorowaniami liniowymi. Zatem ogół odwzorowań liniowych z przestrzeni \(V\) do \(W\) stanowi podprzestrzeń wektorową przestrzeni \(W^V\).

Rozważmy sytuację szczególną. Za \(W\) weźmy ciało \(\mathbb K\). Przestrzeń odwzorowań liniowych prowadzących z \(V\) do \(\mathbb K\) oznaczmy przez \(V^*\). Przestrzeń tę nazywamy przestrzenią dualną do \(V\). A zatem

Załóżmy teraz, że przestrzeń \(V\) jest skończenie wymiarowa i ma wymiar \(n\). Niech \(e_1,..., e_n\) będzie bazą tej przestrzeni. Zdefiniujemy ciąg \(e^*_1,..., e^*_n\) elementów przestrzeni \(V^*\) następująco. Pamiętając o tym, że odwzorowanie liniowe możemy zadać na bazie, określamy

\(e^*_i(e_j)=\delta _{ij},\) (5.2)

gdzie \(\delta _{ij}\) jest tzw. deltą Kroneckera. Symbol ten zdefiniowany jest następująco: \(\delta _{ij}=0\) dla \(i\ne j\) oraz \(\delta _{ij}=1\) dla \(i=j\).

Udowodnimy teraz

Twierdzenie 5.1

Ciąg \(e^*_1,..., e^*_n\) jest bazą przestrzeni \(V^*\).

Dowód

Układ \(e^*_1,..., e^*_n\) jest liniowo niezależny. Istotnie, niech

\(\lambda _1e^*_1+...+\lambda _ne ^*_n=0.\) (5.3)

Zero występujące z prawej strony tej równości oznacza odwzorowanie tożsamościowo równe zeru. Oznaczmy przez \(\alpha\) odwzorowanie określone przez lewą stroną równości (5.3). Dla każdego \(v\in V\) mamy \(\alpha (v)=0\). W szczególności dla każdego wektora \(e_i\) bazy \(e_1,...,e_n\) mamy \(\alpha (e_i)=0\). Wstawiając do obu stron równości (5.3) kolejne wektory bazy \(e_1,..., e_n\) stwierdzamy, że \(\lambda _1\),..., \(\lambda _n\) są równe zeru.

Aby stwierdzić że \(e^*_1,..., e^*_n\) stanowię zbiór generatorów przestrzeni \(V^*\) wystarczy sprawdzić, że dla każdego \(\alpha \in V^*\) mamy

\(\alpha =\alpha (e_1)e^*_1+...+\alpha (e_n)e^*_n.\) (5.4)

Dla sprawdzenia tej równości, wystarczy porównać wartości

odwzorowań liniowych znajdujących się po obydwu jej stronach na

kolejnych wektorach bazy \(e_1,...,e_n\).

Formuła (5.4) jest sama w sobie ważna i bardzo pożyteczna.

Zauważmy jeszcze, że jeśli \(f:V\longrightarrow W\) jest liniowe, to

definiując odwzorowanie

otrzymujemy odwzorowanie liniowe. Sprawdzenie zostawiamy czytelnikowi. Odwzorowanie to nazywamy odwzorowaniem dualnym (lub transponowanym) do \(f\).

Korzystając bezpośrednio z definicji odwzorowania dualnego, łatwo sprawdzić następujący fakt

Twierdzenie 5.2

Niech \(f: V \longrightarrow W, h: W \longrightarrow Z\) będą odwzorowaniami liniowymi. Zachodzi równość odwzorowań

Macierze

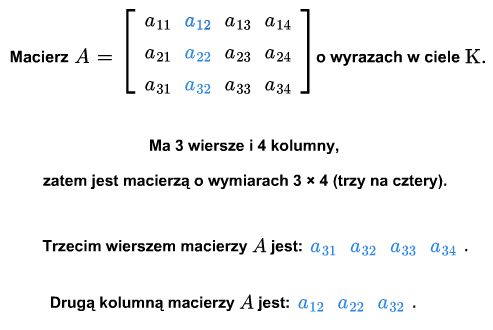

Definicja macierzy, podstawowe pojęcia

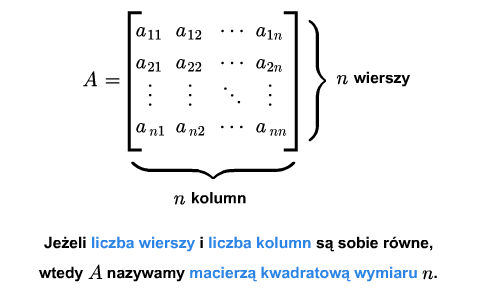

Niech ustalone będzie ciało \(\mathbb K\) i dwie liczby naturalne \(m\), \(n\).

Macierzą o wyrazach z ciała \(\mathbb K\) i wymiarach \(m\) na \(n\) nazywamy każdą funkcję

Macierz taką zapisujemy w postaci tabelki

\(A= \left [\begin{array} {crclc} \ a_{11} &\cdot&\cdot &\cdot & a_{1n}\\ \ \\ \ \cdot &\ \ \ \cdot&\cdot &\cdot \ \ \ & \cdot \\ \ \cdot &\ \ \ \cdot&\cdot &\cdot\ \ \ & \cdot \\ \ \cdot &\ \ \ \cdot&\cdot &\cdot \ \ \ & \cdot \\ \ \\ \ a_{m1}&\cdot&\cdot &\cdot & a_{mn} \end{array} \right ]\) (1.1)

Macierz zapisujemy również na wiele innych sposobów, w zależności od tego jaką jej cechę chcemy wziąć pod uwagę lub podkreślić. I tak, możemy zapisać macierz jako \(A_{m\times n}\) (określono wymiary macierzy), \([a_{ij}]\) (oznaczono wyrazy macierzy), \(A=A=[a_{ij}]_ {\tiny\begin{array} {l} 1\le i\le m\\ 1\le j\le n \end{array}}\), (nazwano wyrazy, określono wymiary) lub po prostu \(A\) (dokładniejsze informacje są niepotrzebne lub wynikają z kontekstu).

Ciąg \(a_{i1},..., a_{in}\), \(i=1,...,m\) nazywamy \(i\)-tym wierszem macierzy (1.1). Ciąg \(a_{1j},...,a{mj}\), \(j=1,...,n\), nazywamy \(j\)-tą kolumną macierzy (1.1).

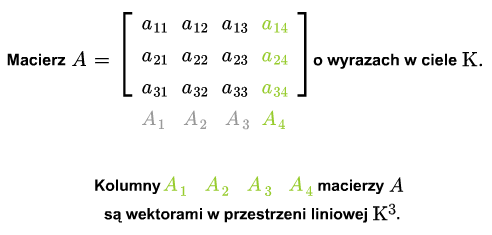

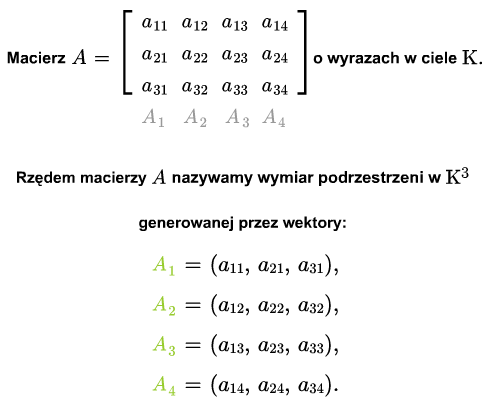

Niech \(A_1,...,A_n\) będą kolumnami macierzy \(A\). Jest to ciąg wektorów z \(\mathbb K ^m\). Rząd układu kolumn \(A_1,...,A_m\) nazywamy rzędem macierzy i oznaczamy \( rk A\).

Mamy następujący lemat przydatny w rachunku macierzy

Lemat 1.1

Niech dany będzie układ wektorów \(w_1,...,w_k\), \(k>1\), przestrzeni wektorowej \(V\). Wtedy \( rk \{w_1,...,w_k\}= rk \{ u_1, w_2,...,w_k\}\), gdzie \(u_1 =w_1 +\lambda _2w_2+...+\lambda_kw_k\) i \(\lambda _2,...,\lambda _k\) są dowolnymi skalarami.

Dowód

Pokażemy, że \( lin \{w_1,...,w_k\}= lin \{u_1,w_2,...,w_k \}\). Oczywiście prawa strona zawiera się w lewej. Ponieważ \(w_1=u_1-\lambda _2w_2-...-\lambda _k w_k\), więc lewa strona zawiera się w prawej.

Mówimy krótko, że rząd układu wektorów nie zmieni się, jeśli do któregoś z jego wektorów dodamy kombinacją liniową wektorów pozostałych.

A zatem rząd układu kolumn nie zmieni się, jeśli do którejś kolumny dodamy kombinację liniową pozostałych kolumn.

Oczywiście, jeśli spermutujemy kolumny, to, choć macierz najczęściej istotnie się zmieni, jej rząd się nie zmieni.

Jeśli którąkolwiek z kolumn macierzy \(A\) pomnożymy przez niezerowy skalar, to rząd macierzy nie zmieni się.

Wszystkie wymienione wyżej operacje na macierzy, tj. dodanie do danej kolumny kombinacji liniowej pozostałych kolumn, pomnożenie kolumny przez niezerowy skalar, permutowanie kolumn, nazywamy operacjami dopuszczalnymi (ze względu na rząd macierzy).

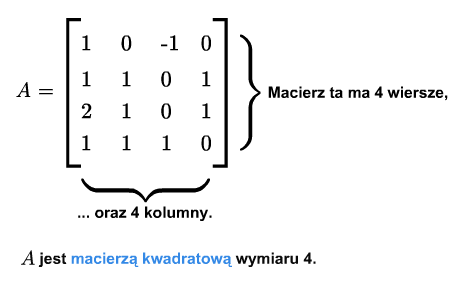

Macierz \(A_{m\times n}\) nazywamy kwadratową, jeśli \(m=n\).

W przeciwnym wypadku mówimy, że macierz jest prostokątna (dla podkreślenia, że nie jest kwadratowa). Dla macierzy kwadratowej podaje się jeden wymiar.

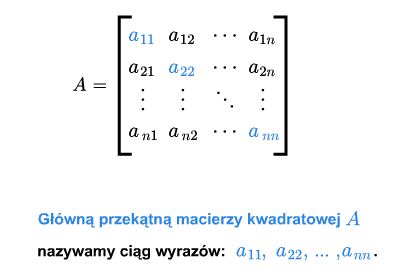

Dla macierzy kwadratowej \(A=[a_{ij}]_ {\tiny\begin{array} {l} 1\le i\le n\\ 1\le j\le n \end{array} }\) definiujemy główną przekątną jako ciąg \(a_{11},..., a_{nn}\).

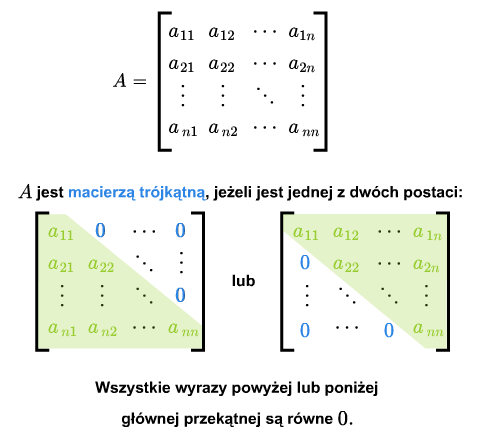

W macierzy kwadratowej można wyróżnić wyrazy leżące ponad przekątną i wyrazy leżące poniżej przekątnej. Macierz kwadratowa nazywa się macierzą trójkątną, jeśli wszystkie jej wyrazy leżące ponad główną przekątną lub wszystkie wyrazy leżące poniżej głównej przekątnej są zerami.

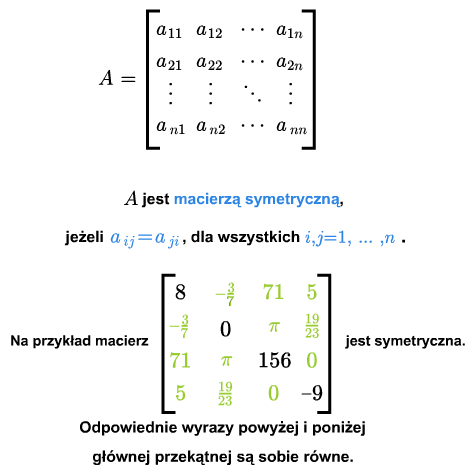

Macierz kwadratową \(A={[a_{ij}]}_{1\le i,j\le n}\) nazywa się symetryczną, jeśli \(a_{ij} =a_{ji}\) dla każdych \(i,j=1,...,n\).

Macierz \(A\) nazywa się antysymetryczną (lub skośnie symetryczną), jeśli \(a_{ij}=-a_{ji}\) dla każdych \(i,j=1,...,n\). W macierzy skośnie symetrycznej wszystkie wyrazy leżące na głównej przekątnej są równe zeru.

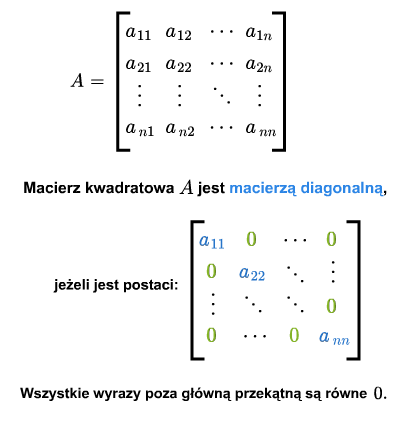

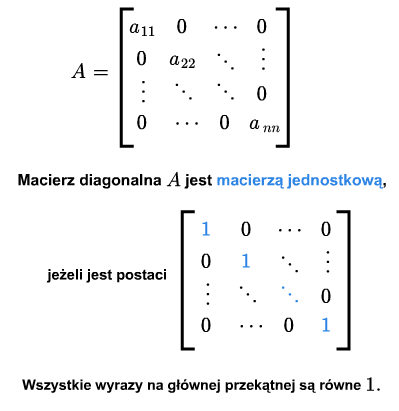

Macierz kwadratowa nazywa się diagonalną, jeśli wszystkie jej wyrazy poza główną przekątną są zerami.

Macierz kwadratowa nazywa się jednostkową, jeśli jest diagonalna a na jej głównej przekątnej są same jedynki. Macierz tę oznaczać będziemy przez \(I\) lub \(I_{n\times n}\).

Oznaczyliśmy już(w Wykładzie 3.) przez \(I\) odwzorowanie identycznościowe danej przestrzeni wektorowej. Okaże się wnet, że nie ma tu wielkiej kolizji oznaczeń.

Operacje na macierzach

Zbiór wszystkich macierzy o wymiarach \(m\) na \(n\) i wyrazach z \(\mathbb K\) oznaczmy przez \(M(m,n;\mathbb K)\). Zbiór ten jest podprzestrzenią przestrzeni \(\mathbb K ^X\), gdzie \(X=\{1,..., m\}\times \{1,...,n\}\) (porównaj Przykład 7. Wykładu 2.)

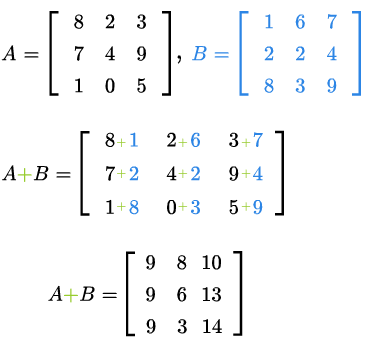

W szczególności, działania w \(M(m,n;\mathbb K)\) są określone następująco. Niech

Sumą macierzy \(A\) i \(B\) jest macierz następująca

Jeśli \(\lambda\in\mathbb K\), to macierz \(\lambda A\) jest

zdefiniowana tak

Z Przykładu 7. Wykładu 2. wiemy, że dodawanie w \(M(m,n;\mathbb K)\) jest łączne, przemienne, ma element neutralny (który jest macierzą składająca się z samych zer) i każda macierz ma macierz przeciwną. Macierzą przeciwną do macierzy (1.1) jest macierz

Ustalimy teraz jaki jest wymiar przestrzeni \(M(m,n;\mathbb K)\). Rozważmy odwzorowanie

Z grubsza mówiąc, odwzorowanie to polega na przepisaniu kolejnych wierszy jeden po drugim w jednym ciągu. Oczywiście odwzorowanie to jest bijekcją.

Ponadto, łatwo widać, że odwzorowanie to jest liniowe. Zatem odwzorowanie to jest izomorfizmem. Mamy więc

Wniosek 2.1

Zachodzi równość \(\dim M(m,n;\mathbb K)=mn\).

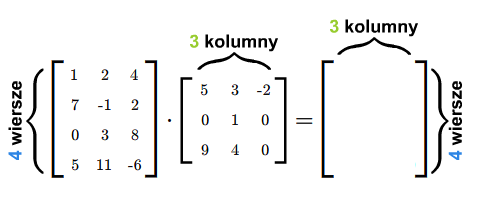

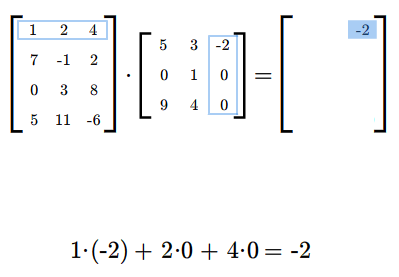

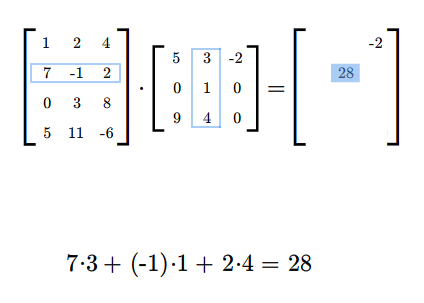

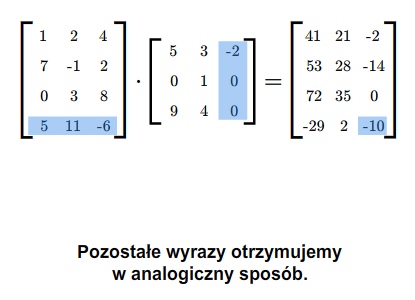

Załóżmy teraz, że mamy dwie macierze: \(A=A_{m\times k}\) i \(B=B_{k\times n}\). Możemy zdefiniować iloczyn tych macierzy \(A B\) według następującego przepisu. Jeżeli \(\displaystyle A= [a_{il}]_ {\tiny\begin{array} {l} 1\le i\le m\\ 1\le l\le k \end{array} }\) i \(\displaystyle B=[b_{lj}]_ {\tiny\begin{array} {l} 1\le l\le k\\ 1\le j\le n \end{array} }\), to \(AB\) jest macierzą \(C=[c_{ij}]\) o wymiarach \(m\) na \(n\), której wyrazy określone są formułą

dla wszystkich wskaźników \(i,j\), gdzie \(i=1,...,m\) oraz \(j=1,..., n\).

Podkreślmy mocno, że możemy wykonać mnożenie \(AB\) tylko takich macierzy \(A\), \(B\), dla których liczba kolumn macierzy \(A\) jest równa liczbie wierszy macierzy \(B\). W rezultacie mnożenia otrzymujemy macierz, która ma tyle wierszy co macierz \(A\) i tyle kolumn co macierz \(B\).

Mnożąc macierze najpierw sprawdzamy, czy możemy je pomnożyć, następnie ustalamy wymiary iloczynu macierzy. Potem wyliczamy wyrazy iloczynu (w dowolnej kolejności), być może tylko te, które chcemy znać.

Mnożenie macierzy jest łączne, tzn. jeśli \(A,B,C\) są takie, że można wykonać mnożenia \(AB\) i \(C(AB)\), to można też wykonać mnożenia \(CA\) i \((CA)B\) oraz \(C(AB)=(CA)B\). Można tę własność bezpośrednio przerachować. W następnym wykładzie pokażemy, że łączność ta jest konsekwencją łączności składania odwzorowań.

Zachodzi też następująca własność rozdzielności mnożenia macierzy względem dodawania macierzy. Jeśli \(A, B\in M(k,n;\mathbb K)\) i \(C\in M(m,k;\mathbb K)\), to \(C(A+B)=CA+CB\). Podobnie można sformułować prawo rozdzielności \((A+B)C\). Objaśnimy tę własność w następnym wykładzie. Można też te własności bezpośrednio sprawdzić.

Nietrudno sprawdzić, że jeśli \(A=A_{m\times n}\) oraz \(I=I_ n\times n}\), to \(AI=A\). Podobnie, jeśli \(A=A_{m\times n}\) oraz \(I=I_{m\times m}\), to \(IA=A\).

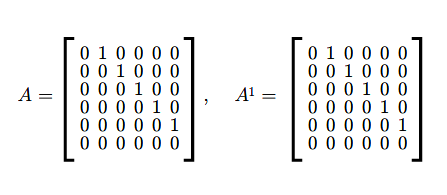

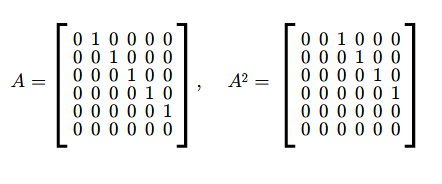

Przez \(n\)-tą potęgę \(A^n\) macierzy kwadratowej \(A\) rozumiemy iloczyn \(n\) egzemplarzy macierzy \(A\).

Przykład 2.2

Dowolna potęga macierzy diagonalnej jest macierzą diagonalną. Jeśli

to

Przykład 2.3

Niech

Indukcyjnie można udowodnić, że

gdzie

Przykład 2.4

Jeśli

to stosując indukcję można stwierdzić, że

gdzie \(\{a_m\}\) jest ciągiem Fibonacciego, czyli ciągiem zdefiniowanym wzorem rekurencyjnym

Przykład 2.5

Niech \(A\in M(n,n;\mathbb K)\)

\(A=\left [\begin{array} {lcccccr} \ 0 &1& & & & 0\\ \ 0& 0& 1& & & 0\\ \ .&. & .& .& .& .\\ \ 0 & & & 0 & 1 & 0\\ \ 0 & & & & 0 & 1\\ \ 0 & & & & &0 \end{array} \right ]\) (2.2)

Łatwo sprawdzić, że \(A^{n}=0\).

Jeżeli dany jest wielomian \(W(t)=a_0 +a_1t+....+a_r t^r\) jednej zmiennej \(t\) o współczynnikach z ciała \(\mathbb K\) i \(A\) jest macierzą kwadratową, to przez \(W(A)\) rozumiemy macierz

gdzie \(I\) jest macierzą jednostkową takiego samego wymiaru co macierz \(A\). Każdy wielomian \(W(t)\), dla którego \(W(A)=0\), nazywa się anihilatorem macierzy \(A\).

Ogólna grupa liniowa

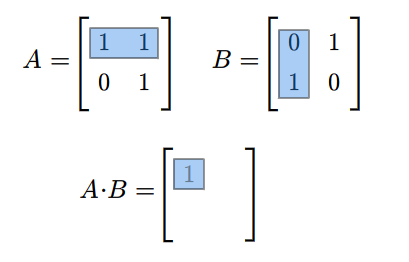

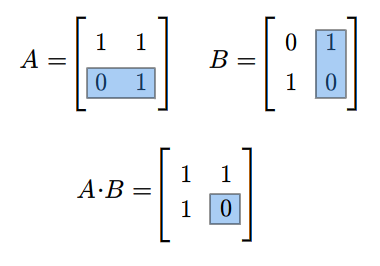

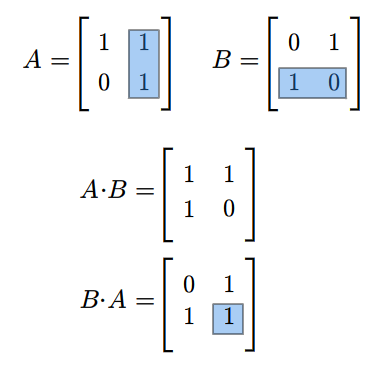

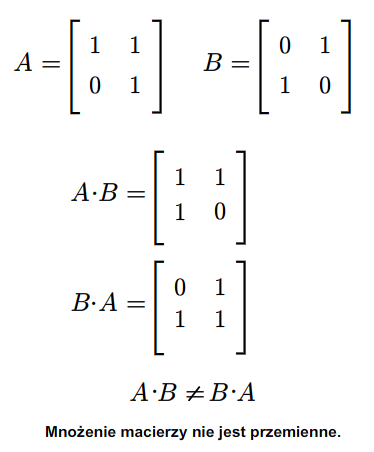

Rozważmy teraz przestrzeń macierzy kwadratowych \(M(n,n;\mathbb K)\). Każde dwie macierze \(A,B\in M(n,n;\mathbb K)\) można pomnożyć w obydwu kolejnościach, tzn. można znaleźć zarówno iloczyn \(AB\) jak i \(BA\). Na ogół macierze \(AB\) i \(BA\) są różne. Na przykład weźmy następujące macierze (istniejące dla każdego ciała \(\mathbb K\))

Mamy

Macierz kwadratową \(A\in M(n,n:\mathbb K)\) nazywamy odwracalną, jeśli istnieje macierz \(B\in M(n,n;\mathbb K)\) taka, że

\(AB=BA=I.\) (3.3)

Macierz \(B\) spełniająca (3.3) jest jedyna.

Przypuśćmy, że \(AB'=B'A=I\). Pomnóżmy równość \(AB=I\) obustronnie z lewej strony przez \(B'\). Mamy następujące równości \(B'(AB)=B'\). Korzystając z łączności mnożenia macierzy otrzymujemy

\(B'=(B'A)B=IB=B\). A zatem \(B=B'\). Mogliśmy również skorzystać z pierwszego wykładu, z fragmentu poprzedzającego definicję grupy.

Macierz \(B\) spełniającą warunek (3.3) nazywamy macierzą odwrotną do \(A\). Oznaczamy tę macierz przez \(A^{-1}\).

Zbiór macierzy \(A\in M(n,n;\mathbb K)\) odwracalnych stanowi grupę. Grupa ta, poza przypadkiem \(n=1\), jest nieprzemienna. Grupę tę oznaczamy \(GL(n;\mathbb K)\) i nazywamy ogólną grupą liniową nad ciałem \(\mathbb K\).

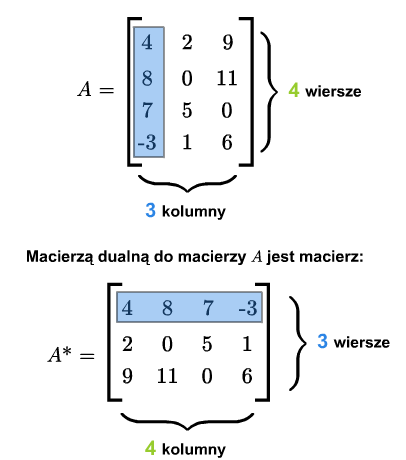

Niech będzie daną macierzą. Macierzą dualną (lub transponowaną) do macierzy \(A=[a_{ij}]_ {\tiny\begin{array} {l} 1\le i\le m\\ 1\le j\le n \end{array} }\) nazywamy macierz \(A^*= [a_{ji}]_ {\tiny\begin{array} {l} 1\le j\le n\\ 1\le i\le m \end{array} }\). A zatem macierz \(A^*\) powstaje z macierzy \(A\) przez zamianę wierszy na kolumny.

Macierz dualna do macierzy \(A^*\) jest macierzą \(A\), czyli \((A^*)^*=A\). Macierz kwadratowa \(A\) jest symetryczna wtedy i tylko wtedy, gdy \(A^*=A\). Macierz kwadratowa \(A\) jest skośnie symetryczna wtedy i tylko wtedy, gdy \(A^*=-A\).

Macierze a odwzorowania liniowe

W niniejszym wykładzie wszystkie rozważane przestrzenie są skończenie wymiarowe a bazy są uporządkowane.

Macierz odwzorowania liniowego

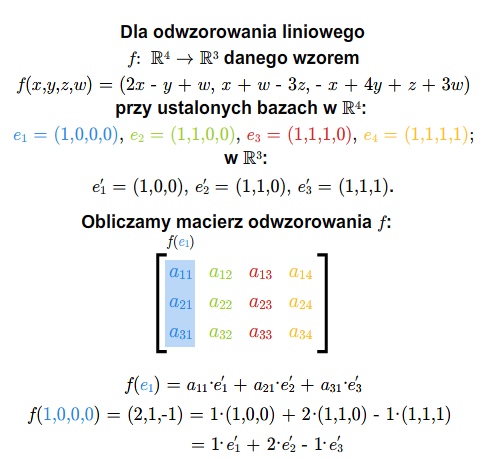

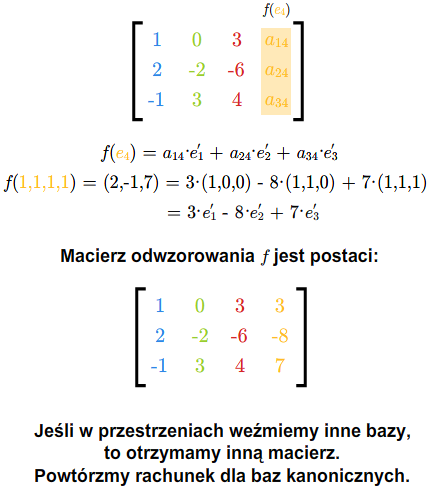

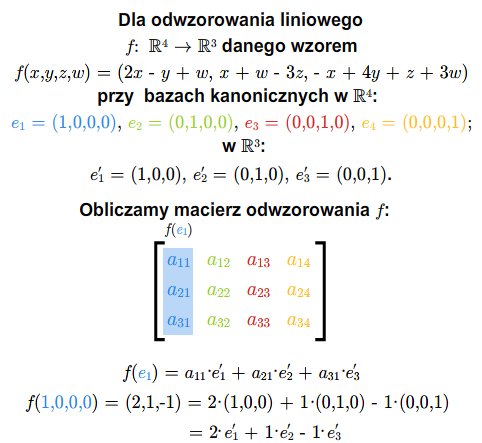

Niech dane będą przestrzenie wektorowe \(V\) i \(W\) nad ciałem \(\mathbb K\) oraz odwzorowanie liniowe \(f:V\longrightarrow W\).

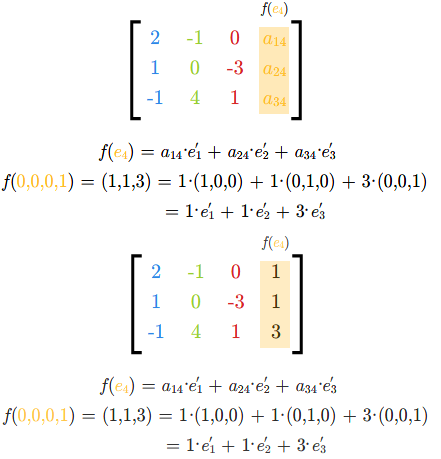

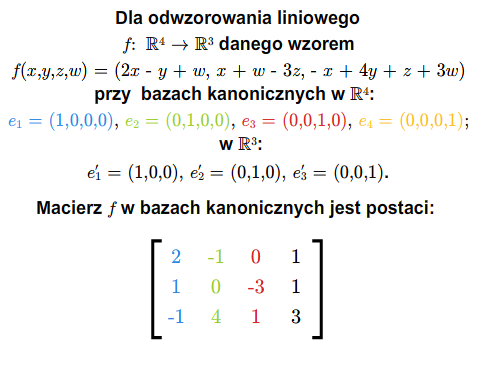

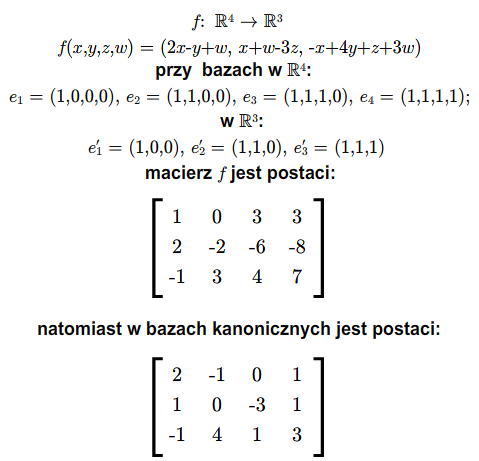

Niech \(e_1,...,e_n\) będzie bazą przestrzeni wektorowej \(V\), zaś \(e'_1,...,e'_m\) bazą przestrzeni \(W\). Dla odwzorowania liniowego \(f\) mamy

\(\begin{array} {rcl} &&f(e_1) =a_{11}e'_1+... +a_{m1}e'_m,\\ &&\ \ \ .\\ &&\ \ \ .\\ &&\ \ \ .\\ &&f(e_n)= a_{1n}e'_1+...+a_{mn}e'_m. \end{array}\) (1.1)

dla pewnych skalarów \(a_{ij}\), \(i=1,...,m\), \(j=1,...,n\). Inaczej zapisując

dla każdego \(j=1,...,n\).

Otrzymaliśmy więc macierz \(A=[a_{ij}]_ {\tiny\begin{array} {l} 1\le i\le m\\ 1\le j\le n \end{array} }\), która całkowicie opisuje odwzorowanie liniowe \(f\). Istotnie, jeśli znamy wartości odwzorowania liniowego na bazie, to znamy to odwzorowanie. Macierz tę nazywamy macierzą odwzorowania \(f\) przy bazach \(e_1,...,e_n\) i \(e'_1,...,e'_m\).

Jeśli mamy daną macierz \(A\), ustalone bazy w przestrzeniach \(V\), \(W\), to macierz ta jest macierzą odwzorowania liniowego \(f:V\longrightarrow W\). Odwzorowanie to jest dane formułą (1.1).

Wygodnie jest myśleć o macierzach jako o odwzorowaniach liniowych. Jeśli żadne szczególne przestrzenie nie są wyróżnione, to macierz \(A=A_{m\times n}\) możemy traktować jako odwzorowanie liniowe \(f:\mathbb K ^n\longrightarrow \mathbb K^m\) dane przepisem (1.1), gdzie \(e_1,...,e_n\) jest bazą kanoniczną przestrzeni \(\mathbb K ^n\), zaś \(e'_1,...,e'_m\) jest bazą kanoniczną przestrzeni \(\mathbb K ^m\).

Jeśli \(A\) jest macierzą odwzorowania \(f:V\longrightarrow W\) i przez \(A_1,..., A_n\) oznaczymy kolumny macierzy \(A\), to każda kolumna \(A_j\) jest ciągiem współrzędnych wektora \(f(e_j)\) w bazie \(e'_1,..., e'_m\). Oznacza to, że układ kolumn macierzy \(A\) można uważać za wektory (wyrażone we współrzędnych w bazie \(e_1,...,e_n\)) \(f(e_1),...,f(e_n)\). Rząd odwzorowania \(f\) jest więc rzędem układu wektorów \(A_1,..., A_n\) macierzy \(A\).

Mamy więc

Twierdzenie 1.1

Jeśli \(A\) jest macierzą odwzorowania \(f:V\longrightarrow W\) przy pewnych bazach przestrzeni \(V\) i \(W\), to \( rk A= rk f\).

Niech \(f,h :V\longrightarrow W\) będą dwoma odwzorowaniami liniowymi. Wiemy, że suma tych odwzorowań jest odwzorowaniem liniowym. Przy danych bazach \(e_1,...,e_n\), \(e'_1,...,e'_m\) przestrzeni \(V\) i \(W\) odpowiednio, macierz odwzorowania \(f+h\) jest sumą macierzy \(A_f+A_h\), gdzie \(A_f\) jest macierzą odwzorowania \(f\) a \(A_h\) macierzą odwzorowania \(h\). A zatem dodawanie macierzy odpowiada dodawaniu odwzorowań liniowych. Podobnie mnożeniu macierzy przez skalar odpowiada mnożenie odwzorowania liniowego przez skalar.

Załóżmy teraz, że mamy trzy przestrzenie wektorowe \(V\), \(W\), \(U\). Załóżmy ponadto, że \(e_1,...,e_n\) jest bazą \(V\), \(e'_1,...,e'_k\) jest bazą \(W\) i \(e''_1,...,e''_m\) jest bazą \(U\). Niech \(f:V\longrightarrow W\) i \(h:W\longrightarrow U\) będą odwzorowaniami liniowymi. Oznaczmy przez

macierze odwzorowania \(f\), \(h\) i \(h\circ f\) odpowiednio, przy danych bazach. Zachodzą następujące równości

Z drugiej strony

Zatem

Oznacza to, że

Krótko mówiąc, mnożenie macierzy odpowiada składaniu odwzorowań liniowych. Ponieważ składanie odwzorowań jest łączne, więc mnożenie macierzy jest łączne. Wspomnieliśmy już tę własność w poprzednim wykładzie. Teraz uzasadniliśmy jej prawdziwość.

Zauważmy także, że jeśli \(h_1, h_2: W\longrightarrow U\), to \((h_1+h_2)\circ f= h_1\circ f +h_2\circ f\). Jeśli \(f_1, f_2:V\longrightarrow W\), to \(h\circ (f_1+f_2)=h\circ f_1 +h\circ f_2\). W języku macierzy oznacza to, że \((B_1 +B_2)A=B_1A+B_2A\) oraz \(B(A_1+A_2)=BA_1+BA_2\) (jeśli występujące tu dodawania i mnożenia macierzy można wykonać). Te własności rachunku macierzy również wymieniliśmy w poprzednim wykładzie.

Macierz dualna i odwzorowanie dualne

Niech \(e^*_1,..., e^*_n\) będzie bazą dualną do bazy \(e_1,...,e_n\) przestrzeni \(V\) i \(e'^*_1,...,e'^*_m\) bazą dualną do bazy \(e'_1,...,e'_m\) przestrzeni \(W\). Rozważmy odwzorowanie dualne \(f^*:W^* \longrightarrow V^*\). Chcemy znaleźć macierz \(f^*\) przy wyróżnionych właśnie bazach dualnych. Oznaczmy poszukiwaną macierz przez \(B=[b_{ji}]_ {\tiny\begin{array} {l} 1\le j\le n\\ 1\le i\le m \end{array} }\), czyli

Po obydwu stronach powyższej równości mamy wektory z \(V^*\), czyli odwzorowania liniowe określone na \(V\) i o wartościach w \(\mathbb K\). Obliczymy wartość tych odwzorowań na wektorach bazy \(e_1,..., e_n\). Otrzymujemy

Z drugiej strony

A zatem \(a_{is}=b_{si}\), co oznacza, że macierz \(B\) jest macierzą dualna do macierzy \(A\).

Macierz odwzorowania dualnego jest macierzą dualną do macierzy odwzorowania danego, jeśli w przestrzeniach dualnych wybierzemy bazy dualne.

Stąd, że dla odwzorowań liniowych zachodzi formuła \((f \circ h)^* = h^* \circ f^*\), otrzymujemy analogiczną formułą dla macierzy.

Twierdzenie 2.1

Jeśli iloczyn \(AB\) jest wykonalny, to wykonalny jest iloczyn \(B^* A^*\) oraz

Udowodnimy teraz następujące twierdzenie

Twierdzenie 2.2

Rząd odwzorowania dualnego do \(f\) jest równy rzędowi odwzorowania \(f\).

Dowód

Wiemy, że

\( rk f^*=\dim W^*-\dim ker f^*=\dim W-\dim\ker f^*.\) (2.2)

Przyjrzyjmy się więc przestrzeni \(\ker f^*\). Mamy

Weźmy bazę \(w_1,...,w_k\) przestrzeni \( im f\). Jeśli \( im f= W\), to \( rk f=\dim W\) i \(\ker f^*= \{0\}\). Twierdzenie w tym przypadku jest prawdziwe..

Jeśli \( im f\ne W\), to układ \(w_1,...,w_k\) rozszerzmy do bazy

przestrzeni \(W\). Przestrzeń \(U\) rozpięta na wektorach \(w_{k+1},...,w_m\) jest dopełnienieniem algebraicznym do \( im f\) w \(W\), czyli \(W=U\oplus im f\). Zauważmy,

że odwzorowanie

jest izomorfizmem. Oczywiście odwzorowanie \(\phi\) jest liniowe. Jeśli \(\phi(\beta)=0\), to \(\beta_{|U}\) i \(\beta _{| im f}\) są odwzorowaniami zerowymi. A zatem, \(\beta\) jest odwzorowaniem zerowym na całym \(W\). Odwzorowanie \(\phi\) jest więc monomorfizmem.

Jest też epimorfizmem. Jeśli bowiem \(\gamma :U\longrightarrow \mathbb K\) jest liniowe, to odwzorowanie liniowe \(\beta: W\longrightarrow \mathbb K\) zdefiniowane na bazie przestrzeni \(W\) następująco: \(\beta (w_i)=0\) dla \(i=1,...,k\),\(\beta (w_i)=\gamma (w _i)\) dla \(i=k+1,..., m\), jest takie, że \(\phi (\beta)=\gamma\).

Ponieważ \(\phi\) jest izomorfizmem, więc \(\dim\ker f^* = \dim U ^* =\dim U =m-k =\dim W- rk f\). Porównując tę równość z równością z pierwszego zdania tego dowodu otrzymujemy żądaną tezę.

Z powyższego twierdzenia i stąd, że macierz odwzorowania dualnego jest macierzą dualną do macierzy odwzorowania danego wynika następujący wniosek

Wniosek 2.3

Dla dowolnej macierzy \(A\) zachodzi równość \( rk A= rk A^*\).