Języki automaty i obliczenia

Forma zajęćWykład (30 godzin) + ćwiczenia (30 godzin)

Opis

Teoria jezyków formalnych, automatów i gramatyk w zakresie hierarchii Chomsky'ego.

Sylabus

Autorzy

- Maria Foryś — Uniwersytet Jagielloński

- Wit Foryś — Uniwersytet Jagielloński

- Adam Roman — Uniwersytet Jagielloński

Wymagania wstępne

- Logika i teoria mnogości

- Algebra liniowa z geometrią analityczną

- Matematyka dyskretna

- Algorytmy i struktury danych

Zawartość

- Alfabet, słowo, język - elementy teorii półgrup; półgrupy i monoidy wolne

- Gramatyki – model obliczeń; hierarchia Chomsky'ego

- Języki regularne; automat skończenie stanowy; automat minimalny i algorytmy; automaty deterministyczne i niedeterministyczne; algorytm determinizacji; własności języków regularnych; lemat o pompowaniu i języki nieregularne; wyrażenia regularne i algorytmy; twierdzenie Kleenego; problemy rozstrzygalności

- Języki bezkontekstowe; własności języków bezkontekstowych, gramatyka - postać Chomsky'ego i Greibach oraz algorytmy upraszczania; automat ze stosem; równoważność gramatyki bezkontekstowej i automatu ze stosem - algorytmy; lemat o pompowaniu i języki, które nie są bezkontekstowe; jednoznaczność, problem przynależności i algorytm CYK; problemy rozstrzygalności

- Języki kontekstowe i typu (0); własności; automat liniowo ograniczony; maszyna Turinga i jej wersje

- Podstawowe klasy złożoności w języku maszyn Turinga

- Języki maszyn Turinga i języki typu (0); teza Churcha; problemy rozstrzygalności

Literatura

- M. Foryś, W. Foryś, Teoria automatów i języków formalnych, AOW EXIT, Warszawa 2005.

- J. Gruska, Foundations of computing, Thompson, 1997.

- J.E. Hopcroft, J.D. Ulman, Introduction to automata theory, languages and computing, Addison-Wesley, 1979.

- A. Salomaa, Computation and automata, Cambridge Univ.Press, 1985.

- M. Sipser, Introduction to the theory of computation, PWS Publishing Company, Boston 1997.

Słowa, katenacja - elementy teorii półgrup, półgrupy i monoidy wolne

Definicje, oznaczenia i podstawowe własności

Przyjmijmy, że \(\mathbb{N}=\left\{ 1,2,\ldots \right\}\) oznacza zbiór liczb naturalnych, a \(\mathbb{N}_{0}\) zbiór liczb naturalnych wraz z 0. Przypomnimy teraz podstawowe wiadomości z wykładu Algebra Liniowa dotyczące struktur algebraicznych, a dokładniej struktur najprostszych, półgrup i monoidów, posiadających jedno tylko działanie.

Definicja 1.1

Zbiór \(S\), w którym określone jest działanie łączne, to znaczy spełniające warunek

nazywamy półgrupą.

Przykład 1.1

Zbiór liczb naturalnych z dodawaniem \((\mathbb{N},+)\) tworzy półgrupę.

Definicja 1.2

Półgrupę \(M\), w której istnieje element neutralny działania, to znaczy element \(1_{M}\in M\) spełniający warunek

nazywamy monoidem.

Przykład 1.2

- (1) Zbiór liczb naturalnych z mnożeniem \((\mathbb{N},\cdot ,1)\) jest monoidem.

- (2) Zbiór liczb naturalnych z zerem \((\mathbb{N}_{0},+,0)\) jest monoidem ze względu na dodawanie.

- (3) Monoidem jest \((A^A,\circ,id_A)\) - zbiór odwzorowań dowolnego zbioru \({A}\) w siebie ze składaniem jako działaniem i identycznością jako elementem neutralnym.

Dwa pierwsze monoidy są przemienne, czyli działanie jest przemienne, a trzeci jest nieprzemienny.

Każdy monoid jest półgrupą.

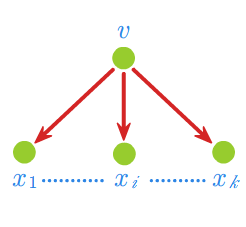

Dla uproszczenia notacji będziemy opuszczać kropkę "\(\cdot\)" oznaczającą działanie oraz używać nazwy "jedynka" na element neutralny. Jeśli nie będzie zaznaczone inaczej, to \((\mathbf{S},\cdot )\) będzie oznaczać półgrupę, a \((\mathbf{M},\cdot ,\, 1_{\mathbf{M}})\) monoid. Ze względu na łączność działania zarówno w półgrupie, jak i w monoidzie iloczyn \(x_1...x_n,\) a także \(x^n=x...x\) (n razy) jest określony jednoznacznie bez potrzeby wprowadzania nawiasów. Dla dowolnych liczb naturalnych \(m,n\in \mathbb{N}\) zachodzą wzory

Dla dowolnego \(x \in M\) przyjmujemy z definicji

Strukturę monoidu \(M\) przenosimy na zbiór potęgowy \(\mathcal{P}(M)\) wszystkich podzbiorów monoidu \(M\), określając dla dowolnych \(A,B \in\mathcal{P}(M)\) działanie

\((\mathcal{P}(M),\cdot, \{1_{M}\})\) jest monoidem.

Podobnie przenosimy strukturę półgrupy z \(S\) na \(\mathcal{P}(S)\).

Dla dowolnego podzbioru monoidu

(półgrupy) i dla dowolnej liczby \(n \in \mathbb{N}\) zapis \(A^n\) oznacza n-krotny iloczyn

zbioru \({A}\) przez siebie rozumiany w powyższym sensie.

W szczególności \(A^{1}=A.\)

W przypadku monoidu przyjmujemy z definicji

Definicja 1.3

Homomorfizmem półgrup \((S,\cdot)\;,\;\;(S',*)\) nazywamy odwzorowanie

\(h~:S~\longmapsto~S'\) takie, że

Homomorfizmem monoidów \((M,\cdot,1_{M}),\;(M',*,1_{M'})\) nazywamy odwzorowanie \(h:M \longmapsto M'\)

takie, że

Przykład 1.3

Odwzorowanie \(h:{\mathbb{Z}}_{mod\, 3}\longrightarrow {\mathbb{Z}}_{mod\,6}\) takie, że

jest homomorfizmem półgrupy \((\mathbb{Z}_{mod\,3},\cdot )\) w półgrupę \((\mathbb{Z}_{mod\,6},\cdot )\), ale nie jest homomorfizmem monoidu \((\mathbb{Z}_{mod\,3},\cdot,1 )\) w monoid \((\mathbb{Z}_{mod\,6},\cdot,1 )\), bo wartością 1 z monoidu \((\mathbb{Z}_{mod\,3},\cdot, 1 )\) nie jest jedynka monoidu \((\mathbb{Z}_{mod\,6},\cdot,1 )\).

Definicja 1.4.

Niech \((S,\cdot),\;\;(M,\cdot,1_{M})\) będą odpowiednio dowolną półgrupą, monoidem.

- \((T,\cdot)\) nazywamy podpółgrupą \({S}\) wtedy i tylko wtedy, gdy \(T\subset S\) i \(T^2 \subset T.\)

- \((N,\cdot,1_{M})\) nazywamy podmonoidem \(M\) wtedy i tylko wtedy, gdy \(N\) jest podpółgrupą \(M\) i \(1_{M} \in N.\)

Przykład 1.4.

\((\mathbb{Z}_{mod\,6},\cdot )\) jest monoidem. Podzbiór \(\{2,4\}\), jako zamknięty na działanie \(\cdot _{mod\, 6}\), tworzy podpółgrupę \(\mathbb{Z}_{mod\, 6}\). \((\{2,4\},\cdot _{mod\, 6})\) jest monoidem z \(4\) jako elementem neutralnym, ale nie podmonoidem \(\mathbb{Z}_{mod\, 6}\).

Niech \(X\) będzie dowolnym podzbiorem monoidu \(M\). Zbiór

jest podmonoidem monoidu \(M\).

Jest to najmniejszy, w sensie inkluzji podmonoid monoidu \(M\) zawierający zbiór \(X\).

Gdy spełniona jest równość \(X^*={M}\), to mówimy, że \(X\) jest zbiorem generatorów monoidu \(M\).

Zachodzą następujące własności:

- 1. Zbiór generatorów nie jest wyznaczony jednoznacznie.

- 2. Dla dowolnego monoidu istnieje zbiór generatorów, jest nim w szczególności zbiór \({M}\).

Podobnie dla dowolnego podzbioru \(X\) półgrupy \({S}\) zbiór

jest podpółgrupą \({S}\) i to najmniejszą w sensie inkluzji zawierającą zbiór \(X\).

Powyższe uwagi dotyczące zbioru generatorów monoidów przenoszą się odpowiednio dla półgrup.

Przykład 1.5.

W monoidzie \((\mathbb{N}_{0},+,0)\) podmonoid generowany przez zbiór generatorów \(X=\{2\}\) składa się z liczb parzystych i nieujemnych.

Definicja 1.5

Niech \(S\) będzie półgrupą. Relację równoważności \(\rho \subset {S}^2\) nazywamy:

- (1) prawą kongruencją w półgrupie \({S}\), jeśli \(\forall x,y,z \in {S} \;\;\; x\;\rho\; y \Rightarrow xz\;\rho\; yz,\)

- (2) lewą kongruencją w półgrupie \({S}\), jeśli \(\forall x,y,z \in {S} \;\;\; x\;\rho\; y \Rightarrow zx\;\rho\; zy,\)

- (3) kongruencją, jeśli jest prawą i lewą kongruencją, tzn. \(\forall x,y,z \in {S} \;\;\; x\;\rho\; y \Rightarrow zx\;\rho\; zy \;\; i \;\; xz\;\rho\; yz.\)

Zastępując w powyższej definicji półgrupę \(S\) na monoid \(M\) otrzymamy dualnie pojęcia prawej kongruencji,

lewej kongruencji i kongruencji zdefiniowane w monoidzie.

Mając kongruencję \(\rho\) określoną w półgrupie \({S}\) (monoidzie

\(M)\) możemy utworzyć półgrupę ilorazową \({S}/\rho\) (monoid ilorazowy \({M}/\rho\)), której elementami

są klasy równoważności (abstrakcji) relacji \(\rho\).

Dla dowolnego homomorfizmu półgrup \(h:{S}\longmapsto {S}'\) określamy relację

Relacja \(Ker_h\) jest kongruencją w półgrupie \({S}.\)

Dla homomorfizmu monoidów \(h:{M}\longmapsto {M}'\) relacja \(Ker_h\) jest kongruencją w monoidzie \(M\).

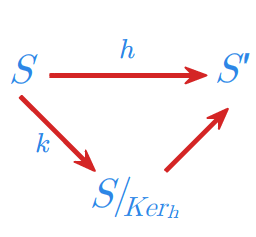

Podstawowe twierdzenie o epimorfizmie dla struktur algebraicznych przyjmuje dla półgrup i odpowiednio dla monoidów następującą postać.

Twierdzenie 1.1

Niech \(h:{S}\longmapsto {S}'\) będzie dowolnym epimorfizmem półgrupy \({S}\) na półgrupę \({S}'.\) Półgrupa \({S}'\) jest izomorficzna z półgrupą ilorazową \({S}/_{Ker_h}\).

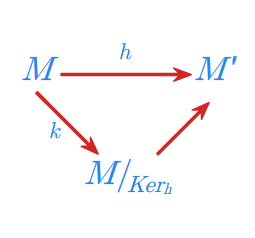

Twierdzenie 1.2

Niech \(h:{M}\longmapsto {M}'\) będzie dowolnym epimorfizmem monoidu \({M}\) na monoid \({M}'.\) Monoid \({M}'\) jest izomorficzny z monoidem ilorazowym \({M}/_{Ker_h}\).

Półgrupy wolne i monoidy wolne

Niech \({A}\) oznacza dowolny zbiór.

Definicja 2.1

Wolnym monoidem \(A^*\) o bazie \({A}\) nazywamy zbiór wszystkich skończonych ciągów:

Ciąg pusty \({(n=0)}\) oznaczamy symbolem "1" i z definicji jest on elementem neutralnym określonego powyżej działania, nazywanego katenacją lub konkatenacją.

Przyjmujemy następującą konwencję zapisu:Ta inkluzja uzasadnia użycie wprowadzonego wcześniej oznaczenia \(A^*\).

\(A^*\) jest najmniejszym podmonoidem

monoidu \(A^*\) zawierającym \(A.\)

Definicja 2.2

Wolną półgrupą \(A^+\) nad alfabetem \(A\) nazywamy zbiór wszystkich skończonych ciągów:

wraz z działaniem katenacji.

Używa się także określeń - wolny monoid o bazie \(A\) i wolna półgrupa o bazie \(A\).

- Elementy alfabetu \({A}\) nazywamy literami.

- Elementy wolnego monoidu (półgrupy) nazywamy słowami i oznaczać bedziemy w wykładzie najczęściej literami \(u,v,w\).

- Dowolny podzbiór wolnego monoidu (półgrupy) nazywamy językiem.

Długością słowa \(w \in A^*\) nazywamy liczbę \(|w|\) będącą długością ciągu określającego to słowo. Słowo puste 1, czyli odpowiadające ciągowi pustemu ma długość równą 0.

Przykład 2.1

- (1) Wolna półgrupa \(\{0,1\}^+\) składa się z ciągów binarnych.

- (2) Wolny monoid \(\{0,1\}^*\) składa się z ciągów binarnych i ciągu pustego.

Definicja 2.3

Niech \(A\) i \(B\) będą alfabetami. Podstawieniem nazywamy homomorfizm

Twierdzenie 2.1.

Niech \({A}\) oznacza dowolny zbiór, a \(({M},\cdot,1_{M})\) dowolny monoid.

- (1) Każde odwzorowanie

- daje się jednoznacznie rozszerzyć do homomorfizmu

\(h:A^*\longmapsto {M}.\)

- (2) Homomorfizm \({h}\) jest epimorfizmem wtedy i tylko wtedy, gdy \(f(A)\) jest zbiorem generatorów \({M}.\)

Dowód

- (1) Przyjmujemy

- Tak określone \(h\) jest jedynym rozszerzeniem przekształcenia \(f\).

- (2) \(f(A)^*=M \Leftrightarrow \forall s \in {M}\;\; s=f(a_1)...f(a_n)=h(a_1...a_n)\) dla pewnego \(a_1...a_n \in A^*\Leftrightarrow h\) jest suriekcją.

Przyjmując w powyższym twierdzeniu jako \(A\) dowolny zbiór generatorów monoidu \({M}\) oraz jako funkcję \(f\) włożenie \(id_{A}:A\longrightarrow \mathbf{M}\) równe identyczności na \({A}\) dochodzimy do następującego wniosku.

Wniosek 2.1.

Każdy monoid \({M}\) jest homomorficznym obrazem wolnego monoidu \(A^*\) utworzonego nad dowolnym zbiorem generatorów \({M}.\)

Udowodnione powyżej twierdzenie oraz sformułowany wniosek prawdziwy jest również dla półgrup.

Powyższe rezultaty określają rolę wolnych monoidów (półgrup) w klasie wszystkich monoidów (półgrup).

Twierdzenie 2.2.

Monoid \({M}\) jest wolny wtedy i tylko wtedy, gdy każdy element \(m \in {S}={M}\setminus \{1\}\) ma jednoznaczny rozkład na elementy zbioru \(A={S}\setminus {S}^2.\)

Dowod

Załóżmy, że monoid \({M}\) jest wolny, to znaczy \({M}=B^*\) dla pewnego zbioru (bazy) \(B.\)

- Udowodnimy, że \(A{}\) jest zbiorem generatorów monoidu \(M\). W tym celu wykażemy, że zachodzi inkluzja \({S}\subset ({S}\setminus {S}^2)^+.\)Dowód przeprowadzimy nie wprost. Załóżmy więc, że

- Udowodnimy, że \(A{}\) jest zbiorem generatorów monoidu \(M\). W tym celu wykażemy, że zachodzi inkluzja

- i niech \({m}\) oznacza element z tego zbioru o najmniejszej długości w \(B^*.\)

Wnioskujemy stąd kolejno:

\(m\in {S}^2\)

\(m=s_1s_2\) dla pewnych \(s_1,s_2\in {S}\),

- przy czym długość \(s_1,s_2\) jest silnie mniejsza niż długość \(m.\) Zatem

- a to oznacza, że

- Otrzymana sprzeczność kończy dowód faktu, że \(A={S}\setminus {S}^2\) jest zbiorem generatorów monoidu \({M}.\)

- Pokażemy teraz, że \(A \subset B.\)

Niech \(m=b_1...b_k \in {S}\setminus {S}^2\) dla pewnych \(b_i \in B\), \(i=1,...,k.\)

Jeśli \(k>1\), to \(m\in {S}^2\), co jest sprzeczne z wyborem \(m.\) Zatem \({k=1}\), co implikuje \(A\subset B.\)

- Pokażemy teraz, że \(A \subset B.\)

Z definicji wolnego monoidu wynika jednoznaczność rozkładu na elementy z bazy \(B\), a to pociąga za sobą jednoznaczność rozkładu na elementy z podzbioru \(A={S}\setminus {S}^2.\)

Niech teraz \({M}\) oznacza monoid z jednoznacznością rozkładu na elementy zbioru \(A~=~S~\setminus~S^2\). Rozszerzamy identyczność \(id_A:A\longmapsto {M}\) do homomorfizmu \(h:A^*\longmapsto {M}.\) Z założenia wynika, że każdy element \(m \in {S}\) można przedstawić jako iloczyn

Zatem

Homomorfizm \(h\) jest izomorfizmem, więc monoid \({M}\) jako izomorficzny z \(A^*\) jest wolny.

Powyższe twierdzenie posiada swój odpowiednik dla wolnych półgrup.

Twierdzenie 2.3.

Półgrupa \({S}\) jest wolna wtedy i tylko wtedy, gdy każdy element \(x \in {S}\) ma jednoznaczny rozkład na elementy zbioru \({S}\setminus {S}^2.\)

Wniosek 2.2.

Baza wolnego monoidu (półgrupy) jest minimalym zbiorem generatorów.

Przyklad 2.2.

- (1) Półgrupa \((\mathbb{N},+ )\) jest wolna. Każdy jej element można jednoznacznie zapisać jako sumę jedynek - \(\mathbb{N}\setminus (\mathbb{N}+\mathbb{N})=\left\{ 1\right\}\).

- (2) Dla \(\mathbb{N}_2=\{n \in \mathbb{N}:n\geq 2\}\) półgrupa \((\mathbb{N}_2,+ )\) nie jest to półgrupą wolną.

Nie ma jednoznaczności rozkładu na elementy z \(\mathbb{N}_2\setminus (\mathbb{N}_2+\mathbb{N}_2)=\{2,3\}\).

Na przykład \(6=2+2+2=3+3\).

Gramatyka jako model obliczen. Hierarchia Chomsky'ego

W tym wykładzie wprowadzimy ogólne pojęcie systemu przepisującego, zdefiniujemy gramatykę, czyli szczególny typ systemu przepisującego oraz określimy cztery typy gramatyk wprowadzone przez Noama Chomsky'ego.

Teoria języków formalnych i automatów tworzy i bada pewne modele obliczeń, można popularnie powiedzieć modele komputera, zwane automatami lub gramatykami. Jednym z głównych i ogólnych problemów wokół którego skupione są badania tej teorii jest problem możliwości i ograniczeń obliczeniowych. Początki tych rozważań sięgają lat trzydziestych ubiegłego stulecia i wiążą się z pracami K.Goedla i późniejszymi A.Turinga i A.Churcha. Równolegle do teorii automatów problematyka ta jest intensywnie badana w ramach teorii obliczalności i teorii złożoności.

W tym wykładzie wprowadzimy pierwszy z tych modeli, mianowicie gramatykę. Określimy także sposób wyprowadzenia (generowania) słowa zgodnie z regułami gramatycznymi i zdefiniujemy język opisywany przez gramatykę. Przedstawimy również podstawowe typy gramatyk wprowadzone do lingwistyki teoretycznej i później do teorii języków formalnych przez Noama Chomsky'ego, twórcę pojęcia gramatyki transformacyjno-generatywnej, co miało miejsce w roku 1957.

Przez gramatykę rozumie się systematyczny opis wybranego języka naturalnego, opis, który obejmuje jego składnię (syntaktykę), znaczenie (semantykę) i fonologię, czyli dźwiękowy system języka. Reguły składni określają regularności rządzące kombinacjami słów, semantyka bada znaczenie słów i zdań, a fonologia wyróżnia dźwięki i ich dopuszczalne zestawienia w opisywanym języku.

Teoria języków formalnych bada wyłącznie syntaktyczne własności języków. Język rozumiany jest abstrakcyjnie, jako zbiór skończonych napisów. Zatem opierając się na wiadomościach z poprzedniego wykładu możemy powiedzieć, że język (formalny) \(L\) to dowolny podzbiór wolnego monoidu \(A^{*}\). Baza tego wolnego monoidu, czyli zbiór \({A}\) to alfabet, a sam wolny monoid możemy interpretować, jako zbiór wszystkich możliwych napisów utworzonych w tym alfabecie. Na ogół język \(L\) jest właściwym podzbiorem \(A^{*}\), czyli składa się z pewnych tylko ("poprawnych") napisów. Wyróżniając język \(L\) zazwyczaj wprowadzamy pewne kryteria, które muszą spełniać napisy z tego języka. Dlatego o elementach języka \(L\) mówimy, że spełniają te kryteria lub że są syntaktycznie poprawne.

Jak już powiedzieliśmy teoria języków formalnych tworzy pewne modele obliczeń lub inaczej systemy opisu języków zwane gramatykami i automatami. Od tych systemów żąda się, aby spełniały warunki efektywności analitycznej i efektywności syntetycznej. Pierwszy z warunków oznacza, że system opisu prowadzi do algorytmu, który w skończonej liczbie kroków rozstrzyga, czy dowolne słowo należy, czy też nie należy do tego języka. Spełnienie warunku drugiego daje w rezultacie algorytm, który umożliwia wygenerowanie wszystkich słów danego języka.

Gramatyka to system, którego działanie opiera się na procesie sekwencyjnego przepisywania, czyli modyfikowania pewnych napisów (słów). Przepisywanie to realizowane jest poprzez reguły przyjęte w danym systemie jako dopuszczalne. Idea ta związana jest z nazwiskami takich logików jak Axel Thue czy Emil Post. W roku 1957 Noam Chomsky, lingwista amerykański, stworzył pewien matematyczny formalizm opisu języków naturalnych zwany gramatykami generacyjnymi.

Gramatyki te opisują wybrane, najbardziej istotne cechy syntaktyczne języków, w szczególności ich strukturalne regularności.

Idee Chomsky'ego bardzo szybko przeniknęły do innych dziedzin nauki. Stworzona teoria znalazła istotne zastosowanie w badaniach nad językami programowania. Z powodzeniem gramatyki Chomsky'ego służą również do budowania modeli procesów biologicznych, czy też procesów badanych przez nauki o społeczeństwie. Teoria gramatyk rozwinęła się w wielu kierunkach, służąc jako formalny opis sekwencyjnych zmian różnorakich obiektów, takich jak, termy, grafy, obrazy, czy fraktale.

System przepisujący

Definicja 1.1

System przepisujący jest to para \(RS=(A,P)\), gdzie

\({A}\) jest dowolnym skończonym zbiorem (alfabetem),

\(P \subseteq A^* \times A^*\) - skończoną relacją (zbiorem praw).

Fakt, że para \((u,v) \in P\) zapisujemy, \(u~\rightarrow~v \in P\) i nazywamy prawem przepisywania lub produkcją w systemie \(RS\).

Definicja 1.2

Niech \(RS=(A,P)\) będzie dowolnym systemem przepisującym, a \(\;\;x,y~\in~A^*\) dowolnymi słowami.

System \(RS\) przepisuje słowo \(x\) na słowo \(y\) (generuje \(y\) z \(x\)) bezpośrednio, co oznacza się symbolem

jeśli istnieją słowa \(x_1 , x_2 \in A^*\) oraz prawo \(u~\rightarrow~v \in P\) takie, że

\(x = x_1 ux_2,\;\; y = x_1 vx_2.\)

System \(RS\) przepisuje słowo \(x\) na słowo \(y\) (generuje \(y\) z \(x\)), co oznacza się symbolemBezpośrednie wyprowadzenie \("\mapsto "\) jest relacją na

wolnym monoidzie \(A^*\), a wyprowadzenie \("\mapsto^*"\) zwrotnym i przechodnim domknięciem tej relacji.

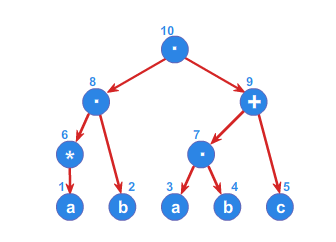

Rysunek 1

Niech \(RS=(\{a,b,c\},\{(ba,ab),(ca,ac),(cb,bc)\} )\) będzie systemem przepisującym. W systemie \(RS\) słowo \(aabbcc\) można wyprowadzić ze słowa \(cabbac\) (rysunek 1).

Rozważa się systemy przepisujące generujące lub rozpoznające język.

Definicja 1.3

Niech \(RS=(A,P)\) będzie dowolnym systemem przepisującym, a \(I\) dowolnym, ustalonym podzbiorem \(A^{*}\).

- językiem generowanym przez \(RS\) nazywamy zbiór

- językiem rozpoznawanym przez \(RS\) nazywamy zbiór:

Przykład 1.2

Jeśli w przykładzie 1.1 (patrz przykład 1.1.) przyjmiemy \(I=\{cab \},\) to

Gramatyka, której definicję teraz wprowadzimy, jest szczególnym systemem Thuego. Można powiedzieć, że jest to system Thuego tak określony, aby poprzez wskazanie jedynie poprawnych sposobów generowania napisów definiować język. Gramatyka to jedno z najważniejszych pojęć teorii języków formalnych. Używany poniżej, dla \(u \in A^*\) i \(B \subset A\), symbol \(\# _{B} u\) oznacza liczbę wystąpień liter z alfabetu \(B\) w słowie \({u}\).

Definicja 1.4

Gramatyka jest to system \(G = (V_N,V_T,P,v_0)\), w którym

\(V_N \neq \emptyset\) - skończony zbiór symboli nieterminalnych (alfabet nieterminalny),

\(V_T \neq \emptyset\) - skończony zbiór symboli terminalnych (alfabet terminalny),

\(P \subseteq (V_N \cup V_T)^+ \times (V_N \cup V_T)^*\) - skończona relacja, zbiór produkcji (praw),

\(v_0 \in V_N\) - symbol początkowy (startowy).

Ponadto zakładamy, że \(V_N \cap V_T = \emptyset\;\;\;\) i dla każdego \(\;\;(u,v) \in P\;\;\; \# _{V_N} u \geq 1\).

A zatem w gramatyce alfabety terminalny i nieterminalny są rozłącznymi zbiorami, a słowo \(u\) występujące po lewej stronie produkcji zawiera co najmniej jeden symbol nieterminalny. Fakt, że para \((u,v) \in P,\) zapisujemy:/p>

Wykorzystujemy też zdefiniowane dla systemów przepisujących pojęcia generowania bezpośredniego \("\mapsto "\) i generowania \("\mapsto^* "\).

Definicja 1.5

Językiem generowanym przez gramatykę \(G = (V_N,V_T,P,v_0)\) nazywamy zbiór:

Łatwo zauważyć, że pomiędzy językiem a generującą go gramatyką nie ma odpowiedniości wzajemnie jednoznacznej. Dany język może być generowany przez wiele gramatyk, czasem o bardzo różnej strukturze i własnościach. Stąd potrzeba wprowadzenia pojęcia równoważności językowej dla gramatyk.

Definicja 1.6

Gramatyki \(G_1\) i \(G_2\) są równoważne (językowo) wtedy i tylko wtedy, gdy \(L(G_1) = L(G_2)\).

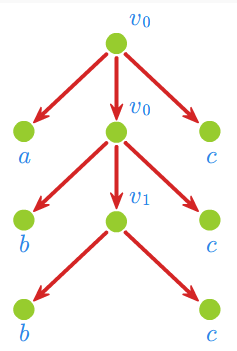

Przykład 1.3

- (1) Gramatyka \(G_1 = (V_N,V_T,P,v_0)\), w której \(V_N = \{v_0\}, \;\; V_T = \{a\}, \;\; P = \{ v_0 \rightarrow v_0a, \; v_0 \rightarrow a \},\) generuje język

- (2) Gramatyka \(G_2 = (V_N,V_T,P,v_0)\), w której \(V_N = \{v_0\}, \;\; V_T = \{a\}, \;\; P = \{ v_0 \rightarrow v_0v_0, \; v_0 \rightarrow a \},\) generuje język \(L(G_2) = \{ a^n : n = 1,2,... \}\).

- (3) Gramatyka \(G_{3}=\left( V_{N},V_{T},P,v_{0}\right)\), w której \(V_{N}=\left\{ v_{0},v_{1},w,w_{1},w_{2},z,z_{1},z_{2},z_{3}\right\} , \; \; V_{T}=\left\{ a,b,c\right\}\),

- generuje język

- (4) Gramatyka \(G_4 = (V_N,V_T,P,v_0)\), w której \(V_N = \{v_0, v_1, v_2 \}, \;\; V_T = \{a,b,c\}\),

- generuje język

\(L(G_4) = \{ a^n b^n c^n : n = 1,2,... \}.\)

Gramatyki \(G_1\) i \(G_2\) są równoważne. Równoważne również są gramatyki \(G_3\) i \(G_4\).

Klasyfikacja Chomsky'ego

Wprowadzimy teraz cztery typy gramatyk określonych, jak powiedziano już wcześniej, przez Noama Chomsky'ego.

Definicja 2.1

Gramatyka \(G = (V_N,V_T,P,v_0)\) jest typu \(\textbf{(i)}\) dla \(i=0,1,2,3\) wtedy i tylko wtedy, gdy spełnia następujące warunki:

- typ(0): każda gramatyka, czyli system spełniajacy definicję 1.4 (patrz definicja 1.4.)

- typ(1): kontekstowa, czyli gramatyka, w której każde prawo ze zbioru \(P\) ma postać

\(u_1 vu_2 \rightarrow u_1 xu_2,\) - gdzie \(u_1 , u_2 \in (V_N \cup V_T)^*, \; \; v \in V_N , \;\; x \in (V_N \cup V_T)^+\) lub

\(v_0 \rightarrow 1,\) przy czym, jeśli \(v_0 \rightarrow 1 \in P\), to \({v_0}\) nie występuje po prawej stronie w żadnym prawie z \(P\),

- typ (2): bezkontekstowa, czyli gramatyka, w której każde prawo ze zbioru \(P\) ma postać

\(v \rightarrow x,\) gdzie \(v \in V_N, \;\; x \in (V_N \cup V_T)^*\),

- typ (3): regularna, czyli gramatyka, w której każde prawo ze zbioru \(P\) ma postać

\(v \rightarrow v'x\;\;\; lub \;\;\;v \rightarrow x,\) gdzie \(v,v' \in V_N, \;\; x \in V_T^*\).

Przykład 2.1

Gramatyki z przykładu 1.3 (patrz przykład 1.3.) są odpowiednio

- (1) \(G_1\) - typu (3)

- (2) \(G_2\) - typu (2)

- (3) \(G_3\) - typu (1)

- (4) \(G_4\) - typu (0)

Natomiast język \(L(G_1)=L(G_2)\) jest typu (3),

język \(L(G_3)=L(G_4)\) jest typu (1).

W oparciu o wprowadzone typy gramatyk określamy odpowiadające im rodziny (klasy) języków, oznaczając przez

- \(\bf \mathcal{L}_{0}\): - rodzinę wszystkich języków typu 0,

- \(\bf \mathcal{L}_{1}\): - rodzinę wszystkich języków typu 1, czyli języków kontekstowych,

- \(\bf \mathcal{L}_{2}\): - rodzinę wszystkich języków typu 2, czyli języków bezkontekstowych,

- \(\bf \mathcal{L}_{3}\): - rodzinę wszystkich języków typu 3, czyli języków regularnych.

Pomiędzy wprowadzonymi rodzinami języków zachodzą następujące zależności:

Inkluzje pierwsza i trzecia wynikają bezpośrednio z definicji odpowiednich klas języków, a więc z definicji gramatyk regularnej i bezkontekstowej oraz kontekstowej i typu (0). Natomiast fakt, że \(\bf \mathcal{L}_{2}\subset \bf \mathcal{L}_{1},\) udowodnimy później. Podobnie z dalszych rozważań wynika, że powyższe inkluzje są właściwe.

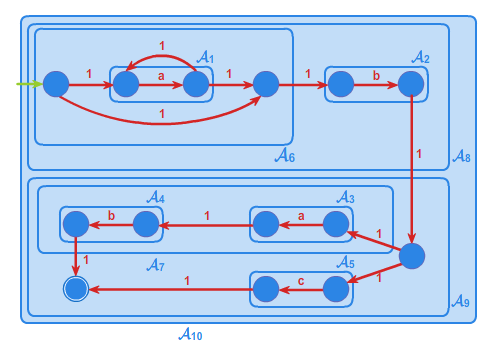

Gramatyki spełniają warunek efektywności syntetycznej. Systemami, które realizują warunek fektywności analitycznej, są automaty. Automaty działają w ten sposób, iż pod wpływem zewnętrznego sygnału zmieniają swój stan. W efekcie tej zmiany rozpoznają bądź nie ciągi takich sygnałów reprezentowane przez słowa. Zatem działanie automatu polega na testowaniu kolejno słów z \(A^{*}\) i określaniu, które z nich są rozpoznawane (spełniają określone kryteria), a które nie są rozpoznawane. Ogół słów rozpoznanych przez automat tworzy język rozpoznawany przez ten automat. Dla każdej z określonych powyżej rodzin języków, w sensie Chomsky'ego określa się odpowiadającą jej rodzinę automatów.

Język \(L\) jest typu (i) dla \(i=0,1,2,3\) wtedy i tylko wtedy, gdy jest rozpoznawany przez jakiś automat z odpowiedniej rodziny. Definicje automatów i ich własności wprowadzane będą sukcesywnie przy prezentowaniu poszczególnych rodzin języków.

Automat skończenie stanowy

W rozdziale tym zdefiniujemy automat - drugi, obok gramatyki, model obliczeń. Określimy język rozpoznawany przez automat i podamy warunki równoważne na to, by język był rozpoznawany.

Automaty

Wprowadzimy teraz pojęcie automatu. Jak już wspomnieliśmy w wykładzie drugim automat to drugi, obok gramatyki, model obliczeń będący przedmiotem badań teorii języków i automatów. Model realizujący warunek efektywności analitycznej, czyli taki na podstawie którego możliwe jest sformułowanie algorytmu rozstrzygającego w skończonej liczbie kroków, czy dowolne słowo należy, czy też nie należy do języka rozpoznawanego przez ten automat. Lub inaczej możemy powiedzieć, że taki automat daje algorytm efektywnie rozstrzygający, czy dowolne obliczenie sformułowane nad alfabetem automatu jest poprawne.

Wprowadzony w tym wykładzie automat, zwany automatem skończenie stanowym, jest jednym z najprostszych modeli obliczeń. Jest to model z bardzo istotnie ograniczoną pamięcią. Działanie takiego automatu sprowadza się do zmiany stanu pod wpływem określonego zewnętrznego sygnału czy impulsu.

Pomimo tych ograniczeń urządzenia techniczne oparte o modele takich automatów spotkać możemy dość często. Jako przykład służyć mogą automatyczne drzwi, automaty sprzedające napoje, winda, czy też urządzenia sterujące taśmą produkcyjną.

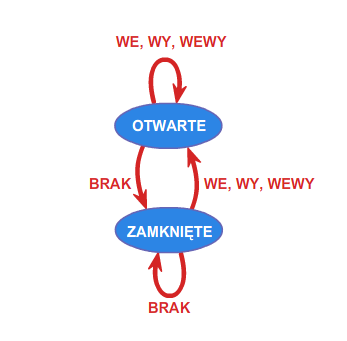

Przykład 1.1.

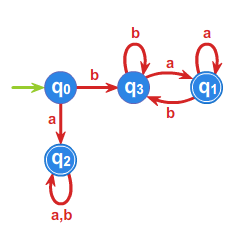

Drzwi automatycznie otwierane są sterowane automatem, którego działanie opisać można, przyjmując następujące oznaczenia. Fakt, że osoba chce wejść do pomieszczenia zamykanego przez takie drzwi, identyfikowany przez odpowiedni czujnik, opiszemy symbolem \(\displaystyle WE\). Zamiar wyjścia symbolem \(\displaystyle WY\). Symbol \(\displaystyle WEWY\) będzie związany z równoczesnym zamiarem wejścia jakiejś osoby i wyjścia innej. Wreszcie symbol \(\displaystyle BRAK\) oznaczał będzie brak osób, które chcą wejść lub wyjść. Zatem zbiór \(\displaystyle \{ WE, WY,WEWY,BRAK \}\), to alfabet nad którym określimy automat o \(\displaystyle 2\) stanach: \(\displaystyle OTWARTE, ZAMKNIĘTE\) poniższym grafem.

Automaty reagują więc na określone sygnały zewnętrzne reprezentowane przez litery alfabetu \(\displaystyle A\), zmieniając swój stan. Jeśli ustalimy stan początkowy automatu oraz dopuszczalne stany końcowe, to automat będzie testował dowolne słowo z \(\displaystyle A^{*}\) , startując ze stanu początkowego. Jeśli rezultatem finalnym działania automatu (obliczenia) będzie stan końcowy, to słowo będzie rozpoznawane przez automat, a obliczenie określone takim słowem poprawne. Automaty można graficznie reprezentować jako etykietowane grafy skierowane. W takim grafie każdy wierzchołek odpowiada stanowi automatu, a każda strzałka pomiędzy wierzchołkami \(\displaystyle u\) i \(\displaystyle v\), etykietowana symbolem \(\displaystyle a\), oznacza rzejście automatu ze stanu \(\displaystyle u\) do stanu \(\displaystyle v\) pod wpływem litery \(\displaystyle a\). Podamy teraz definicję automatu. Niech \(\displaystyle A\) oznacza dowolny alfabet. Od tego momentu wykładu zakładamy, że alfabet jest zbiorem skończonym.

Definicja 1.1

Automatem nad alfabetem \(\displaystyle A\) nazywamy system \(\displaystyle \mathcal{A} \displaystyle =(S,f)\), w którym

\(\displaystyle S\) - jest dowolnym skończonym zbiorem zwanym zbiorem stanów,

\(\displaystyle f: S \times A \rightarrow S\) - jest funkcją przejść.

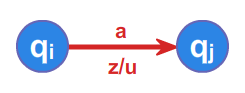

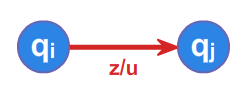

Automat będąc w stanie \(\displaystyle s_{i}\) po przeczytaniu litery \(\displaystyle a\) zmienia stan na \(\displaystyle s_{j}\) zgodnie z funkcją przejścia \(\displaystyle f(s_{i},a)=s_{j}\) .

Funkcję przejść rozszerzamy na cały wolny monoid \(\displaystyle A^{*}\) do postaci

przyjmując:

dla każdego \(\displaystyle s \in S\;\;\;f(s,1) = s\) oraz

dla każdego \(\displaystyle s \in S,\;\;a \in A\) i dla dowolnego \(\displaystyle w \in A^*\)

Działanie automatu pokazane jest na poniższej animacji 2.

Zdefiniowany powyżej automat \(\displaystyle \mathcal{A}\) nazywamy skończonym lub

skończenie stanowym ze względu na założenie skończoności zbioru stanów \(\displaystyle S\).

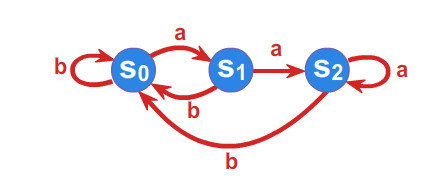

Przykład 1.2.

Niech \(\displaystyle A=\left\{ a,b\right\}\) będzie alfabetem, a \(\displaystyle \mathcal{A}=(S,f)\) automatem takim, że

\(\displaystyle S=\left\{ s_{0},s_{1},s_{2}\right\}\) , a funkcja przejść zadana jest przy pomocy tabelki

Automat możemy również jednoznacznie określić przy pomocy grafu.

Podamy teraz bardzo interesujący przykład zastosowania automatów skończonych. Przedstawimy mianowicie wykorzystanie tak zwanych automatów synchronizujących w przemyśle. Automat synchronizujący nad alfabetem \(\displaystyle A\) to automat \(\displaystyle (S,f)\) o następującej własności: istnieje stan \(\displaystyle t \in S\) oraz słowo \(\displaystyle w \in A^*\) takie, że dla każdego stanu \(\displaystyle s\) tego automatu \(\displaystyle f(s, w)=t\). Istnieje więc pewne uniwersalne słowo \(\displaystyle w\), pod wpływem którego wszystkie stany przechodzą w jeden, ustalony stan automatu \(\displaystyle t \in S\). Mówimy, że następuje wtedy synchronizacja wszystkich stanów automatu.

Poniżej prezentujemy przykład zaczerpnięty z pracy Ananicheva i Volkova (D. S. Ananichev, M. V. Volkov, Synchronizing Monotonic Automata, Lecture Notes in Computer Science, 2710(2003), 111-121.), ukazujący ideę użycia automatów synchronizujących w tej dziedzinie.

Przykład 1.3.

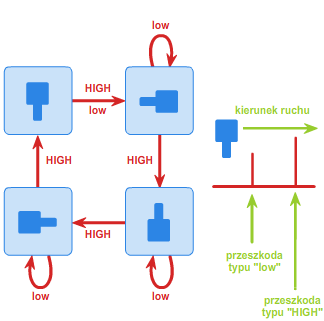

Załóżmy, że pewna fabryka produkuje detale w kształcie kwadratu z "wypustką" na jednym boku (patrz rys. 3). Po wyprodukowaniu detale należy umieścić w opakowaniach w ten sposób, by wszystkie były w tej samej orientacji - mianowicie "wypustką" w lewo.

Załóżmy ponadto dla uproszczenia, że detale mogą przyjmować jedną z czterech orientacji (rys. 4): "wypustką" w górę, w dół, w lewo lub w prawo.

Należy zatem skonstruować takie urządzenie (orienter), które będzie ustawiało wszystkie detale w żądanej orientacji. Oczywiście istnieje wiele metod rozwiązania tego problemu, ale z praktycznego punktu widzenia potrzebne jest rozwiązanie najprostsze i najtańsze. Jednym z takich sposobów jest umieszczanie detali na pasie transmisyjnym z zamontowaną wzdłuż niego pewną ilością przeszkód dwojakiego rodzaju: niskich (low) oraz wysokich (HIGH). Wysoka przeszkoda ma tę własność, że każdy detal, który ją napotka, zostanie obrócony o 90 stopni w prawo (zakładamy, że elementy jadą od lewej do prawej strony). Przeszkoda niska obróci o 90 stopni w prawo tylko te detale, które są ułożone "wypustką" w dół. Na rys. 5 przedstawione zostały przejścia pomiędzy orientacjami detali w zależności od napotkania odpowiedniej przeszkody.

Można zauważyć, że automat z rysunku 5 jest automatem synchronizującym. Słowem, które go synchronizuje, jest następująca sekwencja przeszkód:

low-HIGH-HIGH-HIGH-low-HIGH-HIGH-HIGH-low.

Niezależnie od tego, w jakiej orientacji początkowej znajduje się detal, po przejściu przez powyższą sekwencję przeszkód zawsze będzie ułożony "wypustką" w lewo. Sytuację przedstawia poniższa animacja 3:

Rozszerzymy teraz wprowadzone pojęcie automatu w ten sposób, by uzyskać możliwość efektywnego rozstrzygania, czy dowolne słowo utworzone nad alfabetem \(\displaystyle A\) reprezentuje poprawne obliczenie, czyli spełnia kryteria określone przez rozszerzony automat.

Definicja 1.2.

Język \(\displaystyle \; L~\subset A^* \;\) jest rozpoznawany (akceptowany) wtedy i tylko wtedy, gdy istnieje automat skończony \(\displaystyle \mathcal{A} \displaystyle = (S,f) , \;\) stan \(\displaystyle \; s_0 \in S \;\) oraz zbiór \(\displaystyle \; T \subset S \;\) takie, że

Stan \(\displaystyle s_0 \;\) nazywamy stanem początkowym, a \(\displaystyle \; T \;\) zbiorem stanów końcowych automatu \(\displaystyle \mathcal{A}\) .

Rozszerzony w powyższy sposób automat, poprzez dodanie stanu początkowgo i zbioru stanów końcowych, w dalszym ciągu nazywamy automatem i oznaczamy jako piątkę \(\displaystyle \mathcal{A} \displaystyle = (S,A,f,s_0,T)\) lub czwórkę \(\displaystyle \mathcal{A} \displaystyle =(S,f,s_0,T)\), jeśli wiadomo, nad jakim alfabetem rozważamy działanie automatu.

Fakt, że język \(\displaystyle \; L \;\) jest rozpoznawany przez automat \(\displaystyle \mathcal{A},\) zapisujemy jako

Rodzinę wszystkich języków rozpoznawalnych nad alfabetem \(\displaystyle A\) oznaczamy przez \(\displaystyle \mathcal{REC}(\mathcal{A}^{*})\) .

Podobnie jak w przypadku gramatyk nie ma jednoznacznej odpowiedniości pomiędzy językami rozpoznawalnymi a automatami. Wprowadza się więc relację, która identyfikuje automaty rozpoznające ten sam język.

Definicja 1.3.

Automaty \(\displaystyle \mathcal{A}_{1}\) i \(\displaystyle \mathcal{A}_{2}\) są równoważne, jeśli rozpoznają ten sam język, czyli

W dalszych rozważaniach języków rozpoznawanych ograniczymy się do automatów \(\displaystyle \mathcal{A} \displaystyle = (S,A,f,s_0,T)\), które spełniają warunek \(\displaystyle f(s_0,A^*) = S.\) Nie zawęża to naszych rozważań. Jeśli bowiem język \(\displaystyle \; L \;\) jest rozpoznawany przez pewien automat \(\displaystyle \mathcal{A} \displaystyle = (S,A,f,s_0,T)\), to jest również rozpoznawany przez automat

który spełnia powyższy warunek. Zauważmy, że przyjmując to założenie, upraszczamy strukturę automatu. Z punktu widzenia grafu automatu można powiedzieć, że nie występują w nim wierzchołki (stany) nieosiagalne z \(\displaystyle s_0\). Poniżej przedstawiamy algorytm usuwający z automatu stany nieosiągalne ze stanu początkowego.

Algorytm UsuńStanyNieosiągalne - usuwa z automatu \(\displaystyle \mathcal{A}\) stany nieosiągalne

Wyjście: A'=(S', A, f', s_0, T') - automat równoważny automatowi A bez stanów nieosiągalnych.

for each p in S do

zaznaczone[p] <- 0;

end for

zaznaczone[s_0] <- 1;

OZNACZ (s_0);

S' <- {s in S: zaznaczone[s]=1};

T' <- T cap S';

flag <-false # jeśli nie dodamy stanu to na końcu pętli nadal flag=false

f' <- f;

for each p in S do

for each a in A do

if f'(p,a)=NULL then

f'(p,a)<- s_f; # f'(p,a) była nieokreślona

flag <-true;

end if

end for

end for

if flag=true then

S'<- S' cup {s_f};

end if

return A'=(S', A, f', s_0, T');

Algorytm Procedure Oznacz

procedure OZNACZ (x in S)

for each p in S

flag <-false

for each a in A do

if f(x,a)=p then

flag <-true

end if

end for

if flag=true and zaznaczone [p]=0 then

zaznaczone [p] <- 1;

OZNACZ (p);

end if

end for

end procedure

Powyższy algorytm, dla ustalonego alfabetu \(\displaystyle A\), posiada złożoność \(\displaystyle O(|A| \cdot |S|)\), czyli liniową względem liczby stanów.

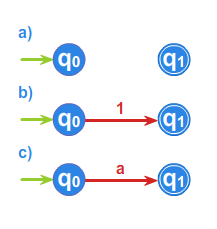

Przedstawiając automat przy pomocy grafu przyjmujemy następującą konwencję. Jeśli w automacie występuje stan początkowy, oznaczać go będziemy zieloną strzałką wchodzącą do tego stanu. Jeśli w automacie występują stany końcowe, oznaczać je będziemy niebieską obwódką.

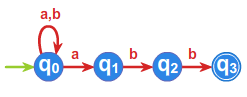

Przykład 1.4.

Jeśli w przykładzie 1.2 (patrz przykład 1.2.) przyjmiemy stan \(\displaystyle s_{0}\) jako stan początkowy, \(\displaystyle T=\left\{ s_{2}\right\}\) jako zbiór stanów końcowych, to automat \(\displaystyle \mathcal{A} = (S,A,f,s_0,T)\) rozpoznaje język

złożony ze słów, kończących się na \(\displaystyle a^2\) .

Słowo \(\displaystyle aba\) nie jest akceptowane.

Słowo \(\displaystyle abaa\) jest akceptowane.

Każdy automat \(\displaystyle \mathcal{A} \displaystyle = (S,A,f,s_0,T)\) wyznacza w wolnym monoidzie \(\displaystyle A^*\) prawą kongruencję, nazywaną prawą kongruencją automatową, określoną w następujący sposób:

\(\displaystyle \forall u,v \in A^*\)

Dla automatu skończonego (o skończonym zbiorze stanów), a takie rozważamy, relacja \(\displaystyle \sim _{A}\) ma skończony indeks, czyli skończoną liczbę klas równoważności.

Przykład 1.5.

Automat z przykładu 1.2 (patrz przykład 1.2.) ze stanem \(\displaystyle s_{0}\) jako początkowym wyznacza relację równoważności o trzech klasach:

\(\displaystyle [1]=A^*\left\{ b \right\}\cup \left\{ 1\right\}\),

\(\displaystyle [a]=A^*\left\{ ba\right\} \cup \left\{ a\right\}\),

\(\displaystyle [a^2]=A^*\left\{ a^2 \right\}.\)

Na odwrót, każda prawa kongruencja \(\displaystyle \rho \subset (A^*)^2\) wyznacza automat, zwany ilorazowym, w następujący sposób:

\(\displaystyle \mathcal{A} \displaystyle _\rho\) jest automatem ze stanem początkowym \(\displaystyle [1]_\rho\). \(\displaystyle \mathcal{A}_{\rho }\) jest automatem skończonym wtedy i tylko wtedy, gdy relacja \(\displaystyle \rho\) ma skończony indeks.

Z definicji prawej kongruencji wynika, że funkcja przejść \(\displaystyle f^*\) jest określona poprawnie.

Definicja 1.4.

Niech \(\displaystyle \mathcal{A} \displaystyle =(S,f)\) i \(\displaystyle \, \mathcal{B} \displaystyle =(T,g)\) będą dowolnymi automatami. Odwzorowanie \(\displaystyle \varphi:S\longrightarrow T\) nazywamy homomorfizmem automatów wtedy i tylko

wtedy, jeśli

Homomorfizm automatów oznaczamy \(\displaystyle \varphi :\mathcal{A}\longrightarrow \mathcal{B}\) .

Twierdzenie 1.1.

Prawdziwe są następujące fakty:

(1) Dla dowolnej prawej kongruencji \(\displaystyle \; \rho \; \subset \; (A^*)^2\)

(2) Dowolny automat \(\displaystyle \mathcal{A} \displaystyle = (S,A,f,s_0,T)\) jest izomorficzny z automatem \(\displaystyle \mathcal{A}_{\sim _{\mathcal{A}}}\) ,

(3) Dla dowolnych automatów \(\displaystyle \mathcal{A}_1 \displaystyle = (S_1,A,f_1,s^1_0,T_1)\) i \(\displaystyle \mathcal{A}_2 \displaystyle = (S_2,A,f_2,s^2_0,T_2)\) prawdziwa jest równoważność

\(\displaystyle \sim _{\mathcal{A}_1}\: \subseteq \: \sim _{\mathcal{A}_2}\: \: \Longleftrightarrow \:\) istnieje epimorfizm \(\displaystyle \varphi :\mathcal{A}_1\longrightarrow \mathcal{A}_2\) taki, że \(\displaystyle \varphi(s^1_0) = s^2_0\).

Dowód

(1) Identyczność relacji wynika wprost z definicji automatu ilorazowego \(\displaystyle \mathcal{A} \displaystyle _\rho\) oraz prawej kongruencji \(\displaystyle \sim _{A_{\rho }}\) .

(2) Rozważmy automat \(\displaystyle \mathcal{A} \displaystyle = (S,A,f,s_0,T)\) i odwzorowanie

gdzie \(\displaystyle \forall s\in S\)

Istnienie słowa \(\displaystyle w\) wynika z faktu, że \(\displaystyle s_0\) jest stanem początkowym, natomiast z definicji relacji \(\displaystyle \sim _{\mathcal{A}}\) wynika, że odwzorowanie \(\displaystyle \psi\) jest poprawnie określone.

Odwzorowanie \(\displaystyle \psi\) ma być homomorfizmem, czyli dla każdego stanu \(\displaystyle s\in S\) i dowolnego słowa \(\displaystyle w\in A^{*}\) spełniać warunek

Warunek ten wynika z następujących równości

gdzie \(\displaystyle f(s_0,u)=s\).

Z prostych obserwacji wynika, że \(\displaystyle \psi\) jest suriekcją i iniekcją.

(3) Dowód implikacji "\(\displaystyle \Rightarrow\)"

Załóżmy, że \(\displaystyle \: \sim _{\mathcal{A}_1}\: \subseteq \: \sim _{\mathcal{A}_2 }\) . Niech

będzie odwzorowaniem takim, że

\(\displaystyle \forall s\in S_1\) \(\displaystyle \varphi (s) = f_2(s^2_0,w),\;\;\text{gdzie}\;\; w\in A^{*}\;\; i \;\; f_1(s^1_0,w) = s.\)

Stąd, że \(\displaystyle s^1_0\) jest stanem początkowym automatu \(\displaystyle \mathcal{A}_1,\)

wynika, że istnieje słowo \(\displaystyle \; w \in A^* \;\) potrzebne do określenia epimorfizmu \(\displaystyle \varphi\).

Z założenia \(\displaystyle \: \sim _{\mathcal{A}_1}\: \subseteq \: \sim _{\mathcal{A}_2}\)

wynika, że \(\displaystyle \varphi \;\) jest poprawnie zdefiniowaną funkcją.

Uzasadnienie faktu, że \(\displaystyle \varphi\) jest homomorfizmem, jest analogiczne jak w punkcie (2) dla \(\displaystyle \psi\).

\(\displaystyle \varphi\) jest suriekcją, gdyż \(\displaystyle \; s^2_0 \;\) jest stanem początkowym automatu \(\displaystyle \mathcal{A}_2\) .

\(\displaystyle \; \varphi (s^1_0) = s^2_0, \;\) ponieważ \(\displaystyle \; f_1(s^1_0,1) = s^1_0\).

Dowód implikacji "\(\displaystyle \Leftarrow\)"

Niech \(\displaystyle \varphi :\mathcal{A}_1\longrightarrow \mathcal{A}_2\) będzie epimorfizmem

takim, że \(\displaystyle \; \varphi (s^1_0) = s^2_0 \;\).

Wówczas prawdziwy jest następujący ciąg wnioskowań.

To oznacza, że \(\displaystyle \sim _{\mathcal{A}_1}\subseteq \sim _{\mathcal{A}_2}\) .

Symbolem \(\displaystyle S^S\) oznaczamy rodzinę wszystkich funkcji określonych na zbiorze \(\displaystyle S\) i przyjmujących wartości w \(\displaystyle S\). Łatwo zauważyć, iż rodzina ta wraz ze składaniem odwzorowań jest monoidem \(\displaystyle (S^S,\circ)\) .

Definicja 1.5.

Niech \(\displaystyle \mathcal{A} \displaystyle = (S,f)\) będzie dowolnym automatem. Reprezentacją automatu \(\displaystyle \mathcal{A}\) nazywamy funkcję \(\displaystyle \tau _{\mathcal{A}}:A^{*}\longrightarrow S^{S}\) , określoną dla dowolnych \(\displaystyle w \in A^*\) i \(\displaystyle \; s \in S \;\) równością

Reprezentacja automatu jest homomorfizmem monoidu \(\displaystyle A^*\) w monoid \(\displaystyle S^S\), bowiem dla dowolnych \(\displaystyle v,w \in A^*\) spełnione są warunki

Definicja 1.6.

Niech \(\displaystyle \mathcal{A} \displaystyle = (S,f)\) będzie dowolnym automatem. Monoidem przejść automatu \(\displaystyle \mathcal{A}\) nazywamy monoid

Następujące wnioski są konsekwencjami rozważań przeprowadzonych powyżej.

Wniosek 1.1.

(1) Monoid przejść automatu \(\displaystyle \mathcal{A}\) jest podmonoidem monoidu \(\displaystyle S^S\) i zbiór \(\displaystyle \left\{ \tau _{\mathcal{A}}(a):a\in A\right\}\) jest zbiorem generatorów tego monoidu.

Wynika to z faktu, że \(\displaystyle \tau _{\mathcal{A}}\) jest epimorfizmem i z twierdzenia 2.1 z wykładu 1. (patrz twierdzenie 2.1. wykład 1)

(2) Monoid przejść automatu skończonego jest skończony.

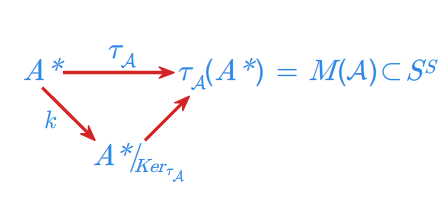

(3) Monoid przejść automatu \(\displaystyle \mathcal{A}\) jest izomorficzny z monoidem ilorazowym \(\displaystyle A^{*}/_{Ker_{\tau _{\mathcal{A}}}}\) .

Jest to wniosek z twierdzenia o rozkładzie epimorfizmu, które w tym przypadku ilustruje poniższy diagram.

Przykład 1.6.

Określimy monoid przejść dla automatu z przykładu 1.2 (patrz przykład 1.2.). Wypisujemy kolejne funkcje \(\displaystyle \tau _{\mathcal{A}}(w)\) dla \(\displaystyle w\in \{a,b\}^{*}\) . Zauważmy, że ze względu na występujące w tabelce powtórzenia, będące wynikiem równości, np. \(\displaystyle \tau _{\mathcal{A}}(b^2)=\tau _{\mathcal{A}}(b),\) nie ma potrzeby określać funkcji \(\displaystyle \tau _{\mathcal{A}}(b^{n})\) dla \(\displaystyle n\geq 3\) . Podobna obserwacja ma miejsce w innych przypadkach, co sprawia, że tabelka zawiera skończoną liczbę różnych funkcji.

Poniżej zamieszczamy algorytm obliczający monoid przejść dla automatu skończenie stanowego.

Algorytm WyznaczMonoidPrzejść - wyznacza monoid przejść dla automatu

Wejście: A=(S, A, f, s_0, T) - automat

Wyjście: M - monoid przejść dla \mathcal{A}

L <- emptyset; #L jest listą

M <- emptyset;

for each a in A cup {1} do

insert (L, {tau_A(a)}); # gdzie tau_A(a)(s)=f(s, a) dla każdego s in S

end for

while L not = emptyset; do

tau_A(w) <- first(L);

M <- M cup tau_A(w);

for each a in A do

for each s in S do

tau'_A(wa)(s)<- f(tau_A(w)(s),a);

end for

if tau'_A(wa) not in L cup M

insert (L, tau'_A(wa));

end if

end for

end while

return M;

Procedura insert\(\displaystyle (L, x)\) wkłada na koniec listy \(\displaystyle L\) element \(\displaystyle x\). Funkcja first\(\displaystyle (L)\) wyjmuje pierwszy element znajdujący się na liście \(\displaystyle L\) i zwraca go. Algorytm działa w następujący sposób: najpierw na listę \(\displaystyle L\) wkładane są elementy monoidu przejść \(\displaystyle \tau_{\mathcal{A}}(a)\) dla każdej litery \(\displaystyle a \in A \cup 1\). Te funkcje można obliczyć bezpośrednio z tabelki reprezentującej funkcję przejścia automatu \(\displaystyle \mathcal{A}\). Następnie z listy po kolei ściągane są poszczególne funkcje \(\displaystyle \tau_{\mathcal{A}}(w)\). Każda z nich dodawana jest do zbioru \(\displaystyle M\), a następnie algorytm sprawdza dla każdej litery \(\displaystyle a \in A\), czy funkcja \(\displaystyle \tau_{\mathcal{A}}(wa)\)

istnieje już na liście \(\displaystyle L\) lub w zbiorze \(\displaystyle M\). Jeśli nie, to funkcja ta dodawana jest do listy. Procedura powyższa trwa do czasu, gdy lista \(\displaystyle L\) zostanie pusta. Wtedy wszystkie elementy monoidu przejść

znajdą się w zbiorze \(\displaystyle M\).

Przeanalizujmy działanie algorytmu dla automatu z przykładu 1.2 (patrz przykład 1.2.).

Na początku na listę \(\displaystyle L\) włożone zostaną funkcje \(\displaystyle \tau_{\mathcal{A}}(1)\), \(\displaystyle \tau_{\mathcal{A}}(a)\) oraz \(\displaystyle \tau_{\mathcal{A}}(b)\). Z listy zdejmujemy funkcję \(\displaystyle \tau_{\mathcal{A}}(1)\) i dodajemy ją do zbioru \(\displaystyle M\). Ponieważ \(\displaystyle \forall a \in A\displaystyle \tau_{\mathcal{A}}(1a)=\tau_{\mathcal{A}}(a)\), a funkcje \(\displaystyle \tau_{\mathcal{A}}(a)\) oraz \(\displaystyle \tau_{\mathcal{A}}(b)\) znajdują się już na liście, zatem nie dodajemy ich do \(\displaystyle L\). Bierzemy kolejny element listy, \(\displaystyle \tau_{\mathcal{A}}(a)\), dodajemy go do \(\displaystyle M\) i obliczamy funkcje \(\displaystyle \tau_{\mathcal{A}}(aa)\) oraz \(\displaystyle \tau_{\mathcal{A}}(ab)\). Ponieważ \(\displaystyle \tau_{\mathcal{A}}(aa)\) nie jest tożsama z żadną funkcją ze zbioru \(\displaystyle L \cup M\), dodajemy ją do listy. Funkcja \(\displaystyle \tau_{\mathcal{A}}(ab)\) również nie jest równa żadnej z funkcji należących do zbioru \(\displaystyle L \cup M\), zatem wstawiamy ją na koniec listy. Na liście \(\displaystyle L\) mamy zatem teraz następujące elementy: \(\displaystyle \tau_{\mathcal{A}}(b)\), \(\displaystyle \tau_{\mathcal{A}}(a^2)\) oraz \(\displaystyle \tau_{\mathcal{A}}(ab)\). Zdejmujemy z listy funkcję \(\displaystyle \tau_{\mathcal{A}}(b)\), dodajemy ją do \(\displaystyle M\) i obliczamy \(\displaystyle \tau_{\mathcal{A}}(ba)\) oraz \(\displaystyle \tau_{\mathcal{A}}(bb)\). Pierwsza z tych funkcji jest nowa, tzn. nie jest tożsama z żadną funkcją ze zbioru \(\displaystyle L \cup M\) więc dodajemy ją na koniec listy. Druga z nich równa jest funkcji \(\displaystyle \tau_{\mathcal{A}}(b)\), więc nie dodajemy jej do listy. W tym momencie zbiór \(\displaystyle M\) zawiera następujące elementy: \(\displaystyle \tau_{\mathcal{A}}(1)\), \(\displaystyle \tau_{\mathcal{A}}(a)\), \(\displaystyle \tau_{\mathcal{A}}(b)\), natomiast lista zawiera elementy \(\displaystyle \tau_{\mathcal{A}}(a^2)\), \(\displaystyle \tau_{\mathcal{A}}(ab)\), \(\displaystyle \tau_{\mathcal{A}}(ba)\). Zdejmujemy z \(\displaystyle L\) funkcję \(\displaystyle \tau_{\mathcal{A}}(a^2)\), dodajemy ja do \(\displaystyle M\) i ponieważ \(\displaystyle \tau_{\mathcal{A}}(a^2a)=\tau_{\mathcal{A}}(a^2)\) i \(\displaystyle \tau_{\mathcal{A}}(a^2b)=\tau_{\mathcal{A}}(b)\), nic nie dodajemy do \(\displaystyle L\). Zdejmujemy teraz z listy funkcję \(\displaystyle \tau_{\mathcal{A}}(ab)\), dodajemy ją do \(\displaystyle M\) i ponieważ \(\displaystyle \tau_{\mathcal{A}}(aba)\) nie należy do \(\displaystyle L \cup M\) dodajemy ją do listy. \(\displaystyle \tau_{\mathcal{A}}(abb)=\tau_{\mathcal{A}}(b)\), więc tej funkcji nie dodajemy do \(\displaystyle L\). Z \(\displaystyle L\) ściągamy \(\displaystyle \tau_{\mathcal{A}}(ba)\), dodajemy ją do \(\displaystyle M\) i widzimy, że \(\displaystyle \tau_{\mathcal{A}}(baa)=\tau_{\mathcal{A}}(a^2)\) oraz \(\displaystyle \tau_{\mathcal{A}}(bab)=\tau_{\mathcal{A}}(b)\), więc nic nie dodajemy do \(\displaystyle L\). Na liście pozostała funkcja \(\displaystyle \tau_{\mathcal{A}}(aba)\). Ściągamy ją z listy i dodajemy do \(\displaystyle M\). Widzimy, że \(\displaystyle \tau_{\mathcal{A}}(abaa)=\tau_{\mathcal{A}}(a^2)\) i \(\displaystyle \tau_{\mathcal{A}}(abab)=\tau_{\mathcal{A}}(b)\), zatem nic nie dodajemy do listy \(\displaystyle L\). Lista jest w tym momencie pusta i działanie algorytmu zakończyło się. Ostatecznie mamy

co zgadza się z wynikiem otrzymanym w przykładzie.

Twierdzenie poniższe zbiera dotychczas uzyskane charakteryzacje języków rozpoznawanych.

Twierdzenie 1.2.

Niech \(\displaystyle \; L \subset A^* \;\) będzie dowolnym językiem. Równoważne są następujące warunki:

- (1) Język \(\displaystyle \; L \;\) jest rozpoznawalny,

- (2) Język \(\displaystyle \; L \;\) jest sumą wybranych klas równoważności pewnej prawej kongruencji \(\displaystyle \rho\) na \(\displaystyle \; A^* \;\) o skończonym indeksie: \(\displaystyle L = \bigcup_{w\in L}[w]_\rho.\)

- (3) Język \(\displaystyle \; L \;\) jest sumą wybranych klas równoważności pewnej kongruencji \(\displaystyle \rho\) na \(\displaystyle \; A^* \;\) o skończonym indeksie: \(\displaystyle L = \bigcup_{w\in L}[w]_\rho.\)

- (4) Istnieje skończony monoid \(\displaystyle \; M \;\) i istnieje epimorfizm \(\displaystyle \varphi : A^* \longrightarrow M\) taki, że \(\displaystyle L = \varphi^{-1}(\varphi (L)).\)

Dowód

Dowód równoważności czterech powyższych warunków przeprowadzimy zgodnie z następującym schematem:

\(\displaystyle 4 \Longrightarrow 3\)

Dany jest homomorfizm

gdzie \(\displaystyle M\) jest skończonym monoidem.

Określamy relację \(\displaystyle \; \rho \;\) na \(\displaystyle A^*\), przyjmując dla dowolnych \(\displaystyle u, v \in A^*\)

Tak określona relacja jest kongruencją. Natomiast jej skończony indeks wynika z faktu, że monoid \(\displaystyle \; M \;\) jest skończony. Pokażemy teraz, że:

Inkluzja \(\displaystyle \; \subseteq \;\) jest oczywista.

Inkluzja w przeciwną stronę (\(\displaystyle L \supseteq \bigcup_{w\in L}[w]_\rho,\)) oznacza, że każda klasa równoważności relacji

\(\displaystyle \; \rho \;\) albo cała zawiera się w języku \(\displaystyle L\), albo cała zawiera się w uzupełnieniu języka \(\displaystyle L\).

Załóżmy, że \(\displaystyle \; u \in [w]_\rho\) dla pewnego \(\displaystyle w \in L. \;\)

Oznacza to, że

Implikuje to ostatecznie, że \(\displaystyle u \in L\).

\(\displaystyle 3 \Longrightarrow 2\)

Każda kongruencja jest prawą kongruencją.

\(\displaystyle 2 \Longrightarrow 1\)

Niech \(\displaystyle \; \rho \;\) będzie prawą kongruencją o skończonym indeksie na \(\displaystyle \; A^* \;\) taką, że

Automat \(\displaystyle \mathcal{A}_{\rho } \displaystyle = (A^*/\rho,f^*,[1]_\rho,T),\) dla którego

akceptuje język \(\displaystyle L\).

\(\displaystyle 1 \Longrightarrow 4\)

Niech język \(\displaystyle \; L=L(\mathcal{A}) \;\), gdzie \(\displaystyle \mathcal{A} \displaystyle = (S,f,s_0,T)\).

Określamy odwzorowanie

przyjmując dla każdego \(\displaystyle v\in A^{*}\)

Jest to odwzorowanie kanoniczne monoidu \(\displaystyle \; A^* \;\) na monoid ilorazowy, a więc jest to epimorfizm.

\(\displaystyle A^{*}/_{Ker\tau _{\mathcal{A}}}\) jest monoidem skończonym, ponieważ \(\displaystyle \; S \;\) jest zbiorem skończonym.

Dla dowodu równości \(\displaystyle L = \varphi^{-1}(\varphi (L))\) wystarczy udowodnić

inkluzję \(\displaystyle L \supset \varphi^{-1}(\varphi (L))\). (Inkluzja \(\displaystyle \; L \subseteq \varphi^{-1}(\varphi (L))\;\)

wynika z definicji przeciwobrazu.)

Niech \(\displaystyle \; u \in \varphi^{-1}(\varphi (L)) .\;\) Oznacz to, że

W szczególności

czyli \(\displaystyle u \in L. \)

Wyrażenia regularne. Automat minimalny

W tym wykładzie określimy rodzinę języków regularnych wolnego monoidu \(A^{*}\) oraz pewien formalny opis tych języków zwany wyrażeniami regularnymi.

Dla języka rozpoznawalnego \(L\) wprowadzimy pojęcie automatu minimalnego rozpoznającego \(L\) i prawej kongruencji syntaktycznej, która odgrywa istotną rolę w problemach związanych z automatem minimalnym.

Wyrażenia regularne

Definicja 1.1

Niech \(A\) będzie skończonym alfabetem. Rodzina \(\mathcal{REG}(A^{*})\) języków regularnych nad alfabetem \(A\) to najmniejsza, w sensie inkluzji, rodzina \(\mathcal{R}\) języków zawartych w \(A^*\) taka, że:

- (1) \(\emptyset \in\mathcal{R}\), \(\forall a \in A \;\;\; \{ a \} \in\mathcal{R}\)

- (2) jeśli \(X, Y \in\mathcal{R}\), to \(X \cup Y, \;\; X \cdot Y \;\; \in\mathcal{R}\)

- (3) jeśli \(X \in\mathcal{R}\), to \(X^* = \bigcup_{n=0} ^\infty X^n \in\mathcal{R}\)

Wprost z definicji wynika, że \(\left\{ 1\right\} =\emptyset ^{*}\in \mathcal{R}\) oraz że dla dowolnego języka regularnego zachodzi równość \(X\in \mathcal{R}\) jest

Wprowadzona w ten sposób definicja rodziny języków regularnych wymaga uzasadnienia faktu, iż definiowany obiekt, definiowana rodzina, istnieje. Zauważmy więc, że warunki 1-3 definicji 1.1 (patrz definicja 1.1.) spełnia na przykład rodzina \(\mathcal{P}(A^{*})\) wszystkich podzbiorów \(A^*\), a zatem klasa takich rodzin nie jest pusta. Ponadto łatwo możemy stwierdzić, że jeśli rodziny \(\mathcal{R}_{1},\: \mathcal{R}_{2}\) spełniają warunki 1-3 powyższej definicji, to rodzina \(\mathcal{R}_{1}\cap \mathcal{R}_{2}\) również spełnia te warunki. Stąd możemy wyprowadzić wniosek, że najmniejsza rodzina spełniającą te warunki, to przecięcie

po wszystkich rodzinach \(\mathcal{R}\) spełniających warunki 1-3 definicji 1.1. (patrz definicja 1.1.)

Zauważmy, że w świetle powyższej definicji fakt, że \(X \in\mathcal{REG}(A^{*})\) oznacza, że \(X\) można uzyskać z liter alfabetu i zbioru pustego \(\emptyset\) poprzez zastosowanie wobec tych "elementarnych klocków" skończonej liczby działań: sumy, katenacji i gwiazdkowania. Na odwrót, każdy zbiór otrzymany w ten sposób jest elementem rodziny \(\mathcal{REG}(A^{*})\). Ta obserwacja prowadzi do pojęcia wyrażeń regularnych, formalnego zapisu języków regularnych.

Definicja 1.2

Niech \(A\) będzie alfabetem, a zbiór \(\{+ , \star , \emptyset , (,)\}\) alfabetem rozłącznym z \(A\). Słowo \({\bf \alpha} \in {\bf (}A \cup \{ + , \star , \emptyset , (,)\}{\bf )}^*\) jest wyrażeniem regularnym nad alfabetem \({A}\) wtedy i tylko wtedy, jeśli:

- (1) \({\bf \alpha} = \emptyset\)

- (2) \({\bf \alpha} = a \in A \;\; ({\bf \alpha}\) jest literą)

- (3) \({\bf \alpha}\) jest w postaci \(({\bf \beta} + {\bf \gamma}), ({\bf \beta} {\bf \gamma} ), {\bf \gamma} ^*\), gdzie \({\bf \beta}, {\bf \gamma}\)są wyrażeniami regularnymi nad alfabetem \(A\).

Przyjmujemy oznaczenia:

Rodzinę wyrażeń regularnych nad alfabetem \(A\) oznaczamy symbolem \(\mathcal{WR}\). Łatwo zauważyć związek pomiędzy wyrażeniami regularnymi oraz wprowadzoną wcześniej rodziną \(\mathcal{REG}(A^{*})\), regularnych języków wolnego monoidu \(A^{*}\). Związek ten ustala poniższa definicja.

Definicja 1.3

Wartościowaniem wyrażenia regularnego nazywamy odwzorowanie

określone następująco:

- (1) \(\mid \emptyset \mid = \emptyset\)

- (2) \(\mid a \mid = \{ a \}\)

- (3) \(\mid ({\bf \alpha} + {\bf \beta})\mid = \mid {\bf \alpha} \mid \cup \mid {\bf \beta} \mid\)

\(\mid ({\bf \alpha} {\bf \beta}) \mid = \mid {\bf \alpha} \mid \cdot \mid {\bf \beta} \mid\)

\(\mid {\bf \alpha}^* \mid = \mid {\bf \alpha} \mid ^*\)

Odwzorowanie określające wartość wyrażenia regularnego nie jest, jak można zauważyć, iniekcją. Oznacza to, że różne wyrażenia regularne mogą mieć tę samą wartość, czyli określać ten sam język regularny. Prostym przykładem tego faktu są wyrażenia regularne \(a^*\) oraz \((a^*)^*\). Zwróćmy uwagę na wartość wyrażenia regularnego oznaczonego symbolem \(1\).

Jest mianowicieWprowadza się następującą relację równoważności w rodzinie wyrażeń regularnych.

Definicja 1.4

Wyrażenia regularne \({\bf \alpha} , {\bf \beta}\) nazywamy równoważnymi i oznaczamy \({\bf \alpha} = {\bf \beta}\), jeśli \(\mid {\bf \alpha} \mid = \mid {\bf \beta} \mid\).

Problem równoważności wyrażeń regularnych jest rozstrzygalny i jest PSPACE-zupełny. Wrócimy do tego problemu w kolejnych wykładach.

Oto przykłady równoważnych wyrażeń regularnych

gdzie \(\alpha ,\alpha _{1},\alpha _{2},\alpha _{3}\in \mathcal{WR}\).

Wprost z definicji wyrażenia regularnego wynika następujaca równoważność:

Fakt 1.1

\(L\in \mathcal{REG}(A^{*}) \Longleftrightarrow L = \mid {\bf \alpha} \mid\) dla pewnego \({\bf \alpha} \in\mathcal{WR}\).

Wyrażenia regularne dają bardzo wygodne narzędzie zapisu języków należących do rodziny \(\mathcal{REG}(A^{*})\).

Np. język nad alfabetem \(\{ a,b\}\) złożony ze wszystkich słów zaczynających się lub kończących na literę \(a\) zapisujemy jako \(a(a+b)^* +(a+b)^*a\).

Z kolei wyrażenie regularne \(a^+ b^+\) oznacza język \(L=\{a^nb^m : n,m\geq 1\}\).

Dla dalszego uproszczenia zapisu przyjmiemy w naszym wykładzie następującą umowę. Jeśli język \(L\) jest wartością wyrażenia regularnego \(\alpha\), czyli \(L= \mid \alpha \mid\), to będziemy zapisywać ten fakt jako \(L= \alpha\). Będziemy zatem mówić w dalszym ciągu wykładu o języku \(\alpha\). Z tych samych powodów, dla dowolnego alfabetu \(A=\{a_1,.....,a_n\}\) będziemy używać zapisu \(A\) w miejsce \(a_1 +.....+a_n\).

Zauważmy na koniec rozważań o wyrażeniach regularnych, że dość prosty w zapisie język \(L=\{a^nb^n : n\geq 1\}\) nie należy do rodziny \(\mathcal{REG}(A^{*})\) i nie można go zapisać przy pomocy wyrażeń regularnych.

Kończąc ten fragment wykładu poświęcony wyrażeniom regularnym warto wspomnieć o problemie "star height", czyli głębokości zagnieżdżenia gwiazdki w wyrażeniu regularnym. Mając wyrażenia regularne \(\alpha ,\alpha _{1},\alpha _{2}\in \mathcal{WR}\) głębokość zagnieżdżenia gwiazdki definiuje się jako liczbę \(sh(\alpha )\) równą \(0\), gdy \(\alpha\) jest literą z alfabetu lub zbiorem pustym, równą \(max\{i,j\},\) gdy \(\alpha =\alpha _{1}\cup \alpha _{2}\) lub \(\alpha =\alpha _{1}\cdot \alpha _{2}\) i \(sh(\alpha _{1})=i\), \(sh(\alpha _{2})=j\) oraz równą \(i+1\) dla \(\alpha =(\alpha _{1})^{*}\). Głębokość zagnieżdżenia gwiazdki dla języka regularnego \(L\) określa się jako najmniejszą liczbę \(sh(L)=sh(\alpha )\), gdzie \(\alpha\) jest wyrażeniem regularnym reprezentującym język \(L\). Głębokość zagnieżdżenia gwiazdki jest więc jakby miarą złożoności pętli występujących w automacie rozpoznającym język \(L\). Ustalono, że dla alfabetu złożonego z jednej litery głębokość zagnieżdżenia gwiazdki jest równa co najwyżej 1 oraz że dla alfabetu o co najmniej dwóch literach dla dowolnej liczby \(k\in \Bbb N\) można wskazać język regularny \(L\) taki, że \(sh(L)=k\). Problemem otwartym pozostaje określenie algorytmu określającego głębokość zagnieżdżenia gwiazdki dla dowolnego języka w klasie języków regularnych.

Prawa kongruencja syntaktyczna i kongruencja syntaktyczna

Opis języka regularnego za pomocą wyrażeń regularnych jest bardzo wygodny, ale nie jedyny. W kolejnych wykładach będziemy wprowadzać inne reprezentacje języków regularnych, takie jak automaty czy gramatyki. Pojęcia, które wprowadzimy teraz, są również narzędziami dla opisu i badań własności języków regularnych. W szczególności służą do konstrukcji możliwie najprostszego automatu rozpoznającego dany język regularny, zwanego automatem minimalnym.

Definicja 2.1.

Niech \(\; L \subset A^* \;\) będzie dowolnym językiem. W monoidzie \(\; A^* \;\) wprowadzamy następujące dwie relacje:

- (1) prawą kongruencję syntaktyczną \(\; P_L^r , \;\) przyjmując

dla dowolnych słów \(u, v \in A^*\)

\(u \; P_L^r \; v \;\;\) wtedy i tylko wtedy, gdy spełniony jest warunek\(\forall w \in A^* \;\; uw \in L \; \Leftrightarrow \; vw \in L,\)

- (2) kongruencję syntaktyczną \(\; P_L , \;\) przyjmując

dla dowolnych \(u, v \in A^*\)

\(u \; P_L \; v \;\;\) wtedy i tylko wtedy, gdy spełniony jest warunek\(\forall w_1, w_2 \in A^* \;\; w_1uw_2 \in L \; \Leftrightarrow \; w_1vw_2 \in L.\)

Łatwo stwierdzić, że nazwy wprowadzonych relacji pokrywają się z ich własnościami, to znaczy relacja \(P_L^r\) jest rzeczywiście prawą kongruencją, a \(P_L\) kongruencją.

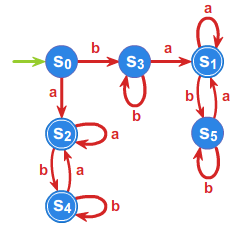

Przykład 2.1.

Niech \(A=\{ a,b\}\) będzie alfabetem.

- (1)Dla języka \(L=a^+b^+\) relacja

- (a) \(P_L^r\) ma \(4\) klasy równoważności: \(\;\;L, \;\;A^*baA^*+b^+,\;\; a^+, \;\;1\),

- (b) \(P_L\) ma \(5\) klas równoważności: \(L, \;\;A^*baA^*,\;\;b^+,\;\; a^+, 1\).

- (2) Dla języka \(L=\{a^nb^n : n\geq 1\}\) obie relacje mają nieskończony indeks

- (a) dla \(P_L^r\) klasami równoważności są zbiory

\(L_i =\{a^nb^{n-i} : n\geq i,n \geq 1\}\) dla \(i \in \mathbb{N}_0\), \(A^* \setminus\bigcup_{i=0}^\infty L_i\).

- (a) dla \(P_L^r\) klasami równoważności są zbiory

- (b) dla \(P_L\) klasami równoważności są zbiory

\(L_i =\{a^nb^{n-i} : n\geq i,n \geq 1\}\) dla \(i \in \mathbb{N}_0\),

\(L'_i =\{a^{n-i}b^n : n\geq i,n \geq 1\}\) dla \(i \in \mathbb{N}\),

\(A^* \setminus[\bigcup_{i=1}^\infty (L_i\cup L'_i )\cup L_0 ]\).

- (b) dla \(P_L\) klasami równoważności są zbiory

Udowodnimy następujące własności relacji \(\; P_L^r \;\) oraz \(\; P_L \;\).

Twierdzenie 2.1.

Prawa kongruencja syntaktyczna \(\; P_L^r \;\) jest największą w sensie inkluzji spośród wszystkich

prawych kongruencji \(\rho\) takich, żeKongruencja syntaktyczna \(\; P_L \;\) jest największą w sensie inkluzji spośród wszystkich

kongruencji \(\rho\) takich, żeDowód

Dowód przeprowadzimy dla prawej kongruencji syntaktycznej. Uzasadnienie tezy dla kongruencji \(\; P_L \;\) przebiega podobnie. Niech \(\;\rho \;\) będzie dowolną prawą kongruencją spełniającą założenia i niech \(u\rho v\). Zatem dla każdego \(w\in A^{*}\) jest

W konsekwencji \(\rho \subseteq P_L^r.\) W

szczególności więc dla dowolnego \(u \in A^*\) ma miejsce inkluzja \([u]_\rho \; \subseteq \; [u]_{P_L^r}.\) Zatem \(L\subset \bigcup _{w\in L}[w]_{P^{r}_{L}}\).

Aby udowodnić inkluzję w stronę przeciwną ustalmy dowolne \(\; u \in L \;\) i niech \(v \in [u]_{P_L^r}.\)

Przyjmując \(\; w =1 \;\) w definicji (patrz definicja 2.1.) relacji \(\; {P_L^r} \;\) otrzymamy równoważność

\(\; u \in L \; \Leftrightarrow \; v \in L \;.\) A więc \(\; v \in L \;.\)

Wniosek 2.1.

Jeśli język \(L\) jest regularny, to relacja \(\; P_L^r \;\) jest największą w sensie inkluzji spośród wszystkich prawych kongruencji takich, że język \(L\) jest sumą jej pewnych klas równoważności, a relacja \(\; P_L \;\) jest największą w sensie inkluzji spośród wszystkich kongruencji spełniających analogiczny warunek. Obie relacje mają skończony indeks, czyli dzielą wolny monoid \(A^*\) na skończoną liczbę klas równoważności.

Pojęcie, które wprowadzimy teraz - monoid syntaktyczny języka - wiąże teorię języków formalnych, a w szczególności teorię języków rozpoznawalnych, z teorią półgrup. Związek ten stanowi podstawę dla bardziej zaawansowanych problemów teorii języków i automatów wykraczających poza ramy tego wykładu.

Definicja 2.2.

Niech \(\; L \subset A^* \;\) będzie dowolnym językiem. Monoidem syntaktycznym języka \(\; L \;\) nazywamy strukturę ilorazową

Dualnie, tworząc iloraz \(S(L) = A^+/P_L\), wprowadza się pojęcie półgrupy syntaktycznej języka \(\; L \;\). Oba wprowadzone tu pojęcia zilustrowane będą w trakcie dalszych rozważań.

Automat minimalny

Określenie języka rozpoznawalnego postuluje istnienie automatu o skończonej liczbie stanów, działającego w odpowiedni sposób. Należałoby zatem wskazać algorytm budowy takiego automatu dla języka rozpoznawalnego. Oczywiście interesuje nas algorytm prowadzący do automatu o możliwie najprostszej postaci. Najprostsza postać, w tym kontekście, oznacza najmniejszą liczbę stanów.

Definicja 3.1.

Automat \(\mathcal{A} = (S,A,f,s_0,T)\) rozpoznający język \(L\) nazywamy automatem minimalnym, jeśli posiada najmniejszą liczbę stanów spośród wszystkich automatów rozpoznających język \(L.\)

Kwestią istnienia takiego automatu minimalnego zajmujemy się teraz. W kolejnym wykładzie przedstawimy algorytmy konstrukcji automatu minimalnego.

W poniższym twierdzeniu występuje automat ilorazowy \({A}_{P^{r}_{L}}\) określony przez prawą kongruencję \(P_L^r\).

Twierdzenie 3.1.

Dla dowolnego automatu \({A} = (S,A,f,s_0,T) \;\) rozpoznającego język \(\; L \subset A^* \;\) istnieje jedyny epimorfizm \(\varphi :\mathcal{A}\longrightarrow \mathcal{A}_{P^{r}_{L}}\) taki, że \(\varphi (s_{0})=[1]_{P^{r}_{L}}.\)

Dowód

Prawa kongruencja automatowa \(\sim _{\mathcal{A}}\) ma skończony indeks i \(L=\bigcup _{u\in L}[u]_{\sim _{\mathcal{A}}}\). Zatem z twierdzenia (patrz Twierdzenie 2.1.) wynika, że

Istnienie epimorfizmu \(\; \varphi \;\) wynika z twierdzenia 1.1, wykład 3. Epimorfizm ten określony jest dla dowolnego stanu \(s\in S\) równością \(\varphi(s) = f^*([1]_{P_L^r},w) = [w]_{P_L^r},\) gdzie \(w\) jest słowem takim, że \(f(s_0,w)=s\).

Jest to jedyny epimorfizm spełniający warunki tezy dowodzonego twierdzenia. Dla każdego epimorfizmu \(\; \psi \;\) takiego, że \(\psi :\mathcal{A}\longrightarrow \mathcal{A}_{P^{r}_{L}}\) i \(\psi (s_{0})=[1]_{P^{r}_{L}}\) mamy\(\;\forall s \in S\)

gdzie \(f(s_0,w) = s .\) Tak więc \(\; \psi = \varphi .\)

Zatem udowodnione twierdzenie zapewnia nas o istnieniu automatu minimalnego, co formułujemy w następującym wniosku.

Wniosek 3.1.

Niech \(\; L \subset A^* \;\) będzie dowolnym językiem. Automat

gdzie \(\; T = \{ [w]_{P_L^r} \; : \; w \in L \}, \;\) jest automatem minimalnym rozpoznającym język \(\; L \;\). Oznaczać go będziemy symbolem \(\mathcal{A}_{L}\).

Następne twierdzenie charakteryzuje monoid przejść automatu minimalnego i podaje kolejny warunek równoważny na to, żeby język \(L\) był rozpoznawany przez automat.

Twierdzenie 3.2.

Niech \(L\subset A^{*}\) będzie dowolnym językiem.

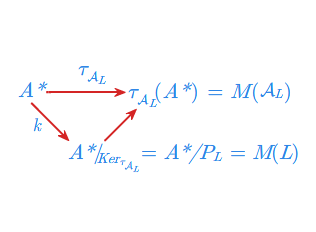

- 1. Dla dowolnego języka \(L\in \mathcal{REC}(A^{*})\) monoid przejść automatu minimalnego \(\mathcal{A}_{L}\) jest izomorficzny z monoidem syntaktycznym \(M(L)\) języka \(L\), czyli

- 2. (tw. J.Myhill'a) Język \(\; L \subset A^* \;\) jest rozpoznawalny wtedy i tylko wtedy, gdy \(\; M(L) \;\) jest monoidem skończonym.

Dowód

Dla dowodu punktu 1 wykażemy, że

gdzie zgodnie z definicją dla dowolnych \(w,u\in A^{*}\)

Korzystamy teraz z twierdzenia o rozkładzie epimorfizmu, które w tym przypadku ma postać:

czyli \(M(\mathcal{A}_{L})\sim M(L)\).

Dla dowodu punktu 2 załóżmy, że język \(\; L \;\) jest rozpoznawalny.

Zatem

Z twierdzenia (patrz twierdzenie 2.1.) wnioskujemy, że \(\rho \subseteq P_L .\) Oznacza to, że indeks relacji \(\; P_L \;\) jest niewiększy od indeksu \(\; \rho, \;\) a co za tym idzie, \(\; M(L) = A^*/P_L \;\) jest monoidem skończonym.

Dla dowodu implikacji w stronę przeciwną rozważmy epimorfizm kanonicznyrówność

Z twierdzenia 3.1 (patrz twierdzenie 3.1.) wynika, że określenie klas abstrakcji prawej kongruencji syntaktycznej \(P^r_L\) prowadzi do określenia minimalnego automatu rozpoznającego język \(L\). Prezentowane poniżej twierdzenia wskazują sposób konstrukcji prawej kongruencji syntaktycznej dla języka \(L\).

Twierdzenie 3.3.

Niech \(\; L \subset A^* \;\) będzie dowolnym językiem,

a \(\; \Theta_L \subset A^* \times A^* \;\) relacją

równoważności o dwóch klasach równoważności \(L\) i \(A^* \setminus L\).

Przez \(\; \rho_i \;\) dla \(\; i \in {\Bbb N}\) oznaczmy zstępujący ciąg relacji określony następująco:

\(\rho_1 = \Theta_L ,\;\;\) a dla \(\; i = 2,...\) przyjmijmy

\(\rho_i = \{ (u,w) \in \; A^* \times A^* \; : \; (ua,wa) \in \; \rho_{i-1} \;\;\; \forall a \in A \cup \{1\}\}.\)

Wtedy \(\;\; \bigcap \rho_i = P_L^r \;\;\).

Dowód

Na początku uzasadnimy, że \(\; \bigcap \rho_i \;\) jest prawą kongruencją na \(\; A^*\). Załóżmy więc, że słowa \(\; x , y \in A^* \;\) są w relacji \(x \; \bigcap \rho_i \;y \;\). Wybierzmy dowolne słowo \(z\in A^{*}\) i niech \(k\) oznacza długość tego słowa. Z założenia wynika, iż \(x\, \rho _{i+k}\, y\), co w świetle definicji ciągu relacji \(\rho _{i}\) implikuje, że \(xz\: \rho _{i}\: yz.\) Ponieważ \(i\) jest dowolne wnioskujemy ostatecznie, że \(xz \; \bigcap \rho_i \; yz \;,\) co kończy dowód faktu, że \(\; \bigcap \rho_i \;\) jest prawą kongruencją.

Dowiedziemy teraz równościDla uzasadnienia inkluzji \(\bigcap \rho_i \;\subseteq\; P_L^r\) zauważmy, że jeśli \(x \; \bigcap \rho_i \; y ,\) to dla dowolnego \(z\in A^{*}\) mamy \(xz \; \bigcap \rho_i \; yz\), a w szczególności \(xz \; \rho_1 \; yz.\) Z definicji relacji \(\rho _{1}\) dla dowolnego \(z\in A^{*}\) prawdziwa jest równoważność

A więc \(x \;\; P_L^r \;\; y\). Inkluzję w stronę przeciwną pokażemy, dowodząc indukcyjnie ze względu na \(i=1,2,...,\) że dla dowolnych \(\;x , y \in A^* \;\) prawdziwa jest następująca implikacja

Załóżmy zatem, że \(x \;\; P_L^r \;\; y.\) Z definicji \(\; P_L^r \;\) wynika, że dla dowolnego \(z \in A^*\) prawdziwa jest równoważność

Przyjmując \(\; z=1 \;\) otrzymujemy żądaną własność dla \(\rho _{1}.\) Załóżmy teraz, że prawdziwa jest implikacja

dla \(i = 1,...,n-1\) oraz dla dowolnych \(x , y \in A^*.\) Stąd, że \(P_L^r\) jest prawą kongruencją, wnioskujemy, że dla dowolnego \(\; a \in A \cup \{1\} \;\) spełniona jest relacja \(xa \;\; P_L^r \;\; ya.\) Korzystając z założenia indukcyjnego, mamy \(xa \;\; \rho_{n-1} \;\; ya\) dla dowolnego \(\; a \in A \cup \{1\} \;\). A to oznacza z definicji \(\; \rho_i \;\), że \(x \;\; \rho_n \;\;y\) i kończy dowód.

Kolejne twierdzenie charakteryzuje relację \(P^r_L\) dla języka rozpoznawalnego i orzeka, iż w przypadku języka rozpoznawalnego ciąg relacji \(\rho_i\), aproksymujacych \(P^r_L\), jest skończony. Równoważność dwóch pierwszych warunków poniższego twierdzenia nazywana bywa często w literaturze twierdzeniem A.Nerode.

Twierdzenie 3.4.

Następujące warunki są równoważne:

- (1) Język \(L\) jest rozpoznawalny.

- (2) Relacja \(P^r_L\) ma skończony indeks.

- (3) Ciąg relacji \(\rho_i\) stabilizuje się, co oznacza, że istnieje \(i\in {\Bbb N}\) takie, że

\(\rho_i = \rho_{i+1}=....\) Dla najmniejszego takiego \(i\) prawdziwa jest równość \(\rho_i = P^r_L.\)

Dowód

Dowód poprowadzimy według następujacego schematu:

\(1 \Longrightarrow 2\)

\(P^r_L\) jest największą w sensie inkluzji relacją spełniająca warunki punktu 2 z twierdzenia 1.3 z wykładu 3 (patrz twierdzenie 1.2 wykład 3). Z tego samego twierdzenia wynika skończoność indeksu.

\(1 \Longleftarrow 2\)

Relacja \(P^r_L\) jest prawą kongruencją, ma skończony indeks oraz

Z twierdzenia 1.2 z wykładu 3 (patrz twierdzenie 1.2 wykład 3) wynika więc, że język \(L\) jest rozpoznawalny.

\(2 \Longrightarrow 3\) Dowód poprowadzimy nie wprost. Załóżmy więc, że dla każdego \(i\in {\Bbb N}\) jest \(\rho_i \neq \rho_{i+1}.\) Oznacza to, że dla każdego \(i\in {\Bbb N}\) indeksy relacji \(\rho _{i}\) tworzą ciąg silnie rosnący, to znaczy spełniają zależność \(ind\rho_i < ind\rho_{i+1}.\) Ponieważ \(ind\rho_1 = 2,\) to dla każdego \(i\in {\Bbb N}\) prawdziwa jest nierówność \(ind\rho_i > i.\) A to prowadzi do wniosku, że dla dowolnego \(i\in {\Bbb N}\)

Zatem indeks relacji \(P^r_L\) jest nieskończony, co jest sprzeczne z założeniem.

\(2 \Longleftarrow 3\)

Udowodnimy indukcyjnie ze względu na \(j\), że każda z relacji \(\rho_j\) dla \(j=1,...,i\) ma skończony indeks. Oczywiście \(ind\rho_1 = 2.\) Załóżmy teraz, że relacja \(\rho_j\) ma skończony indeks. Z definicji relacji \(\rho_{j+1}\) wynika, że jej klasy równoważności powstają przez podział klas równoważności \([w]_{\rho_j}\) na skończoną liczbę klas relacji \(\rho_{j+1}\) (skończona jest liczba możliwych do spełnienia warunków prowadzących do podziału). Oznacza to, że indeks relacji \(\rho_{j+1}\) jest również skończony, a więc relacja \(P^r_L\) ma również skończony indeks.

Wykorzystamy powyżej udowodnione własności do konstrukcji automatu minimalnego rozpoznającego język \(L\). Warto zauważyć, iż punktem wyjścia dla tej konstrukcji jest język \(L\) zadany, na przykład, poprzez wyrażenie regularne.

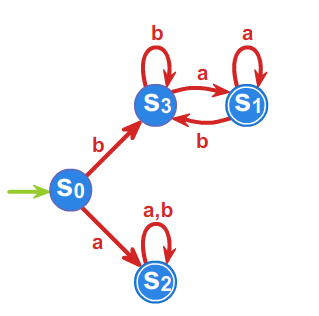

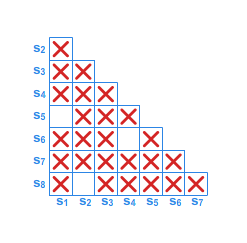

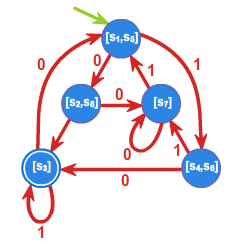

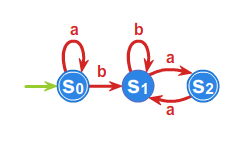

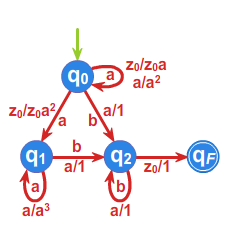

Przykład 3.1.

Niech do języka \(L\) należą wszystkie słowa nad alfabetem \(A=\{a,b\}^*\) zaczynające się lub kończące literą \(a\). Skonstruujemy minimalny automat akceptujący język \(L\).

- \(\rho _{1}:\) \(L=aA^* +A^* a,\;\; A^{*}\setminus L =bA^*b +b+1\)

- \(\rho _{2}:\) \(aA^*a+a,\;\; bA^*a, \;\; bA^*b +b+1,\)

- \(\rho _{3}:\) \(aA^*a+a,\;\; bA^*a, \;\; bA^*b +b, \;\;1,\)

Ponieważ \(\rho _{3}=\rho _{4}\), to \(P^r_L=\rho _{3}\) i automat minimalny ma \(4\) stany.

Przyjmujemy \(s_0 =[1]\), \(s_1=bA^*a\), \(s_2=aA^*a+a\), \(s_3=bA^*b +b\)

oraz \(T=\{s_1,s_2\}\), a automat minimalny \(\mathcal{A}_{L}=\left( A^{*}/_{\rho _{3}},f^{*},s_{0},T\right)\)

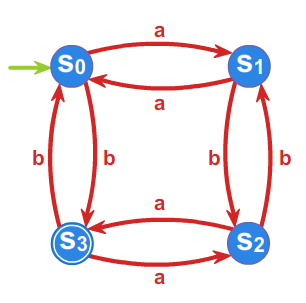

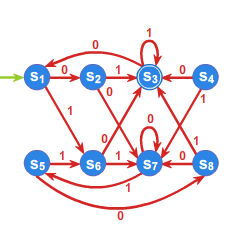

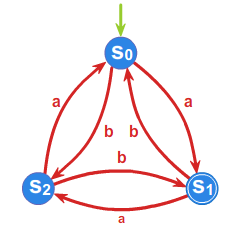

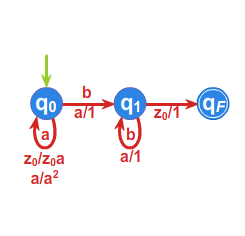

Przykład 3.2.

Dla języka \(L=\left\{ w \in \{ a,b\}^* :\#_a w =2k, \#_b w =2l+1 ,\; k,l\geq 0 \right\}\) określimy ciąg relacji \({\rho}_i\), a

następnie relację \(P^{r}_{L}\). Umożliwi nam to, w świetle

powyższych rozważań, zbudowanie automatu minimalnego rozpoznającego

ten język. Poniżej wypisane są klasy równoważności relacji \(\rho _{1}\) oraz \(\rho _{2}\), \(\rho _{3}=\rho _{2}\), co

kończy proces obliczania relacji \(\rho _{i}\) i daje równość \(\rho _{2}=P^{r}_{L}\).

- \(\rho _{1}:\) \(L, A^{*}\setminus L\)

- \(\rho _{2}:\) \(L, L_1, L_2, L_3\), gdzie

\(L_1=\left\{ w \in \{ a,b\}^* :\#_a w =2k, \#_b w= 2l, \; k,l\geq 0 \right\},\)

\(L_2\left\{ w \in \{ a,b\}^* :\#_a w =2k+1, \#_b w= 2l+1, \; k,l\geq 0 \right\},\)

\(L_3=\left\{ w \in \{ a,b\}^* :\#_a w =2k+1, \#_b w= 2l, \; k,l\geq 0 \right\},\)

Przyjmując \(s_0 =L_1=[1]\), \(s_1=L_3\), \(s_2=L_2\), \(s_3=L\) oraz \(T=\{s_3\}\)

automat minimalny \(\mathcal{A}_{L}=\left( A^{*}/_{\rho _{2}},f^{*},s_{0},T\right)\) przedstawiony jest przy pomocy grafu:

Powyższe twierdzenia podają również sposób konstrukcji monoidu syntaktycznego języka \(L\).

Algorytmy konstrukcji automatu minimalnego

W tym wykładzie podamy algorytmy konstrukcji automatu minimalnego i twierdzenia dowodzące ich poprawności.

Algorytmy konstrukcji automatu minimalnego

Dla języka rozpoznawanego \(L\) konstrukcję automatu minimalnego można rozpocząć, startując z opisu języka danego na przykład przez wyrażenie regularne lub też jakiegoś automatu rozpoznającego ten język. W niniejszym wykładzie przedstawimy algorytmy konstrukcji automatu minimalnego obejmujące oba wspomniane punkty startu. Jako pierwszy, nawiązując do rezulatów przedstawionych w poprzednim wykładzie, prezentujemy algorytm, dla którego punktem wyjścia jest język \(L\). Prezentację poprzedzimy wprowadzeniem pewnej operacji na słowach zwanej pochodną J.Brzozowskiego.

Definicja 1.1.

Niech \(\; L \subset A^* \;\) będzie dowolnym językiem, a \(\; u \in A^* \;\) dowolnym słowem. Pochodną Brzozowskiego (residuum) z języka \(L\) względem słowa \(u\) nazywamy język

Podczas obliczeń pochodnych Brzozowskiego (residuów języka \(L\)) można wykorzystać poniższe równości.

Niech \(L_1, L_2\subset A^* \;\) będą dowolnymi językami, \(a \in A\) dowolną literą, a \(u,v \in A^*\) dowolnymi słowami. Prawdziwe są następujące równości:

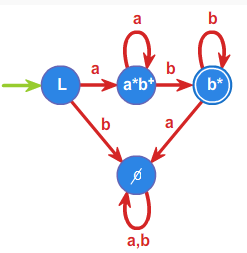

Przykład 1.1.

Obliczmy wszystkie pochodne dla języka \(L=a^+b^+\). Okazuje się, że są tylko cztery różne pochodne liczone względem \(a\), \(b\), \(ab\) i słowa pustego \(1\). Mianowicie:

\(a^{-1}L=a^*b^+\),

\(b^{-1}L= \emptyset\),

\(ab^{-1} L=b^*\),

\(1^{-1}L=L\).

Dla wszystkich innych słów otrzymujemy uzyskane powyżej języki, co wynika z własności pochodnych (patrz wyżej wypisane równości) i z następujacych obliczeń:

\(\forall n \in \mathbb{N} \quad (a^n)^{-1}L=a^*b^+\),

\(\forall n \in \mathbb{N} \quad (b^n)^{-1}L= \emptyset\),

\(\forall n \in \mathbb{N} \quad (ab^n)^{-1} L=b^*\).

Zauważmy również, nawiązując raz jeszcze do rezulatów przedstawionych w poprzednim wykładzie, że prawdziwa jest następująca równoważność wiążąca wprowadzone pojęcie pochodnej Brzozowskiego z prawą kongruencją syntaktyczną:

Rozpisując z definicji lewą stronę tej równoważności, otrzymujemy, iż dla dowolnego słowa \(z \in A^*\) słowo \(uz \in L\) wtedy i tylko wtedy, gdy \(vz \in L\). A to równoważnie oznacza (znów z definicji), że \(u^{-1}L=v^{-1}L.\)

Z uzasadnionej równoważności oraz twierdzenia 3.4 o prawej kongruencji syntaktycznej z poprzedniego wykładu wnioskujemy równoważność rozpoznawalności języka \(L\) i skończonej ilości różnych pochodnych Brzozowskiego tego języka.