Laboratorium

Moduł 1: Wykazywanie podatności programów

Moduł 2: Monitorowanie działania maszyny

Moduł 3: Dostęp do maszyny z sieci

Moduł 4: Dostęp do zasobów maszyny

Jednym z podstawowych wątków w ramach bezpieczeństwa systemów komputerowych jest zarządzanie dostępem do zasobów systemu komputerowego oraz czynności za pomocą tych zasobów wykonywanych.

Stare materiały

- Laboratorium 0: zajęcia organizacyjne

- Laboratorium 1 i 2: acl, syslog

- Laboratorium 3 i 4: buffer overflow

- Laboratorium 5 i 6: pam, sudo

- Laboratorium 7 i 8: ssh, pgp

- Laboratorium 9 i 10: chroot, ssl

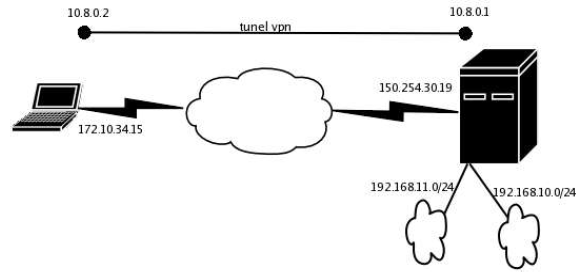

- Laboratorium 11 i 12: firewall iptables, vpn

- Laboratorium 13... : termin dodatkowy

- Laboratorium 14 - łamanie haseł

- Laboratorium 15: SQLi

- Laboratorium: drzewa ataków

- Laboratorium: umacnianie, utwardzanie - temat nierealizowany

ACL i SUDO

Podstawowy model praw dostępu

Przedmiotem mechanizmów kontroli dostępu jest sprawienie, aby określone czynności mogli wykonywać wyłącznie ludzie, którym te czynności wykonywać wolno (żeby na przykład kluczowej decyzji dla funkcjonowania dużej korporacji nie podejmowała sprzątaczka). W związku z tym współczesne systemy komputerowe operują pojęciami użytkownika, zasobu oraz praw do korzystania z tego zasobu, jakie użytkownik posiada. Ten prosty model jest dodatkowo wzbogacany o mechanizmy redukujące złożoność problemu określania praw dostępu (m * n, gdzie m to liczba użytkowników, a n to liczba zasobów): prawa właściciela, prawa grupowe i prawa dla pozostałych. Indywidualne prawa może mieć tylko właściciel, można określić grupę użytkowników i dla niej nadać określone prawa do zasobu oraz można zdefiniować prawa do zasobu, jakie mają wszyscy. Chociaż ten model praw dostępu kojarzymy przede wszystkim z systemami plików (bo systemy operacyjne mają tendencję do udostępniania wszystkich swoich obiektów w systemie plików), to pojawia się on też i gdzie indziej, na przykład w bazach danych. Warto jednak pamiętać, że model ten nie pozwala na zarządzanie ilością dostępnych zasobów (czas pracy procesora, pamięć, ilość danych wysyłanych kanałem komunikacyjnym itp.). Przypomnijmy jeszcze, jakie prawa dostępu możemy określić w tym podstawowym modelu:

- Prawo do odczytu (oznaczane r)

- Prawo do zapisu (oznaczane w), które nie implikuje i nie zakłada istnienia prawa do odczytu. Można zapisać dane do pliku, którego nie możemy odczytać.

- Prawo do wykonywania (oznaczane x), które nie implikuje prawa do odczytu, ale którego realizacja wymaga posiadania prawa do odczytu. Można wykonać plik tylko, gdy możemy go odczytać.

- Prawo do korzystania z katalogu (oznaczane x), które nie implikuje i nie zakłada istnienia prawa do jego odczytu ani zapisu. Można móc czytać informacje z katalogu, ale jednocześnie nie móc się odwoływać do plików w nim się znajdujących i wchodzić do wnętrza katalogu. Podobnie można móc się odwoływać do plików w katalogu (jeśli skądinąd wiemy, że one w nim są), ale nie móc odczytać jego zawartości.

Mechanizmy lokalnej kontroli dostępu

Listy kontroli dostępu (ang. Access Control List, ACL) rozszerzają standardowy mechanizm uprawnień, kontrolujący dostęp do plików (a także katalogów, urządzeń, gniazd i innych obiektów systemu plików). W porównaniu ze standardowymi mechanizmami praw dostępu ACL dają dodatkowo możliwość:

- przydzielania trzech standardowych uprawnień (rwx) nie tylko dla jednego użytkownika - właściciela pliku, ale dla dowolnie wskazanych, potencjalnie wielu użytkowników,

- przydzielania uprawnień nie tylko dla jednej grupy - grupy pliku, ale dla dowolnie wskazanych, potencjalnie wielu grup,

- szybkiego ograniczenia praw dla wielu użytkowników,

- przywiązania opisu praw, jakie otrzymują nowo tworzone zasoby, do katalogów, a nie tylko do użytkowników.

Linux

1. Zawartość Listy Kontroli Dostępu

Minimalna lista kontroli dostępu pokrywa się ze standardowymi uprawnieniami, natomiast lista rozszerzona zawiera dodatkową pozycję - maskę i może zawierać także pozycje dla poszczególnych użytkowników i grup. W liście ACL wyróżniamy następujące typy pozycji (w nawiasach słowa kluczowe):

- właściciel (user:: lub u::)

- wskazany przez nazwę użytkownik (user:nazwa_użytkownika: lub u:nazwa_użytkownika:) [dodatkowy mechanizm]

- grupa właściciela (group:: lub g::)

- wskazana przez nazwę grupa (group:nazwa_grupy: lub g:nazwa_grupy:) [dodatkowy mechanizm]

- maska (mask::) [dodatkowy mechanizm]

- pozostali (other::)

2. Szybkie odbieranie uprawnień - maska

Określanie odrębnych praw dla każdego użytkownika ma taką wadę, że w razie sytuacji kryzysowej (np. ataku na komputer) zmiana uprawnień wymaga żmudnej zmiany praw każdego z nich. Trudności z tym związane pozwala usunąć mechanizm maskowania praw dostępu w ACL (uwaga: chodzi o zupełnie inny mechanizm niż mechanizm związany z poleceniem umask). Dzięki temu mechanizmowi podczas obliczania efektywnych uprawnień (czyli tych, jakie użytkownik ma w momencie korzystania z zasobu w systemie plików), oprócz uprawnień zdefiniowanych dla danego użytkownika, brana jest pod uwagę także maska. Z dwoma naturalnymi wyjątkami: uprawnienia zdefiniowane dla właściciela i dla tzw. pozostałych (other) są zawsze efektywne (maska nie ma na nie wpływu). W obydwóch tych wypadkach nie mamy do czynienia z potencjalnie długą listą użytkowników, dla których musimy odrębnie określić prawa. Efektywne uprawnienia do pliku są koniunkcją bitową maski i uprawnień zdefiniowanych w odpowiedniej pozycji (dla nazwanego użytkownika, grupy właściciela lub nazwanej grupy). Przykład Jeżeli prawa do pliku zdefiniowane są w następujący sposób:user:testowy:r-x mask::rw-

3. Algorytm sprawdzania uprawnień dostępu

Rozszerzone uprawnienia są stosowane wg następującego algorytmu:- jeżeli użytkownik jest właścicielem pliku - zastosuj uprawnienia właściciela,

- jeżeli użytkownik jest na liście użytkowników wskazanych z nazwy - zastosuj efektywne (patrz punkt 2) uprawnienia nazwanego użytkownika,

- jeżeli jedna z grup użytkownika jest grupą właściciela i posiada odpowiednie efektywne prawa - zezwól na dostęp,

- jeżeli jedna z grup użytkownika występuje jako grupa wskazana z nazwy i posiada odpowiednie efektywne prawa - zezwól na dostęp,

- jeżeli jedna z grup użytkownika jest grupą właściciela lub należy do grup wskazanych z nazwy, ale nie posiada dostatecznych efektywnych uprawnień - dostęp jest zabroniony,

- jeżeli nie zachodzi żadne z powyższych - uprawnienia tzw. pozostałych określają możliwość dostępu.

4. Polecenia do odczytu i określania list ACL

Do zarządzania listami ACL służą dwa polecenia:- getfacl

- setfacl

% touch plik-testowy % ls -l plik-testowy -rw-r--r-- 1 janek bsk 0 2016-10-05 14:46 plik-testowy

% getfacl plik-testowy # file: plik-testowy # owner: janek # group: bsk user::rw- group::r-- other::r--

% getfacl plik-testowy –-omit-header user::rw- group::r-- other::r--

a) Zmiana uprawnień - opcja -m

Jeżeli chcemy dodać lub zmienić uprawnienia używamy opcji -m (jak modify), a następnie podajemy: pozycję z listy (patrz punkt 1), jakie uprawnienia chcemy nadać (rwx) i jakiemu plikowi. Przykład% setfacl -m u:ala:rwx plik-testowy

% getfacl plik-testowy # file: plik-testowy # owner: janek # group: bsk user::rw- user:ala:rwx group::r-- mask::rwxman setuid other::r--

% ls -l plik-testowy -rw-rwxr--+ 1 janek bsk 0 2016-10-05 14:46 plik-testowy

b) Usunięcie uprawnień - opcja -x

Opcji -x (jak exclude) używa się tak:man setuid% setfacl -x u:ala plik-testowy % getfacl plik.txt –-omit-header user::rw- group::r-- mask::r-- other::r--

% ls -l plik.txt rw-r--r--+ 1 janek bsk 0 2016-10-05 14:46 plik-testowy

5. Prawa dostępu dostępu dla nowo tworzonych zasobów

Uprawnienia dla nowo tworzonych zasobów, zwane skrótowo uprawnieniami domyślnymi, dotyczą tylko katalogów. Jeżeli katalogowi nadamy domyślne uprawnienia ACL, to nowo utworzone pozycje w tym katalogu będą je dziedziczyć. Do modyfikowania uprawnień domyślnych służy opcja -d (jak default) polecenia setfacl, po której następują znane już -m, -x itd. Przykład dodania uprawnień domyślnych% setfacl -d -m group:testowa:wx bsk-lab1 % getfacl bsk-lab1 –-omit-header user::rwx group::r-x other::r-x default:user::rwx default:group::r-x default:group:testowa:-wx default:mask::rwx default:other::r-x

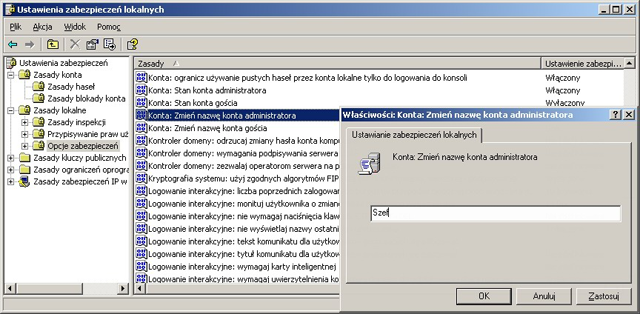

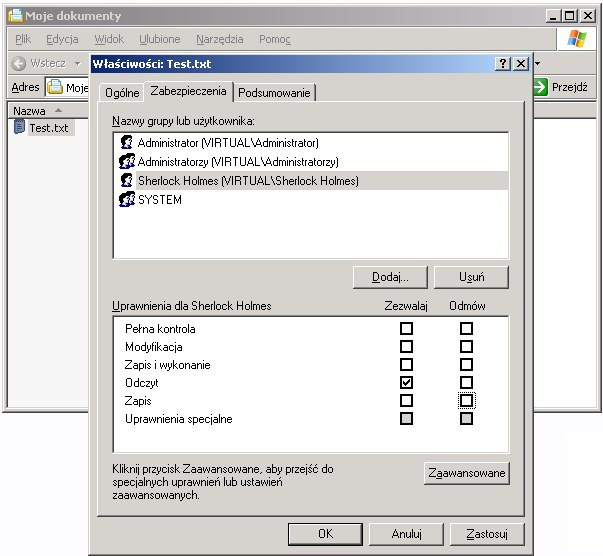

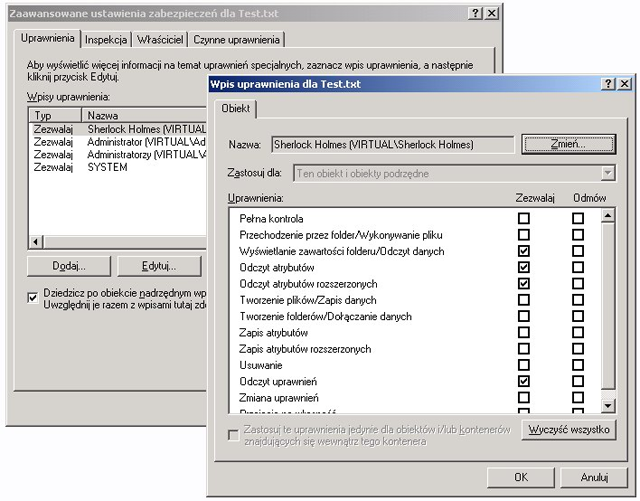

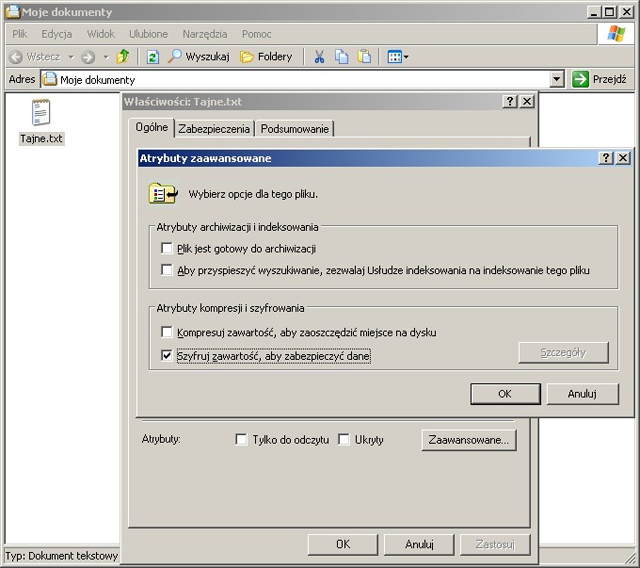

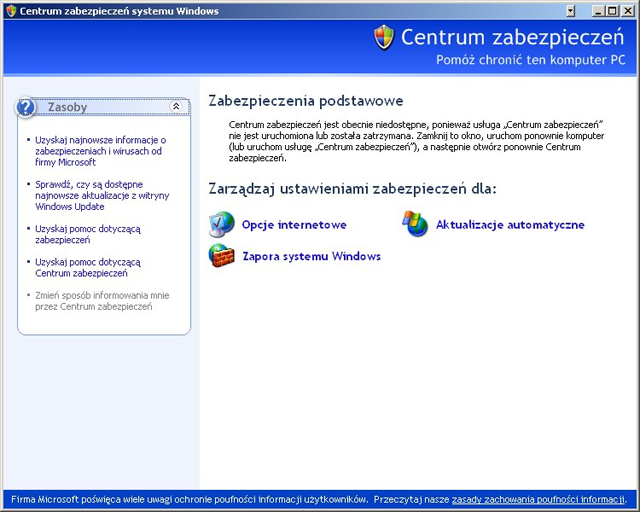

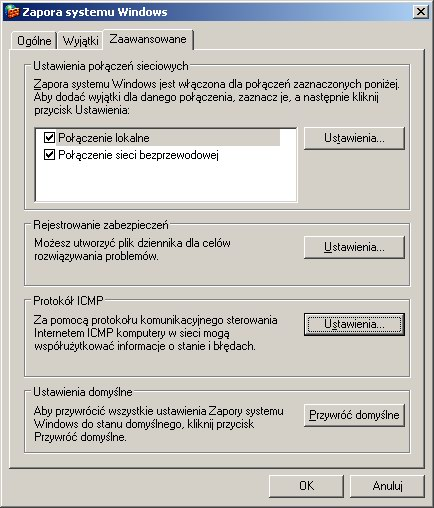

Windows

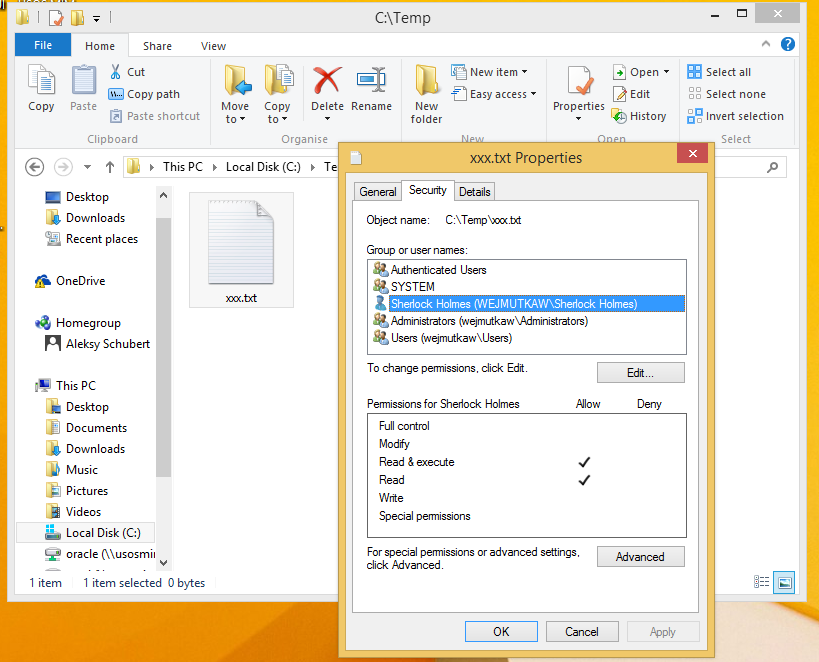

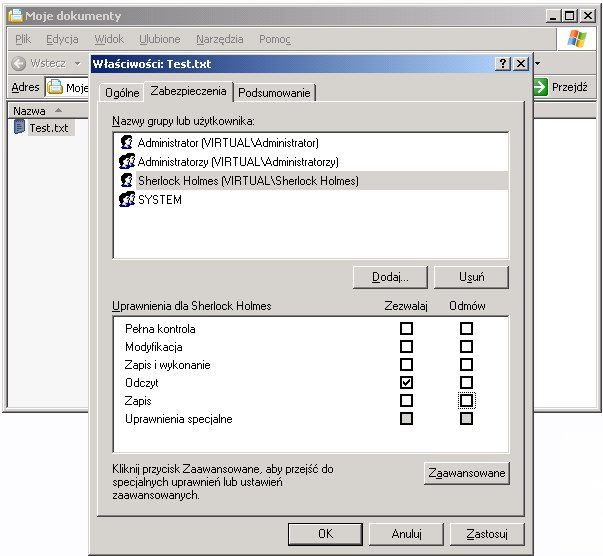

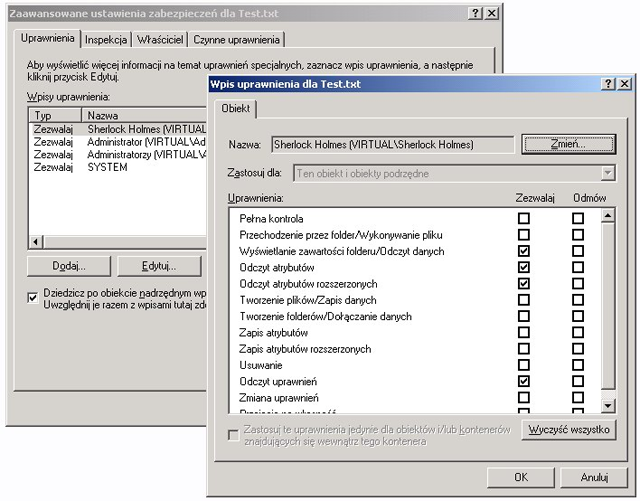

Poniższe obrazki ilustrują działanie ACL w systemie Windows XP. System plików NTFS umożliwia związanie z każdym plikiem (lub katalogiem) list kontroli dostępu. Dostęp do prostych ustawień ACL pliku jest możliwy z poziomu np. Eksploratora Windows w opcji Właściwości (menu Plik lub kontekstowe). Rozszerzone listy ACL są dostępne po wyborze uprawnień Zaawansowanych.

System Windows nie zapewniał obsługi ACL dla swoich pierwotnych systemów plików FAT (FAT16 i FAT32). W Windows CE 6 wprowadzono obsługę ACL dla systemu plików exFAT, jednak w późniejszych wersjach systemu Windows nie została ona wprowadzona.

System Windows nie zapewniał obsługi ACL dla swoich pierwotnych systemów plików FAT (FAT16 i FAT32). W Windows CE 6 wprowadzono obsługę ACL dla systemu plików exFAT, jednak w późniejszych wersjach systemu Windows nie została ona wprowadzona.

Podsumowanie

Zalety ACL:- Elastyczność, możliwość nadawania dowolnie skomplikowanych uprawnień bez konieczności tworzenia dużej liczby grup.

- Ułatwienie migracji, tworzenia i konfigurowania heterogenicznych środowisk z systemami operacyjnymi Windows i Linux (oprogramowanie Samba wspiera ACL).

- Edytory, które automatycznie zapisują zawartość w nowym pliku, a następnie zmieniają jego nazwę na oryginalną, mogą tracić informację o rozszerzonych uprawnieniach.

- Programy archiwizujące (np. tar) nie potrafią zapisywać informacji o listach kontroli dostępu.

% getfacl -R --skip-base . >backup.acl

Czytaj też

man 5 acl man do poleceń: getfacl, setfacl, chmod, umaskRozszerzanie uprawnień zwykłych użytkowników w Linuksie (SUDO)

Pewne operacje wymagają uprawnień posiadanych tylko przez niektórych użytkowników (np. tylko przez administratora). Jeśli chcemy pozwolić innym na ich wykonywanie (np. sterowanie podsystemem drukowania), to mamy dwie możliwości: a) Rozdać im hasło roota, aby mogli się nań zalogować (na innego użytkownika można się chwilowo zalogować, pisząc

su root

su - root

<użytkownik> <komputer>=(<efektywny-użytkownik>) <programy>

dobo ALL=(ALL) ALL

dobo localhost= ALL

<span class="inline inline-center"> sudo -l

Mechanizm SUID i SGID

Niektóre polecenia (np. passwd) wymagają uprzywilejowanego dostępu do chronionych zasobów, takich jak pliki. Oczywiście nie ma sensu czynić wszystkich sudoersami. Dlatego plik wykonywalny (czyli program) może mieć ustawiony specjalny bit powodujący, że wykonuje się on z prawami swojego właściciela lub grupy, a nie tego, kto go uruchomił. Pliki takie nazywa się SUID (od Set UID) bądź SGID (Set GID). Generalnie mechanizm ten jest niebezpieczny, bo nie jest dostępna zbiorcza informacja o takich programach w naszym systemie (ale polecenie find „poleca się łaskawym klientom”). Ustawianie takiego bitu w programach mających możliwość wykonania dowolnego innego programu (shelle, programy w C wywołujące system(...)) świadczy o dużej wrodzonej życzliwości właściciela programu --- należy go trzymać z dala od administrowania systemem.

Materiały:

man sudo man sudoers man setuid man setgid

Zadanie pokazujące aktywność

Wyobraź sobie, że w małym banku spółdzielczym masz zorganizować prawa dostępu do informacji o kredytach i lokatach poszczególnych klientów. Lista klientów znajduje się w pliku tekstowym, gdzie każdy wiersz ma postać:

identyfikator_klienta imię nazwiskoChcesz udostępnić klientom dwa katalogi: lokaty i kredyty. Dodatkowo masz dwóch pracowników, którzy zarządzają lokatami i kredytami. Napisz skrypt, który stworzy odpowiednią strukturę katalogów, założy klientom oraz pracownikom konta (useradd) oraz skonfiguruje dostęp do katalogów w taki sposób aby:

- każdy klient z listy miał prawo do odczytu plików, które powstaną w katalogu kredyty, a pracownik miał prawo do odczytu i zmiany plików z tego katalogu, a także miał prawo dodawać do niego elementy,

- każdy klient z listy miał prawo do odczytu i zapisu plików, które powstaną w katalogu lokaty, a także miał możliwość tworzenia plików w tym katalogu; jednocześnie pracownik miał prawo do czytania plików z tego katalogu, ale nie miał prawa do ich zmieniania, dodawania i usuwania,

- za pomocą polecenia sudo pracownik może przyjąć tożsamość jednego z klientów i wykonać jego operacje, dodaj do skryptu kilka operacji na lokatach i kredytach wykonywanych przez pracowników za pomocą sudo podszywających się pod klientów.

Powstały skrypt prześlij na Moodle.

Plik z listą klientów ma być parametrem skryptu.| Załącznik | Wielkość |

|---|---|

| uzytkownicy.txt | 95 bajtów |

Analiza plików obiektowych oraz ABI

Analiza plików obiektowych oraz ABI

Podstawowa struktura plików obiektowych

Po skompilowaniu programy lub biblioteki są zapisywane w systemie w postaci plików. Pliki te mają standaryzowany format, ale w różnych systemach operacyjnych odmienny. W systemach uniksowych (czyli we wszystkich linuksach) obecnie dominuje format ELF (ang. Executable and Linkable Format), który jest dostępny dla wielu architektur maszyn (np. x86, M68k, x86-64 czy ARM lub ARM 64-bits). Tego formatu można się spodziewać w plikach o rozszerzeniach: .axf, .bin, .elf, .o, .out, .prx, .puff, .ko, .mod and .so, ale też i w plikach bez rozszerzeń. Format ELF jest odmienny od formatu PE (ang. Portable Executable), w którym zapisane są pliki w systemach Windows. Również innym formatem - Mach-O - posługują się systemy firmy Apple. Na potrzeby tej lekcji skupimy się na formacie ELF i narzędziach służących do jego oglądania.

Podstawowym narzędziem, którego będziemy używali do oglądania plików

w formacie ELF jest polecenie objdump. Za jego pomocą

możemy się dowiadywać różnych ciekawych informacji na temat plików z

kodem wykonywalnym. Na przykład podstawowe informacje wynikające z

nagłówka pliku ELF możemy uzyskać za pomocą:

# objdump -d <nazwa_pliku>

Oto kilka przykładowych wyników działania tego polecenia:

# objdump -f /bin/ls /bin/ls: file format elf64-x86-64 architecture: i386:x86-64, flags 0x00000150: HAS_SYMS, DYNAMIC, D_PAGED start address 0x0000000000006b10 # objdump -f /lib/libasm.so.1 /lib/libasm.so.1: file format elf32-i386 architecture: i386, flags 0x00000150: HAS_SYMS, DYNAMIC, D_PAGED start address 0x00002760 # objdump -f /lib64/libasm.so.1 /lib64/libasm.so.1: file format elf64-x86-64 architecture: i386:x86-64, flags 0x00000150: HAS_SYMS, DYNAMIC, D_PAGED start address 0x0000000000002750 # objdump -f /lib64/libg.a In archive /lib64/libg.a: dummy.o: file format elf64-x86-64 architecture: i386:x86-64, flags 0x00000011: HAS_RELOC, HAS_SYMS start address 0x0000000000000000

Z których możemy wyczytać, że tylko trzy z nich działają w architekturze 64-bitowej (x86-64), trzy mogą brać udział w dynamicznym ładowaniu (DYNAMIC), wszystkie mają tablicę symboli (HAS_SYMS), dla trzech strony procesu dla kodu wykonywalnego pochodzącego z danego pliku mogą być przydzielane dynamicznie (D_PAGED). Dla jednego pliku możemy wyczytać, że jest archiwum bibliotecznym, a dla wszystkich mamy podany adres, pod który skoczy proces po załadowaniu pliku do pamięci, gdy potraktujemy kod jako plik wykonywalny (start address).

Ten ostatni adres jest szczególnie interesujący dla

pliku /bin/ls, ale więcej o tym, co tam się znajduje,

dowiemy się za chwilę. Wcześniej przyjrzyjmy się dokładniej

strukturze plików ELF, w szczególności plików wykonywalnych.

Ogólna, typowa struktura pliku ELF ma następującą postać:

/-------------------\

| Nagłówek ELF |---\

/---------> >-------------------< | e_shoff

| | |<--/

| Section | Nagłówek sekcji 0 |

| | |---\ sh_offset

| Header >-------------------< |

| | Nagłówek sekcji 1 |---|--\ sh_offset

| Table >-------------------< | |

| | Nagłówek sekcji 2 |---|--|--\

\---------> >-------------------< | | |

| Sekcja 0 |<--/ | |

>-------------------< | | sh_offset

| Sekcja 1 |<-----/ |

>-------------------< |

| Sekcja 2 |<--------/

\-------------------/

Jak widać, początki sekcji są wyznaczane przez odpowiednie wskaźniki. Oznacza to, że w zasadzie faktyczna kolejność sekcji może być odmienna. Typowy układ sekcji wygląda tak:

/-------------------\ | Nagłówek ELF | >-------------------< | Nagłówki sekcji | >-------------------< | .text | - sekcja ze skompilowanymi instrukcjami programu >-------------------< | .init | - sekcja ze instrukcjami programu służącymi do | | jego inicjalizacji >-------------------< | .rodata | - sekcja z danymi tylko do odczytu >-------------------< | .data | - sekcja z danymi inicjalizującymi, ale | | zmienialnymi w trakcie działania programu >-------------------< | .bss | - dane statyczne inicjalizowane na zero >-------------------< | .symtab | - tablica symboli pozwalających wiązać różnego | | rodzaju nazwy symboliczne z pozycjami w pliku | | obiektowym >-------------------< | .rel.text | - sekcja ze skompilowanym kodem relokowalnym >-------------------< | .rel.data | - sekcja z danymi w formacie relokowalnym >-------------------< | .debug | - sekcja zawiera informacje potrzebne przy | | debugowaniu, format zależny od debuggera | | sprzężonego z kompilatorem >-------------------< | .line | - sekcja ta zawiera informacje potrzebne przy | | debuggowaniu, a odpowiadające za powiązanie | | kodu źródłowego z kodem asemblerowym w pliku obiektowym >-------------------< | .strtab | - napisy, zwykle napisy reprezentujące nazwy w | | tablicy symboli \-------------------/

Sekcje zawierają informacje potrzebne przy linkowaniu - czyli komponowaniu plików składowych w pliki wykonywalne, a na samym końcu w początkowy obraz procesu. W ostatecznym rachunku sekcje tworzą segmenty programu wykonywalnego. Oczywiście kolejność występowania sekcji w pliku jest dowolna i nie musi ona wyglądać tak jak na powyższym rysunku. Nazwy te mają charakter umowny i czasami wyglądają nieco inaczej (np. możemy mieć .rdata zamiast .rodata lub możemy mieć inne umiejscowienie fragmentów nazw wskazujących na relokowalny kod czy dane albo też bardziej rozbudowane nazwy sekcji z danymi do debugowania). Typowe przełożenie sekcji na segmenty w pamięci roboczej procesu wygląda następująco:

/----------------------\ | Pamięć jądra, | -\ | adresy niedostępne | > pamięć niewidoczna dla kodu procesu | dla procesu | -/ >----------------------< >----------------------< | Stos procesu | | użytkownika | >----------------------< <-- %esp (wskaźnik wierzchołka stosu) | | | | v | | | | ^ | | | | >----------------------< | Region przeznaczony | | na mapowanie | | bibliotek dzielonych | >----------------------< | | | ^ | | | | >----------------------< <-- rozszerzane za pomocą brk | Sterta procesu | | (alokacja z pomocą | | malloc itp.) | | | >----------------------< | Segment danych do | -\ | odczytu i zapisu | | | (sekcje .data .bss) | | >----------------------< > dane ładowane z pliku | Segment danych tylko | | wykonywalnego | do odczytu (sekcje | | | .init .text .rodata) | -/ >----------------------< <-- zwykle: 0x0000000000400000 (64) | | 0x0000000008048000 (32) | | \----------------------/ <-- 0x0000000000000000

Oto jeszcze kilka przydatnych opcji programu objdump:

-

# objdump -h <nazwa pliku>- wyświetli podstawowe informacje zawarte w nagłówkach sekcji, -

# objdump -x <nazwa pliku>- wyświetli podstawowe informacje zawarte we wszystkich nagłówkach pliku obiektowego, -

# objdump -d <nazwa pliku>- pokaże nam zdezasemblowany kod wykonywalnych sekcji programu, -

# objdump -D <nazwa pliku>- pokaże nam zdezasemblowany kod wszystkich sekcji programu, -

# objdump -D <nazwa pliku>- pokaże nam zdezasemblowany kod wszystkich sekcji programu, -

# objdump -s <nazwa pliku>- pokaże nam w postaci szesnastkowej, a tam gdzie się da w ASCII, zawartość wszystkich sekcji, -

# objdump -g <nazwa pliku>- pokaże nam zawartość sekcji związanych z debugowaniem, -

# objdump -t <nazwa pliku>- pokaże nam zawartość tablicy symboli (używanych przy dezasemblacji kodu), -

# objdump -T <nazwa pliku>- pokaże nam zawartość tablicy dynamicznie ładowanych symboli, -

# objdump -j <nazwa sekcji> <nazwa pliku>- pokaże nam zawartość wskazanej sekcji pliku.

Typowa sekwencja startowa programu

W części tej zaczniemy przedstawiać podstawowe informacje dotyczące ABI. ABI to skrót od angielskiego Application Binary Interface, czyli specyfikacji, która opisuje, jak kod programu współpracuje z jego otoczeniem wykonawczym. W szczególności właśnie tam jest opisana procedura inicjalizacji procesu, ale także lokalizacja kodu i danych, sposób korzystania ze stosu, konwencja wywoływania procedur czy zasady układania danych na odpowiednich granicach adresowych i.in. W obecnym materiale skupimy się nad popularnym ABI używanym w świecie systemów uniksowych działających na procesorach Intel x64, czyli nad System V AMD64 ABI.

Popracujemy teraz nad kodem następującego prostego programu

#include <stdio.h>

int process(int a) {

int b = 3;

return a+b;

}

int main(void)

{

int n = 10;

int i = 1;

int sum = 0;

for(;i<=n;i++)

sum+=process(i);

printf("\n Sum is : [%d]\n",sum);

return 0;

}

umieszczonego w pliku o nazwie sum.c. Po jego skompilowaniu:

# gcc -g sum.c -o sum

Otrzymamy plik wykonywalny sum, dla którego

# objdump -fsRrd sum

da zawartość załączonego

pliku sum_objdump.txt.

Na początek zwróćmy uwagę, że adresem startowym programu

jest 0x0000000000401040. Pod tym adresem, jak widać w

załączonym wyniku objdump, znajduje się symbol o

nazwie _start i to rzeczywiście w to miejsce, a nie do

funkcji main jest wykonywany skok na początku działania

programu.

Przyjrzyjmy się kodowi związanemu z tym symbolem

0000000000401040 <_start>: 401040: f3 0f 1e fa endbr64 401044: 31 ed xor %ebp,%ebp 401046: 49 89 d1 mov %rdx,%r9 401049: 5e pop %rsi 40104a: 48 89 e2 mov %rsp,%rdx 40104d: 48 83 e4 f0 and $0xfffffffffffffff0,%rsp 401051: 50 push %rax 401052: 54 push %rsp 401053: 45 31 c0 xor %r8d,%r8d 401056: 31 c9 xor %ecx,%ecx 401058: 48 c7 c7 3e 11 40 00 mov $0x40113e,%rdi 40105f: ff 15 8b 2f 00 00 call *0x2f8b(%rip) # 403ff0 <__libc_start_main@GLIBC_2.34> 401065: f4 hlt

Powyższy kod zaczyna się od instrukcji endbr64, której

funkcją jest zabezpieczanie przed atakami związanymi ze skokami

sterowanymi przez dane (programowanie zorientowane na powroty czy

skoki). Część instrukcji skoku działa tak, że wykonanie skoku

zakończy się wyjątkiem, jeśli punkt docelowy nie zaczyna się od

właśnie tej instrukcji.

Następna instrukcja pod adresem 0x401044 zeruje

zawartość rejestru %ebp, który to rejestr zawiera

wskaźnik na rekord aktywacji aktualnej procedury zwany też ramką

procedury. Działanie to jest wymagane przez ABI. Właśnie ono

przepisuje, że wskaźnik ramki dla najbardziej zewnętrznej procedury

powinien być zerowy. W przypadku pozostałych procedur wskaźnik ramki

będzie dosyć niedaleki od adresu szczytu stosu, znajdującego się w

rejestrze %rsp. Uwaga - xor na dolnej części

rejestru %rbp, czyli właśnie na %ebp,

powoduje wyzerowanie jego górnej części.

Kolejna instrukcja pod adresem 0x401046 zajmuje się już

przygotowaniem parametrów wejściowych dla wywołania funkcji

__libc_start_main, które ma miejsce pod

adresem 0x40105f. W związku z tym opiszemy teraz

używaną w opisywanym tutaj ABI konwencję wołania funkcji/procedur.

Konwencja obsługi funkcji/procedur w ABI - wołanie

W skrócie, według tej konwencji najpierw argumentom przypisywane są

odpowiednie klasy (np. POINTER, INTEGER, SSE, MEMORY i.in.), a

następnie w zależności od klasy przydzielane im są w kolejności od

lewej do prawej odpowiednie lokacje sprzętowe. I tak pierwsze sześć

lokacji dla argumentów całkowitoliczbowych (INTEGER) lub

wskaźnikowych (POINTER) to odpowiednio rejestry

%rdi, %rsi, %rdx

%rcx, %r8, %r9 (ciekawostka:

rejestr %r10 jest używany w językach takich jak Pascal,

które oferują możliwość deklarowania funkcji/procedur

zagnieżdżonych, wtedy pokazuje on na ramkę procedury, wewnątrz

której zadeklarowana została wołana procedura). Dla argumentów

zmiennoprzecinkowych pierwsze osiem lokacji to

%xmm0, %xmm1, %xmm2, %xmm3,

%xmm4, %xmm5, %xmm6, %xmm7.

Dalsze argumenty, ale także argumenty o większych rozmiarach, są

przekazywane na stosie.

Jeśli nie są używane specjalne opcje kompilatora, to adres powrotu z

funkcji znajduje się tuż obok siódmego argumentu całkowitoliczbowego

na stosie. Dodatkowo poniżej wskaźnika stosu istnieje tak zwana

czerwona strefa, która z założenia nie będzie używana przez żadne

procedury obsługi sygnałów czy przerwań. Kompilatory umieszczają tam

czasami zmienne lokalne bez zmieniania zawartości

rejestrów obsługujących stos %rbp

czy %rsp.

Jednak należy pamiętać, że takie optymalizacje mają sens tylko w

przypadku funkcji, które nie wywołują już żadnych innych funkcji -

wywołania tych ostatnich popsują zawartość tego obszaru.

Analiza wywołania __libc_start_main w _start

Wiedząc tyle na temat ABI, możemy wrócić do analizy

funkcji _start. Zanim jeszcze tam przejdziemy warto

wiedzieć, że przed wywołaniem tej funkcji stos ma następującą zawartość:

/-----------------\ | NULL | >-----------------< | ... | | envp | | ... | >-----------------< | NULL | >-----------------< | ... | | argv | | ... | >-----------------< | argc | <- rsp \-----------------/

Dodatkowo rejestr %rdx zawiera przy wejściu

do _start adres funkcji zajmującej się terminacją

obsługi bibliotek dzielonych. Pomoże nam to zrozumieć, dlaczego

następne instrukcje mają kształt widoczny na listingu.

Jak wspomnieliśmy od

adresu 0x401046 znajduje się kod, który przygotowuje

parametry wejściowe dla wywołania z biblioteki standardowej funkcji

__libc_start_main. Funkcja ta ma następujący interfejs:

int __libc_start_main (

int (*main) (int, char **, char **), // adres kodu funkcji main, %rdi

int argc, // liczba argumentów polecenia, %rsi

char **argv, // tablica argumentów polecenia, %rdx

__typeof (main) init, // konstruktor programu, %rcx

void (*fini) (void), // destruktor programu, %r8

void (*rtld_fini) (void), // adres funkcji terminacji dla

// bibliotek dzielonych załadowanych

// przed kodem obecnego pliku, %r9

void *stack_end // wskaźnik na szczyt stosu, na stosie

)

W komentarzach opisane zostało znaczenie poszczególnych argumentów oraz wynikające z ABI pozycje argumentów w rejestrach i na stosie. Wszystkie argumenty są albo całkowitoliczbowe, albo wskaźnikowe, dlatego wypełnione zostają kolejno wszystkie rejestry odpowiedzialne za przekazywanie argumentów. Dzieje się to w następujący sposób:

- Pod adresem

0x401046wypełniany jest rejestr%r9podanym w%rdxadresem funkcji terminującej działanie bibliotek dzielonych załadowanych przed kodem z obecnego pliku. - Pod adresem

0x401049wypełniany jest rejestr%rsiznajdującą się na szczycie stosu liczbą argumentów polecenia. - Pod adresem

0x40104awypełniany jest rejestr%rdxadresem szczytu stosu, który po wykonanej wcześniej instrukcjipopwskazuje na tablicę argumentów polecenia. - Pod adresem

0x40104dinstrukcjaandpowoduje wyrównanie wskaźnika stosu przez obniżenie jego adresu do najbliższej pełnej wielokrotności 16, co jest wymagane przez ABI. - Pod adresem

0x401051instrukcjapushwstawia wartość, która jest nieistotna z punktu widzenia działania programu. To jest po prostu śmieciowa wartość. - Pod adresem

0x401052za to instrukcjapushpowoduje zapisanie adresu czubka stosu, czyli siódmego argumentu funkcji__libc_start_main. Przy okazji - dwie instrukcjepushobniżają szczyt stosu o 16 bajtów. - Pod adresami

0x401053i0x401056instrukcjexorzerują rejestry%r8,%rcx(trzeba sobie przypomnieć, co dokładnie robixorna młodszej połówce rejestru). - Pod adresem

0x401058wreszcie wypełniany jest rejestr%rdi, jak łatwo stwierdzić na podstawie danych w pliku, adresem funkcjimain.

Po tych wszystkich działaniach następuje rzeczywiście skok

do __libc_start_main, która wykonuje wszystkie operacje

niezbędne do uruchomienia kodu w C, a następnie woła

funkcję main. Gdy zaś ta zakończy działanie, obsługuje

też wszystkie działanie związane z wyjściem z procesu. W związku z

tym w zasadzie wyjście z niej nie powinno nigdy nastąpić. Gdyby tak

się jednak z jakiegoś powodu stało, to tuż za wywołaniem tej funkcji

występuje instrukcja hlt, której wykonanie poza kodem

jądra spowoduje błąd i proces zakończy natychmiast działanie w

sposób awaryjny.

Konwencja obsługi funkcji/procedur w ABI - wewnątrz funkcji

Przyjrzyjmy się teraz temu, jak swoje działanie organizuje funkcja,

która została wywołana. Zrobimy to na przykładzie

funkcji process z naszego programu sum.c.

Funkcja ta po zdezasemblowaniu ma taką postać:

0000000000401126: 401126: 55 push %rbp 401127: 48 89 e5 mov %rsp,%rbp 40112a: 89 7d ec mov %edi,-0x14(%rbp) 40112d: c7 45 fc 03 00 00 00 movl $0x3,-0x4(%rbp) 401134: 8b 55 ec mov -0x14(%rbp),%edx 401137: 8b 45 fc mov -0x4(%rbp),%eax 40113a: 01 d0 add %edx,%eax 40113c: 5d pop %rbp 40113d: c3 ret

Procedury/funkcje w C muszą się trzymać zasady, że muszą zachowywać

zawartość pewnych rejestrów. Chronione w ten sposób rejestry

to %rbx, %rsp, %rbp

oraz %r12-%r15.

To właśnie ta zasada powoduje, że w pierwszej instrukcji pod

adresem 0x401126 na stos kładziona jest zawartość

rejestru %rbp. Potem wartość ta jest odtwarzana pod

adresem 0x40113c. Jednocześnie w tym samym miejscu

niejawnie jest odtwarzana zawartość rejestru wskaźnika

stosu %rsp. Pozostałe rejestry w kodzie nie są używane,

więc nie zachodzi potrzeba ich odtwarzania.

Po zapamiętaniu oryginalnej wartości rejestru %rbp do

rejestru tego wstawiany jest adres aktualnego szczytu

stosu. Następnie w instrukcjach spod adresów 0x40112a i

0x40112d inicjalizowane są pod czubkiem stosu, we

wspomnianej wcześniej czerwonej strefie, zmienne lokalne,

odpowiednio

a i b. Następnie pod

adresami 0x401134 i 0x401137 następuje

załadowanie wartości zmiennych do rejestrów roboczych,

odpowiednio %edx i %eax. Wreszcie pod

adresem 0x40113a następuje dodanie tych wartości. Wynik

operacji trafia do rejestru %eax. Wykorzystana tutaj

jest konwencja wychodzenia.

Konwencja wychodzenia z procedury/funkcji każe wartości

całkowitoliczbowe lub wskaźnikowe o rozmiarze do 64 bitów

umieszczać w rejestrze %rax (%eax to

młodsza połówka tego właśnie rejestru), zaś o rozmiarze do 128

bitów w połączonych rejestrach %rax (młodsza połówka)

i %rdx (starsza połówka). Wartości zmiennoprzecinkowe

są na podobnej zasadzie podawane w rejestrach %xmm0

i %xmm1.

Ostatnia instrukcja procedury/funkcji to ret, która to

instrukcja przenosi sterowanie pod adres wskazany na szczycie

stosu. Jeśli włamywacze niczego nie popsuli, to jest to adres

procedury/funkcji, z której nasza funkcja była wołana. W przypadku

naszego przykładowego kodu będzie to zawsze

adres funkcji main.

Dalsze lektury

- Pełny opis ABI

- Poszerzyć wiedzę o plikach ELF można dzięki temu tutorialowi.

- Tutorial na temat procedury uruchamiania procesu można przeczytać tutaj.

- I jeszcze jeden tutaj.

Ćwiczenie

Rozważmy następujący program:

#include <stdio.h>

int process(int a) {

int ar[8] = { 0, 1, 2, 3, 4, 5, 6, 7 };

ar[3]=a;

int sum = 0;

for (int i=0;i<8;i++)

sum+=ar[i];

return sum;

}

int main(void)

{

int n = 10;

int i = 1;

int sum = 0;

for(;i<=n;i++)

sum+=process(i);

printf("\n Sum is : [%d]\n",sum);

return 0;

}

Po skompilowaniu i użyciu objdump uzyskaliśmy zrzut

dezasemblera z

pliku sum_array_objdump.txt. Przyjrzyj

się temu zrzutowi i dopisz w komentarzach po dwuznaku //

umieszczonych w pobliżu miejsca związanego z pytaniem odpowiedzi na

następujące pytania:

- Jaki jest adres lub rejestr, w którym przechowywana jest

zmienna

iz funkcjimain()? - Jaki jest adres lub rejestr, w którym przechowywana jest

zmienna

sumz funkcjimain()? - Jaki jest adres lub rejestr, w którym przechowywana jest

zmienna

iz funkcjiprocess()? - Jaki jest adres lub rejestr, w którym przechowywana jest

zmienna

sumz funkcjiprocess()? - Jaki jest adres początku tablicy

arz funkcjiprocess()? - Jak jest zlokalizowany w stosunku do adresu początku i końca

tablicy

aradres, pod którym znajduje się adres powrotu z funkcjiprocess()?

Wartości adresów podaj symbolicznie, np. obecny adres szczytu stosu minus 16. Zmodyfikowany tak przez dodanie komentarzy plik należy przesłać do Moodle.

| Załącznik | Wielkość |

|---|---|

| sum.c | 234 bajty |

| sum_objdump.txt | 43.73 KB |

| sum_array.c | 330 bajtów |

| sum_array_objdump.txt | 41.36 KB |

Chroot i Docker

1. Bezpieczne środowisko uruchamiania aplikacji

Jeśli aplikacja (np. serwer http) jest uruchamiana pod systemem operacyjnym, w szczególności np. z uprawnieniami roota, w przypadku umiejętnego wykorzystania błędu atakujący może uzyskać bardzo szerokie uprawnienia, m.in. nieograniczony dostęp do systemu plików. Włamywacze są bardzo łasi na wynajdowanie takich podatności.

W celu uniknięcia takich zagrożeń:

- należy uruchamiać aplikację z minimalnymi niezbędnymi uprawnieniami, w szczególności jako użytkownik inny niż root. Takie podejście jest szeroko stosowane, np. serwer HTTP Apache może być uruchomiony jako użytkownik inny niż root (zwykle

httplubwww); - jeśli to możliwe, trzeba zadbać, aby proces miał dostęp do ograniczonych zasobów systemowych.

1.1. Ograniczenie przestrzeni aktywności procesu - chroot

W systemie Linux można uruchomić dowolny proces (i jego procesy potomne) ze zmienionym katalogiem głównym za pomocą polecenia chroot (można to też zrobić wewnątrz programu za pomocą wywołania systemowego chroot()). Uruchomiony w ten sposób proces nie może powrócić do rzeczywistego katalogu głównego w systemie plików. Można więc przygotować inny niż główny katalog zawierający pliki niezbędne dla aplikacji np. biblioteki czy pliki konfiguracyjne. Zwykle trzeba odwzorować część struktury katalogów i plików konfiguracyjnych, np. /etc, /usr/lib/, /var, /proc. Mechanizm chroot może być też przydatny dla celów testowania oprogramowania lub np. zrealizowania środowiska programistycznego ze specyficznym zestawem bibliotek i narzędzi. Do zalet należy także zaliczyć bardzo łagodną krzywą uczenia się przy korzystaniu z tego rozwiązania i brak konieczności modyfikacji jądra systemu operacyjnego.

1.1.1. Przykład użycia polecenia chroot

Jeśli docelowy katalog został przygotowany, można uruchomić proces, np.:

chroot /przygotowany_katalog /usr/sbin/apache2 -k start

1.1.2. Wady chroot

Sam w sobie chroot nie posiada mechanizmów limitowania zasobów używanych przez proces, użycie go nie zabezpiecza więc przed atakami DoS. (Ograniczenia takie można wprowadzić za to mechanizmem PAM).

Uruchomienie polecenia chroot wymaga uprawnień roota.

Chroot nie zmienia UID i GID procesu. Jeśli aplikacja sama nie zmieni UID, będzie wykonywana z prawami roota.

Istnieją sposoby, które pozwalają procesowi uruchomionemu z prawami roota, wyjście poza określony poleceniem chroot katalog -

opisano je w lekturze uzupełniajacej http://linux-vserver.org/Secure_chroot_Barrier.

Można przy okazji zacytować fragment listu Alana Coxa: "(...) chroot is not and never has been a security tool." :)

1.1.3 Przydatne triki

Jeżeli chcemy mimo wszystko przygotować katalog chroot, możemy ułatwić sobie życie na dwa sposoby. Po pierwsze można przygotować minimalną instalację jakiejś dystrybucji, aby uniknąć zgadywania, które pliki są potrzebne do pracy naszego programu; dotyczy to zwłaszcza bibliotek korzystających z wielu plików pomocniczych. Trzeba jednak pamiętać, aby nie umieszczać w systemie zbędnych programów z bitem SUID, które mogłyby być wykorzystane do „ucieczki” z chroota. Warto też pamiętać o poleceniu

mount --bind /proc /przygotowany_katalog/proc mount --rbind /dev /przygotowany_katalog/dev

pierwsza wersja powoduje, że pliki z systemu plików (lub jakiegoś katalogu z systemu plików) widocznego jako /proc będą też widoczne w katalogu /przygotowany_katalog/proc. Nie dotyczy to jednak katalogów podmonotwanych wewnątrz proc, np. /proc/sys/fs/binfmt_misc. Natomiast druga wersja obejmuje także katalogi podmontowane wewnątrz dowiązywanego katalogu.

1.2. Kontentery

Chociaż opanowanie podstawowej funkcjonalności chroot jest łatwe, to jak zaznaczyliśmy powyżej, użycie chroot do stworzenia szczelnie zamkniętego środowiska wykonawczego dedykowanego dla jednej aplikacji jest żmudne i wymaga sporego doświadczenia. Dlatego opracowane zostały bardziej kompleksowe rozwiązania, które pozwalają na lepsze opanowanie wskazanych trudności.

Naturalnym roszerzeniem chroota jest objęcie ograniczeniami także innych zasobów niż system plików. W idealnym świecie uruchomiony w takim ulepszonym chroocie – czyli kontenerze – program powinien zachowywać się tak, jakby był uruchomiony na maszynie wirtualnej na tym samym komputerze i z oddzielną kopią tego samego jądra. Jednak ponieważ naprawdę nie uruchamiamy nowego jądra, to nie występuje narzut spowodowany koniecznością obsługi wywołań systemowych przez dwa jądra, wirtualizacją urządzeń sprzętowych itp. Możemy także, jeżeli tego potrzebujemy, osłabić izolację w jakimś miejscu, aby programy bardziej efektywnie współpracowały. Ograniczeniem jest konieczność używania takiego samego jądra we wszystkich używanych kontenerach i systemie bazowym (choć to ograniczenie w ostatnich czasach zostało zupełnie zniwelowane).

W Linuksie implementacja kontenerów opiera się na uogólnieniu pojącia chroot do pojęcia namespace. Są one następujące i pozwalają izolować:

Namespace Constant Isolates

Cgroup CLONE_NEWCGROUP Cgroup root directory

IPC CLONE_NEWIPC System V IPC, POSIX message queues

Network CLONE_NEWNET Network devices, stacks, ports, etc.

Mount CLONE_NEWNS Mount points

PID CLONE_NEWPID Process IDs

User CLONE_NEWUSER User and group IDs

UTS CLONE_NEWUTS Hostname and NIS domain nameTabelka pochodzi z man namespace(7). Tę stronę podręcznika systemowego należy przeczytać, a strony zależne przejrzeć. Należy także zapoznać się z możliwościami nakładania ograniczeń na procesy za pomocą grup cgroups(7).

Na podstawie tej infrastuktury zbudowanych jest kilka środowisk dających wygodne narzędzia do wirtualizacji, są to. np. Linux Containers (LXC), OpenVZ, Docker. Na tych zajęciach przyjrzymy się bliżej jako przykładowi temu ostatniemu rozwiązaniu.

1.3. Docker

Docker składa się z procesu serwera, który odpowiada za faktyczne tworzenie kontenerów, ich modyfikacje, itp. oraz klienta, którego funkcją jest zapewnianie możliwości korzystania z serwera. W celu skonfigurowania nowego kontenera, tworzymy w pustym katalogu plik o nazwie Dockerfile z zawartością odpowiadającą naszym potrzebom. Oto przykładowa zawartość:

FROM debian:buster # O ile chcemy, aby proces działał w środowisku Debian 10 MAINTAINER Kto To Wie RUN apt-get update && apt-get install -y apache2 EXPOSE 80 CMD apachectl -D FOREGROUND

pierwsza linia oznacza obraz systemu operacyjnego, z którego korzystamy na początku pracy. Docker ma centralny rejestr obrazów, z których można korzystać przy tworzeniu kontenerów, są w nim w szczególności podstawowe instalacje różnych dystrybucji. Jeśli chcemy uniezależnić się od twórców Dockera, można też uruchomić własny taki serwer.

Linia z wpisem MAINTAINER jest wymagana, ale ma charakter informacyjny. Następnie mamy (być może kilka) linii z poleceniami RUN. Opisują one polecenia potrzebne do przygotowania docelowej konfiguracji kontenera. W celu uniknięcia zbyt częstego wykonywania tych samych poleceń Docker zapamiętuje stan kontenera po każdej linijce z pliku Dockerfile w sposób analogiczny do migawek zwykłych maszyn wirtualnych.

Polecenie EXPOSE 80 udostępnia światu port 80. Polecenie CMD określa polecenie, które będzie służyło do faktycznego uruchomienia kontenera - w tym przypadku jest to serwer Apache. Gdy podany proces zakończy działanie Docker zatrzyma wszystkie procesy w kontenerze

W celu uruchomienia naszego kontenera wchodzimy do odpowiedniego katalogu z plikiem Dockerfile i wykonujemy polecenia:

docker build . docker container run <id_obrazu>

lub krócej

docker run <id_obrazu>

Polecenie docker build . zbuduje obraz na podstawie pliku Dockerfile (w tym przypadku na Debianie 10, ale np. z dołączonymi naszymi plikami), polecenie docker run id_obrazu uruchomi proces serwera Apache w nowym kontenerze w środowisku naszego obrazu.

Polecenie

docker images

lub

docker image ls

pozwala sprawdzić identyfikator (id) obrazu.

Jeśli chcemy szybko uruchomić proces w nowym kontenerze (w środowisku Debian 10) bez pisania pliku Dockerfile, możemy napisać

docker run -t -i debian:buster /bin/bash

Polecenie docker run wykona wtedy kilka kroków:

- Ściągnie obraz Debiana bustera, jeśli wcześniej nie był ściągnięty za pomocą polecenia

docker pull debian:buster - Utworzy nowy kontener.

- Nadmontuje nad obrazem warstwę rw.

- Ustanowi nowy adres IP.

- Uruchomi nowy proces w środowisku określonym przez obraz/warstwę rw

Należy zwrócić uwagę, że istnieje duża różnica między docker run id_obrazu, a docker start id_kontenera. (W tym samym znaczeniu można wykonać docker container run id_obrazu lub docker container start id_kontenera). Polecenie Dockera run zawsze tworzy nowy kontener.

Kilka przykładów operacji na kontenerach:

docker container ls -a (listowanie wszystkich) docker container run <id_obrazu> (uruchamia proces w nowym kontenerze, w środowisku obrazu o danym id) docker container stop <id_kontenera> (zatrzymywanie kontenera) docker container start <id_kontenera> (uruchamianie zatrzymanego kontenera) docker container rm <id_kontenera> (usuwanie) docker container prune (usuwanie wszystkich zatrzymanych)

Można też oczywiście usuwać obrazy (docker image rm id_obrazu lub docker image prune -- usuwa wszystkie nieużywane). Tak jak było widać już wcześniej, np. polecenie docker stop wykona to samo, co docker container stop, ale nie zadziała docker prune, trzeba użyć docker image prune lub docker container prune. Pierwsze usuwa obrazy, drugie kontenery. Warto sprawdzić jakie opcje są dostępne dla danego polecenia Dockera: docker --help, docker container --help, docker image --help, docker container ls --help itd.

Należy pamiętać, że obraz (image) i kontener (container) to nie to samo. Obraz daje możliwość utworzenia środowiska

dla procesu w kontenerze, środowiska opartego na konkretnym systemie operacyjnym (Debianie 9, Debianie 10, Ubuntu itp).

Można powiedzieć, iż kontenery korzystają z obrazów, z jednego obrazu może korzystać wiele kontenerów. Więcej informacji

na temat przechowywania danych, warstw z których składa się dockerowa pamięć nieulotna można znaleźć na https://docs.docker.com/storage/storagedriver/.

1.3.1 Ciąg dalszy

Docker oraz plik Dockerfile mają jeszcze wiele możliwości, których nie poznaliśmy. Co ciekawe, od wersji Docker Engine 19.03, istnieje możliwość pracy w trybie nie roota, w tej wersji cecha ta jest uważana za eksperymentalną. Do używania w tym trybie zalecana jest najnowsza wersja 20.10.

Warto też nadmienić, że chociaż początkowo korzystanie z Dockera pod Windows skazywało nas na korzystanie z systemów windowsowych wewnątrz kontenerów, a korzystanie z Linuksa z systemów linuksowych, to obecnie te ograniczenia zostały pokonane i pod Windows można korzystać z Linuksa i vice versa (choć w nieco bardziej skomplikowany sposób).

Pełna dokumentacja Dockera jest dostepna pod adresem https://docs.docker.com/get-started/overview/.

Zadanie pokazujące aktywność

Zainstaluj dockera, pod Debianem 10 wystarczy:

apt-get install docker.io

docker pull debian:buster

docker run -i -t debian:buster bash -l

Jako ćwiczenie umieść w kontenerze pliki swojego rozwiązania zadania z tematu ACL i SUDO oraz program z obsługą PAM-a napisany na zajęciach z PAM-a. Uruchom w dokerze skrypt napisany z zadania z tematu ACL i SUDO i skompiluj program z PAM-em, a następnie uruchom skompilowany program. Odpowiedni Dockerfile prześlij na Moodle.

GDB i analiza programów

GDB i analiza programów

Instalacja nakładki PEDA

Korzystanie z GDB bez dodatkowych narzędzi jest dosyć kłopotliwe. Narzędzie to oferuje bardzo nieporęczny, niskopoziomowy interfejs, którego opanowanie wymaga wiele wysiłku, a po opanowaniu używanie jest pracochłonne. Dlatego powstało wiele nakładek na GDB, które wspomagają różnego rodzaju działania. Na naszych zajęciach przyjrzymy się bliżej nakładce PEDA (ang. Python Exploit Development Assistance), która jest używana do wykazywania podatności aplikacji na ataki.

Instalacja nakładki PEDA sprowadza się do ściągnięcia jej kodu z repozytorium:

# git clone https://github.com/longld/peda.git ~/peda

i wpisaniu do pliku konfiguracyjnego GDB (.gdbinit)

kodu ładującego procedury PEDA:

# echo "source ~/peda/peda.py" >> ~/.gdbinit

Pierwsze kroki w GDB (z PEDA)

Na zajęciach będziemy pracowali nad kodem następującego programu w C (plik sum.c).

#include <stdio.h>

int process(int a, int len)

{

int ar[8];

for (int i=0; i < len; i++)

ar[i]=a+i;

int sum = 0;

for (int i=0; i < len; i++)

sum+=ar[i];

return sum;

}

int main(void)

{

int n = 10;

int i = 1;

int sum = 0;

for(;i <=n;i++)

sum+=process(i, 8);

printf("\n Sum is : [%d]\n",sum);

return 0;

}

Dla ułatwienia naszej pracy skompilujemy go poleceniem:

# gcc -g sum.c -o sum

Możemy teraz uruchomić debugger na tak skompilowanym kodzie:

# gdb sum

Otrzymamy dłuższe powitanie, po którym pojawi się znak zachęty:

gdb-peda$

Możemy teraz uruchomić załadowany program, pisząc run

lub po prostu r. Otrzymamy wtedy informacje o ładowaniu

otoczenia wykonywanego programu, jego wyjście oraz raport z

zamykania jego procesów:

Starting program: /home/alx/Praca/Zajecia/BSK/gdb/sum [Thread debugging using libthread_db enabled] Using host libthread_db library "/lib64/libthread_db.so.1". Sum is : [720] [Inferior 1 (process 1141169) exited normally] Warning: not running

Jednak ogromna siła GDB polega na tym, że możemy działanie programu zatrzymać we wskazanym punkcie i począwszy od tego punktu rozpocząć wykonanie programu i ewentualnie wpłynąć na jego działanie przez podmianę danych w trakcie działania programu.

Punkt zatrzymania biegu programu ustalamy, ustanawiając tzw. punkt przerwania (ang. breakpoint). Robimy to poleceniem

break <wskazanie punktu>

lub

b <wskazanie punktu>

Często pierwszą rzeczą, jaką robimy po wejściu do GDB jest napisanie:

gdb-peda$ b main

W ten sposób ustawiamy sobie punkt przerwania na pierwszej

instrukcji funkcji main. Jak widać możemy wstawiać

symbole z tablicy symboli za punkty przerwania. W takim razie po

poprzednich zajęciach możemy mieć ochotę napisać też:

gdb-peda$ b _start

Jednak pech chce, że po załadowaniu programu z informacjami

dotyczącymi debugowania do pamięci, symbol _start jest

niejednoznaczny, gdyż występuje on nie tylko w skompilowanym programie, ale i w dynamicznie ładowanych

bibliotekach. Dlatego bezpieczniej jest założyć punkt przerwania na

adresie wyczytanym za pomocą objdump.

gdb-peda$ b *0x0000000000401040

Wtedy będziemy rzeczywiście mogli prześledzić wykonanie kodu spod

symbolu _start pochodzącego z naszego programu.

Wróćmy jednak do wykonywania funkcji main. PEDA

oferuje tutaj pewne usprawnienie, bo zamiast przechodzić przez

sekwencje ustawienia punktu przerwania na main i

uruchomienia run, wystarczy, że uruchomimy

polecenie

gdb-peda$ start

które automatyzuje te kroki.

Gdy już program nam się zatrzyma na początku

funkcji main, możemy zacząć wykonywać go krok po kroku,

używając poleceń

-

step(w skrócies) do wykonania jednej instrukcji z granulacją określoną wierszami w kodzie źródłowym, -

stepi(w skróciesi) do wykonania jednej instrukcji z granulacją wskazaną przez kod maszynowy, -

next(w skrócien) do wykonania jednej instrukcji z granulacją wskazaną w kodzie źródłowym, ale bez wchodzenia do wywołań, -

nexti(w skrócieni) do wykonania jednej instrukcji z granulacją wskazaną przez kod maszynowy, ale bez wchodzenia do wywołań.

Oczywiście wpisywanie w kółko nawet powyższych skrótów jest

niewygodne, więc warto pamiętać, że naciśnięcie klawisza przejścia

do nowego wiersza powoduje wykonanie ostatnio wpisanej instrukcji.

Dodatkowo powyższe instrukcje wykonane z parametrem liczbowym

(np. step 5) pozwalają na wykonanie wskazanej w

parametrze liczby instrukcji. Zwykle też wygodne jest użycie

-

xuntil <punkt>

prowadzące do wykonania kodu aż do osiągnięcia wskazanego punktu w kodzie.

Co PEDA wyświetla?

Po przejściu przez każdy krok wykonania GDB z nakładką PEDA wypisuje nam najważniejsze elementy kontekstu wykonania programu, są to w kolejności wyświetlania:

- aktualna zawartość rejestrów,

- okolice właśnie wykonywanej instrukcji,

- okolice szczytu stosu.

Zawartość rejestrów jest przedstawiana w formie ciągu wierszy, z których każdy zaczyna się nazwą rejestru, po której następuje jego aktualna wartość, a dalej, jeśli wartość da się zinterpretować jako adres w aktualnej przestrzeni adresowej procesu, to wartość, jaka znajduje się pod adresem z rejestru. Rejestr flag ($eflags) opatrzony jest dodatkowo słownym opisem tego, jakie flagi są ustawione.

Okolice właśnie wykonywanej instrukcji zawierają zapisy postaci

0x401183 <main>: push rbp 0x401184 <main+1>: mov rbp,rsp 0x401187 <main+4>: sub rsp,0x10 => 0x40118b <main+8>: mov DWORD PTR [rbp-0xc],0xa 0x401192 <main+15>: mov DWORD PTR [rbp-0x4],0x1 0x401199 <main+22>: mov DWORD PTR [rbp-0x8],0x0 0x4011a0 <main+29>: jmp 0x4011b8 <main+53> 0x4011a2 <main+31>: mov eax,DWORD PTR [rbp-0x4]

Instrukcja, która w następnym kroku ma być wykonana jest wyróżniona

za pomocą znacznika =>. W każdym wierszu widzimy

najpierw adres instrukcji, po którym występuje symboliczne

wskazanie, jakiemu miejscu której procedury adres odpowiada

(np. <main+8>), a następnie widzimy mnemonik instrukcji

maszynowej wraz z jego argumentami.

Trzeci blok to blok stosu wygląda tak

0000| 0x7fffffffd628 --> 0x7ffff7dc4560 (<__libc_start_call_main+128>: mov edi,eax)

0008| 0x7fffffffd630 --> 0x400040 --> 0x400000006

0016| 0x7fffffffd638 --> 0x40112a (<main>: sub rsp,0x8)

0024| 0x7fffffffd640 --> 0x1000006f0

0032| 0x7fffffffd648 --> 0x7fffffffd758 --> 0x7fffffffdb75 ("/irgendwie/irgendwo/sum")

0040| 0x7fffffffd650 --> 0x0

0048| 0x7fffffffd658 --> 0x7ea1c88705a356f0

0056| 0x7fffffffd660 --> 0x7fffffffd758 --> 0x7fffffffdb75 ("/irgendwie/irgendwo/sum")

Jego zawartość jest podobna w formie i

znaczeniu do zawartości bloku rejestrów, ale informacje zaczynają

się nie od nazwy rejestru, a od adresu na stosie. Widzimy tutaj dwa

pola - w pierwszym znajduje się wielkość przesunięcia danej pozycji

adresowej względem szczytu stosu, dalej znajduje się rzeczywisty

adres pozycji. Po adresie, za strzałką --> znajduje się

zawartość pozycji na stosie.

Dodatkowo wszystkie adresy są pokolorowane, dzięki czemu w miarę szybko można się zorientować, do czego one prowadzą. Adresy czerwone są wskaźnikami do kodu, adresy niebieskie do danych zmienialnych, adresy zielone to adresy do danych przeznaczonych tylko do odczytu.

Gdyby przytłaczał nas nadmiar informacji ze wszystkich trzech sekcji, możemy sobie wyświetlić tylko jedną z nich za pomocą odpowiednio:

- context reg

- context code

- context stack

Jeśli interesuje nas kod źródłowy programu, który badamy (niestety

ta możliwość jest dostępna tylko, gdy program został skompilowany z

opcją -g, czego się w zasadzie nie robi dla kodu

produkcyjnego), to możemy napisać

- list

które polecenie wypisze nam fragment kodu źródłowego z okolic właśnie wykonywanej instrukcji maszynowej.

Wielkość kontekstu w razie potrzeby można regulować za pomocą parametru liczbowego, po poleceniu (po code lub stack).

Gdyby powyższe udogodnienia PEDA nam nie wystarczały, to możemy spróbować użyć podstawowego, służącego do wyświetlania danych polecenia GDB. Ma ono postać:

-

print <nazwa zmiennej>

Spowoduje to wypisanie zmiennej zadeklarowanej w kodzie źródłowym

zgodnie z jej typem. Można używać też formy skróconej tego polecenia

- p, a i też jako zmiennej użyć identyfikatora

rejestru. Wreszcie można podpowiedzieć poleceniu nieco, w jakiej

formie ma wypisać wynik

-

p/x <nazwa zmiennej>- wypisze wartość zmiennej szesnastkowo, -

p/d <nazwa zmiennej>- wypisze wartość zmiennej dziesiętnie, -

p/s <nazwa zmiennej>- wypisze wartość zmiennej jako napis.

Jeszcze jedna forma wypisywania danych możliwa jest do uzyskania za pomocą polecenia

x /nfu <adres>

Litera x jest tutaj skrótem od

angielskiego examine. Literki nfu reprezentują tutaj

symbolicznie różne opcjonalne parametry wypisywanej wartości:

- n - wskazuje za pomocą liczby dziesiętnej, ile kolejnych wartości z pamięci ma zostać wypisane,

- f - wskazuje, w jakim formacie mają być wypisywane wartości (dziesiętnie, szesnastkowo, jako napis, jako instrukcje asemblera i.in.),

- u - rozmiar wypisywanej jednostki pamięci (b to bajty 8-bitowe, h to półsłowa 16-bitowe, w to słowa 32-bitowe, g to gigantyczne słowa 64-bitowe).

Na przykład wypisanie 5 instrukcji, począwszy od szczytu stosu można uzyskać tak:

x /5i $rsp

Przejście przez program

Spróbujmy teraz przejść się trochę po danym nam kodzie programu. Zaczniemy od wykonania

gdb-peda$ xuntil 0x4011a0

(0x4011a0 jest podejrzanym przez nas za

pomocą objdump adresem początka pętli). Możemy się

teraz zabawić w podmianę danych na gorąco:

gdb-peda$ set sum = 100

spowoduje, że zaczniemy sumowanie nie od zera, ale od 100, co da

nam wyraźnie inny wynik końcowy, o czym się przekonamy, prosząc GDB

o kontynuację wykonywania kodu za pomocą continue (lub

po prostu c).

Trochę bardziej kłopotliwe jest zmienianie wartości

zmiennych n czy i, gdyż te są uznawane za

skróty poleceń GDB. Dlatego dla nich lepiej jest pisać od razu

gdb-peda$ set var n = 100

Możemy się też w każdej chwili przekonać, jaka jest wartość

zmiennej sum w danym momencie

gdb-peda$ print sum

czy zmiennej n.

gdb-peda$ p n

lub jakiegoś rejestru

gdb-peda$ p $rcx

Ciekawy efekt uzyskamy, gdy wykonamy

gdb-peda$ xuntil 0x4011ac

(tu dostaniemy się tuż przed wywołanie process), a

następnie zmienimy zawartość rejestru odpowiadającego za drugi

argument wywołania:

gdb-peda$ set $esi = 13

Gdy liczbę 13 zamienimy na 14, efekt będzie jeszcze ciekawszy.

Poszukiwanie wzorców

Uruchommy nasz program od początku poleceniem start.

Ważnym narzędziem pozwalającym na stosunkowo szybkie trafienie w miejsce przetwarzania programu, jakie nas interesuje, jest wyszukanie jakiegoś napisu, który nam się pojawia w interfejsie użytkownika. W naszym przykładowym programie moglibyśmy poszukać napisu "Sum". Można to zrobić za pomocą:

gdb-peda$ searchmem "Sum"

Uzyskamy wtedy mniej więcej taki wynik:

Searching for 'Sum' in: None ranges

Found 2 results, display max 2 items:

sum : 0x402012 ("Sum is : [%d]\n")

sum : 0x403012 ("Sum is : [%d]\n")

Poszukiwanie to może być znacznie bardziej skomplikowane i poszukiwane mogą być wystąpienia pasujące do wyrażenia regularnego, a także może ono być ograniczone tylko do jakichś obszarów (np. możemy szukać jakiegoś wzorca w kodzie biblioteki dzielonej).

Jak już znajdziemy interesujący nas napis, to możemy poprosić GDB, aby zatrzymało się przy próbie odwołania do tego adresu:

rwatch *0x402013

(niekoniecznie musi to być początek znalezionego regionu). Gdy

teraz uruchomimy wykonanie za pomocą c, nasz program

zatrzyma się w jakimś miejscu. Polecenie bt wyświetli

nam stos wywołanych do tej pory funkcji. Dzięki temu możemy się

zorientować, jakie wywołanie biblioteczne powoduje odwołanie do tego

naszego adresu (ta wiedza jest bardzo nieoczywista, gdy nie mamy do

dyspozycji kodu źródłowego programu). W naszym wyniku zobaczymy, że

jesteśmy gdzieś w środku wywołania

funkcji __printf. Możemy teraz kilka razy użyć

polecenia finish, aby wyjść z wywołania tej

funkcji. Wtedy zaś możemy za pomocą odpowiedniego

polecenia context rozejrzeć się, co doprowadziło do

wypisania danego napisu.

Zabawa ze stosem

Jeszcze raz wystartujmy nasz program od początku. Następnie po

uruchomieniu za pomocą start ustawmy punkt zatrzymania

programu na funkcji process i puśćmy działanie

programu do momentu trafienia na tę funkcję.

Po przyjrzeniu się stosowi możemy zauważyć, że adres powrotu z

procedury process znajduje się tam pod

adresem 0x7fffffffd5f8. Spróbujmy pod ten adres wpisać

jakąś inną wartość:

gdb-peda$ set *0x7fffffffd5f8=0

Jeśli teraz poprosimy GDB o kontynuację działania programu

(c), to okaże się, że program zakończy działanie na

SIGSEGV. To jest łatwe do wytłumaczenia, bo przecież kazaliśmy mu

skoczyć pod adres zerowy. Może ciekawsze jednak będzie, jeśli przed

wykonaniem polecenia set nieco lepiej dobierzemy adres

powrotu. Spróbujmy za pomocą

gdb-peda$ p _exit

dowiedzieć się, pod jakim adresem znajduje się

funkcja _exit (uwaga: koniecznie z podkreśleniem na

początku) i wpisać na stosie zamiast adresu powrotu

z process właśnie ten adres:

set *(int64_t*)0x7fffffffd5f8=0x7ffff7e67520

(tutaj trochę staranności wymaga to, żeby pod wskazany adres trafiła wartość 64-bitowa, a nie 32-bitowa, powyższa forma zagwarantuje nam właśnie takie działanie).

Okazuje się, że tym razem funkcja wychodzi całkiem zgrabnie, bez niepotrzebnego alarmu w postaci błędu segmentacji.

Dalsze lektury

Ćwiczenie

Rozważmy program

#include <stdio.h>

#include <stdlib.h>

void bad_function(void) {

char buff[4];

printf("Podaj mi jakiś napis:");

gets(buff);

printf("Jestem bezpieczny, bufor zawiera: %s\n", buff);

}

void root_me(void) {

printf("Ha, ha, mam Cię!!!\n");

}

int main() {

bad_function();

exit(0);

}

Skompiluj plik wlam.c z powyższym kodem za pomocą polecenia:

gcc -g wlam.c -o wlam

Dla uzyskanego pliku wykonywalnego wykonaj następujące czynności:

- Ustal, jaki adres ma kod funkcji

root_mepo załadowaniu do pamięci. - Ustal, za pomocą GDB, jakiej długości napis spowoduje nadpisanie

adresu powrotu z funkcji

bad_function. - Spreparuj za pomocą polecenia postaci

# echo "odpowiedni napis" | ./wlam

eksploita, który spowoduje wypisanie Ha, ha, mam Cię!!! i poprawne zakończenie programu. (Podpowiedź: do tego ostatniego użyj funkcjiexit, przyda się też lektura podręcznika man dla polecenia echo). - Skrypt zawierający powyżej spreparowane polecenie prześlij do Moodle.

| Załącznik | Wielkość |

|---|---|

| sum.c | 349 bajtów |

| wlam.c | 296 bajtów |

Intermezzo: Narzędzia wspomagające pisanie bezpiecznego kodu

Wprowadzenie

Jednym z najważniejszych pierwotnych źródeł problemów z bezpieczeństwem oprogramowania są błędy programistyczne. Organizacja o nazwie Common Weakness Enumeration zajmuje się śledzeniem wszelkiego rodzaju błędów programistycznych prowadzących do luk w bezpieczeństwie oraz promowaniem technik pozwalających ich uniknąć. Dodatkowo fundacja Open Web Application Security Project zajmuje się śledzeniem błędów występujących w aplikacjach WWW.

Organizacje te publikują swoje rankingi błędów powodujących najgroźniejsze luki w bezpieczeństwie:

Warto się im przyjrzeć.

Warto regularnie przeglądać, aby doskonalić swój warsztat programistyczny.

W związku z tym, że błędy przepełnienia bufora należą do najpoważniejszych, skupimy się nieco właśnie nad nimi.

Błędy przepełnienia bufora

Przyjrzyjmy się dokładniej jednemu z najczęściej pojawiających się błędów prowadzących do luk w bezpieczeństwie. Powaga tego błędu wynika szczególnie z faktu, że może on doprowadzić do nadpisania adresu powrotu z procedury, a to z kolei do wykonania kodu, który został wstawiony do programu jako dane.

Przykłady

Oto kilka przykładów kodu prowadzącego do luk w bezpieczeństwie (zainspirowane materiałami z CWE oraz SEI CERT).

Przykład 1

Pierwszy przykład to rzecz, która zdarza się w zasadzie jedynie nowicjuszom, ale też po wielu godzinach pracy i doświadczonemu programiście uda się taki błąd popełnić.

float grades[2]; /* Populate the array with initial grades. */ grades[0] = 1.0; grades[1] = 2.0; grades[2] = 3.5;

Tablica zadeklarowana jako dwuelementowa nie zmieści w swoim zakresie trzech elementów. W związku z tym, że tablice w C są indeksowane od 0, mamy nieintuicyjną sytuację, że indeks widoczny w deklaracji tablicy nie jest dostępny. Tego rodzaju błędy można wyłapać następującymi narzędziami:

-

cppcheck --enable=all <nazwa_pliku>.c -

clang -Warray-bounds <nazwa_pliku>.c

Przykład 2

#include <stdlib.h>

#include <string.h>

int recordSize(void * p) {

int i = 0;

for (i=0; i < 100;i++) {

if (*((char*)p+i) == 0) return i+1;

}

return -1;

}

int main() {

...

memcpy(destBuf, srcBuf, (recordSize(destBuf)-1));

...

}Funkcja obliczająca długość bufora może dać w wyniku sygnał błędu (-1), który powinien być jawnie sprawdzany. Brak sprawdzenia może spowodować, że zainicjowane zostanie kopiowanie bardzo dużej ilości danych. Tego rodzaju błędy można wyłapać narzędziami, które sprawdzają zgodność typów w sposób ścisły:

-

gcc -Wconversion <nazwa_pliku>.c -

clang -Wconversion <nazwa_pliku>.c

Przykład 3

#include <stdlib.h>

#include <string.h>

#include <stddef.h>

char * transform(char *input_string, size_t len){

int i, j;

char *buf = (char*)malloc(3*sizeof(char) * len + 1);

if (buf==NULL) return NULL;

j = 0;

for ( i = 0; i < strlen(input_string); i++ ){

if( '&' == input_string[i] ){

buf[j++] = '&';

buf[j++] = 'l';

buf[j++] = 't';

buf[j++] = ';';

} else buf[j++] = input_string[i];

}

return buf;

}W tym kodzie błąd polega na tym, że zaalokowana przestrzeń może nie być wystarczająca, ponieważ znak '&' jest zamieniany na cztery znaki, ale przy alokacji jest używany mnożnik 3 – duża liczba znaków '&' spowoduje przekroczenie zakresu zaalokowanej pamięci.

Błędy takie, jak w Przykładzie 3 można wykrywać za pomocą narzędzi takich jak ElectricFence. Narzędzie to działa w ramach testowania działającego programu zawierającego błędny kod. W trakcie działania programu podmieniany jest alokator pamięci tak, że dynamicznie alokowane bufory są umieszczane tak, iż koniec (lub początek) bufora wypada na końcu strony, zaś strona jest ulokowana tak, że następna strona nie jest przydzielona do procesu. Dzięki temu każde wyjście poza zakres bufora kończy się błędem segmentacji.

Badanie, czy występuje tego typu problem wykonujemy za pomocą pakietu ElectricFence przez wywołanie polecenia:

ef <nazwa programu> <parametry wywołania>

gdzie <nazwa programu> to nazwa programu ze skompilowanym kodem z parametrami tak dobranymi, aby doprowadzić do wykonania wadliwego kodu.

O wpisach poza zarezerwowany bufor ostrzeże nas też program valgrind, gdy go wywołamy tak:

valgrind <nazwa programu> <parametry wywołania>

Działa on na podobnej zasadzie, co ElectriFence, ale do wykrywania błędów wykorzystuje nie alokowanie na granicy strony, a zapisywanie na brzegach bufora specjalnych wartości zwanych kanarkami. Powyższe wywołanie da m.in taki wynik

... ==81332== Invalid write of size 1 ==81332== at 0x4011AF: transform (in /somewhere/compiled_code) ==81332== by 0x401265: main (in /somewhere/compiled_code) ==81332== Address 0x4a81060 is 1 bytes after a block of size 31 alloc'd ==81332== at 0x484186F: malloc (vg_replace_malloc.c:381) ==81332== by 0x40115F: transform (in /somewhere/compiled_code) ==81332== by 0x401265: main (in /somewhere/compiled_code) ...

Przykład 4

#include <stdlib.h>

#include <string.h>

void provide_name(char *);

char* give_name(){

char name[64];

provide_name(name);

if (name[0] == '.') return NULL;

char* res = (char*)malloc(64);

if (res==NULL) return NULL;

strcpy(name, res);

return res;

}Tutaj funkcja give_name pobiera z funkcji provide_name nazwę name, ale nigdzie nie jest sprawdzane, czy uzyskany wynik mieści się w 64 bajtach. Funkcja provide_name może w trakcie swojego wykonania spowodować nadpisanie adresu powrotu z funkcji give_name.

Tutaj problem można wykryć za pomocą techniki kanarków. Obecnie jest ona bez problemu wspierana przez współczesne kompilatory. Wystarczy skompilować program tak:

-

gcc -fstack-protector <nazwa_pliku>.c -

clang -fstack-protector <nazwa_pliku>.c

a następnie go uruchomić. Jeśli nastąpi przekroczenie zakresu bufora dostępnego na stosie (name), to przy wychodzeniu z funkcji (give_name) mechanizm wykonawczy sprawdzi, że naruszona została zawartość specjalnie spreparowanych kilku bajtów umieszczonych między buforem a adresem powrotu z procedury. Program zakończy się w tym momencie błędem segmentacji poprzedzonym komunikatem w stylu:

*** stack smashing detected ***: terminated

Warto przyjrzeć się dokumentacji gcc, żeby zobaczyć, jak można wpłynąć na zawartość wspomnianego kanarka.

Nota bene powyższy kod to przykład źle zaprojektowanego interfejsu programistycznego, bo skąd niby funkcja provide_name ma się w swojej treści dowiedzieć, jakiej wielkości bufor może wypełnić danymi?

Przykład 5

#include <string.h>

#include <stdio.h>

void truncend(char *input_string){

int i = strlen(input_string);

while (input_string[--i] != ';');

input_string[i+1] = 0;

}

int main() {

char a[30];

strcpy(a,";ala ma kota");

truncend(a+2);

printf("%s\n", a);

} W kodzie tym, jeśli założymy, że bufor input_string jest prawidłowym napisem zaterminowanym znakiem o kodzie 0, znajduje się błąd polegający na tym, że można wyjść poza bufor wejściowy na jego początku.

Znaleźć błąd w tym kodzie pomoże nam program frama-c. Wywołanie:

frama-c -eva -eva-precision 1 <nazwa programu>.c

da między innymi taki wynik:

[eva:final-states] Values at end of function truncend:

i ∈ {-2; -1; 0; 1; 2; 3; 4; 5; 6; 7; 8; 9}

a[0..12] ∈ [--..--] or UNINITIALIZED

[13..29] ∈ UNINITIALIZED

[eva:final-states] Values at end of function main:

a[0..12] ∈ [--..--] or UNINITIALIZED

[13..29] ∈ UNINITIALIZED

__retres ∈ {0}

S___fc_stdout[0..1] ∈ [--..--]Łatwo wyczytamy z niego, że niespodziewanie zmienna i może tutaj przyjąć wartości ujemne.

Przykład 6

#include <sys/socket.h>

#include <netinet/in.h>

#define MAX_NO_ADDR 100

size_t get_no_addresses();

int main() {

size_t no_addr;

int i;

no_addr = get_no_addresses();

if ((no_addr == 0) || (no_addr > MAX_NO_ADDR)) {

exit(-1);

}

in_addr_t *addrs = (in_addr_t *)malloc(no_addr * sizeof(in_addr_t));

for(i=0; i<no_addr; i++) {

addrs[i] = 0xFFFFFFFF;

}

addrs[no_addr] = 0;

}Tutaj w intencji tablica addrs ma być wypełniona niezerowymi adresami internetowymi, a zerowy adres ma oznaczać koniec tablicy. Błąd polega na tym, że alokacja uwzględnia miejsce na właściwe adresy, ale nie uwzględnia miejsca na terminujący adres zerowy.

W tym i następnym przykładzie zachęcamy Państwa do spróbowania znalezienia błędu za pomocą narzędzi samemu.

Przykład 7

int main() {

...

scanf("%d", &srcBuf);

strncpy(destBuf, &srcBuf[find(srcBuf, ch)], 1024);

...

}Tutaj problematyczne jest użycie funkcji find, która może dać w wyniku -1, gdy znak ch nie występuje w buforze srcBuf. Dodatkowo, jeśli na wartość wskaźnika w srcBuf może wpływać użytkownik, to uzyskuje on narzędzie do wstawienia dowolnej wartości pod adres destBuf.

Standardy kodowania

Oprócz list groźnych błędów wspomniane organizacje publikują także poradniki dotyczące zasad dobrego kodowania:

- Wskazówki dotyczące bezpiecznego kodowania (MISRA) (wymaga zakupienia)

- Poradnik bezpiecznego kodowania OWASP

- Standard kodowania w C opracowany przez SEI CERT (najbogatszy bezpłatny poradnik)

To ostatnie źródło nie pochodzi od omawianych tutaj organizacji, ale jest najbogatszym źródłem porad, które też zawiera informacje, jakie narzędzia wspomagają unikanie poszczególnych rodzajów błędów. Dodatkowo źródło to jest bezpłatne.

Ćwiczenie

Znajdź za pomocą opisanych powyżej narzędzi trzy błędy związane z operacjami na pamięci w kodzie załączonego pliku blad.c (błędy związane z typami całkowitoliczbowymi się nie liczą). Wywołania, które wskazują na błąd, oraz wypisywane przez nich komunikaty zapisz w pliku tekstowym i wyślij go za pomocą Moodle. Uwaga: znalezione błędy niekoniecznie muszą należeć do omówionych powyżej.

blad.c

#include <string.h> #include <stdio.h> #include <stdlib.h> #define ERROR '@' int palindrome_with_error(char* buf, size_t size) { char* tmp; size_t len; size_t i; buf[size] = '\0'; tmp = (char*) malloc(size); if (tmp==NULL) return -1; len = strlen(buf); for (i = len; i>=0; i--) { if (buf[i] == ERROR) return -1; tmp[len-i]=buf[i]; } int res = strcmp(buf, tmp); free(tmp); return res; } int main() { char a[10]; strcpy(a, "aba"); if (palindrome_with_error(a, 3)) printf( "OK\n"); }

Laboratorium 0: zajęcia organizacyjne

Na infrastrukturę komputerową banku Green Forest Bank nastąpił atak włamywaczy. Atak spowodował wyciek informacji o klientach firmy oraz poważne uszkodzenie danych finansowych, co grozi nieobliczalnymi skutkami. Firma już podnosi się z kryzysu. Częścią planu uzdrowienia sytuacji jest wdrożenie nowych zasad bezpieczeństwa. Waszym zadaniem jest wprowadzenie części rozwiązań określonych w zasadach bezpieczeństwa w życie.

Dostaliście zadanie, aby wdrożyć procedury bezpieczeństwa w następującym zakresie:

- Opracowanie drzew ataku, oceniających szanse przeprowadzenia kolejnego ataku na firmę.

- Prawa dostępu i monitorowanie

- ACL - ustawienie wygodnych i bezpiecznych praw dostępu do zasobów banku.

- Syslog - określenie zasad monitorowania systemów banku.

- Badanie plików binarnych

- Przećwiczenie badania narażonych na ataki programów binarnych

- Kontrola dostępu

- Programowanie z biblioteką PAM - stworzenie szkieletu aplikacji dla pracowników firmy z ustanowieniem standardu kodowania.

- Gospodarowanie prawami dostępu z użyciem SUDO - wprowadzenie w życie polityki dostępu do kont o zwiększonych możliwościach działania w ramach firmy.

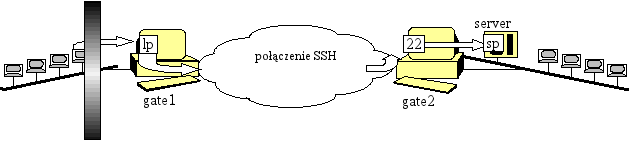

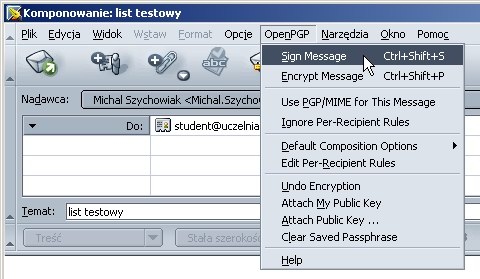

- Szyfrowane kanały komunikacyjne

- Stosowany przez administratorów dostęp zdalny przez SSH

- Kopiowanie plików przez rsync - tworzenie kopii bezpieczeństwa danych banku w zdalnej lokacji

- Podstawy obsługi PGP - szyfrowanie wrażliwych danych banku przy przesyłaniu przez sieć

- Infrastruktura klucza publicznego i kontenery wykonywania

- Konfigurowanie certyfikatów SSL/TLS na potrzeby strony WWW Green Forest Bank

- Konfigurowanie serwera WWW w odseparowanym środowisku (Chroot, Docker)

- Konfigurowanie ściany ogniowej i VPN Green Forest Bank.

- Konfiguracja ścian ogniowych Green Forest Bank za pomocą Iptables

- Konfiguracja połączeń OpenVPN w sieci wewnętrznej

Green Forest Bank.

Zadanie 1. będzie rozwijane przez Was przez cały semestr. Zadania 2-7 będziecie opracowywać na laboratoriach w 6 blokach po 2 zajęcia z treściami merytorycznymi. Za każde z 7 zadań będzie można dostać do 4 punktów. Zatem łącznie w trakcie semestru można dostać do 28 punktów. Uzyskanie 14 lub mniej punktów oznacza brak dopuszczenia do pierwszego terminu egzaminu (do drugiego terminu dopuszczeni są wszyscy). W ostatnim tygodniu zajęć będzie można poprawić zaliczenie jednego z tych bloków.

Szanowni Państwo stawiamy na Waszą samodzielność w uczeniu się. Czytanki, jakie będziecie studiować to daleko nie cała wiedza, jaką musicie opanować na laboratorium. Starajcie się zawsze pogłębiać ich treść samodzielnie przez dodatkowe studiowanie stron man, info oraz dokumentacji narzędzi, z jakich korzystacie.

Bloki dwóch zajęć laboratoryjnych z treściami merytorycznymi będą miały następującą postać:

- na pierwszych zajęciach w bloku na wstępie jest kartkówka (zakres merytoryczny kartkówki jest podany w materiałach do odpowiedniego laboratorium), z kartkówki można dostać do 2 punktów,

- następnie do końca pierwszych zajęć robione jest zadanie (treść zadania będzie dostępna w materiałach do odpowiedniego laboratorium), za zadanie można dostać do 2 punktów (4 punktów łącznie z kartkówką),

- na drugich zajęciach prowadzący sprawdza wykonanie zadania,

- ocena łączna uzyskiwana jest przez odjęcie od oceny za zadanie różnicy między maksymalną ilością punktów za test a liością faktycznie uzyskaną (<ocena> = <wynik z zadania> - (2 - <wynik z testu>)), czyli maksymalna ocena tutaj uzyskana to 4.

Zadania zaliczeniowe z każdych zajęć można zabrać do domu i tam je dokończyć.

Punkty za aktywność na wykładzie będą przydzielane tak:

- do 0,25 punktu na wykład za quizzy na wykładach,

- do 0,75 punktu za pojawienie się co najmniej jednego pytania w sesji pytań do wykładowcy.

Po wykonaniu wszystkich tych zadań dostaniecie przywilej, pozwalający na przystąpienie do egzaminu na adepta sztuki cyberbezpieczeństwa. Za egzamin będzie można dostać do 28 punktów.

Punkty z laboratorium liczą się do oceny także w drugim terminie egzaminu, zatem uzyskanie pozytywnej oceny nawet w drugim terminie bez systematycznej pracy podczas semestru jest niemożliwe.

Egzamin zerowy: po zdobyciu 28 punktów z laboratoriów przy zarejestrowanej aktywności na wykładzie.

Przy okazji tych działań poznacie:

- narzędzia zapewniania poufności, integralności i dostępności informacji oraz modele stojące za nimi;

- narzędzia pozwalające na stosowanie kryptografii, podpisu elektronicznego i infrastruktury klucza publicznego;

- narzędzia wprowadzania uwierzytelniania, kontroli dostępu, bezpieczeństwa protokołów komunikacyjnych i usług aplikacyjnych;

- narzędzia analizy zabezpieczeń, monitoringu systemu, wykrywania ataków oraz ochrony przed nimi.

Materiały do zajęć znajdują się na stronach:

PAM

Plugawe Autoryzacji Moduły: modularne systemy autoryzacji w Linuksie

Cel: umożliwienie elastycznej kontroli dostępu do systemu i programów przez wprowadzenie możliwości definiowania własnych modułów dostępu.

Rozwiązanie: ładowalne moduły autoryzacji (Pluggable Authorization Modules, PAM), popularnie zwane wtyczkami, zawierające specjalizowane procedury związane z bezpieczeństwem, np. procedury identyfikacji oparte o RIPEMD-160, SHA3 czy linie papilarne, ale też nakładanie dodatkowych ograniczeń (np. na liczbę jednoczesnych loginów).

Dla danej aplikacji administrator ustala (plikiem konfiguracyjnym), które z nich i jak mają być użyte.

Wprowadzenie procedur obsługiwanych za pomocą PAM wymaga działań na 3 poziomach:

1. Programista aplikacji:

umieszcza w programie (np. /bin/login) odpowiednie wywołania funkcji dla ładowalnych modułów autoryzacji (no i linkuje program z odpowiednią biblioteką).

2. Programista modułów:

pisze ładowalne moduły autoryzacji zawierające specjalizowane metody identyfikacji (np. RIPEMD-160, SHA3, linie papilarne), które będą używane w aplikacjach.

3. Administrator:

instaluje i modyfikuje pliki konfiguracyjne dla aplikacji i modułów autoryzacji (i zapewne także instaluje moduły w systemie).

Na co dzień najbardziej istotny jest poziom 3.

Struktura systemu PAM dzieli się na 4 w miarę niezależne grupy zarządzania (zwane też typami):

- auth: zarządzanie identyfikacją (jak rozpoznajemy, o którego użytkownika chodzi), uwierzytelnieniem czyli autentyfikacją (jak rozpoznajemy, że dany faktyczny podmiot odpowiada podmiotowi zarejestrowanemu w systemie) oraz podstawowymi formami autoryzacji (jakie podmiot ma prawa do działania w systemie),

- account: zarządzanie kontami i bardziej zaawansowaną autoryzacją: określanie, czy użytkownik ma prawo dostępu do danej usługi, czy może zalogować się o danej porze dnia itp.

- session: zarządzanie sesjami (np. limity),

- password: zarządzanie aktualizacją żetonów identyfikujących (np. haseł).

Niektóre programy, np. login, potrzebują usług z wszystkich czterech grup. Inne, takie jak passwd, mogą korzystać tylko z wybranych grup.

Każda aplikacja chcąca używać PAM ma plik konfiguracyjny zawierający listę modułów dla procesu uwierzytelniania. Nazwa pliku nie musi być zgodna z nazwą aplikacji, często na początek używa się „cudzych”, sprawdzonych plików.