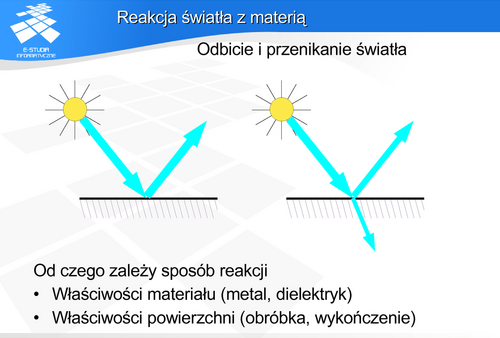

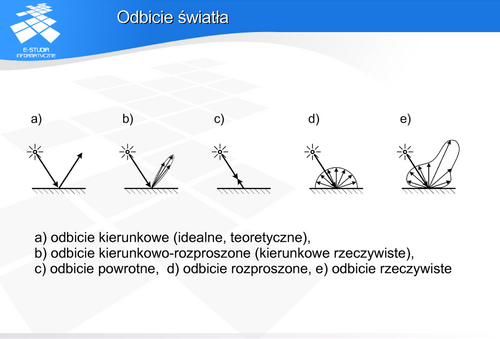

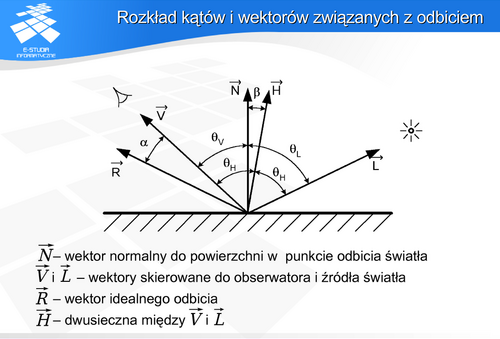

Można wyróżnić dwa niezależne przypadki: odbicie światła i przenikanie światła (dla materiałów przezroczystych). Oczywiście może zachodzić jeszcze pochłanianie, ale z punktu widzenia obserwatora jest to najmniej interesujący przypadek. Dla przypadku odbicia mówimy o odbiciu kierunkowym (lustrzanym) lubrozproszonym (dyfuzyjnym). W pierwszym przypadku padający promień odbija się pod kątem równym kątowi padania. W drugim przypadku odbicie może być widoczne pod dowolnym kątem. Analogiczna sytuacja może zajść dla przenikania światła.

Odbicie światła

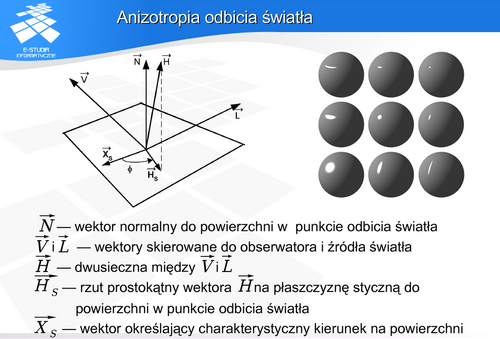

Z anizotropią mamy także do czynienia w przypadku odbicia promieniowania od powierzchni materiału. Wiele powierzchni, zarówno naturalnych, jak i uzyskanych w wyniku technologicznej obróbki odbija światło w sposób anizotropowy, zależny od kierunku jego padania – w sposób zależny od usytuowania powierzchni względem źródła światła. Dobrym przykładem powierzchni wykazującej naturalne właściwości anizotropowe jest powierzchnia drewna. Odbija ona światło zależnie od kata między kierunkiem padania a kierunkiem słojów przekroju. Powierzchnia metalu poddana obróbce mechanicznej (np. polerowaniu) będzie odbijała światło zależnie od kąta między padającym promieniem, a kierunkiem obróbki.

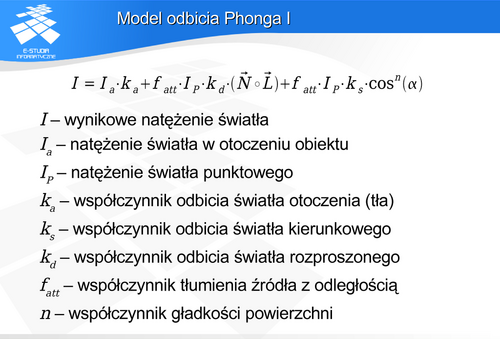

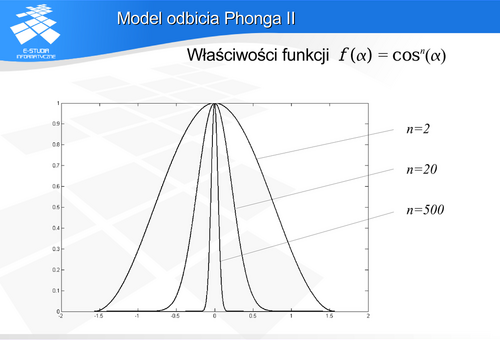

Model odbicia Phonga

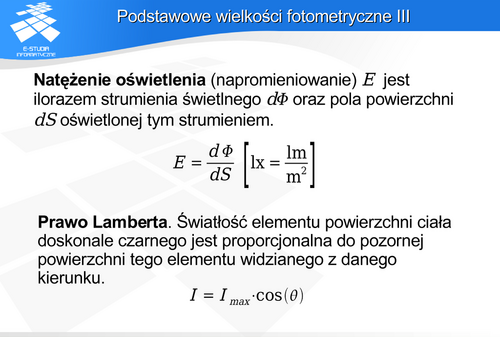

Pierwszy składnik wzoru opisuje światło otoczenia (tła). Zakłada się, że jest ono rozproszone i bezkierunkowe oraz, że na skutek wielokrotnych odbić pada jednakowo pod wszystkimi kierunkami na rozpatrywane powierzchnie. Oczywiście również  jest jednakowe dla wszystkich obiektów. Drugi składnik opisuje odbicie rozproszone tak zwane lambertowskie. Powierzchnie matowe; rozpraszające światło jednakowo we wszystkich kierunkach opisane są prawem Lamberta, zgodnie z którym światłość promieniowania odbitego jest proporcjonalne do kosinusa kata padania. Oczywiście rzeczywiste powierzchnie rozpraszające zachowują się zgodnie z tym prawem tylko w pewnym zakresie kąta. Niemniej jednak taki opis odbicia rozproszonego jest najczęściej stosowany w modelach odbicia. Trzeci składnik opisuje odbicie kierunkowe (zwierciadlane). Maksimum natężenia promieniowania światła odbitego występuje dla zerowego kąta

jest jednakowe dla wszystkich obiektów. Drugi składnik opisuje odbicie rozproszone tak zwane lambertowskie. Powierzchnie matowe; rozpraszające światło jednakowo we wszystkich kierunkach opisane są prawem Lamberta, zgodnie z którym światłość promieniowania odbitego jest proporcjonalne do kosinusa kata padania. Oczywiście rzeczywiste powierzchnie rozpraszające zachowują się zgodnie z tym prawem tylko w pewnym zakresie kąta. Niemniej jednak taki opis odbicia rozproszonego jest najczęściej stosowany w modelach odbicia. Trzeci składnik opisuje odbicie kierunkowe (zwierciadlane). Maksimum natężenia promieniowania światła odbitego występuje dla zerowego kąta  , natomiast potęga

, natomiast potęga  we wzorze charakteryzuje właściwości odbiciowe danego materiału.

we wzorze charakteryzuje właściwości odbiciowe danego materiału.

Warto jeszcze zwrócić uwagę na współczynnik tłumienia źródła światła. Wiemy z fizyki, że strumień światła pochodzący z punktowego źródła światła maleje z kwadratem odległości jaką przebywa. Zastosowanie tej reguły w modelu odbicia Phonga nie daje, niestety, w praktyce dobrych rezultatów. Dla dużych odległości od źródła zmiany są zbyt mało zauważalne, z kolei dla małych odległości zmiany występują zbyt szybko. Okazało się, że w praktyce dobre rezultaty można uzyskać dla współczynnika postaci gdzie

gdzie  jest pewną stałą.

jest pewną stałą.

opisuje odbicie kierunkowe (zwierciadlane) przy czy

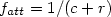

opisuje odbicie kierunkowe (zwierciadlane) przy czy  charakteryzuje dany materiał (właściwości odbiciowe powierzchni). Warto zwrócić uwagę na właściwości tej funkcji. Idealne odbicie kierunkowe to takie, w którym odbicie występuje tylko dla zerowego kąta

charakteryzuje dany materiał (właściwości odbiciowe powierzchni). Warto zwrócić uwagę na właściwości tej funkcji. Idealne odbicie kierunkowe to takie, w którym odbicie występuje tylko dla zerowego kąta  (to znaczy poza tym kątem natężenie światła odbitego jest zerowe). Funkcja

(to znaczy poza tym kątem natężenie światła odbitego jest zerowe). Funkcja  opisuje taki przypadek dla

opisuje taki przypadek dla  dążącego do nieskończoności. Zatem im większa wartość

dążącego do nieskończoności. Zatem im większa wartość  tym bardziej powierzchnia zbliża się do powierzchni lustrzanej. Tym lepsze właściwości kierunkowe charakteryzują odbicie od tej powierzchni. W praktyce już dla

tym bardziej powierzchnia zbliża się do powierzchni lustrzanej. Tym lepsze właściwości kierunkowe charakteryzują odbicie od tej powierzchni. W praktyce już dla  rzędu kilkuset mamy do czynienia z dobrym lustrem.

rzędu kilkuset mamy do czynienia z dobrym lustrem.

do prawej zbliżającej się do właściwości lustrzanych.

do prawej zbliżającej się do właściwości lustrzanych.

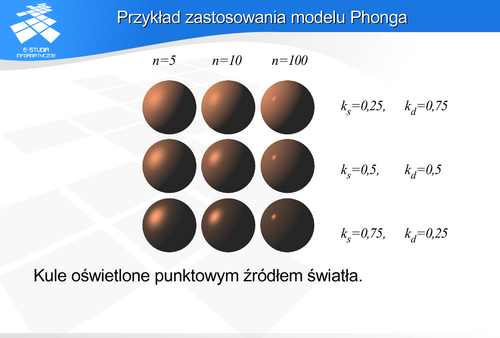

Światłość jest gęstością kątową strumienia świetlnego. Jednostką światłości jest kandela – należąca do siedmiu podstawowych jednostek miar.

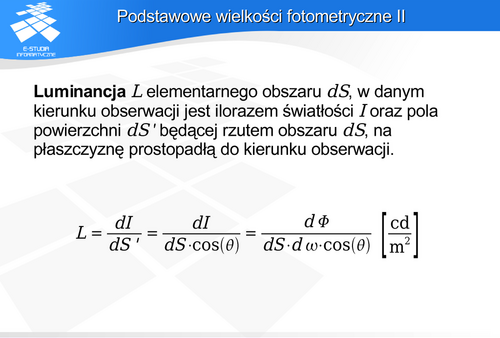

Luminancja nie zależy od odległości od obiektu. Jeśli rozpatrzymy źródło światła i wszystkie parametry geometryczne są stałe, to luminancja źródła jest proporcjonalna do energii emitowanej przez źródło.

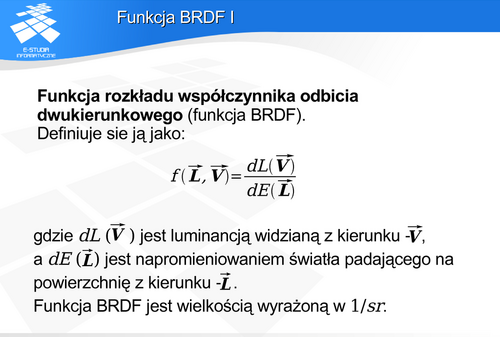

definiuje się jako iloraz luminancji obserwowanej z kierunku

definiuje się jako iloraz luminancji obserwowanej z kierunku , do natężenia napromieniowania światła padającego z kierunku

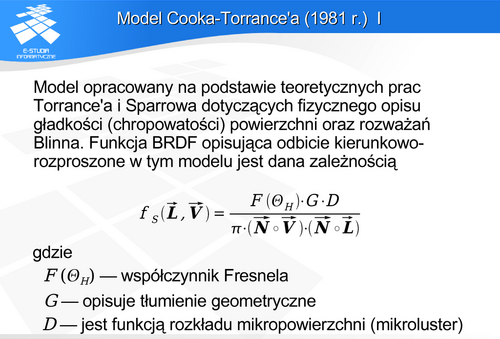

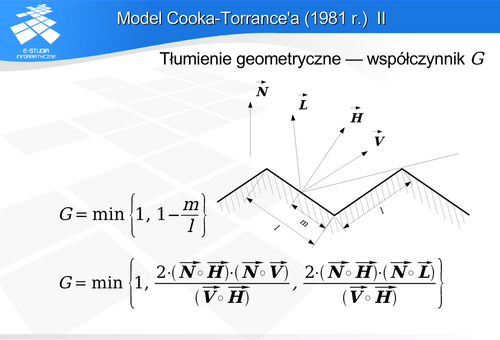

, do natężenia napromieniowania światła padającego z kierunku  . Znane funkcje BRDF można podzielić na dwie grupy : zależności opracowane eksperymentalnie i zależności mające podłoże fizyczne. Pierwszą grupę stanowią zależności, których opis matematyczny został eksperymentalnie dobrany do oczekiwanych (lub zmierzonych) efektów. Nie mają one żadnego uzasadnienia teoretycznego, ale są dobrą aproksymacją rzeczywistych zjawisk - dają dobre rezultaty. Drugą grupę stanowią opracowania, które powstały na podstawie odpowiedniej teorii fizycznej opisującej gładkość (chropowatość) powierzchni.

. Znane funkcje BRDF można podzielić na dwie grupy : zależności opracowane eksperymentalnie i zależności mające podłoże fizyczne. Pierwszą grupę stanowią zależności, których opis matematyczny został eksperymentalnie dobrany do oczekiwanych (lub zmierzonych) efektów. Nie mają one żadnego uzasadnienia teoretycznego, ale są dobrą aproksymacją rzeczywistych zjawisk - dają dobre rezultaty. Drugą grupę stanowią opracowania, które powstały na podstawie odpowiedniej teorii fizycznej opisującej gładkość (chropowatość) powierzchni.

.

.

Drugim warunkiem jest zasada zachowania energii, zgodnie z którą suma całkowitej energii wypromieniowanej na skutek odbicia światła od powierzchni jest nie większa niż energia światła padającego.

Modele odbicia światła

Znane jest również uproszczenie modelu Cooka-Torrance’a - model Schlicka, zaproponowany w 1994 roku. Autor starał się dokonać uproszczenia z zachowaniem fizycznego charakteru modelu pierwotnego, ale znacznie podnieść atrakcyjność obliczeniową. W modelu Cooka-Torrance’a w równaniu zastąpione zostały wielkości G i D (funkcja rozkładu Beckmanna) prostszymi funkcjami wymiernymi.

(kąta

(kąta  w przypadku modelu Phonga). Spełnienie zasady zachowania energii wymaga, aby funkcja dystrybucji spełniała warunek normalizacji. Oznacza to dla powierzchni izotropowych następującą zależność:

w przypadku modelu Phonga). Spełnienie zasady zachowania energii wymaga, aby funkcja dystrybucji spełniała warunek normalizacji. Oznacza to dla powierzchni izotropowych następującą zależność:

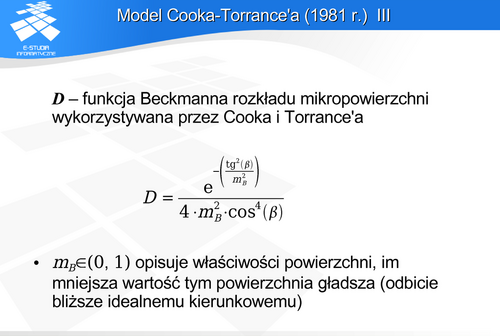

Autorzy funkcji dystrybucji nie zawsze dbali o spełnienie tego warunku. Czasem dopiero niezależne prace późniejsze doprowadzały do spełnienia zasady zachowania energii – tak było np. w przypadku modelu odbicia Phonga.

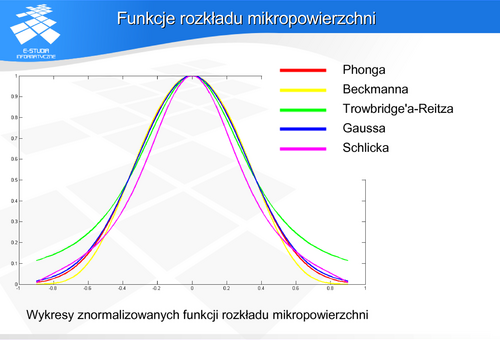

Aby móc porównywać różne funkcje dystrybucji, na rysunku są pokazane funkcje znormalizowane (oznaczone jako  ) tzn. takie, że

) tzn. takie, że  . Oczywiście dla dowolnej funkcji dystrybucji jej maksimum występuje dla

. Oczywiście dla dowolnej funkcji dystrybucji jej maksimum występuje dla  . Istnieje wiele różnych funkcji dystrybucji. Ze względu na podobny charakter zmienności, Blinn sugerował możliwość zastąpienia jednej z nich drugą. Czasami może to być opłacalne obliczeniowo, jednak może powodować powstanie drobnych różnic na rysunku.

. Istnieje wiele różnych funkcji dystrybucji. Ze względu na podobny charakter zmienności, Blinn sugerował możliwość zastąpienia jednej z nich drugą. Czasami może to być opłacalne obliczeniowo, jednak może powodować powstanie drobnych różnic na rysunku.

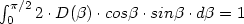

Schlick zaproponował dobrą aproksymację tej funkcji (według autora aproksymacji błąd mniejszy niż 1%). Opisuje ją wielomianowa funkcja kąta i wartość współczynnika  dla zerowego kąta i określonej długości fali. Wartości

dla zerowego kąta i określonej długości fali. Wartości  są podawane przez tablice materiałowe.

są podawane przez tablice materiałowe.

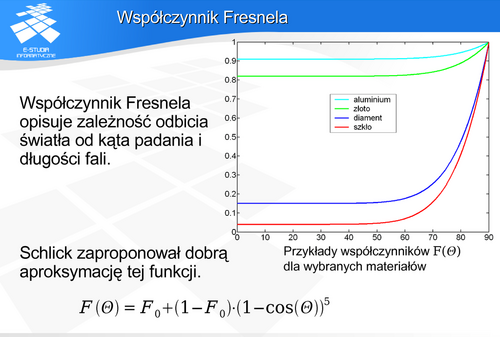

Model Warda (1992)

Model Warda niestety nie uwzględnia współczynnika Fresnela, co nie daje możliwości opisania w pełni właściwości materiałowych i uwzględnienia zależności kątowych. Jest to szczególnie widoczne dla dużych kątów padania światła.

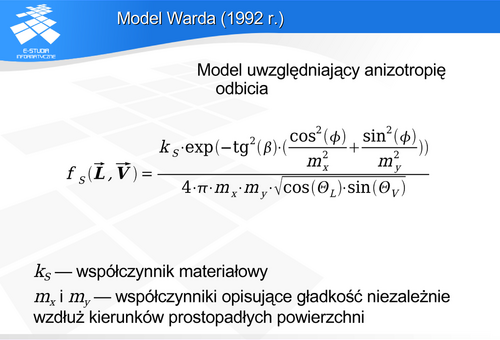

Model Orena-Nayara (1994 r.)

Oren i Nayar opracowali model, w którym przybliżyli powierzchnię obiektu powierzchnią wielościenną. Założyli, że obiekt pokryty jest wgłębieniami typu V (podobnie jak w modelu Cooka-Torrance’a). Przy czy w modelu Orena i Nayara mikropowierzchnie nie są lustrzane ale rozpraszają w sposób lambertowski. To znaczy dla każdej pojedynczej mikropowierzchni jest stosowany Lambertowski model odbicia. Dla takiego modelu powierzchni Oren i Nayar zastosowali rozkład Gaussa kierunku wektora normalnego do powierzchni wielościennej. W efekcie uzyskali model uwzględniający wzajemne zasłanianie powierzchni wielościennej typu V ale przy lambertowskim odbiciu od mikropowierzchni. Ponieważ uzyskany opis był zbyt skomplikowany do zastosowań praktycznych, zaproponowali aproksymację prostymi równaniami.

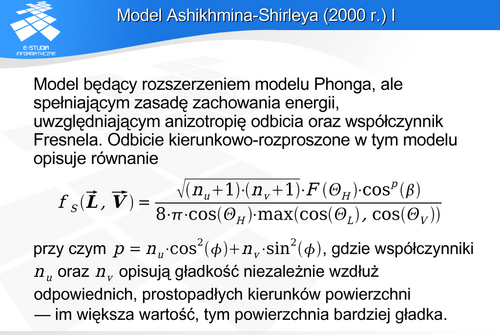

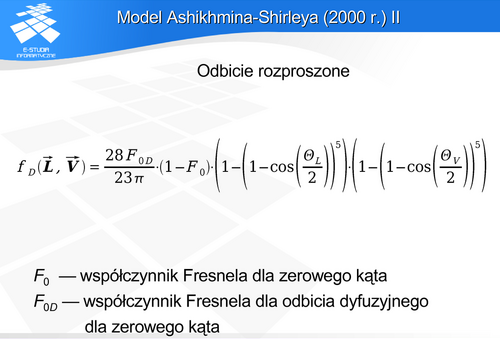

Model Ashikhmina-Shirleya (2000 r.)

Spełnia wszystkie podstawowe wymagania (zasada wzajemności, zasada zachowania energii, uwzględnia współczynnik Fresnela odbicia światła). Pozwala uwzględnić anizotropię odbicia. Został sformułowany w taki sposób, że może być wykorzystywany w dowolnych obliczeniach graficznych – także we wszystkich wariantach metody śledzenia promieni. (Model He nie może być wykorzystywany w algorytmach typu Monte Carlo.) Ma dodatkowo jeszcze jedną zaletę: jest modelem atrakcyjnym obliczeniowo.

Jednocześnie trzeba podkreślić, że jest to inne podejście do opisu odbicia rozproszonego niż w modelu Orena i Nayara. W modelu Ashikhmina I Shirleya wykorzystano opis oparty na pomyśle Schlicka aproksymacji wielomianowej.

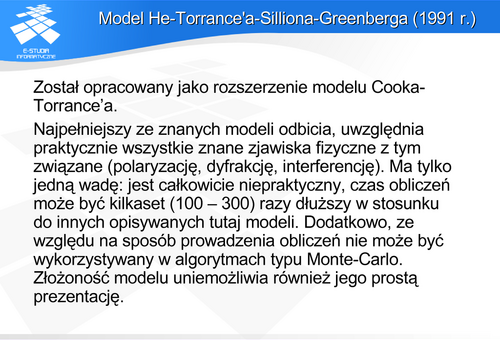

Model He-Torrance'a-Silliona-Greenberga (1991 r.)

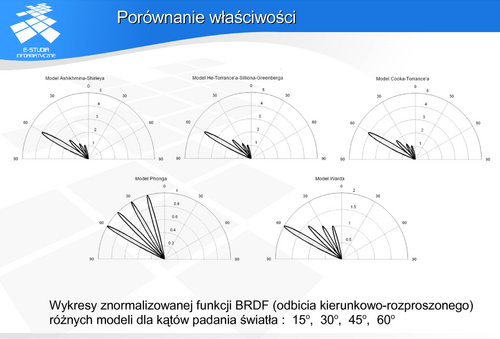

Jak widać modele Cooka-Torrance’a, Ashikhmina-Shirleya, He-Torrance’a-Silliona-Greenberga i Warda wykazują zbliżone kształty funkcji BRDF dla różnych kątów padania światła. Przy czym zależności Warda dają inne proporcje zależności kątowych. Model ten nie uwzględnia współczynnika Fresnela. Stąd wartości maksymalne w opisie Warda odbiegają od wartości w modelachCooka-Torrance’a, Ashikhmina-Shirleya, He-Torrance’a-Silliona-Greenberga. Jako punkt odniesienia przyjmuje się model He-Torrance’a-Silliona-Greenberga. Badania doświadczalne pokazały, że najlepiej opisuje on zachowanie rzeczywistych powierzchni. Niemniej jednak ze względu na złożoność obliczeniową i jednocześnie bardzo zbliżone właściwości (rysunek) modele Cooka-Torrance’a orazAshikhmina-Shirleya są atrakcyjniejsze. Warto pamiętać jednocześnie, że model He-Torrance’a-Silliona-Greenberga nie może być stosowany w odmianach metody śledzenia promieni, gdzie wymagana jest funkcja gęstości prawdopodobieństwa. Model Phonga nie pasuje do pozostałych, gdyż w ogóle nie uwzględniono w nim ani kąta padania, ani współczynnika Fresnela.

Inne sposoby opisu odbicia światła

Modele wielowarstwowe (np. model Hanrahana i Kreugera z 1993 roku). Wiele obiektów odbija światło wielowarstwowo. Z jednej strony materiały dielektryczne odbijają w sposób rozproszony dzięki tak zwanemu odbiciu objętościowemu. Światło wnika w materiał i po wielokrotnych odbiciach od cząstek materiału, część tego światła wychodzi na zewnątrz, tworząc składową rozproszoną odbicia. Z drugiej strony często mamy do czynienia z materiałami zbudowanymi z warstw o różnej przenikalności światła (i innych właściwościach odbiciowych). Dobrym przykładem jest skóra, której naturalna barwa jest bardzo trudna do uzyskania bez modeli wielowarstwowych. Do tego dochodzą materiały po prostu pokryte farbami lub innymi warstwami zmieniającymi właściwości odbiciowe.

Zamiast próbować modelować skomplikowaną strukturę i właściwości powierzchni można zmierzyć właściwości odbiciowe i na tej podstawie zbudować tablicowaną funkcję BRDF. Oczywiście problem polega na tym, że żeby model pomiarowy był użyteczny to pomiary musza być dokonane z rozdzielczością wymaganą w obliczeniach związanych z danym obrazem i obiektem. Z drugiej strony wybrana próbka musi być reprezentatywna dla danego materiału.

Jeżeli funkcję BRDF potraktować jako funkcję kątów w układzie sferycznym, to naturalnym sposobem opisu, będzie aproksymacja w postaci harmonicznych sferycznych (np. prace Westina z 1992 roku). Dzięki temu można rozłożyć opis odbicia na zestaw składowych, które mogą być używane z określoną dokładnością. Jeśli nie są potrzebne szczegóły powierzchni to można użyć prostszego zestawu opisu funkcji BRDF – bez składowych wyższych harmonicznych. Stosowane są również inne formy opisu aproksymacji: z wykorzystaniem wielomianów Zernike lub metodami falkowymi.

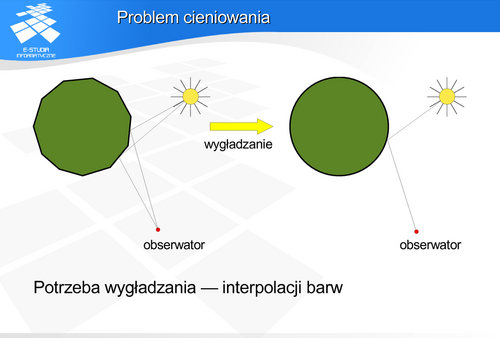

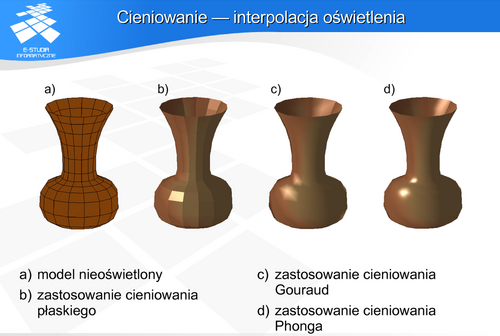

- Cieniowanie płaskie (cieniowanie stałą wartością), gdy cały wielokąt jest wypełniony taką samą barwą.

- Cieniowanie Gouroud.

- Cieniowanie Phonga.

Cieniowanie płaskie jest zgodne z rzeczywistością, gdy obserwator lub źródło światła znajduje się w nieskończoności. Może być także stosowane, gdy wielokąt reprezentuje rzeczywiście powierzchnię modelowaną – mamy wtedy do czynienia z rzeczywistą powierzchnią wielościenną. Jeżeli jednak złożony kształt powierzchni obiektu jest przybliżony wielościanem, to można za pomocą cieniowania wygładzić obiekt niwelując wielościenny charakter.

W pierwszym etapie wyznaczamy (hipotetyczną) barwę w wierzchołkach wielościanu. W tym celu wyznaczamy hipotetyczny wektor normalny jako średnią arytmetyczną wektorów normalnych wszystkich ścian, do których ten wierzchołek należy. Następnie na podstawie wektora normalnego wyznaczamy barwę wierzchołka korzystając z wybranego modelu odbicia światła. W drugim etapie dokonywana jest liniowa interpolacja barwy zgodnie z zaprezentowanymi wzorami.

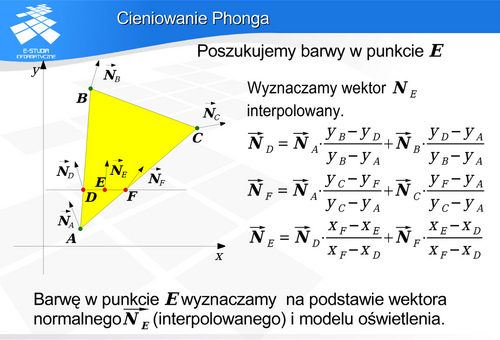

W pierwszym etapie wyznaczamy wektor normalny w wierzchołku w ten sam sposób jak w cieniowaniu Gouraud. W drugim etapie wyznaczamy interpolowany wektor normalny dla każdego piksela (to znaczy dla punktu powierzchni odpowiadającego pikselowi). Następnie wyznaczamy barwę piksela, na podstawie interpolowanego wektora normalnego korzystając z wybranego modelu odbicia światła.

Obie metody zapewniają ciągłą zmianę barwy eliminując skokowe zmiany cieniowania płaskiego. Cieniowanie Gouraud nie daje możliwości powstania lokalnego ekstremum (np. rozbłysku światła) w ramach jednego elementu płaskiego. Powoduje to uśrednienie jasności na powierzchni obiektu. Cieniowanie Phonga nie ma tej wady. Interpolacja wektora oddaje poprawnie lokalne ekstrema również w ramach pojedynczego elementu płaskiego. Cieniowanie Gouraud dopuszcza, niestety, powstawanie pasm Macha. Wady tej jest praktycznie pozbawione cieniowanie Phonga. Wadą cieniowania Phonga jest fakt, że jest ono ponad dwukrotnie droższe obliczeniowo od cieniowania Gouraud.

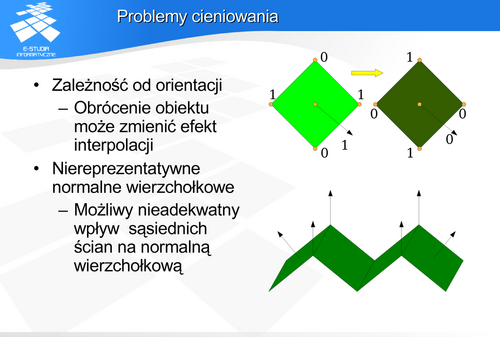

Obie metody są wrażliwe na orientację cieniowanego obiektu. Jeśli obiekt ma różne jasności w wierzchołkach i zostanie obrócony, to interpolacja da różne efekty w zależności od położenia obiektu. W obu metodach liczy się hipotetyczny wektor normalny w wierzchołku wielościanu na podstawie średniej arytmetycznej wektorów normalnych sąsiadujących ścian. Może to spowodować powstanie błędnie skierowanych wektorów interpolowanych. Na dolnym rysunku wektory interpolowane wewnętrznych ścian będą inaczej skierowane niż rzeczywiste wektory normalne. Dodatkowo powstaje nieoczekiwany wpływ ścian sąsiednich. Ruch jednaj ściany zewnętrznej spowoduje zmianę hipotetycznego wektora normalnego w wierzchołku (przez wpływ na średnią), a w konsekwencji tego zmianę wektora interpolowanego ściany wewnętrznej.

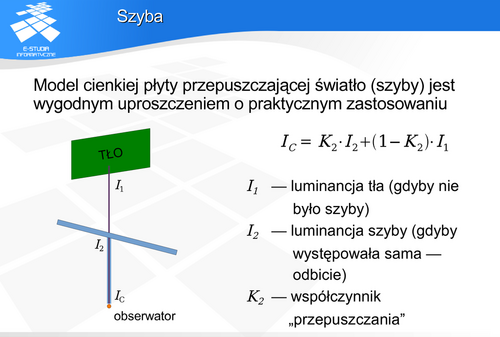

Szyba