Z drugiej strony barwa biała (np. światła słonecznego) zawiera wszystkie składowe barwne. I jest efektem addytywnego mieszania tych wszystkich składowych.

Mieszanie subtraktywne jest mieszaniem farb. Farba jest substancją pochłaniającą składowe promieniowania o określonej długości fali. Np. farba niebieska pochłania wszystkie składowe oprócz niebieskiej. A więc jeśli oświetlimy niebieską powierzchnię światłem białym to odbije ona tylko promieniowanie niebieskie i taką barwę postrzegamy.

Wypadkowa mieszania subtraktywnego dąży do czerni. (Znany z przedszkola eksperyment: co powstanie ze zmieszania wszystkich farb z palety?)

Barwy dopełniające to dwie takie barwy, których mieszanie addytywne daje biel, a subtraktywne czerń.

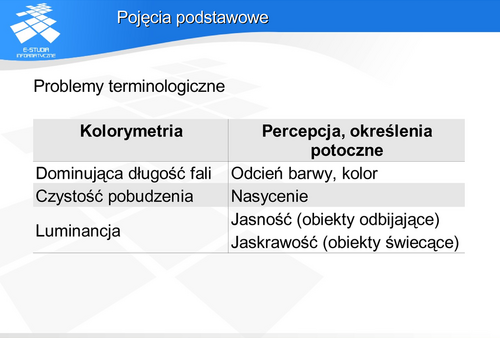

Pojęcia podstawowe

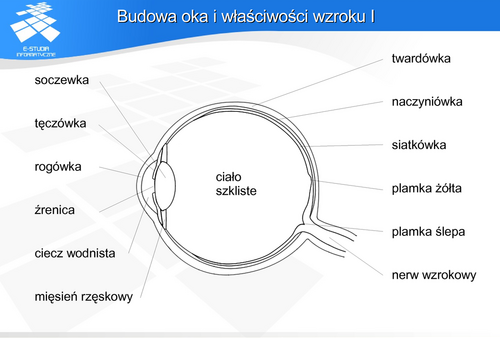

Warto dodać, że para oczu daje człowiekowi możliwość oceny odległości. Jeśli patrzymy na zbliżający się obiekt, to osie optyczne obu gałek przecinają się pod coraz większym kątem. Analiza tego kąta przez mózg pozwala wnioskować o odległości do obiektu. Z drugiej strony jednak, analiza odległości i położenia w przestrzeni jest dokonywana na podstawie postrzeganych wzajemnych relacji (np. wzajemnego zasłaniania) między przedmiotami, akomodacji oraz zdobytego doświadczenia. Na tej podstawie osoby, które utraciły jedno oko również potrafią ocenić odległości.

Zdobyte doświadczenie jest również wyjaśnieniem problemu postrzegania świata „do góry nogami”. Soczewka oka odwraca obraz i dopiero mózg interpretuje obraz właściwie. Nie jest to umiejętność wrodzona ale nabyta. Dziecko do ok. pół roku nabiera doświadczeń ruchowych i najprawdopodobniej dopiero wtedy następuje odwrócona interpretacja.

Na siatkówce jest ok. 120 mln pręcików i ok. 6 mln czopków. Receptory te są rozłożone nierównomiernie na siatkówce w okolicach plamki żółtej (zwanej też dołkiem centralnym), przy czym pręciki znajdują się na całej siatkówce poza plamką żółtą, natomiast czopki głównie w plamce żółtej. Połączenie nerwu wzrokowego z siatkówka tworzy tzw. plamkę ślepą na, której nie ma żadnych receptorów. Plamka żółta pokrywa kąt ok. 1 stopnia pola widzenia. Gęstość czopków jest tam największa – rozmieszczone są one tak, że odległość między ich środkami jest równa ich średnicy (ok. 0,002 mm). Poza tym polem gęstość receptorów gwałtownie spada. Pręciki, mimo że na całej siatkówce, to także rozmieszczone są nierównomiernie. Ich największe skupienie występuje w odległości kątowej ok. 15 stopni od plamki żółtej (dlatego o widzeniu nocnym mówimy, że jest widzeniem peryferyjnym). Gęstość rozmieszczenia receptorów jest związana z rozdzielczością widzenia, czyli minimalną odległością między punktami, które są postrzegane w postaci dwóch niezależnych punktów a nie jednej plamy. Doświadczalnie stwierdzono, że maksymalna rozdzielczość oka ludzkiego wynosi ok. 1 minuty kątowej. Rozdzielczość tę nazywa się minimum separabile.

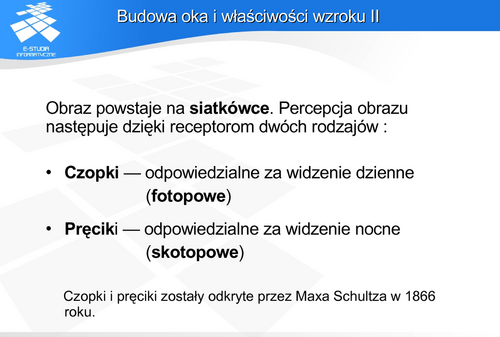

Podstawowe różnice między receptorami decydują o sposobie postrzegania świata przez człowieka.

Czopki pozwalają na rejestracją wrażeń barwnych i rozróżnianie odcieni barwnych. Do pobudzenia wymagają dużej ilości światła - odpowiadają za widzenie dzienne, nazywane fotopowym.

Pręciki pozwalają na rejestrację tylko odcieni szarości, do pobudzenia wystarczy im wielokrotnie mniej światła – odpowiadają za widzenie nocne. W nocy widzimy bez barw („w nocy wszystkie koty są czarne”), główne kształty i kontury.

Warto zwrócić uwagę na połączenia receptorów z mózgiem. Liczba połączeń nerwowych siatkówki w nerwie wzrokowym wynosi ok. 1 mln (wobec ok. 126 mln receptorów). A zatem nie ma odpowiedniości 1 receptor – 1 połączenie. Już na etapie przetwarzania na siatkówce obraz poddawany jest „kompresji”. Połączenia nerwowe doprowadzone są do tzw. jednostek receptorowych – pól, które grupują receptory. Jednostki plamki żółtej obejmują po jednym receptorze (czopku), natomiast poza nią grupują od kilkudziesięciu do kilkuset receptorów. W ramach plamki żółtej każdy receptor (czopek) jest więc indywidualnie połączony z nerwem wzrokowym. Szacuje się że te kilka procent powierzchni siatkówki tworzy ok. 50 % połączeń. Reszta obejmuje pozostały obszar siatkówki.

Czopki i pręciki maja również różne zależności pobudzenia od długości fali. Kształt zależności w obu przypadkach jest praktycznie identyczny – jest to krzywa dzwonowa obejmująca prawie cały obszar promieniowania widzialnego. Ale maksima tych krzywych są przesunięte. Dla widzenia dziennego (fotopowego) jest to ok. 555 nm, dla widzenia nocnego (skotopowego) ok. 515 nm. Efektem tego jest wrażenie, że powierzchnie niebieskozielone postrzegamy w nocy jako jaśniejsze niż w dzień, natomiast żółtoczerwone jako ciemniejsze (efekt Purkiniego).

Stan pośredni między widzeniem skotopowym a fotopowym (o świcie i o zmierzchu) nazywamy widzeniem mezopowym.

Przyjmuje się, że na siatkówce człowieka występują czopki pobudzane przez fale elektromagnetyczne o długości odpowiednio:

Percepcja barw jest procesem subiektywnym. Oznacza to, że każdy postrzega barwy w inny sposób. Możliwe są również minimalne różnice między lewym a prawym okiem.

Do tego trzeba dodać różnice interpretacyjne zależne od doświadczeń i kultury. Znane są różnice łączenia barw z emocjami uwarunkowane kulturowo (np. postrzegania bieli i czerni).

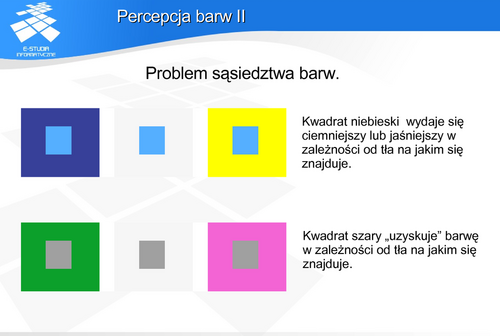

Problem sąsiedztwa barw.

Pomimo identyczności pobudzenia receptorów siatkówki przez barwę danej plamy, jej otoczenie / sąsiedztwo wpływa na wytworzenie określonych wrażeń.

Problem oświetlenia.

Zmiana składowych światła oświetlającego plamę barwną wpływa na zestaw składowych odbitych od tej plamy. Receptory są pobudzone składowymi zależnymi od odbicia.

Każdą dowolną barwę można przedstawić za pomocą trzech składowych – barw podstawowych (takich, że żadna z nich nie jest wypadkową dwóch pozostałych – są niezależne kolorymetrycznie).

Zasada ciągłości

Jeśli mamy do czynienia z mieszaniną dwóch barw, to ciągła zmiana jednej składowej powoduje ciągłą zmianę mieszaniny.

Zasada addytywności

Barwa mieszaniny nie zależy od jej składu widmowego tylko od barw składników.

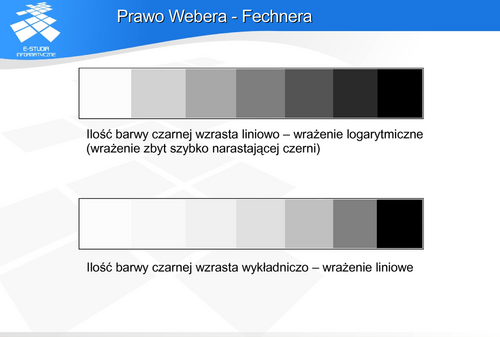

Prawo Webera - Fechnera

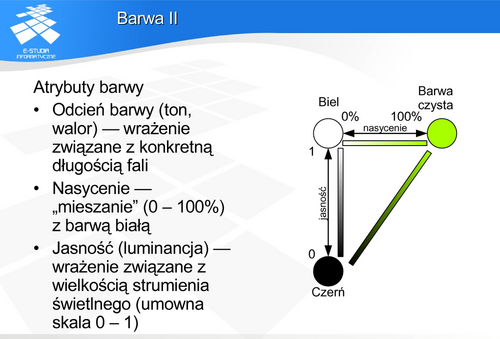

Badania wykazały, że zachodzi percepcyjny związek między atrybutami barwy. Zmiana jednego z nich pociąga za sobą zmiany pozostałych.

Warto pamiętać o tym nawet podczas najprostszej obróbki obrazów (np. zdjęć cyfrowych). Zmiana jasności albo kontrastu może spowodować nienaturalny wygląd (postrzegalną zmianę barw) przedmiotów na zdjęciu.

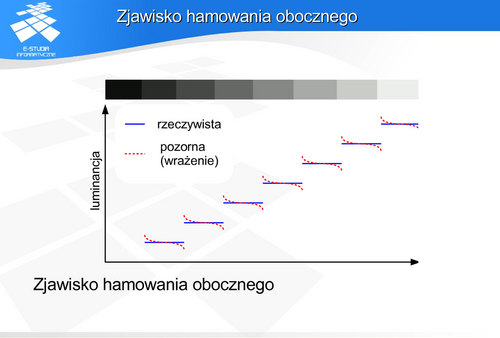

Receptory siatkówki wpływają wzajemnie na proces percepcji barwy. Jest to widoczne na granicy pól o różnej luminancji. Receptory odbierające barwę jaśniejszą są pobudzane przez sąsiednie receptory odbierające barwę ciemniejszą. W odwrotnej sytuacji receptory odbierające barwę ciemniejszą są blokowane. Działanie takie powoduje wrażenie zwiększenia kontrastu na granicy luminancji.

Mechanizm ten jest bardzo użyteczny dla człowieka. Potrafimy dzięki temu dostrzec szczegóły przy słabym oświetleniu (np. czytać o zmierzchu). Ale zły dobór barw np. przy realizacji ciągłej zmiany między dwiema określonymi barwami zostanie natychmiast wychwycony przez oko. Powstają wtedy tzw. pasma Macha.

Z jednej strony może być tak, że np. gazeta została wydrukowana dwoma rodzajami czarnej barwy i w warunkach drukarni różnice nie były w ogóle widoczne. Zauważyli je dopiero czytelnicy w innych warunkach oświetleniowych.

Z drugiej strony istnieją zestawy barw, które wyglądają identycznie pomimo otrzymywania ich z różnych składowych. Przykładem może być barwa czerwona którą otrzymywano z drogich składników, ze względów finansowych zastąpiono innymi – tańszymi. Mimo różnego rozkładu widmowego wrażenie jest identyczne. Metameryzm stanowi bardzo poważny problem w poligrafii.

Oko nie jest miernikiem składowych widmowych barwy.

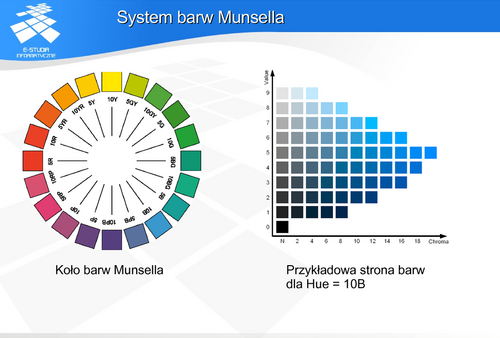

Odcień barwy oznaczony H (od ang. Hue) tworzy okrąg. Został on podzielony na 10 głównych segmentów, a te z kolei na 10 segmentów pośrednich. System oznaczeń literowo-cyfrowych pozwala odnaleźć właściwy segment. Opisuje on położenie na zasadzie odległości kątowej od początku segmentu liczonej zgodnie z ruchem wskazówek zegara. W ten sposób zdefiniowano 100 różnych odcieni barw. Wartość (jasność) oznaczone V (od ang. Value) zestawiono w 10 poziomach przy czym oba poziomy skrajne są teoretyczne (nie są realizowalne praktycznie).. Nasycenia oznaczone C (od ang. Chroma) jest przedstawione w postaci odległości od osi V barw w pełni nienasyconych.

Atlasy barw Munsella zawierają 100 tablic dla różnych odcieni. Na każdej tablicy znajduje się 9 poziomów wartości i od 1 do 28 poziomów nasycenia.

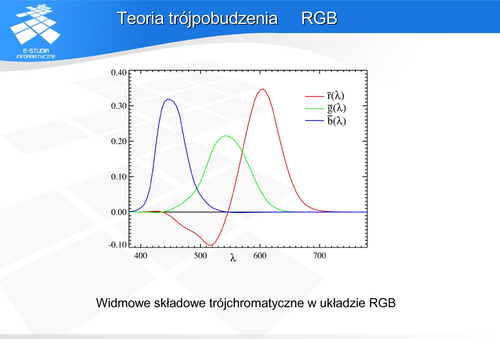

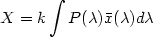

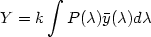

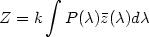

. Definiują one barwy X Y Z w postaci:

. Definiują one barwy X Y Z w postaci:

gdzie  jest rozkładem energetycznym strumienia świetlnego, k jest współczynnikiem dobieranym tak aby maksymalna wartość Y wyniosła 100.

jest rozkładem energetycznym strumienia świetlnego, k jest współczynnikiem dobieranym tak aby maksymalna wartość Y wyniosła 100.

Barwa Y została tak zdefiniowana, aby krzywa składowej  odpowiadała dokładnie krzywej czułości oka na światło o stałej luminancji. W ten sposób składowa

odpowiadała dokładnie krzywej czułości oka na światło o stałej luminancji. W ten sposób składowa  odpowiada informacji o strumieniu światła, natomiast pozostałe dwie składowe odpowiadają wyłącznie za informacje o barwie.

odpowiada informacji o strumieniu światła, natomiast pozostałe dwie składowe odpowiadają wyłącznie za informacje o barwie.

Barwy podstawowe, które zostały wybrane do tego modelu są barwami teoretycznymi – leżą poza zakresem widzialnym. Nie są więc realizowalne fizycznie. Dodatkowo trzeba zwrócić uwagę na fakt, że składowa  ma dwa maksima.

ma dwa maksima.

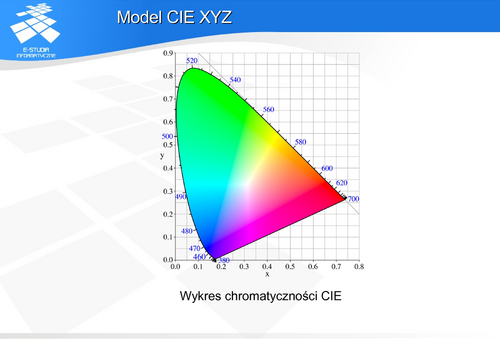

. Jest to równanie płaszczyzny w przestrzeni barw. Płaszczyznę te przedstawia się najczęściej w postaci rzutu na płaszczyznę xy. Tak powstaje wykres chromatyczności układu CIE XYZ.

. Jest to równanie płaszczyzny w przestrzeni barw. Płaszczyznę te przedstawia się najczęściej w postaci rzutu na płaszczyznę xy. Tak powstaje wykres chromatyczności układu CIE XYZ.

Na obwodzie wykresu znajdują się barwy nasycone odpowiadające określonym długościom fali.

Przestrzeń barw CIE XYZ jest przestrzenią liniowa. Oznacza to, że w przestrzeni tej obowiązuje prawo dodawania wektorów i mnożenia wektora przez skalar. Dzięki temu można wyznaczać w prosty sposób barwy wynikowe np. mieszania barw.

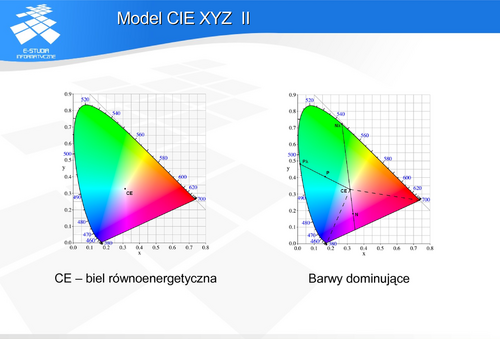

Z punktu widzenia budowy modelu CIE XYZ uzasadnionym punktem bieli jest punkt o jednakowych współrzędnych tzn.

Barwa o takich współrzędnych nosi nazwę bieli równoenergetycznej i została zaznaczona na wykresie jako punkt CE (często oznaczany również E). W przypadku światła słonecznego mówi się o jego przybliżeniu w postaci standardowego światła białego odpowiadającego światłu dziennemu dla skorelowanej temperatury barwowej 6774 K. Jest to tzw. iluminat C (biel C) o współrzędnych  .

.

Osoby zajmujące się fotografią tradycyjna wiedzą, że sprzedawane materiały fotograficzne dostosowane są do dwóch różnych parametrów bieli. Albo do światła o temperaturze 6500 K (światła naturalnego; dziennego), albo do światła o temperaturze 3200 K (sztucznego ; żarowego). Wykonanie zdjęcia na pierwszym materiale przy świetle sztucznym daje efekt „zażółcenia”, na drugim materiale w świetle słonecznym efekt „zaniebieszczenia”.

Jeśli punkt CE odpowiada bieli (barwie w pełni nienasyconej) a punkt na obrzeżu „podkowy” wykresu chromatyczności barwie czystej (w pełni nasyconej) to połączenie tych punktów odcinkiem wyznacza zmiany nasycenia barwy. W takim razie dla dowolnej barwy np. dla punktu P na wykresie można wyznaczyć odpowiadającą jej barwę czystą czyli barwę dominującą (punkt  ). Powstaje problem z punktami takimi jak N na wykresie. Dla dolnej części podkowy nie istnieje możliwość przypisania długości fali. W przypadku barwy zaznaczonej punktem N mówi się, że jej barwą dominującą jest dopełnienie barwy

). Powstaje problem z punktami takimi jak N na wykresie. Dla dolnej części podkowy nie istnieje możliwość przypisania długości fali. W przypadku barwy zaznaczonej punktem N mówi się, że jej barwą dominującą jest dopełnienie barwy  . W trójkącie, zaznaczonym na rysunku linią przerywaną, znajdują się barwy niespektralne: purpury i magenty.

. W trójkącie, zaznaczonym na rysunku linią przerywaną, znajdują się barwy niespektralne: purpury i magenty.

Warto dodać, że wykres chromatyczności w postaci rzutu płaszczyzny  na płaszczyznę xy nie uwzględnia zmiany luminancji. A to oznacza, że nie są reprezentowane barwy, których wrażenie wzrokowe zależy od luminancji. Na przykład nie występuje na tym przekroju barwa brązowa. Barwa ta występuje na innym przekroju bryły CIE XYZ.

na płaszczyznę xy nie uwzględnia zmiany luminancji. A to oznacza, że nie są reprezentowane barwy, których wrażenie wzrokowe zależy od luminancji. Na przykład nie występuje na tym przekroju barwa brązowa. Barwa ta występuje na innym przekroju bryły CIE XYZ.

Barwę brązową na urządzeniach korzystających ze standardowego wykresu chromatyczności CIE XYZ uzyskuje się mieszając barwę pomarańczową z czernią (czyli zmniejszając jej luminancję).

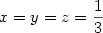

Wykres chromatyczności CIE pozwala w prosty sposób wyznaczyć barwy dopełniające : punkty D1 i D2 na rysunku.

Wykres chromatyczności CIE daje także możliwość wyznaczenia barwy mieszaniny. Jeśli mieszamy barwy P1 i P2 to barwa wynikowa P3 znajduje się na odcinku łączącym te punkty. Długości odcinków P1P3 i P2P3 zależą od proporcji ilości użytych barw.

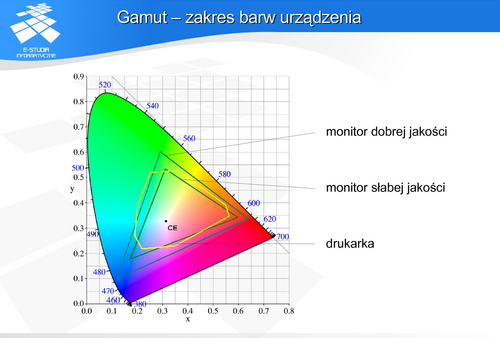

Analogicznie można mieszać trzy barwy np. P4, P5 i P6 – barwa wynikowa mieszaniny leży w trójkącie. Mieszając trzy składowe nie da się uzyskać barwy spoza trójkąta składowych! A to oznacza że nie ma możliwości pokrycia całego wykresu chromatyczności za pomocą mieszaniny trzech składowych.

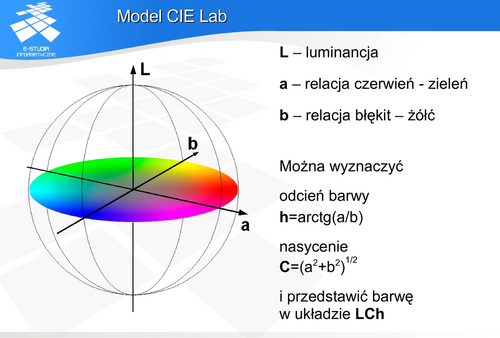

Model CIE XYZ ma jedną wadę: nie jest percepcyjnie jednorodny. Oznacza to, że operacje wektorowe na wykresie chromatyczności nie są zgodne z odczuwaniem przez człowieka: np. zmiana dwóch barw o taki sam wektor nie musi być postrzegana tak samo. Ponieważ problem percepcji jest bardzo ważny w dziedzinach związanych z poligrafią, komisja CIE opracowała w 1976 roku modele CIE LUV i CIE Lab (czasami oznaczany jako CIELa*b*). Są to modele niezależne od sprzętu. dające możliwość uzyskania jednorodności percepcyjnej. Opierają się one na teorii barw przeciwstawnych wykorzystywanej do opisu widzenia człowieka. Zgodnie z tą teorią człowiek koduje barwy jako trzy sygnały: jasność, stosunek czerwień/zieleń, stosunek błękit/żółć. Oznacza to że nie może być postrzegana barwa jednocześnie czerwona i zielona (analogicznie jednocześnie niebieska i żółta). Wyznaczenie luminancji (przeliczenie z układu CIE XYZ) jest realizowane za pomocą pierwiastka trzeciego stopnia. Komisja CIE wybrała taką zależność jako najbardziej odpowiadającą postrzeganiu zmian jasności przez człowieka.

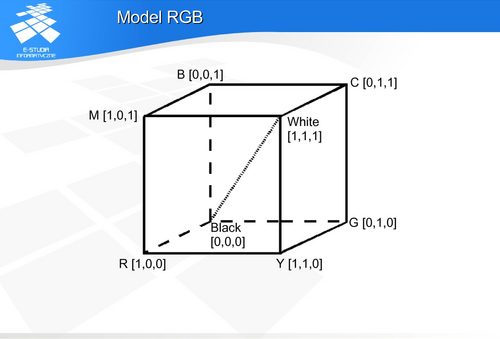

Model RGB

Model RGB nie jest jednorodny percepcyjnie. Zmiany barw nie są odczuwane proporcjonalnie do zmian wartości.

Model RGB jest modelem dyskretnym.  bitów pozwala zakodować

bitów pozwala zakodować  różnych barw. Powszechnie stosuje się 24 bity (po 8 dla każdej składowej) do zapisu barwy. oznacza to 16,7 mln barw. Z drugiej strony człowiek jest w stanie rozróżniać dla każdej składowej od 100 do 200 różnych barw. Dawałoby to w sumie możliwość rozpoznawania ok. 8 mln barw. W zależności od badań przyjmuje się, że liczba ta nie przekracza 10 mln. Wydawać by się więc mogło, że liczba 16mln dla zapisu barw w systemie RGB za pomocą 24 bitów jest całkowicie wystarczająca. Tak jednak nie jest ze względu na nieliniowość procesu percepcji.

różnych barw. Powszechnie stosuje się 24 bity (po 8 dla każdej składowej) do zapisu barwy. oznacza to 16,7 mln barw. Z drugiej strony człowiek jest w stanie rozróżniać dla każdej składowej od 100 do 200 różnych barw. Dawałoby to w sumie możliwość rozpoznawania ok. 8 mln barw. W zależności od badań przyjmuje się, że liczba ta nie przekracza 10 mln. Wydawać by się więc mogło, że liczba 16mln dla zapisu barw w systemie RGB za pomocą 24 bitów jest całkowicie wystarczająca. Tak jednak nie jest ze względu na nieliniowość procesu percepcji.

Dodatkowo występuje problem ciągłości zmiany barw. Jeśli jedna składowa wykorzystująca do zapisu  bitów, co pozwala zakodować

bitów, co pozwala zakodować  różnych barw, to w dyskretnym sześcianie barw

różnych barw, to w dyskretnym sześcianie barw  między dowolnymi barwami istnieje ścieżka łączące je mająca maksymalnie

między dowolnymi barwami istnieje ścieżka łączące je mająca maksymalnie  poziomów. Taka wartość jest dostępne tylko między wierzchołkami przekątnej sześcianu, w każdym innym przypadku poziomów pośrednich będzie o wiele mniej. Oznacza to, że ciągłe przejście między barwami o różnych odcieniach będzie zrealizowane na stosunkowo małej liczbie poziomów. Dla modelu wykorzystującego 8 bitowe kodowanie może to oznaczać przejście między barwami z liczbą barw pośrednich dużo mniejszą niż 100 – co będzie zauważalne przez człowieka.

poziomów. Taka wartość jest dostępne tylko między wierzchołkami przekątnej sześcianu, w każdym innym przypadku poziomów pośrednich będzie o wiele mniej. Oznacza to, że ciągłe przejście między barwami o różnych odcieniach będzie zrealizowane na stosunkowo małej liczbie poziomów. Dla modelu wykorzystującego 8 bitowe kodowanie może to oznaczać przejście między barwami z liczbą barw pośrednich dużo mniejszą niż 100 – co będzie zauważalne przez człowieka.

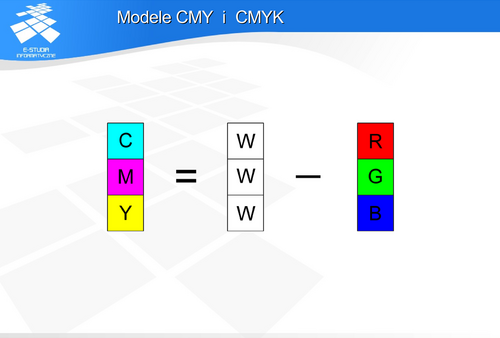

CMY jest modelem analogicznym do RGB pod względem właściwości.

Ze względu na technologiczne problemy uzyskania barwy czarnej mieszaniny zaproponowano dodanie barwnika czarnego (K). Wtedy można usunąć składową szarą G: G=min(C,M,Y) zmieniając wartości barw

gdzie k jest współczynnikiem dobieranym doświadczalnie dla danego urządzenia.

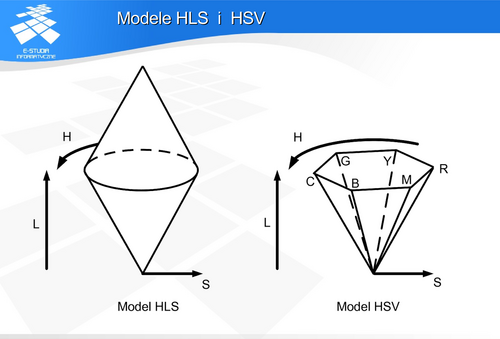

Modele HLS i HSV

Modele HSV i HLS nie są opisane przestrzenią liniowa (tak jak CIE XYZ). Nie jest więc możliwe dodawanie wektorów w tych modelach.

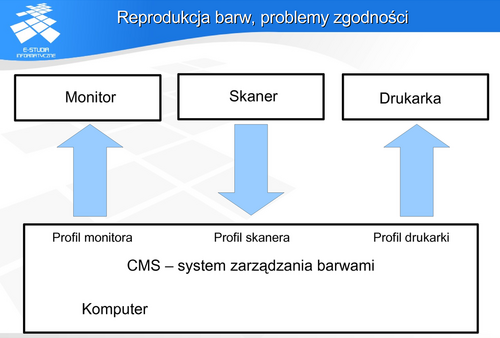

Proces profilowania barw jest jednym z etapów kalibracji urządzenia. Np. dla monitora kalibracja będzie także obejmowała korekcje zniekształceń geometrycznych. Warto pamiętać, że parametry urządzeń podlegają zmienności w czasie i aby utrzymać standard jakości urządzenia powinny być regularnie kalibrowane.

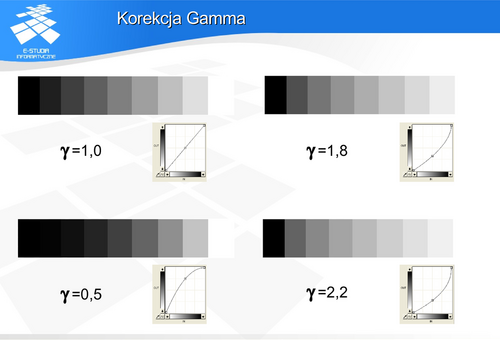

Korekcja Gamma

i natężenie światła

i natężenie światła  świecącego luminoforu to:

świecącego luminoforu to:

gdzie  jest pewną stałą natomiast

jest pewną stałą natomiast  charakteryzuje nieliniowość sterowania monitora. Dla stosowanych monitorów

charakteryzuje nieliniowość sterowania monitora. Dla stosowanych monitorów  zawiera się w przedziale od ok. 1,5 do ok. 2,8. Często wartość tego parametru jest związana z określonym producentem lub klasą sprzętu. Np.

zawiera się w przedziale od ok. 1,5 do ok. 2,8. Często wartość tego parametru jest związana z określonym producentem lub klasą sprzętu. Np.  dla monitorów komputerów Macintosh jest niższa (1,8) niż monitorów sprzętu PC (2,2).

dla monitorów komputerów Macintosh jest niższa (1,8) niż monitorów sprzętu PC (2,2).

Z drugiej strony np. przestrzeń barw sRGB jest związana z wartością  = 2,2 , natomiast nie zawsze używamy monitora o takim współczynniku. Oznacza to, że w takiej sytuacji, postrzegane zmiany barw na obrazie będą różne na różnych monitorach oraz inne niż przewidzieli to twórcy obrazu korzystając z określonej przestrzeni barw.

= 2,2 , natomiast nie zawsze używamy monitora o takim współczynniku. Oznacza to, że w takiej sytuacji, postrzegane zmiany barw na obrazie będą różne na różnych monitorach oraz inne niż przewidzieli to twórcy obrazu korzystając z określonej przestrzeni barw.

Przyjęło się używać określenia "korekcja gamma". Jednak wydaje się, że lepszym określeniem byłoby "dostosowanie" lub "kodowanie", ponieważ celem nie jest korygowanie współczynnika gamma, tylko dostosowanie sposobu wyświetlania do możliwości urządzenia, aby zminimalizować problemy kwantyzacji, szumu i różnic w percepcji barw.

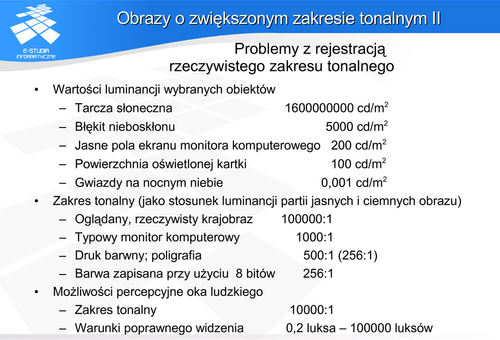

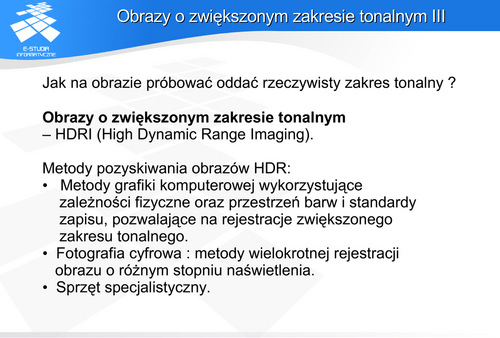

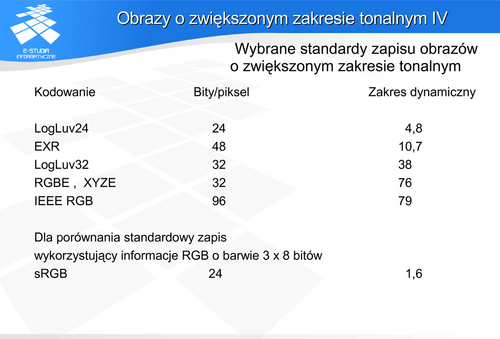

Obrazy o zwiększonym zakresie tonalnym

Przed problemem rejestracji zakresu tonalnego staje każdy, kto posługuje się aparatem fotograficznym. Bez względu na technologię (analogowa – tradycyjna, czy cyfrowa) trudno uzyskać na zdjęciu szczegóły zarówno w światłach jak i w cieniach, jeśli różnica w luminancji jednych i drugich fragmentów jest znaczna. Okazuje się, że obserwując dany obiekt poprawnie postrzegamy jasne i ciemne pola. Natomiast robiąc zdjęcie mamy często po prostu do wyboru albo dobrze naświetlone pola jasne (wtedy cienie są nieoświetlone i nie widać w nich szczegółów), albo dobrze naświetlone pola ciemne (wtedy prześwietlone pola jasne są praktycznie niewidoczne). Pogodzenie tych warunków jest niestety najczęściej niemożliwe.

Opisując w tym rozdziale model RGB zwrócono uwagę na liczbę barw rozróżnianych przez człowieka – człowiek jest w stanie rozróżniać dla każdej składowej maksymalnie od 100 do 200 różnych barw. Jednak takie rozważania nie uwzględniają zdolności adaptacyjnych oka do różnych warunków oświetleniowych. Zdolności te są związane z dwoma mechanizmami. Pierwszym jest praca mięśni tęczówki zmniejszających źrenicę. Pozwala to wielokrotnie zmniejszyć ilość światła docierającego do siatkówki oka. Drugim mechanizmem jest praca fotoreceptorów w zakresie widzenia fotopowego i skotopowego. Przyjmuje się, że oko pozwala poprawnie rejestrować szczegóły w zakresie tonalnym ok. 10000:1. Jednocześnie zakres pracy naszego zmysłu wzroku odpowiada natężeniu oświetlenia od 0,2 luksa (odpowiada to powierzchni Ziemi przy pełni Księżyca) do 100000 luksów (powierzchnia Ziemi oświetlona światłem słonecznym). Oczywiście oglądając krajobraz z różnie oświetlonymi obiektami nigdy nie odbieramy obrazu jako całości – kierując wzrok na określony obiekt oko dostosowuje się do jego luminancji. Dopiero z tak zebranych informacji o fragmentach budujemy obraz całości pola widzenia. Dzięki temu dostrzegamy szczegóły obrazu niemożliwe do zarejestrowania aparatem fotograficznym i wydrukowania na papierze, niemożliwe także do pokazania na monitorze. Pod tym względem oko okazuje się o wiele lepszym instrumentem do rejestracji wrażeń barwnych niż film fotograficzny czy matryce cyfrowe.

A zatem nawet jeśli uzyskamy obraz o zwiększonej skali tonalnej, to będzie on pokazywany na typowym urządzeniu, na przykład na typowym monitorze o bardzo ograniczonym zakresie tonalnym. Aby poprawić odbiór obrazu w takiej sytuacji dokonuje się rzutowania przestrzeni barw o zwiększonym zakresie tonalnym na przestrzeń o ograniczonym zakresie. Metody realizujące to zadanie są stratne i nieliniowe. Wykorzystuje się analizę właściwości odbiciowych powierzchni obiektów znajdujących się na obrazie oraz analizę właściwości percepcyjnych człowieka.

Do zapisu zdjęć w aparatach cyfrowych jest także wykorzystywany sposób kodowania RAW. Sposób ten wykorzystuje właściwości matrycy danego aparatu bez żadnej dodatkowej obróbki obrazu. Powiązanie z właściwościami i konstrukcją matrycy powoduje, że zapis ten jest niestandardowy i zależny od producenta aparatu. Najczęściej zapis ten wykorzystuje od 12 do 16 bitów dla składowej barwnej. Zapis RAW nie jest uznawany za kodowanie obrazu o zwiększonym zakresie tonalnym. Niemniej jednak fotografia zapisana jako RAW zawiera więcej informacji o barwie niż w standardowym zapisie 24-bitowym i może być „wywołana” do kilku, różnie naświetlonych obrazów. Daje to możliwość poprawy jakości zdjęcia.