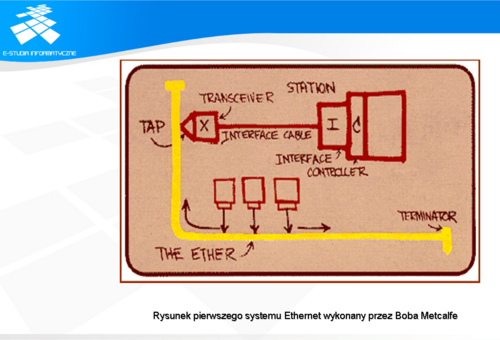

Komputer podpięty do sieci Aloha mógł w dowolnym momencie rozpocząć nadawanie. Jeżeli po określonym czasie nie było odpowiedzi od adresata, nadawca przyjmował, że nastąpiła kolizja w wyniku jednoczesnego nadawania we współdzielonym medium. W takiej sytuacji obaj nadawcy odczekiwali losowy przedział czasu zanim ponawiali nadawanie, co gwarantowało poprawną transmisję. Jednak przy zwiększającej się liczbie komputerów wykorzystanie kanału spadało do 18%, a po wprowadzeniu synchronizacji transmisji do 37%. Bazując na rozwiązaniach zastosowanych w sieci Aloha, Bob Matcalfe opracował nowy system, w którym znalazły się takie mechanizmy jak: wykrywanie kolizji, wykrywanie zajętości kanału, współdzielony dostęp, co doprowadziło do powstania protokółu CSMA/CD (Carrier Sense Multiple Access witch Collision Detection). W wyniku dalszych prac nad siecią Ethernet przeprowadzonych w firmie Xerox PARC powstała pierwsza doświadczalna sieć komputerowa Alto Aloha Network. Prace zostały uwieńczone publikacją w 1976 roku artykułu w Communication of the Association for Computing Machinery (CACM): Bob Matcalfe, David Boggs – „Ethernet Distributed Packet Switching for Local Computer Networks” oraz uzuskaniem w 1977 roku w Urzędzie Patentowym USA patentu numer 4063220 pod nazwą: „Multipoint Data Communication System With Collision Detection”. W 1980 roku konsorcjum DIX (Digital-Intel-Xerox) opublikowało standard Ethernet pracujący z prędkością 10Mbps znany pod nazwą DIX Ethernet. Ostatnia znana wersja tego standardu to DIX V2.0

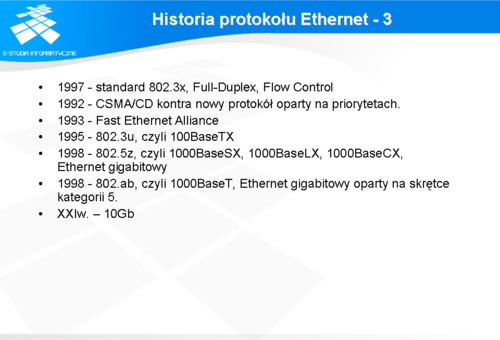

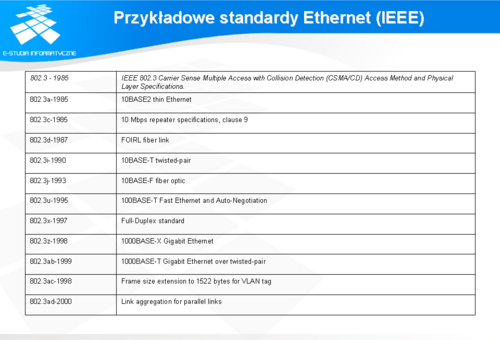

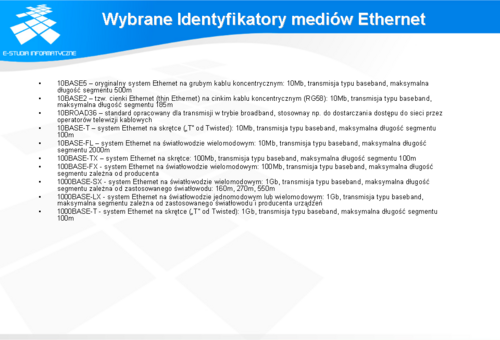

W następnych latach opracowano całą gamę standardów 802.3 uwzględniających bieżący stan rozwoju technologii w zakresie przesyłania sygnałów. Do najważniejszych można zaliczyć standardy o znaczeniu przełomowym dla sieci komputerowych, jak np. wprowadzenie skrętki, czy kolejnych szybkości ethernetu: 100Mb, 1Gb i obecnie 10Gb. Wybrane standardy zostały zamieszczone w tabeli (slajd 10)

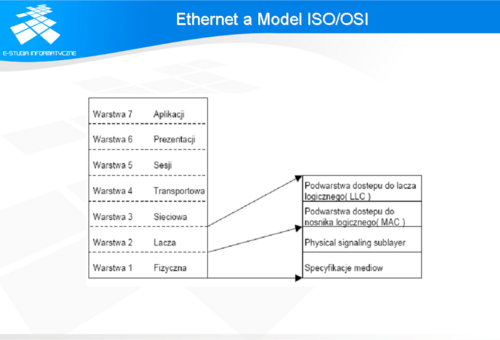

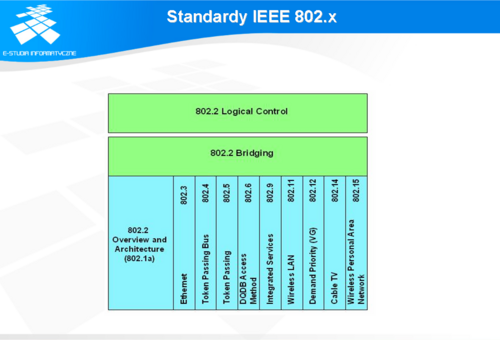

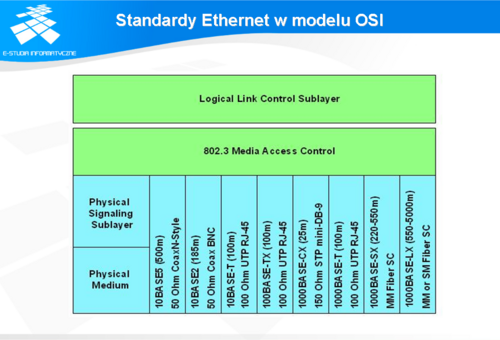

Standard Ethernet opisuje funkcje toru komunikacyjnego, umieszczonego w modelu ISO/OSI w warstwach 2 i 1. Ponieważ poszczególne standardy rodziny Ethernet dotyczą różnych modułów wchodzących zarówno w skład warstwy 1 jaki 2, komisja IEEE zdefiniowała dodatkowe podwarstwy dwóch pierwszych warstw modelu ISO/OSI. Oczywiście każda z tych podwarstw może ulegać dalszym wewnętrznym podziałom ze względu na specyficzne funkcje jakie zostały zaimplementowane w danej podwarstwie. Na poziomie warstwy łącza zdefiniowano dwie podwarstwy: LLC (Logical Link Control) oraz MAC (Medium Accesss Control). Warstwa LLC jest warstwą niezależną od zastosowanego systemu sieci lokalnej (LAN). Jej zadaniem jest identyfikowanie danych przesyłanych w ramce Ethernet. Warstwa MAC opisuje protokół określający sposób dostępu do medium w systemie Ethernet. Podwarstwy zdefiniowane w warstwie 1 modelu ISO/OSI są zmienne i określają rodzaj sieci Ethernet jaki został zastosowany, np. 10Mb, 100Mb, czy 1Gb.

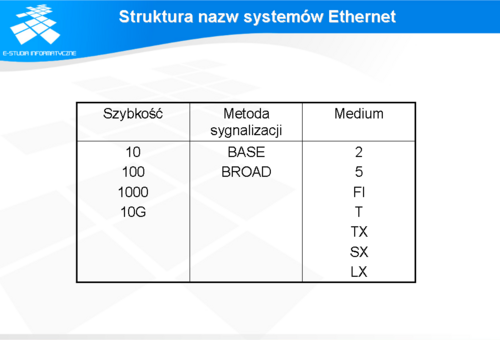

Należy jednak zauważyć, że wszystkie standardy powstały w oparciu o rozwiązania wprowadzane na rynek przez poszczególnych producentów sprzętu sieciowego. Część z nich doczekała się opracowania w postaci standardu IEEE. W ramach standaryzacji poszczególnym mediom ujętym w standardzie nadano trzyczęściowe identyfikatory, w których poszczególne części określają: prędkość, typ sygnalizacji oraz rodzaj medium. Przy czym pierwotnie w część określająca medium zawierała informację o długości kabla w metrach z zaokrągleniem do pełnych setek. W późniejszym okresie zrezygnowano z zamieszczania tej informacji.

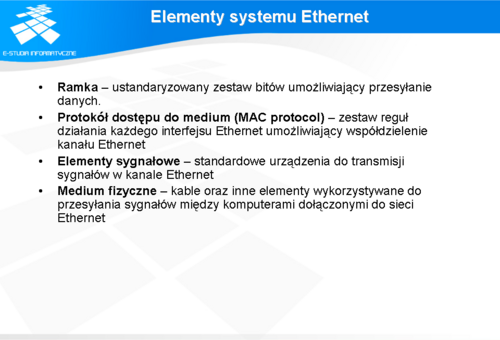

W celu poprawnej realizacji tego zadania muszą zostać spełnione ściśle określone warunki, które definiują cztery podstawowe elementy : ramkę, protokół sterujący dostępem do medium, komponenty sygnalizacji, media fizyczne. Elementy te zostaną opisane w dalszej części rozdziału.

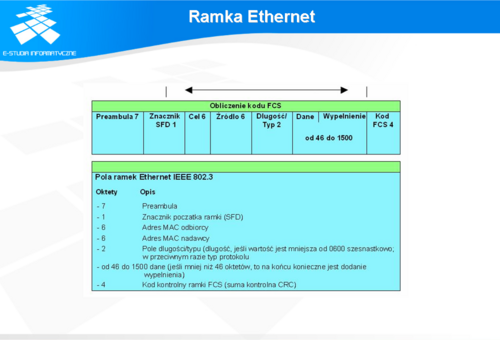

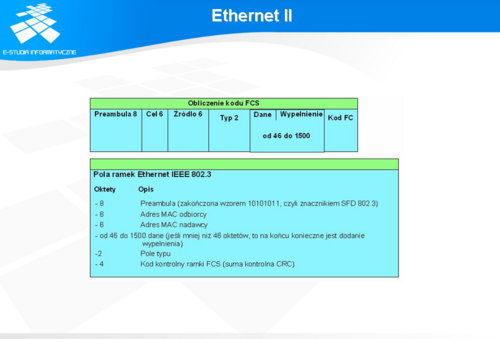

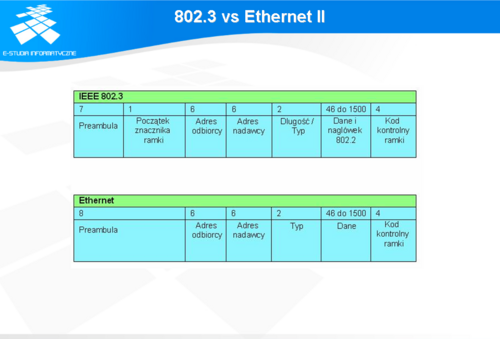

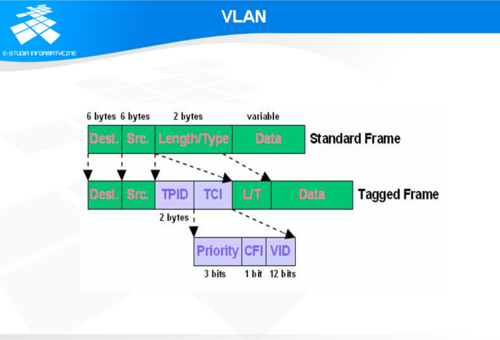

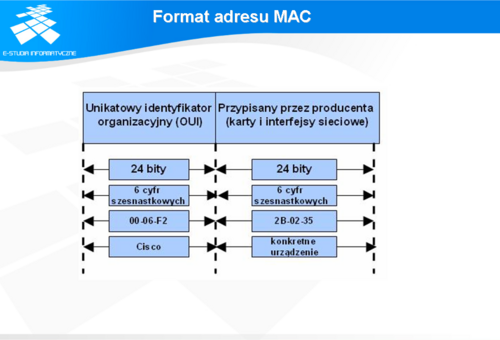

Znacznik początku ramki (SFD) to jeden oktet bitów w postaci: 10101011, oznaczający koniec sekwencji synchronizującej. Pole adresata zawiera MAC adres odbiorcy. Adres odbiorcy może być MAC adresem konkretnego urządzenia, adresem grupowym lub rozgłoszeniowym. Pole adresu nadawcy zawiera MAC adres nadawcy. Adres nadawcy jest MAC adresem konkretnego urządznia nadającego, będącego węzłem sieci Ethernet. Znacznik VLAN (Virtual LAN) został wprowadzony przez standard IEEE 802.1Q. Stanowi on czterooktetowy zespół dodatkowych pól w nagłówku ramki Ethernet służących do identyfikacji przynależności ramki do konkretnego VLAN’u w komunikacji miedzy urządzeniami oraz do obsługi priorytetów zgodnie z QoS (Quality of Service). W skład znacznika wchodzą następujące pola: TPID (Tag Protocol Identifier), TCI (Tag Control Information): Priority, CFI (Canonical Format Indicator ), VID (VLAN ID). TPID – zajmuje miejsce przeznaczone w podstawowym standardzie dla pola typ/długość i jego wartość ustawiona jest na 0x8100, co jednoznacznie identyfikuje typ ramki jako IEEE 802.1Q/802.1P. Priority – trzy pierwsze bity pola TCI pozwalają na zdefiniowanie 8 poziomowego priorytetu zgodnie z IEEE 802.1P. CFI – pole używane do zachowania kompatybilności między przełącznikami Ethernet a Token Ring. Dla przełączników Ethernet wartość tego pola ustawiana jest na 0. VID – Numer identyfikujący VLAN zgodnie z IEEE 802.1Q. Numery VLAN’ów mogą przyjmować wartości od 1 do 4094. Wartość 0 oznacza ramkę priorytetową, wartość 4095 jest zarezerwowana. W standardzie DIX pole to oznaczało typ protokołu warstwy wyższej, natomiast w pierwszej wersji standardu IEEE długość ramki. W celu zapewnienia jednoznacznej interpretacji tego pola, w kolejnym wydaniu standardu IEEE wprowadzono interpretację kontekstową. Jeżeli wartość pola jest mniejsza niż 1536 (0x0600), to wartość określa długość ramki, a identyfikację protokołu warstwy wyższej zapewnia warstwa LLC. W przeciwnym wypadku wartość pola należy interpretować jako numer protokołu warstwy wyższej. Maksymalny rozmiar pola danych wynosi 1500 oktetów, co stanowi wartość maksymalnej jednostki transmisji (MTU – Maximum Transmision Unit) dla sieci Ethernet. Jeżeli całkowita długość ramki jest mniejsza niż 64 oktety, to zawartość pola danych uzupełniana jest dodatkowymi oktetami aż do osiągniecia przez ramkę minimalnej długości. Pole FCS (Frame Check Sequence) zawiera czterobajtową wartość CRC (Cyclic Redundancy Check) tworzoną przez urządzenie nadawcze. Wartość ta jest ponownie przeliczana przez urządzenie odbiorcze. Jeżeli wartość obliczona przez urządzenie odbiorcze jest inna niż wartość znajdująca się w ramce, ramka traktowana jest jako uszkodzona i zostaje pominięta w dalszym przetwarzaniu.

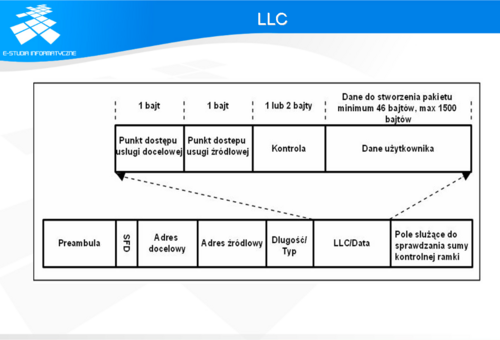

Dane warstwy LLC zgodnie z IEEE 802.2 zajmują kilka pierwszych bitów pola danych. DSAP (Destination Service Access Point) – identyfikuje protokół warstwy wyższej SSAP (Source Service Access Point) Dane kontrolne

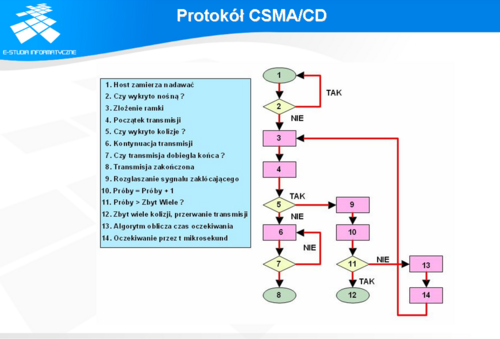

Wyróżniamy dwa podstawowe rodzaje protokołów deterministyczne i niedeterministyczne. Typowymi protokołami deterministycznymi stosowanymi w sieciach LAN są rozwiązania obecne w systemach Token Ring oraz FDDI. Komputery w tych systemach połączone są za pomocą topologii pierścienia, w którym krąży znacznik (token), przekazywany między komputerami. Komputer, będący w posiadaniu znacznika, może nadawać przez określony czas, po czym przekazuje znacznik następnemu komputerowi. Dzięki temu w sieci nie występują kolizje, gdyż w danym momencie tylko jeden komputer wysyła dane do sieci. System Ethernet dla odmiany jest systemem niedeterministycznym. Obowiązuje tu zasada rywalizacji o dostęp do medium. W takim środowisku zjawiskiem normalnym są częste kolizje wynikające stąd, że w danym momencie dwa lub więcej urządzeń, współdzielących medium, może rozpocząć transmisję danych. W związku z tym, wprowadzono mechanizm umożliwiający rozwiązywanie sytuacji kolizyjnych w postaci protokołu CSMA/CD (Carrier Sense Multiple Access with Colision Detection). Protokół CSMA/CD opiera się na trzech prostych mechanizmach: wykrywania kanału, rozpoznawania kolizji, wyznaczania czasu po którym nastąpi próba retransmisji.

wysyłanie i odbieranie ramek z danymi, dekodowanie ramek i sprawdzanie poprawności zawartych w nich adresów przed przekazaniem ich do wyższych warstw modelu OSI, wykrywanie błędów wewnątrz ramek lub w sieci. Pracując w oparciu o protokół CSMA/CD urządzenie przechodzi w stan nasłuchiwania przed rozpoczęciem nadawania. Nasłuchiwanie ma na celu sprawdzenie zajętości kanału transmisji. Jeżeli w kanale transmisji zostanie wykryta nośna (obecność jakiegokolwiek sygnału w sieci) oznacza to, że inne urządzenie wysyła dane, czyli kanał jest zajęty. Jeżeli w kanale nastąpi cisza i będzie utrzymywała się przez z góry ustalony okres czasu (przerwa międzyramkowa), to urządzenie stwierdza, że kanał jest wolny i rozpoczyna nadawanie. Podczas nadawania pierwszej, ściśle określonej liczby bitów (minimalna długość ramki) urządzenie sprawdza, czy nie wystąpiła kolizja. Jeżeli transmisja dobiegła końca i nie stwierdzono kolizji, urządzenie zakłada, że operacja zakończyła się powodzeniem. Jeżeli jednak wykryto kolizję (nadmierny wzrost amplitudy sygnału świadczący o nałożeniu się sygnałów) następuje wysłanie do sieci specjalnego sygnału. Wszystkie urządzenia, które brały udział w kolizji zaprzestają nadawania oraz obliczają losowy odcinek czasu, po którym ponowią próbę transmisji. Jeżeli ponownie wystąpi kolizja, obliczony wcześniej losowy odcinek czasu jest podwajany i po tak obliczonym czasie wykonywana jest kolejna próba transmisji. Podwajanie losowo obliczonego odcinka czasu może występować najwyżej 16 razy, jeżeli każda kolejna próba transmisji zakończyła się kolizją. Po przekroczeniu dopuszczalnej liczby kolejnych kolizji urządzenie odczekuje pewien czas i uruchamia proces nadawania od początku.

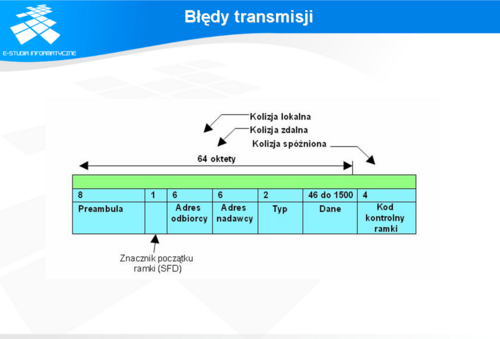

Przyjmując skrajny przypadek, w którym kolizja wystąpiła na jednym krańcu sieci, to stacja nadawcza, znajdująca się na drugim krańcu otrzyma informację o kolizji z pewnym opóźnieniem, równym czasowi propagacji sygnału w medium o długości dwukrotnie większej niż maksymalny rozmiar sieci. Do celów projektowych przyjęto z pewną nadwyżką czas propagacji sygnału przez całą sieć na poziomie 25,6us. W związku z tym stacja nadająca otrzyma sygnał o wystąpieniu kolizji nie później niż 51,2us. Ponieważ projekt dotyczył sieci o szybkości 10Mbps, oznacza to że sygnał o wystąpieniu kolizji powinien dotrzeć do nadawcy nie później niż podczas wysyłania maksimum pierwszych 512 bitów (64 oktety). Zatem jeżeli nadawca wyśle pierwsze 64 oktety ramki i nie otrzyma sygnału kolizji kontynuuje wysyłanie pozostałej części ramki. Jeżeli długość ramki byłaby mniejsza niż 64 oktety nadawca nie mógłby wiedzieć, czy transmisja zakończona została sukcesem, czy nie. Dlatego przyjęto, że minimalnym rozmiarem ramki gwarantującym pewność poprawności transmisji jest rozmiar równy 64 oktetom.

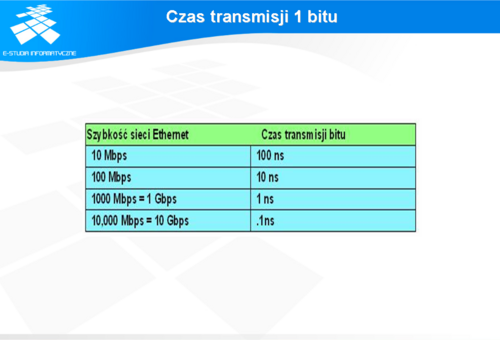

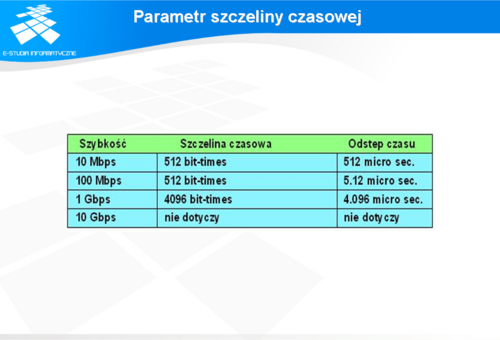

We wszystkich odmianach technologii Ethernet o szybkości transmisji nieprzekraczającej 1000 Mb/s standard wyznacza minimalny czas pojedynczej transmisji nie krótszy niż szczelina czasowa. Szczelina czasowa dla technologii Ethernet 10 i 100 Mb/s jest równa czasowi transmisji 512 bitów (czyli 64 oktetów). Szczelina czasowa dla technologii Ethernet 1000 Mb/s jest równa czasowi transmisji 4096 bitów (czyli 512 oktetów). Szczelina czasowa jest obliczana przy założeniu maksymalnych długości kabli w największej dopuszczalnej architekturze sieciowej. Wszystkie czasy opóźnień propagacji sprzętowej są na poziomie dopuszczalnego maksimum, a gdy zostanie wykryta kolizja, używana jest 32-bitowa sekwencja zakłócająca. Rzeczywista obliczona szczelina czasowa jest nieco dłuższa niż teoretyczna ilość czasu wymagana do przebycia drogi pomiędzy najdalszymi punktami domeny kolizyjnej, zderzenia się z inną transmisją w ostatnim możliwym momencie, powrotu fragmentów kolizyjnych do stacji wysyłającej i ich wykrycia. Aby system działał, pierwsza stacja musi dowiedzieć się o kolizji zanim zakończy wysyłanie ramki o najmniejszym dopuszczalnym rozmiarze. Aby umożliwić działanie sieci Ethernet 1000 Mb/s w trybie półdupleksu, przy wysyłaniu krótkich ramek dodano pole rozszerzenia służące jedynie do utrzymania urządzenia transmitującego w stanie zajętości na tyle długo, by mogły wrócić fragmenty kolizyjne. Pole to jest obecne tylko przy szybkości 1000 Mb/s w przypadku łączy pracujących w trybie półdupleksu, po to, aby ramki o minimalnym rozmiarze były wystarczająco długie, by móc sprostać wymaganiom szczeliny czasowej. Bity rozszerzenia są odrzucane przez stację odbierającą. W technologii Ethernet 10 Mb/s transmisja jednego bitu w warstwie MAC trwa 100 nanosekund (ns). Przy szybkości 100 Mb/s transmisja tego samego bitu trwa 10 ns, a przy szybkości 1000 Mb/s trwa ona tylko 1 ns. W przybliżonych szacunkach często wykorzystywana jest wartość 20,3 cm (8 cali) na nanosekundę do obliczania opóźnienia propagacji w kablu UTP. Oznacza to, że w 100 metrach kabla UTP przesłanie sygnału 10BASE-T na całej długości przewodu trwa krócej niż czas transmisji pięciu bitów. Dla funkcjonowania metody CSMA/CD stosowanej w sieciach Ethernet konieczne jest, aby stacja wysyłająca wiedziała o wystąpieniu kolizji zanim zostanie zakończona transmisja ramki o minimalnym rozmiarze. Przy szybkości 100 Mb/s taktowanie systemu jest ledwie w stanie obsłużyć sieci o długości kabla równej 100 metrów. Przy szybkości 1000 Mb/s wymagane są specjalne korekty, gdyż prawie cała ramka o minimalnym rozmiarze zostałaby wysłana, zanim pierwszy bit pokonałby pierwsze 100 metrów kabla UTP. Z tego powodu tryb półdupleksu nie jest dozwolony w technologii 10 Gigabit Ethernet.

Kolizja lub runt – jednoczesna transmisja więcej niż jednego urządzenia przed upływem szczeliny czasowej Późna kolizja – jednoczesna transmisja więcej niż jednego urządzenia po upływie szczeliny czasowej Jabber, długa ramka, błędy zakresu – niedopuszczalnie długa transmisja Krótka ramka, fragment kolizji lub runt – niedopuszczalnie krótka transmisja Błąd FCS – uszkodzona ramka Błąd wyrównania – zbyt duża albo zbyt mała liczba wysyłanych bitów Błąd zakresu – liczba otrzymanych bitów różna od liczby zadeklarowanej Ghost lub jabber – niedopuszczalnie długa preambuła lub zakłócenie.

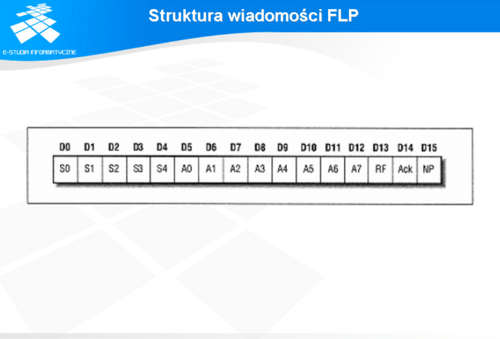

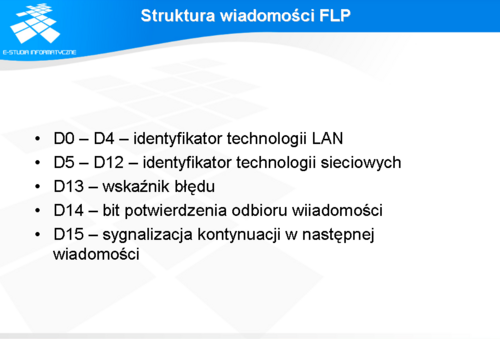

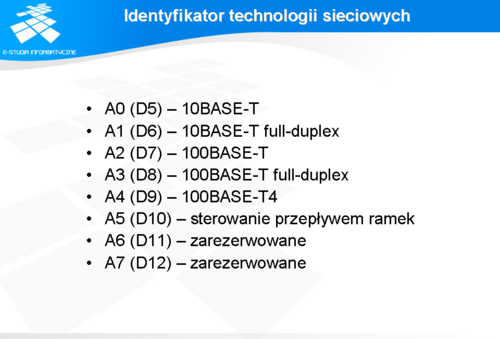

Mechanizm automatycznej negocjacji szybkości parametrów łącza bazuje na sygnalizacji typu FLP (Fast Link Pulse). Sygnalizacja ta stanowi zmodyfikowaną postać sygnalizacji NLP (Normal Link Pulse) używanej w standardzie 10BASE-T do sprawdzania integralności łącza. Standard 10BASE-T wymaga, aby każde urządzenie wysyłało co ok. 16ms ciąg impulsów. Protokół auto-negocjacji zaadoptował ten mechanizm do ogłaszania pełnej funkcjonalności danego interfejsu. W tym celu wysyłane jest tyle 16-bitowych wiadomości ile potrzeba do opisania możliwości interfejsu. Slajd pokazuje strukturę pierwszej wiadomości.

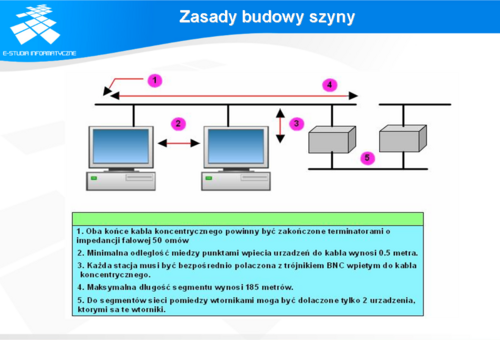

Zgodnie z zasadami budowy segmentu sieci w oparciu o ten typ kabla: Oba końce kabla powinny być zakończone terminatorami o oporności 50ohm, Minimalna odległość między punktami przyłączenia urządzeń wynosi 0.5m Każda stacja powinna być bezpośrednio podłączona do trójnika BNC, Maksymalna długość segmentu wynosi 185m.

Łączenie segmentów dokonuje się przy pomocy wzmacniaczy dwustronnych, tzw. repeater'ów Maksymalna liczba repeater’ów między dowolnymi dwoma stacjami w sieci wynosi 4 Do segmentów parzystych mogą być podłączone jedynie dwa urządzenia, którymi są repeater'y.

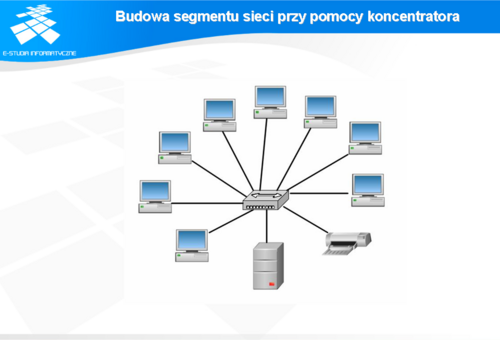

Zasady łączenia tego typu segmentów w celu rozbudowy sieci ograniczają się jedynie do ograniczenia liczby koncentratorów do 4 między dwoma dowolnymi urządzeniami. Maksymalna długość kabla łączącego urządzenie z koncentratorem wynosi 100m. W przypadku sieci pracujących z szybkością 100Mb (FastEthernet) standard dopuszcza jedynie dwa koncentratory oraz ogranicza maksymalną długość połączeń między dwoma dowolnymi stacjami do 205m.

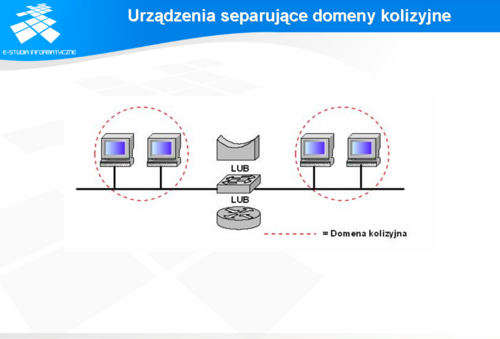

Stosowane dotychczas urządzenia pracowały w warstwie 1 modelu ISO/OSI i poza regeneracją sygnałów nie wnosiły żadnych innych funkcjonalności do budowy sieci. Dalsza rozbudowa sieci przy pomocy koncentratorów i wzmacniaczy oznaczałaby przekroczenie maksymalnej wartości opóźnienia w sieci, co spowodowałoby wadliwe działanie protokołu CSMA/CD. Ponadto wraz z rozwojem technologii, do sieci podłączano coraz większą liczbę urządzeń, co doprowadzało nawet poprawnie skonstruowane sieci do załamania komunikacji z powodu nadmiernego wzrostu kolizji. Segment sieci, w którym wszystkie połączenia zostały zrealizowane za pomocą urządzeń biernych i aktywnych warstwy 1 modelu ISO/OSI nazwano domeną kolizyjną. W celu umożliwienia dalszej rozbudowy oraz podniesienia wydajności sieci lokalnej opracowano urządzenie o nazwie most (ang. Bridge), wyposażone w dodatkową funkcjonalność w stosunku do zwykłych regeneratorów sygnałów. Funkcjonalność ta polega na umiejętności rozpoznawania urządzeń pod kątem przynależności do domen kolizyjnych bezpośrednio podłączonych do mostu. Most tworzy i przechowuje tablicę pozwalającą skojarzyć MAC adres urządzenia z odpowiednim portem mostu. Ponieważ most przetwarza ramki Ethernet zaliczany jest do urządzeń aktywnych warstwy 2 modelu ISO/OSI.

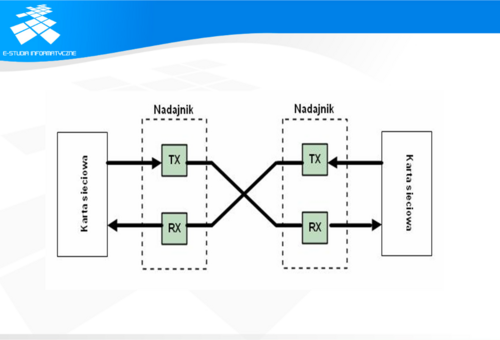

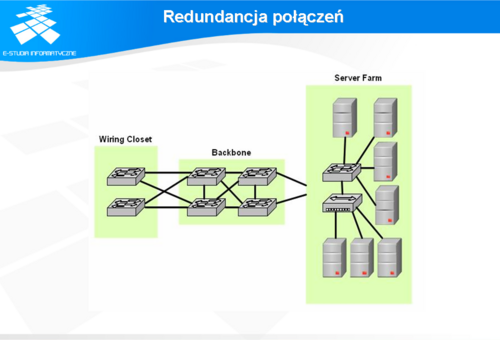

Przełączniki umożliwiały łączenie więcej niż tylko dwóch domen kolizyjnych oraz dodatkowo pracowały w trybie pełnego dupleksu i tworzyły wirtualne kanały transmisyjne między portami, do których połączone były segmenty nadawcy i odbiorcy. Wszystkie te funkcjonalności zaimplementowane w urządzeniach warstwy 2 modelu ISO/OSI spowodowały znaczny wzrost wydajności sieci, przy zachowaniu kompatybilności wstecznej ze starszymi standardami. Na przykład pomimo separacji domen kolizyjnych zachowano istnienie domen rozgłoszeniowych, co umożliwia wykorzystywanie dotychczas stosowanych aplikacji i systemów bazujących na tego typu środowisku, bez konieczności ich rekonfiguracji. Oczywiście znaczny rozrost domen rozgłoszeniowych ma też swoje wady, z których najważniejszą jest ryzyko powstawania sztormów rozgłoszeniowych wynikających z dużej liczby urządzeń podłączonych tak rozbudowanej sieci lokalnej. Dlatego, o ile to możliwe sugeruje się stosowanie urządzeń wyższych warstw sieci (głównie router’ów), które pozwalają nie tylko na segmentację domen kolizyjnych, ale także na segmentację domen rozgłoszeniowych.

W najprostszym przypadku, gdy mamy do czynienia z przełączaniem symetrycznym (wszystkie porty przełącznika pracują z tą samą szybkością) stosowany jest tryb cat-through. Tryb ten polega na podejmowaniu decyzji o przekierowaniu ramki na podstawie adresu docelowego, znajdującego się w pierwszych 6 oktetach ramki Ethernet. Drugi sposób stosowany bywa zazwyczaj w trybie przełączania niesymetrycznego (porty przełącznika pracują z różnymi szybkościami, co głównie występuje w przełącznikach z portami 10/100/1000Mb) i określany jest jako stor-and-forward. Jak sama nazwa wskazuje decyzja o przekierowaniu ramki podejmowana jest dopiero wtedy, gdy przełącznik otrzyma całą ramkę i ewentualnie sprawdzi jej poprawność na podstawie pola FCS. W przypadku gdy do portów przełącznika podłączone są segmenty sieci w postaci domen kolizyjnych, niezależnie od sposobu przełączania stosowany bywa pośredni tryb fragment-free, w którym decyzja o przekierowaniu ramki podejmowana jest po otrzymaniu przez przełącznik pierwszych 64oktetów ramki, co pozwala upewnić się, że podczas transmisji ramki nie doszło do kolizji. W niektórych przełącznikach stosowana jest czwarta metoda, hybrydowa. Jeżeli poziom błędów w sieci nie przekracza pewnej wartości (ok. 10%), przełącznik stosuje tryb cat-through. Jeżeli poziom błędów wzrośnie ponad założoną wartość, to przełącznik przechodzi do trybu store-and-forward.

Działanie tego protokołu polega na wzajemnym informowaniu się urządzeń o bieżącym stanie połączeń za pomocą komunikatów BPDU (Bridge Protocol Data Units). W wyniku wymiany informacji nt. konfiguracji połączeń każdy port przełącznika może znajdować się w pięciu różnych stanach i w zależności od sytuacji zmieniać według schematu pokazanego na slajdzie.